Learn more about Search Results A - Page 307

- You may be interested

- プリンストンの研究者たちは、革新的な軽...

- このAIニュースレターがあれば、あなたは...

- Rows AI:エクセルスプレッドシートの終焉...

- 線形代数4:行列方程式

- 「ChatGPTを金融業務に活用する10の方法」

- 『自分のデータでChatGPTを訓練する方法:...

- AccelDataがBewgleを買収:AIデータパイプ...

- 「データビジュアルの誤り:一般的なGPT-4...

- 「部分情報分解とは何か、そして特徴がど...

- Pythonで絶対に犯してはいけない10の失敗

- Pd.Get_Dummiesの良い面、悪い面、そして...

- 「spaCyを使用したNLPパイプラインの強化」

- 「盲目的なキャリブレーションによる無線...

- 信頼性のある世代をチェーンオブバーニケ...

- 「3Dガウシアンスプラッティング入門」

「GPUを使用してAmazon SageMakerのマルチモデルエンドポイントで数千のモデルアンサンブルを展開し、ホスティングコストを最小限に抑えます」

「人工知能(AI)の導入は、さまざまな業界やユースケースで加速しています深層学習(DL)、大規模言語モデル(LLM)、生成型AIの最近の科学的な突破により、お客様はほぼ人間のような性能を持つ高度な最先端ソリューションを利用することができるようになりましたこれらの複雑なモデルでは、ハードウェアのアクセラレーションが必要とされることがありますなぜなら、それにより高速なトレーニングだけでなく、より速い推論も可能になるからです[…]」

「Amazon SageMaker StudioでSpark UIをホストする」

「Amazon SageMakerは、ビッグデータ処理のための人気のある分散コンピューティングフレームワークであるApache Sparkを使用して、分散データ処理ジョブを実行するためのいくつかの方法を提供していますSageMaker StudioノートブックとAWS Glueのインタラクティブセッションを接続して、Sparkジョブをサーバーレスクラスターで実行するために、SageMaker StudioからSparkアプリケーションをインタラクティブに実行することができますインタラクティブセッションを使用することで、[...]」

「Swift Transformersのリリース:AppleデバイスでのオンデバイスLLMsの実行」

私はiOS/Macの開発者に多くの敬意を持っています。2007年にiPhone向けのアプリを書き始めたときは、まだAPIやドキュメントさえ存在しませんでした。新しいデバイスは、制約空間におけるいくつかの見慣れない決定を採用しました。パワー、画面の広さ、UIのイディオム、ネットワークアクセス、永続性、遅延などの組み合わせは、それまでとは異なるものでした。しかし、このコミュニティはすぐに新しいパラダイムに適した優れたアプリケーションを作り出すことに成功しました。 私はMLがソフトウェアを構築する新しい方法だと信じており、多くのSwift開発者が自分のアプリにAI機能を組み込みたいと思っていることを知っています。MLのエコシステムは大きく成熟し、さまざまな問題を解決する数千のモデルが存在しています。さらに、LLM(Language and Learning Models)は最近、ほぼ汎用のツールとして登場しました。テキストやテキストに似たデータで作業するため、新しいドメインに適応させることができます。私たちは、LLMが研究所から出てきて、誰にでも利用可能なコンピューティングツールになりつつあるという、コンピューティングの歴史上の転換点を目撃しています。 ただし、LlamaのようなLLMモデルをアプリに使用するには、多くの人が直面し、単独で解決する必要があるタスクがあります。私たちはこの領域を探求し、コミュニティと一緒に取り組みを続けたいと考えています。開発者がより速く開発できるように、ツールとビルディングブロックのセットを作成することを目指しています。 今日は、このガイドを公開し、MacでCore MLを使用してLlama 2などのモデルを実行するために必要な手順を説明します。また、開発者をサポートするためのアルファ版のライブラリとツールもリリースしています。MLに興味のあるすべてのSwift開発者にPRやバグレポート、意見を提供して、一緒に改善するよう呼びかけています。 さあ、始めましょう! 動画: Llama 2 (7B)チャットモデルがCore MLを使用してM1 MacBook Proで実行されています。 今日リリース swift-transformersは、テキスト生成に焦点を当てたSwiftで実装されたtransformersライクなAPIを開発中のSwiftパッケージです。これはswift-coreml-transformersの進化版であり、より広範な目標を持っています。Hubの統合、任意のトークナイザのサポート、プラグイン可能なモデルなど。 swift-chatは、パッケージの使用方法を示すシンプルなアプリです。 transformersモデルのCore ML変換のための更新されたバージョンのexporters、Core ML変換ツールであるtransformers-to-coremlの更新されたバージョン。 これらのテキスト生成ツールで使用するために準備されたLlama…

「DPOを使用してLlama 2を微調整する」

はじめに 人間のフィードバックからの強化学習(RLHF)は、GPT-4やクロードなどのLLMの最終トレーニングステップとして採用され、言語モデルの出力が人間の期待に合致するようにするために使われます。しかし、これによってRLの複雑さがNLPにもたらされます。良い報酬関数を構築し、モデルに状態の価値を推定するように訓練し、同時に元のモデルからあまり逸脱せずに意味のあるテキストを生成するように注意する必要があります。このようなプロセスは非常に複雑で、正しく行うのは常に簡単ではありません。 最近の論文「Direct Preference Optimization」(Rafailov、Sharma、Mitchell他)では、既存の方法で使用されるRLベースの目的を、シンプルなバイナリクロスエントロピー損失を直接最適化できる目的に変換することを提案しており、これによりLLMの改善プロセスが大幅に簡素化されます。 このブログ記事では、TRLライブラリで利用可能なDirect Preference Optimization(DPO)メソッドを紹介し、さまざまなスタックエクスチェンジポータルの質問に対するランク付けされた回答を含むスタックエクスチェンジのデータセットで最近のLlama v2 7Bパラメータモデルを微調整する方法を示します。 DPO vs PPO 人間の派生した好みをRLを通じて最適化する従来のモデルでは、補助的な報酬モデルを使用し、興味のあるモデルを微調整して、この報酬をRLの仕組みを利用して最大化するようにします。直感的には、報酬モデルを使用して最適化するモデルにフィードバックを提供し、ハイリワードのサンプルをより頻繁に生成し、ローリワードのサンプルをより少なく生成するようにします。同時に、フリーズされた参照モデルを使用して、生成物があまり逸脱せずに生成の多様性を維持し続けるようにします。これは通常、参照モデルを介した全報酬最大化の目的にKLペナルティを追加することで行われ、モデルが報酬モデルをごまかしたり利用したりすることを防ぐ役割を果たします。 DPOの定式化は、報酬モデリングのステップをバイパスし、報酬関数から最適なRLポリシーへの解析的なマッピングを使用して、言語モデルを好みのデータに最適化します。このマッピングは、与えられた報酬関数が与えられた好みのデータとどれだけ合致するかを直感的に測定します。したがって、DPOはRLHFの損失の最適解から始まり、変数の変換を介して参照モデルに対する損失を導出することで、参照モデルのみに対する損失を得ることができます。 したがって、この直接的な尤度目的は、報酬モデルやポテンシャルに煩雑なRLベースの最適化を必要とせずに最適化することができます。 TRLのトレーニング方法 前述のように、通常、RLHFパイプラインは次の異なるパーツで構成されています: 教師あり微調整(SFT)ステップ データに好みのラベルを付けるプロセス 好みのデータで報酬モデルをトレーニングする そして、RL最適化ステップ TRLライブラリには、これらのパーツのためのヘルパーが付属していますが、DPOトレーニングでは報酬モデリングとRL(ステップ3と4)のタスクは必要ありません。代わりに、TRLのDPOTrainerにステップ2の好みのデータを提供する必要があります。このデータは非常に特定の形式を持ちます。具体的には、次の3つのキーを持つ辞書です: prompt:テキスト生成の際にモデルに与えられるコンテキストプロンプトです…

「NVIDIA H100 Tensor Core GPUを使用した新しいMicrosoft Azure仮想マシンシリーズが一般利用可能になりました」

Microsoft Azureのユーザーは、最新のNVIDIAの高速計算技術を利用して、生成型AIアプリケーションのトレーニングと展開ができるようになりました。 本日から利用可能なMicrosoft Azure ND H100 v5 VMは、NVIDIA H100 Tensor Core GPUとNVIDIA Quantum-2 InfiniBandネットワーキングを使用しており、ブラウザからのクリック操作で生成型AI、高性能コンピューティング(HPC)などのアプリケーションをスケーリングできます。 全米の顧客に提供されるこの新しいインスタンスは、開発者や研究者が大規模な言語モデル(LLM)と高速計算を使用して新しい消費者およびビジネスのユースケースを見つけ出している時期に登場しました。 NVIDIA H100 GPUは、第4世代のTensor Cores、LLMの加速化に使用される新しいTransformer Engine、および各GPU間で900GB/secで通信できる最新のNVLink技術などのアーキテクチャイノベーションにより、スーパーコンピュータクラスのパフォーマンスを提供します。 また、NVIDIA Quantum-2 CX7 InfiniBandの採用により、3,200…

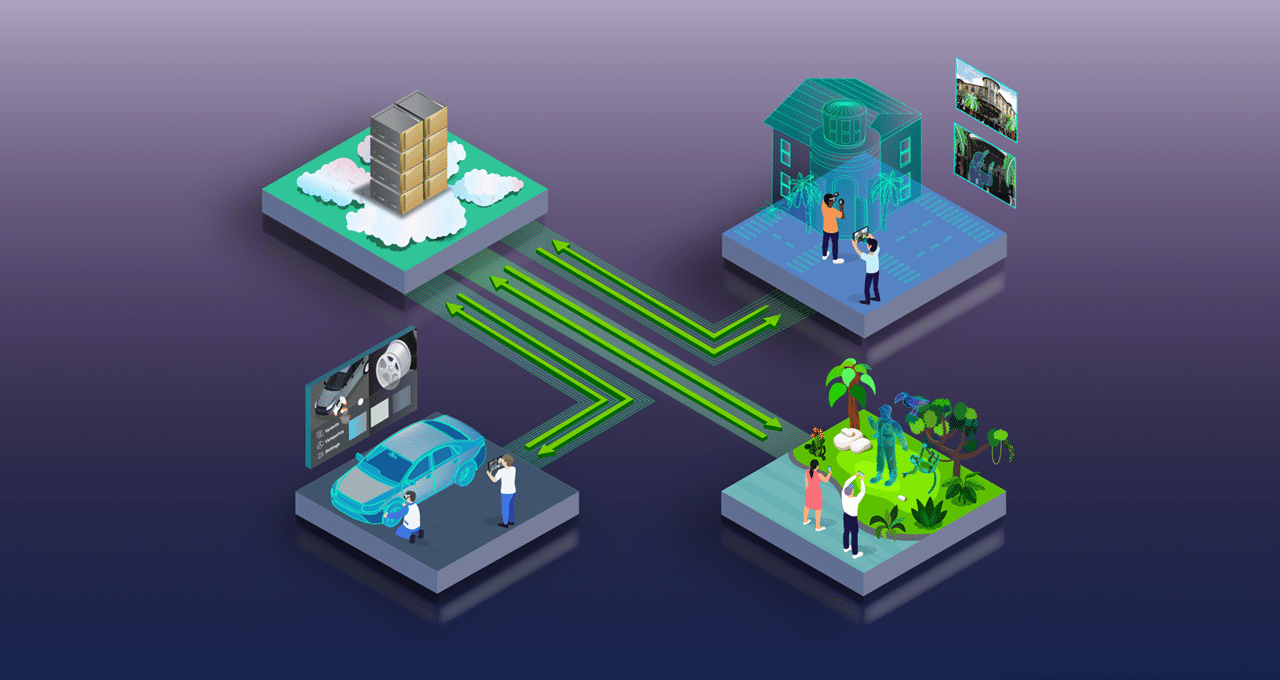

「DENZAはWPPと協力し、NVIDIA Omniverse Cloud上で高度な車両設定ツールを構築・展開する」

BYDとメルセデス・ベンツの共同ベンチャーである高級EVブランドDENZAは、マーケティングおよびコミュニケーションの大手WPPとNVIDIA Omniverse Cloudとの協力を通じて、次世代の車両設定ツールを構築および展開することを発表しました。NVIDIAの創設者兼CEOであるJensen Huangは、SIGGRAPHでこの発表を行いました。 WPPは、産業デジタル化アプリケーションの開発、展開、管理を支援するOmniverse Cloudを使用して、自動車メーカーの非常に複雑なデザインとマーケティングのプロセスを統一するために取り組んでいます。 Omniverse Cloudにより、WPPはDENZA N7モデルの物理的に正確でリアルタイムなデジタルツインを構築することができます。EVメーカーの優先するコンピュータ支援設計ツールからのフルフィデリティのデザインデータを、Universal Scene Description(USD)またはOpenUSDを介して統合します。 OpenUSDは、ソフトウェアツールとデータタイプの間での相互運用性を可能にする3Dフレームワークです。これにより、WPPはプロプライエタリデータの隔離を解消し、デザインチームや関係者の大規模なチームとの共同作業を促進することができます。これにより、WPPはデザインプロセスの早い段階でのローンチキャンペーンに取り組むことができ、反復作業を迅速かつ低コスト化することができます。 Omniverse Cloudによるアセットパイプラインの統一 Omniverse Cloudを使用することで、WPPのチームは、Autodesk MayaやAdobe Substance 3D PainterなどのOpenUSD対応のデザインおよびコンテンツ作成ツールのパイプラインを接続し、DENZA N7向けの新しい設定ツールを開発することができます。Omniverseの統一されたアセットパイプラインにより、WPPのアーティストチームは、DENZA N7の全エンジニアリングデータセットのパストレースビューをリアルタイムで繰り返し編集することができます。これにより、仮想車両が物理的な車両を正確に表現することが保証されます。 従来の車両設定ツールでは、全ての可能なオプションやバリアントを表現するために何十万枚もの画像を事前にレンダリングする必要がありました。OpenUSDを使用することで、WPPは1つのアセットにすべての可能なバリアントを含む車両のデジタルツインを作成することができます。事前にレンダリングされた画像は必要ありません。 同時に、WPPの環境アーティストは、完全にインタラクティブなライブ3D仮想セットを作成します。これは、WPPがロボット犬と共にキャプチャした現実世界の環境のスキャンから始まることができます。または、Shutterstockなどのプロバイダが提供する生成AIツールを活用して、即座に360度のHDRi背景を生成することもできます。これにより、パーソナライズの機会を最大限に活用したカスタム環境を迅速に作成することができます。…

「シャッターストックがNVIDIAピカソとともに生成AIを3Dシーンの背景に導入」

こんな感じです:Shutterstockの最新のツールを使って、クリエイターはジェネレーティブAIの助けを借りて、迅速にカスタマイズ可能な3Dシーンの背景を作成することができます。 このビジュアルコンテンツプロバイダーは、視覚デザインのためのジェネレーティブAIモデルを開発するためのクラウドベースのファウンドリであるNVIDIA Picassoを使用してサービスを構築しています。 この作業には、Picassoの最新機能が組み込まれており、それはNVIDIAの創設者兼CEOであるJensen Huang氏のSIGGRAPH基調講演で今日発表されました。この機能は、AIモデルを使用して完全にライセンスされ、権利が予約されたデータを使用して、単純なテキストや画像のプロンプトに基づいてアーティストが3Dシーンを強化し、照明するのに役立ちます。 これらのプロンプトから、新しいジェネレーティブAI機能は迅速にカスタムの360度、8K解像度、ハイダイナミックレンジイメージング(HDRi)環境マップを生成し、アーティストはそれを使用して背景を設定し、シーンを照らすことができます。 これは、NVIDIAとShutterstockの協力関係を拡大し、次世代のデジタルコンテンツ作成ツールを強化し、3Dモデルの生成を加速させるものです。 映画、ゲーム、仮想世界、広告などで没入型のビジュアルの需要が急増しているため、3Dアーティストコミュニティは急速に拡大しており、昨年に比べて20%以上成長しています。 これらのアーティストの多くは、複雑なワークフローを強化するためにジェネレーティブAIを活用しており、テクノロジーを使って環境マップを迅速に作成してカスタマイズすることができます。これにより、3Dシーンの主要なアセットであるヒーロー3Dアセットに取り組む時間が増え、魅力的な3Dビジュアルを作成する際に大きな違いを生み出します。 Shutterstockの3Dイノベーション担当副社長であるDade Orgeron氏は、「NVIDIA Picassoを使用して、3Dアーティストとコラボレータをハイパーエンエーブルし、彼らが以前よりも速く理想の没入環境を構築し、コンテンツ作成ワークフローを効率化するお手伝いをすることに取り組んでいます」と述べています。 写真のような環境マップの生成 以前は、アーティストは高価な360度カメラを購入して背景や環境マップをゼロから作成するか、正確には3Dシーンに合わない固定のオプションから選択する必要がありました。 今では、ユーザーは簡単なプロンプト(テキストまたは参照画像など)を提供するだけで、Picasso上に構築された360度HDRiサービスが迅速にパノラマ画像を生成します。さらに、ジェネレーティブAIのおかげで、カスタム環境マップはプロンプトとして入力された背景画像と自動的に一致します。 ユーザーはその後、マップをカスタマイズし、アイデアを素早く繰り返し、望むビジョンを実現するまで作業することができます。 3Dワールド構築を強化するためのコラボレーション メディアやエンターテイメントのクリエータに向けた3Dソフトウェアやツールの提供者であるAutodeskは、アーティストが世界中の観客を魅了するための創造的な自由を与えることに焦点を当てています。 Autodeskは、Picassoの基礎モデルを使用して開発されたジェネレーティブAIコンテンツ作成サービスを、人気のある3DソフトウェアMayaと統合することで、アーティストが単調な作業から解放され、最終的にはより速くコンテンツを制作できるようにしています。 AIを使用してAutodeskの顧客ワークフローを強化することで、アーティストは創造に集中し、コンテンツをより迅速に制作することができます。 ジェネレーティブAIモデルファウンドリ Picassoは、テキスト、ビジュアルコンテンツ、さらには生物学にまで及ぶエンタープライズレベルのジェネレーティブAIを進化させるNVIDIA AI Foundationsの一部です。…

「NVIDIA Studio内のコンテンツ作成が、新しいプロフェッショナルGPU、AIツール、OmniverseおよびOpenUSDの共同作業機能によって向上します」

AIと高速計算は、コンピュータグラフィックスの専門家が集まる世界最大のイベントであるSIGGRAPHで注目されました。NVIDIAの創設者兼CEOであるジェンソン・ファンが基調講演で発表したNVIDIA Omniverseのアップデートにより、3Dツールやアプリケーションの構築と接続を可能にするプラットフォーム、および3Dワールドのためのオープンで拡張可能なエコシステムであるUniversal Scene Description(OpenUSDとも呼ばれる)のアクセラレーションが行われました。 これは、最近発表されたNVIDIAがピクサー、アドビ、アップル、オートデスクと共にAlliance for OpenUSDを形成したことに続くものです。これにより、産業全体でのデジタル化のための3Dツールとコンテンツの互換性が確保され、3Dグラフィックス、デザイン、シミュレーションの次の時代の解放が実現されました。 NVIDIAは、最新のAI、グラフィックス、リアルタイムレンダリング技術を世界中のプロフェッショナルに提供する3つの新しいデスクトップワークステーションAda Generation GPUであるNVIDIA RTX 5000、RTX 4500、RTX 4000を発表しました。 Shutterstockは、NVIDIA Picassoを使用してトレーニングされた基礎モデルを使用して、3Dシーンの背景に生成AIを導入しています。Picassoでトレーニングされたモデルは、高速なシーン開発のための写実的で8Kの360度高ダイナミックレンジイメージング(HDRi)環境マップを生成できるようになりました。オートデスクも、Picassoで開発された基礎モデルを使用した生成AIコンテンツ作成サービスを、人気のあるオートデスクのMayaソフトウェアに統合する予定です。 毎月、NVIDIA Studio Driverのリリースでは、アーティスト、クリエイター、3D開発者がクリエイティブなアプリケーションを使用する際に最高のパフォーマンスと信頼性を提供します。今日から利用可能な8月のNVIDIA Studio Driverは、クリエイターがお気に入りのクリエイティブアプリを使用する際の最高の信頼性を提供します。Omniverse、XSplit Broadcaster、Reallusion iCloneのアップデートに対応しています。 さらに、今週のNVIDIA…

拡張版:NVIDIAがビデオ編集のためのMaxineを拡大し、3D仮想会議の研究を披露

プロフェッショナル、チーム、クリエイターなどは、NVIDIA Maxineの助けを借りて、標準のマイクやウェブカメラを使用しても高品質なオーディオやビデオの効果を作成するためにAIの力を活用することができます。 GPUアクセラレートされたソフトウェア開発キットとクラウドネイティブなマイクロサービスのスイートを使用することで、ユーザーはリアルタイム通信サービスやプラットフォームのためにオーディオ、ビデオ、拡張現実の効果を向上させるAI機能を展開することができます。Maxineはまた、ビデオ編集の機能も拡張し、チームがビデオコミュニケーションで新たな高みに到達することを可能にします。 さらに、NVIDIAの研究デモでは、AIが3D機能を備えたビデオ会議を次のレベルに引き上げる方法をSIGGRAPHカンファレンスで紹介しています。 NVIDIA Maxineの機能がビデオ編集に拡大 無線接続のおかげで、人々は以前よりもさまざまな場所から仮想会議に参加することができるようになりました。通常、通話者が移動中であるか、接続が不良な場所にいる場合、音声とビデオの品質は大きく影響を受けます。 背景ノイズ除去、スーパーレゾリューション、アイコンタクトなどのリアルタイムのMaxineの高度な機能により、リモートユーザーは人とのコミュニケーション体験を向上させることができます。 さらに、Maxineは現在ビデオ編集にも使用できます。NVIDIAのパートナーは、ビデオ会議を高めるMaxineの同じ機能でこのプロフェッショナルワークフローを変革しています。セールスプレゼンテーションやウェビナーなどのビデオを編集する際の目標は、可能な限り広い観客に魅力を伝えることです。Maxineを使用することで、プロフェッショナルはオーディオとビデオの信号を向上させるAI機能を利用することができます。 Maxineを使用することで、スポークスパーソンは画面から目を離してノートや台本を参照することができますが、彼らの視線はまるで直接カメラを見ているかのように保たれます。ユーザーは低解像度でビデオを撮影し、後で品質を向上させることもできます。さらに、Maxineを使用すると、人々はさまざまな言語でビデオを録画し、英語で出力することができます。 今年のアーリーアクセスでリリースされるMaxineの機能には、以下が含まれます: 通訳:簡体字中国語、ロシア語、フランス語、ドイツ語、スペイン語から英語に翻訳し、ユーザーのイメージをアニメーション化して英語を話しているように表示します。 音声フォント:スピーカーの音声の特性を適用し、オーディオ出力にマッピングすることができます。 オーディオスーパーレゾリューション:オーディオ信号の時間分解能と帯域幅を増加させることで、音声の品質を向上させます。現在、8,000Hzから16,000Hzへのアップサンプリングと16,000Hzから48,000Hzへのアップサンプリングをサポートしています。この機能は、レイテンシを50%以上削減し、スループットを2倍向上させるアップデートも行われています。 Maxineクライアント:MaxineのマイクロサービスのAI機能をPCのビデオ会議セッションにもたらします。このアプリケーションは低レイテンシのストリーミングに最適化されており、すべてのGPUコンピュート要件にクラウドを使用します。Thin Clientはこの秋にWindowsで利用可能になり、その他のOSサポートも続く予定です。 Maxineはクラウド、オンプレミス、エッジで展開することができるため、ほぼどこからでもクオリティの高いコミュニケーションが可能です。 ビデオ会議を新たな高みに 多くのパートナーと顧客がMaxineを使用して高品質なビデオ会議や編集を体験しています。Maxineの2つの機能であるEye ContactとLive Portraitは、現在NVIDIA AI Enterpriseソフトウェアプラットフォームの製品リリースで利用可能です。Eye Contactは、ユーザーの視線をカメラと一致させることで、カメラとの直接的な視線接触をシミュレートします。また、Live…

「NVIDIAは、エンタープライズや開発者向けに拡張現実(Extended-Reality)ストリーミングをよりスケーラブルでカスタマイズ可能にする」

さまざまな業界の組織は、拡張現実(XR)を使用してワークフローを再設計し、生産性を向上させています。これには、没入型トレーニングや共同設計レビューなどが含まれます。 オールインワン(AIO)ヘッドセットの使用が増えるにつれ、より多くのチームがXRを採用して統合しています。AIOヘッドセットはXRの使用を容易にしますが、コンピュートパワーやレンダリング能力に限界があり、ストリーミング体験のグラフィックスクオリティを制限する場合があります。 NVIDIAは、CloudXR Suiteを使用して、より多くの企業や開発者が高品質なXRを採用できるようにしています。CloudXRはストリーミングを大幅に簡素化し、AIOヘッドセットやモバイルXRデバイスを持つ人々がどの場所からでも高品質な没入型環境を体験できるようにします。 CloudXR Suiteは、NVIDIA RTX GPUとNVIDIA RTX Virtual Workstation(vWS)ソフトウェアのパワーを組み合わせて、AndroidおよびiOSデバイスに高品質なXRアプリケーションをストリーミングします。ネットワークの状況に動的に適応することで、CloudXRはイメージの品質とフレームレートを最大化し、次世代のワイヤレス拡張現実(AR)および仮想現実(VR)体験を実現します。 CloudXRを使用することで、企業は効果的にXRワークロードを組織化し、スケーリングする柔軟性を得ることができ、開発者はユーザー向けにカスタムXR製品を作成するために高度なプラットフォームを使用することができます。このスイートは、公共およびプライベートネットワークの両方で高品質のストリーミングを提供します。 EricssonとVMwareは、CloudXRを使用する最初の企業の一部です。 XRワークフローを次のレベルに引き上げる CloudXR Suiteは、テザードVR体験に匹敵するパフォーマンスを提供します。 これには、いくつかの更新を含む3つのコンポーネントが含まれます: CloudXR Essentialsは、スイートの基盤となるストリーミングレイヤーで、5G L4Sの最適化、QoSアルゴリズム、強化されたログツールなどの新しい改善がもたらされます。EssentialsにはSteamVRプラグイン、サンプルクライアント、および新しいサーバーサイドアプリケーションプログラミングインターフェースも含まれます。 CloudXR Server Extensionsは、Monado OpenXRランタイムへのソースコードの追加により、サーバーサイドのインターフェースを改善します。CloudXR…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.