Learn more about Search Results ming gao - Page 2

- You may be interested

- 「インド、人工知能を利用し言語の壁を解...

- NVIDIA NeMoを使ったスタートアップが生成...

- 報告書:OpenAIがGPT-Visionというマルチ...

- 「ディズニーは小さなロボットに大きな感...

- 「UCLA研究者がGedankenNetを紹介:物理法...

- 「チップの戦いに勝ちたいですか?たくさ...

- アナリティクスエンジニアリングへの紹介

- 「品質と信頼性のためのPythonコードのユ...

- エッジでの視覚品質検査のためのエンド・...

- 「フリーノイズ」にご挨拶:複数のテキス...

- 「Google CloudがGenerative AIの保護を顧...

- 「意思決定の解放:AIが理論的な枠組みと...

- SparkとPlotly Dashを使用したインタラク...

- 「見逃すな!2023年が終わる前に無料のコ...

- AIと機械学習のためのReactJS:強力な組み...

GoogleがACL 2023に参加します

Posted by Malaya Jules, Program Manager, Google 今週、計算言語学協会(ACL)の第61回年次総会がオンラインで開催されています。ACLは、自然言語に関する計算手法に関連する広範な研究分野をカバーする一流のカンファレンスです。 自然言語処理と理解のリーダーであり、ACL 2023のダイヤモンドレベルスポンサーであるGoogleは、50以上の論文を発表し、様々なワークショップやチュートリアルに積極的に参加することで、この分野での最新の研究を紹介します。 ACL 2023に登録されている場合、Googleブースにぜひ訪れ、数十億人の人々のために興味深い問題を解決するためにGoogleで行われているプロジェクトについて詳しく学んでください。以下でGoogleの参加についてもっと詳しく学ぶこともできます(Googleの関連組織は太字で示されています)。 理事会および組織委員会 エリアチェアには:Dan Garrette、ワークショップチェアには:Annie Louis、出版チェアには:Lei Shu、プログラム委員会には:Vinodkumar Prabhakaran、Najoung Kim、Markus Freitagが含まれます。 注目論文 NusaCrowd:Indonesian NLPリソースのオープンソースイニシアティブ Samuel…

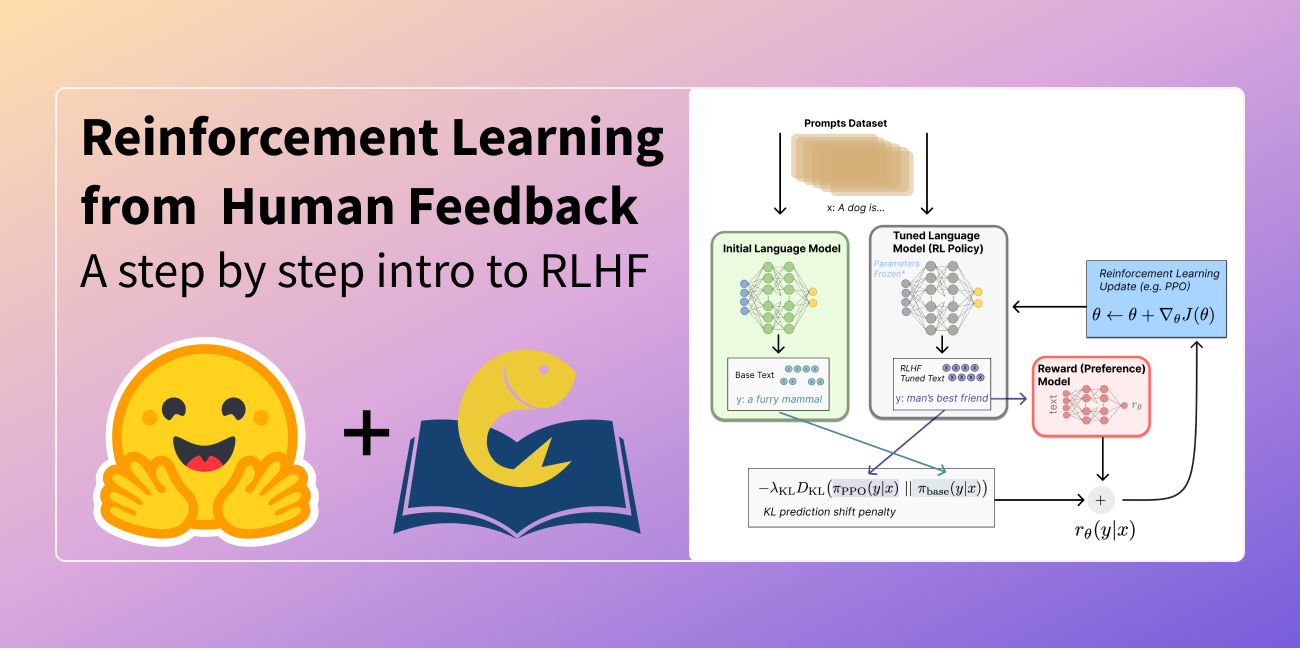

人間のフィードバックからの強化学習(RLHF)の説明

この記事は以下の言語に翻訳されています:中国語(簡体字)とベトナム語。他の言語に翻訳に興味がありますか?nathan at huggingface.co までお問い合わせください。 言語モデルは、過去数年間に人間の入力プロンプトから多様で魅力的なテキストを生成する能力を示してきました。しかし、「良い」テキストとは何かは、主観的で文脈に依存するため、本質的に定義するのは難しいです。創造性を求める物語の執筆などの多くのアプリケーションでは、真実であるべき情報の断片、または実行可能なコードのスニペットなどが必要です。 これらの属性を捉えるための損失関数を作成することは困難であり、ほとんどの言語モデルはまだ単純な次のトークン予測の損失(例:クロスエントロピー)で訓練されています。損失自体の欠点を補うために、人々はBLEUやROUGEなど、人間の優先順位をより適切に捉えるように設計されたメトリクスを定義しています。これらのメトリクスは、パフォーマンスを測定する上で損失関数自体より適しているものの、生成されたテキストを単純なルールで参照テキストと比較するだけなので、制約もあります。生成されたテキストに対する人間のフィードバックをパフォーマンスの指標として使用するか、さらに進んでそのフィードバックを損失としてモデルを最適化することができれば、素晴らしいことではないでしょうか?それが「人間のフィードバックによる強化学習(RLHF)」のアイデアです。強化学習の手法を使用して、言語モデルを人間のフィードバックで直接最適化するのです。RLHFにより、言語モデルは一般的なテキストデータのコーパスで訓練されたモデルを複雑な人間の価値に合わせることができるようになりました。 RLHFの最近の成功例は、ChatGPTでの使用です。ChatGPTの印象的な能力を考慮して、RLHFについて説明してもらいました: それは驚くほどうまくいっていますが、すべてをカバーしているわけではありません。それらのギャップを埋めましょう! 人間のフィードバックによる強化学習(RL from human preferencesとも呼ばれます)は、複数のモデルのトレーニングプロセスと異なる展開の段階を伴うため、難しい概念です。このブログ記事では、トレーニングプロセスを次の3つの主要なステップに分解します: 言語モデル(LM)の事前トレーニング データの収集と報酬モデルのトレーニング 強化学習によるLMの微調整 まず、言語モデルの事前トレーニングについて見ていきましょう。 言語モデルの事前トレーニング RLHFの出発点として、クラシカルな事前トレーニング目標で既に事前トレーニングされた言語モデルを使用します(詳細については、このブログ記事を参照してください)。OpenAIは、最初の人気のあるRLHFモデルであるInstructGPTに対して、より小さなバージョンのGPT-3を使用しました。Anthropicは、このタスクのためにトレーニングされた1,000万から520億のパラメータを持つトランスフォーマーモデルを使用しました。DeepMindは、2800億のパラメータモデルGopherを使用しました。 この初期モデルは、追加のテキストや条件で微調整することもできますが、必ずしも必要ではありません。たとえば、OpenAIは「好ましい」とされる人間が生成したテキストを微調整し、Anthropicは彼らの「助けになり、正直で無害な」基準に基づいて元のLMを蒸留することで、RLHFのための初期LMを生成しました。これらは共に、私が高価な増強データと呼ぶものの一部ですが、RLHFを理解するために必要なテクニックではありません。 一般的に、「どのモデル」がRLHFの出発点として最適かは明確な答えがありません。このブログ記事では、RLHFのトレーニングにおけるオプションの設計空間が完全に探索されていないという共通のテーマになります。 次に、言語モデルが必要なデータを生成して、人間の優先順位がシステムに統合される「報酬モデル」をトレーニングする必要があります。 報酬モデルのトレーニング 人間の優先順位に合わせてキャリブレーションされた報酬モデル(RM、優先モデルとも呼ばれます)を生成することは、RLHFの比較的新しい研究の出発点です。その基本的な目標は、テキストのシーケンスを受け取り、数値で人間の優先順位を表すべきスカラー報酬を返すモデルまたはシステムを取得することです。システムはエンドツーエンドのLMであるか、報酬を出力するモジュラーシステム(例:モデルが出力をランク付けし、ランキングが報酬に変換される)である場合があります。出力がスカラーの報酬であることは、既存のRLアルゴリズムが後のRLHFプロセスにシームレスに統合されるために重要です。 報酬モデリングのためのこれらの言語モデルは、別の微調整された言語モデルまたは好みのデータでスクラッチからトレーニングされた言語モデルのいずれかです。例えば、Anthropicは、これらのモデルを事前トレーニング(好みモデルの事前トレーニング、PMP)の後に初期化するために専門の微調整方法を使用しています。彼らは、これが微調整よりもサンプル効率が高いと結論付けましたが、報酬モデリングのバリエーションの中で明確な最良の選択肢はありません。…

METAのHiera:複雑さを減らして精度を高める

畳み込みニューラルネットワークは、20年以上にわたってコンピュータビジョンの分野を支配してきましたトランスフォーマーの登場により、それらは放棄されると考えられていましたしかし、多くの実践者は…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.

.jpg)