Learn more about Search Results WNR AI - Page 2

- You may be interested

- アントロピックは、SKテレコムから1億ドル...

- チポトレは、ガカモレの準備をするロボッ...

- 「MLOpsは過学習していますその理由をここ...

- 「Pythonにおけるフィボナッチ数列 | コー...

- 紙からピクセルへ:デジタルファックスが...

- 大型モデルがビッグデータと出会う:スパ...

- ‘Perceiver IO どんなモダリティに...

- 「データの血統と現代データ管理における...

- 「DALL·E2に対する哲学的かつ芸術的な視点」

- 「Matplotlibのマスタリング:データ可視...

- 指数平滑移動平均の直感的な説明

- 🤗 Transformersにおいて制約付きビームサ...

- 「AIとビジネス戦略:ポリッシングロボッ...

- 「大規模言語モデルのドメイン適応」

- 「2023年の小売り向けデータストリーミン...

「ESAのセンチネルAPIに深く潜入」

ヨーロッパ宇宙機関は、さまざまな種類のリモートセンシングを活用して、地球観測を支援するコペルニクスプログラムの一環として、センチネルミッションを実施しています

ジェネラティブ人工知能を解明:拡散モデルと視覚コンピューティングの進化についての詳細な解説

コンピュータグラフィックスおよび3Dコンピュータビジョングループは、コンピュータ生成の視覚を組み合わせたり、写真からシーンの物理的特性を推測したりするために、数十年間物理的に現実的なモデルを作成するために取り組んできました。ビジュアルエフェクト、ゲーム、画像およびビデオ処理、コンピュータ支援設計、仮想および拡張現実、データ可視化、ロボティクス、自律型車両、リモートセンシングなどを含むいくつかの業界は、レンダリング、シミュレーション、ジオメトリ処理、フォトグラメトリを含むこの手法に基づいて構築されています。生成的人工知能(AI)の台頭により、視覚コンピューティングについての完全に新しい思考のあり方が現れました。生成的AIシステムにより、書き込みのプロンプトまたは高レベルの人間の指示のみを入力として、写真、映画、または3Dオブジェクトの作成および操作が可能になります。 これらのテクノロジーは、以前は専門的なトピックの専門家にしか利用できなかった視覚コンピューティングの多くの時間を要するタスクを自動化します。Stable Diffusion、Imagen、Midjourney、またはDALL-E 2およびDALL-E 3などの視覚コンピューティングの基礎モデルは、生成的AIの無類の能力を開放しました。これらのモデルは、何億ものテキストと画像のペアリングで訓練された後、すでに「それをすべて見てきた」と言えるほど膨大で、数十億の学習可能なパラメータを持っています。これらのモデルは、非常に強力なグラフィックス処理ユニット(GPU)のクラウドで訓練されました。 画像、ビデオ、および3Dオブジェクトを生成するために使用される畳み込みニューラルネットワーク(CNN)に基づく拡散モデルは、CLIPなどのトランスフォーマベースのアーキテクチャを使用して計算されたテキストを多様な形式で統合します。2D画像生成のための基礎モデルを他の高次元のドメイン(ビデオや3Dシーン作成など)で使用するために、学術界にはまだ大きな貢献をする余地があります。 主により具体的な種類のトレーニングデータの必要性がこれを引き起こします。たとえば、ウェブ上には高品質で多様な3Dオブジェクトや設定の例よりも、低品質で一般的な2D写真の例がはるかに多くあります。また、ビデオ、3Dシーン、または4Dマルチビューコンシステントシーン合成に必要なより大きな次元に合わせて2Dイメージ生成システムをスケーリングする方法がすぐには明らかではありません。現在のネットワークアーキテクチャは、(ラベルのない)大量のビデオデータがウェブ上で利用可能であっても、訓練するには時間がかかりすぎるか、適切な計算リソースがないため、しばしば非効率なのです。これにより、拡散モデルは推論時間が非常に遅くなります。これは、ネットワークの大きさと反復的な性質に起因します。 図1:視覚コンピューティングの拡散モデルの理論と応用については、この最新の論文でカバーされています。これらのモデルは、最近では2Dおよび3D/4Dでのイメージ、ビデオ、およびオブジェクトの生成と変更のための受け入れられた基準として取って代わりました。 未解決の問題にもかかわらず、視覚コンピューティングの拡散モデルの数は昨年急増しました(図1に示すような例があります)。複数の大学の研究者によって開発されたこの最新のレポート(STAR)の目的は、視覚コンピューティングでの拡散モデルの応用に焦点を当てた多くの最近の出版物の整理されたレビューを提供し、拡散モデルの原理を教え、未解決の問題を特定することです。

「MITの新しい機械学習の研究では、階層的な計画(HiP)のための組成的な基礎モデルを提案しています:長期的な課題の解決のために言語、ビジョン、行動を統合する」

見知らぬ家でお茶を準備するという課題について考えてみましょう。このタスクを効率的に完了するための戦略は、抽象レベル(例えば、お茶を温めるために必要な高レベルの手順)、具体的な幾何学的レベル(例えば、彼らがどのように物理的に動き、キッチンを通り抜けるか)、および制御レベル(例えば、カップを持ち上げるために関節をどのように動かすか)を含む、複数のレベルで階層的に推論することです。茶ポットを探すための抽象的なプランは、幾何学的レベルで物理的に考えられ、彼らが行える行動に基づいて実行可能でなければなりません。そのため、各レベルでの推論が互いに整合性を持つことが重要です。本研究では、階層的な推論を用いることができる、ユニークな長期的なタスク解決用のボットの開発を調査しています。 大規模な「基礎モデル」は、数学的な推論、コンピュータビジョン、自然言語処理の問題に取り組む上でリードを取っています。「基礎モデル」を作成することは、このパラダイムの下で重要な問題であり、ユニークで長期的な意思決定問題に対応できる「基礎モデル」の作成には、多くの関心が集まっています。いくつかの以前の研究では、視覚、言語、アクションのデータをマッチさせ、長期的なタスクを処理するために単一のニューラルネットワークを訓練することが行われました。しかし、連動したビジョンと言語のロボットの例は、インターネット上で利用可能な豊富な資料に対して見つけることが難しく、編集するのにも費用がかかります。 さらに、モデルの重みがオープンソース化されていないため、GPT3.5/4やPaLMなどの高性能な言語モデルを微調整することは現在困難です。基礎モデルの主な特徴は、新しい問題を解決するために学習する必要がある場合よりも、はるかに少ないデータで解決できることです。本研究では、長期的な計画のための基礎モデルを構築するために、3つのモダリティ間でペアのデータを収集するという時間と費用のかかるプロセスに代わるスケーラブルな代替手段を模索しています。これは、新しい計画タスクの解決においても合理的に効果的であることができるでしょうか。 Improbable AI Lab、MIT-IBM Watson AI Lab、マサチューセッツ工科大学からの研究者たちは、階層的計画のための構成的基礎モデル(HiP)を提案しています。これは、言語、ビジョン、アクションのデータに独自にトレーニングされた多くの専門モデルから構成される基礎モデルです。基礎モデルを構築するために必要なデータ量は大幅に削減されます(図1)。HiPは、抽象的な言語指示で指定された意図したタスクから、一連のサブタスク(すなわち、計画)を発見するために大規模な言語モデルを使用します。HiPは、環境に関する幾何学的および物理的情報を収集するために大規模なビデオ拡散モデルを使用して、観察のみの軌跡としてより複雑な計画を開発します。最後に、HiPは、以前にトレーニングされた大規模な逆モデルを使用して、一連の自己中心的な画像をアクションに変換します。 図1:階層的計画のための構成的基礎モデルが上記に示されています。HiPは、タスクモデル(LLMによって表される)を使用して抽象的な計画を作成し、ビジュアルモデル(ビデオモデルによって表される)を使用して画像の軌跡計画を作成し、自己中心的なアクションモデルを使用して画像の軌跡からアクションを推論します。 連動した意思決定データをモダリティ間で収集する必要がないため、構成的な設計選択は、さまざまなモデルが階層の異なるレベルで推論し、専門的な結論を共同で導くことを可能にします。別々にトレーニングされた3つのモデルは、相反する結果を生成する可能性があり、全体の計画プロセスで失敗する可能性があります。例えば、キャビネットでティーケトルを探すという計画のステップは、一つのモデルでは高い確率で成功する一方で、もう一つのモデルでは確率がゼロになるかもしれません。家にキャビネットがない場合などです。代わりに、すべての専門モデルにわたって尤度を最大化する戦略をサンプリングすることが重要です。 彼らは、多様なモデル間で一貫性を確保するための反復的な改良技術を提供しています。ダウンストリームモデルからのフィードバックを利用して、異なるモデル間で一貫性のある計画を開発します。言語モデルの生成プロセスの出力分布には、各段階で現在の状態を表す条件付きの尤度推定器からの中間フィードバックが組み込まれています。同様に、アクションモデルからの中間入力は、開発プロセスの各段階でのビデオの作成を向上させます。この反復的な改良プロセスにより、多くのモデル間で合意形成が促進され、目標に対応し、既存の状態とエージェントに基づいて実行可能な階層的に一貫した計画が作成されます。彼らの提案された反復的改良手法は、広範なモデルの微調整を必要とせず、トレーニングの計算効率が高くなっています。 さらに、彼らはモデルの重みを知る必要もなく、彼らの戦略は入力と出力のAPIアクセスを提供するすべてのモデルに適用できます。結論として、彼らは長期の計画を作成するために、さまざまなインターネットおよびエゴセントリックなロボティクスデータのモダリティで独立に取得された基礎モデルの組成を使用する階層的計画の基礎モデルを提供しています。3つの長期のテーブルトップ操作シナリオにおいて、彼らは有望な結果を示しています。

LLMs(Language Model)と知識グラフ

LLMとは何ですか? Large Language Models (LLMs)は、人間の言語を理解し生成できるAIツールです。これらは、膨大な量のテキストデータでトレーニングされた数十億のパラメータを持つ強力なニューラルネットワークです。これらのモデルの広範なトレーニングにより、人間の言語の構造と意味について深い理解を持っています。 LLMsは、翻訳、感情分析、チャットボットの会話など、さまざまな言語タスクを実行することができます。LLMsは、複雑なテキスト情報を理解し、エンティティとその関係を認識し、繋がりを保ち、文法的に正しいテキストを生成することができます。 ナレッジグラフとは何ですか? ナレッジグラフは、異なるエンティティに関するデータと情報を表し結びつけるデータベースです。これには、オブジェクト、人物、場所を表すノードと、ノード間の関係を定義するエッジが含まれます。これにより、機械はエンティティがどのように関連し、属性を共有し、私たちの周りの世界の異なるものとの関係を把握することができます。 ナレッジグラフは、YouTubeの推奨ビデオ、保険詐欺の検出、小売業での製品推奨、予測モデリングなど、さまざまなアプリケーションで使用することができます。 出典:https://arxiv.org/pdf/2306.08302.pdf | ナレッジグラフの例 LLMsとナレッジグラフ LLMsの主な制限の1つは、「ブラックボックス」であること、つまり、彼らが結論にどのようにたどり着いているかを理解するのが難しいということです。さらに、彼らはしばしば事実情報を把握し取得するのが難しく、幻覚として知られる誤りや不正確さが生じることがあります。 ここで、ナレッジグラフがLLMsを推論するための外部知識を提供することができます。ただし、ナレッジグラフは構築が困難であり、進化している性質を持っています。そのため、LLMsとナレッジグラフを一緒に使用して、それぞれの強みを最大限に活かすことは良いアイデアです。 LLMsは、次の3つのアプローチを使用してナレッジグラフ(KGs)と組み合わせることができます: KGを活用したLLMs:これらは、トレーニング中にKGをLLMsに統合し、より理解力を高めるために使用します。 LLMを拡張したKGs:LLMsは、埋め込み、完了、質問応答など、さまざまなKGタスクを改善することができます。 シナジー効果のあるLLMs + KGs:LLMsとKGsは互いに補完し合い、データと知識に基づいた双方向の推論を促進します。 KGを活用したLLMs LLMsは、広範なテキストデータから学習することによって、さまざまな言語タスクで優れた能力を持つことで知られています。ただし、誤った情報(幻覚)を生成したり、解釈可能性に欠けたりするという批判も受けています。研究者は、これらの問題に対処するために、LLMsをナレッジグラフ(KGs)で拡張することを提案しています。 KGsは構造化された知識を保存しており、それを使用してLLMsの理解を向上させることができます。一部の手法では、LLMの事前トレーニング中にKGsを統合して知識の獲得を支援し、他の手法では推論中にKGsを使用してドメイン固有の知識アクセスを向上させます。KGsは、LLMsの推論と事実の解釈に使用され、透明性を改善します。…

「Transformerベースの拡散モデルによる画像生成の革新的なアーキテクチャイノベーションを実現するDiffusion Transformers(DiTs)」

機械学習の領域は、トランスフォーマーベースのアーキテクチャの出現により、自然言語処理、コンピュータビジョンなどの各種タスクを革新的に変革しました。しかし、画像レベルの生成モデルである拡散モデルには、依然として注目すべきギャップが存在し、これらのモデルは主に畳み込みU-Netアーキテクチャに従っています。 他のドメインがトランスフォーマーを採用しているのに対し、拡散モデルはまだこれらの強力なアーキテクチャを統合していません。この問題に取り組むため、ニューヨーク大学の研究者はDiffusion Transformers(DiTs)という革新的なアプローチを導入しており、従来のU-Netバックボーンをトランスフォーマーの機能で置き換えることで、拡散モデルのアーキテクチャにおける既存の慣習に挑戦しています。 現在、拡散モデルは洗練された画像レベルの生成モデルとなっていますが、依然として畳み込みU-Netに依存しています。この研究では、Vision Transformers(ViTs)の原則に基づき、拡散モデルにトランスフォーマーを統合するという画期的なコンセプトを紹介しています。この移行により、U-Netデザインの制約を超えた構造変換が推進され、拡散モデルがより広範なアーキテクチャのトレンドに合致し、拡張性、堅牢性、効率性を向上させることが可能になりました。 DiTsはVision Transformers(ViTs)アーキテクチャに基づいており、拡散モデルの設計に新たなパラダイムを提供しています。このアーキテクチャには、空間入力をトークンシーケンスに変換する「パッチ」というキーコンポーネントが含まれています。DiT-SからDiT-XLまでのさまざまなモデルサイズとともに、条件付き情報を処理するDiTブロックのバリアント、および「インコンテキストコンディショニング」、「クロスアテンションブロック」、「適応的レイヤーノルム(adaLN)ブロック」、「adaLNゼロブロック」も含まれています。これらのブロックデザインとモデルサイズのバリエーションは、強力な拡散モデルの設計に対する柔軟なツールキットを構成しています。 https://arxiv.org/abs/2212.09748 実験フェーズでは、さまざまなDiTブロックデザインのパフォーマンスを評価しています。異なるブロックデザインを採用した4つのDiT-XL/2モデルが訓練され、FIDスコアを基準としてadaLN-zeroブロックデザインの一貫した優越性が示され、その計算効率性と条件付けメカニズムのモデル品質への重要な役割が示されました。この発見は、adaLN-zeroの初期化方法の効果を強調し、さらなるDiTモデルの探索におけるadaLN-zeroブロックの採用に影響を与えました。 https://arxiv.org/abs/2212.09748 さらなる探索では、モデルサイズとパッチサイズを操作してDiT構成をスケーリングします。視覚化により、計算能力の拡張によって達成された画質の大幅な向上が示されます。この拡張は、トランスフォーマーの次元を拡張するか、入力トークンを増やすことによって実行することができます。モデルのGflopsとFID-50Kスコアのロバストな相関関係は、計算リソースがDiTのパフォーマンス向上において重要であることを強調しています。ImageNetデータセットの256×256および512×512の解像度で既存の拡散モデルに対してDiTモデルをベンチマークテストすることにより、説得力のある結果が明らかになりました。DiT-XL/2モデルは、両方の解像度のFID-50Kスコアで既存の拡散モデルを一貫して上回り、その堅牢なパフォーマンスは、DiTモデルがさまざまなスケールでの拡張性と柔軟性を持っていることを強調しています。さらに、この研究はDiT-XL/2モデルの固有の計算効率性を強調し、現実世界のアプリケーションにおける実用的な適用性を示しています。 結論として、Diffusion Transformers(DiTs)を導入することは、生成モデルの革新的な時代を告げるものです。トランスフォーマーの力を拡散モデルと融合することにより、DiTsは従来のアーキテクチャの常識に挑戦し、研究と実世界の応用において有望な道を提供します。包括的な実験と結果は、DiTsが画像生成の領域を前進させる潜在能力を強調し、先駆的なアーキテクチャのイノベーションとしての位置を明確にします。DiTsが画像生成の領域を再構築し続ける中で、トランスフォーマーとの統合は、異なるモデルアーキテクチャを統一し、さまざまなドメインでのパフォーマンス向上に向けた注目すべき一歩となります。

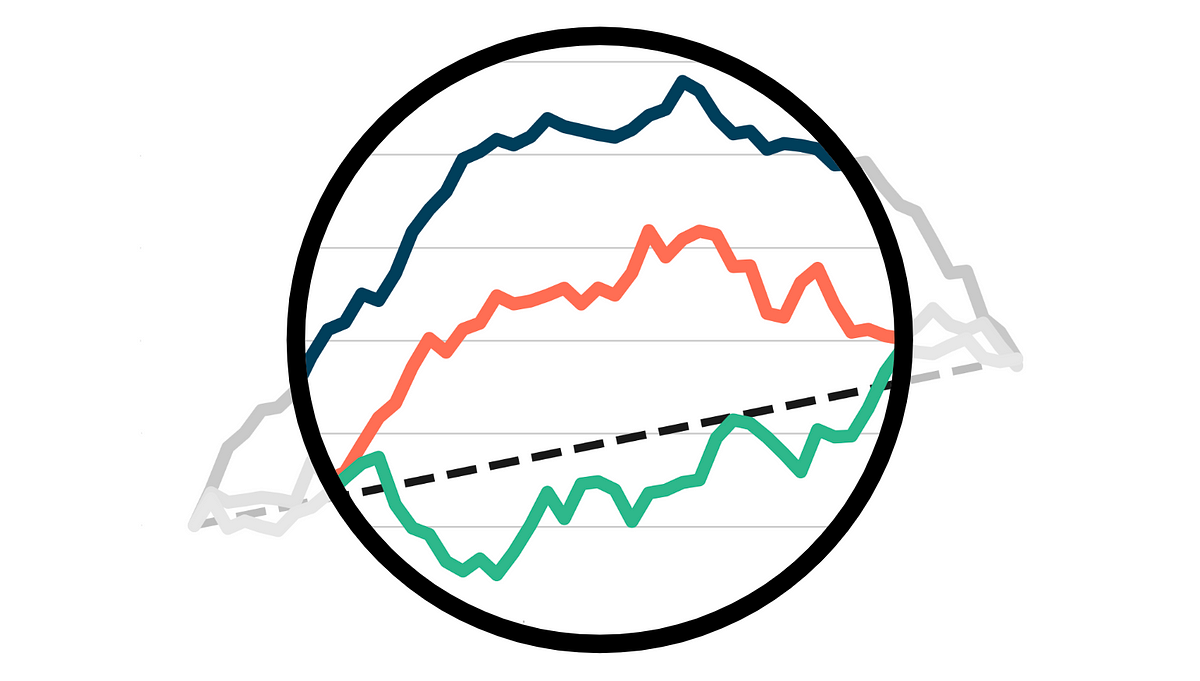

アップリフトモデルの評価

業界での因果推論の最も広く利用されているアプリケーションの1つは、アップリフトモデリング、または条件付き平均治療効果の推定ですある処置の因果効果を推定する際には、

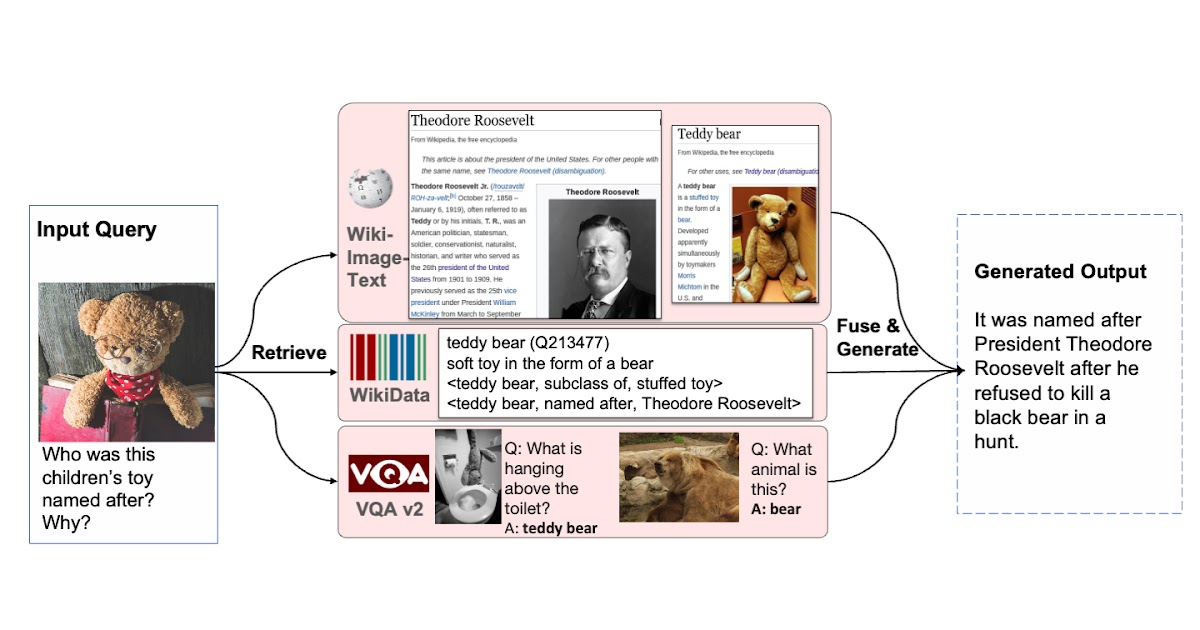

検索増強視覚言語事前学習

Google Research Perceptionチームの学生研究者Ziniu Huと研究科学者Alireza Fathiによる投稿 T5、GPT-3、PaLM、Flamingo、PaLIなどの大規模なモデルは、数百億のパラメータにスケーリングされ、大規模なテキストおよび画像データセットでトレーニングされると、多大な量の知識を格納する能力を示しました。これらのモデルは、画像キャプション、ビジュアルクエスチョンアンサリング、オープンボキャブラリー認識などのダウンストリームタスクで最先端の結果を達成しています。しかし、これらのモデルはトレーニングに膨大な量のデータを必要とし、数十億のパラメータ(多くの場合)を持ち、著しい計算要件を引き起こします。また、これらのモデルをトレーニングするために使用されるデータは古くなる可能性があり、世界の知識が更新されるたびに再トレーニングが必要になる場合があります。たとえば、2年前にトレーニングされたモデルは、現在のアメリカ合衆国大統領に関する古い情報を提供する可能性があります。 自然言語処理(RETRO、REALM)およびコンピュータビジョン(KAT)の分野では、検索増強モデルを使用してこれらの課題に取り組む研究がなされてきました。通常、これらのモデルは、単一のモダリティ(テキストのみまたは画像のみ)を処理できるバックボーンを使用して、知識コーパスから情報をエンコードおよび取得します。ただし、これらの検索増強モデルは、クエリと知識コーパスのすべての利用可能なモダリティを活用できず、モデルの出力を生成するために最も役立つ情報を見つけられない場合があります。 これらの問題に対処するために、「REVEAL:Retrieval-Augmented Visual-Language Pre-Training with Multi-Source Multimodal Knowledge Memory」(CVPR 2023に掲載予定)では、複数のソースのマルチモーダル「メモリ」を利用して知識集中型クエリに答えることを学ぶビジュアル言語モデルを紹介します。REVEALは、ニューラル表現学習を使用して、さまざまな知識ソースをキー-バリューペアから成るメモリ構造に変換し、エンコードします。キーはメモリアイテムのインデックスとして機能し、対応する値はそれらのアイテムに関する関連情報を格納します。トレーニング中、REVEALは、キーエンベッディング、値トークン、およびこのメモリから情報を取得する能力を学習して、知識集中型クエリに対処します。このアプローチにより、モデルパラメータは暗記に専念するのではなく、クエリに関する推論に焦点を当てることができます。 多様な知識ソースから複数の知識エントリを取得する能力を持つビジュアル言語モデルを拡張することで、生成を支援します。 マルチモーダル知識コーパスからのメモリ構築 私たちのアプローチは、異なるソースからの知識アイテムのキーと値のエンベッディングを事前に計算し、キー-バリューペアにエンコードして統一された知識メモリにインデックスするREALMと似ています。各知識アイテムは、より詳細に表現されたトークンエンベッディングのシーケンスである値としてエンコードされます。以前の研究とは異なり、REVEALは、WikiData知識グラフ、Wikipediaのパッセージと画像、Web画像テキストペア、ビジュアルクエスチョンアンサリングデータなど、多様なマルチモーダル知識コーパスを活用しています。各知識アイテムは、テキスト、画像、両方の組み合わせ(たとえば、Wikipediaのページ)、または知識グラフからの関係または属性(たとえば、バラク・オバマは6’2 “の背丈)の場合があります。トレーニング中、モデルパラメータが更新されるたびに、REVEALはキーと値のエンベッディングを連続的に再計算します。ステップごとにメモリを非同期に更新します。 圧縮を使用したメモリのスケーリング メモリ値をエンコードするための素朴な解決策は、各知識アイテムのトークンのすべてのシーケンスを保持することです。次に、モデルは、すべてのトークンを連結してトランスフォーマーエンコーダーデコーダーパイプラインに送信することで、入力クエリとトップkの取得されたメモリ値を融合することができます。このアプローチには2つの問題があります。1つ目は、数億の知識アイテムをメモリに保持する場合、各メモリ値が数百のトークンから構成されている場合、実用的ではないことです。2つ目は、トランスフォーマーエンコーダーが自己注意のために合計トークン数×kに対して2次の複雑度を持っていることです。そのため、Perceiverアーキテクチャを使用して知識アイテムをエンコードおよび圧縮することを提案しています。Perceiverモデルは、トランスフォーマーデコーダーを使用して、フルトークンシーケンスを任意の長さに圧縮します。これにより、kが100にもなるトップkメモリエントリを取得できます。 以下の図は、メモリのキー-バリューペアを構築する手順を示しています。各知識項目は、マルチモーダル視覚言語エンコーダを介して処理され、画像とテキストのトークンのシーケンスに変換されます。キー・ヘッドはこれらのトークンをコンパクトな埋め込みベクトルに変換します。バリュー・ヘッド(パーセプター)は、これらのトークンを少なくし、知識項目に関する適切な情報を保持します。 異なるコーパスからの知識エントリを統一されたキーとバリューの埋め込みペアにエンコードし、キーはメモリのインデックスに使用され、値にはエントリに関する情報が含まれます。…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.