Learn more about Search Results リリース - Page 2

- You may be interested

- MLがDevOpsと出会うとき:MLOpsの理解方法

- 「50以上の最新AIツール(2023年8月)」

- 「AI、機械学習、ディープラーニングの理解」

- 金融におけるデジタルトランスフォーメー...

- 「データの成熟度ピラミッド:レポートか...

- 「データエンジニアリングの役割に疲れま...

- 「不確定性原理は時間系列解析をどのよう...

- 「SIEM-SOAR インテグレーションによる次...

- Optimum+ONNX Runtime – Hugging Fa...

- 「俳優たちが、スタジオがAIレプリカを使...

- 新しい技術の詳細なコース:AWS上の生成AI...

- Google Researchにおける責任あるAI 社会...

- 「トップ50以上のジオスペーシャルPython...

- 「ESAのセンチネルAPIに深く潜入」

- 線形代数の鳥瞰図:基礎

「You.comがYouRetrieverをリリース:You.comの検索APIへの最もシンプルなインターフェース」

You.comは、You.com Search APIへの最もシンプルなインターフェースであるYouRetrieverをリリースしました。 You.com Search APIは、RAG(Retrieval Augmented Generation)アプリケーションを考慮してLLMs向けに開発されました。彼らは、APIをさまざまなデータセットでテストして、LLMのRAG-QA環境での効率を確立するための基準を確立しました。また、You.com Search APIとGoogle Search APIの違いと類似点を詳細に分析しました。彼らは、RAG-QA環境でLLMを評価するためのフレームワークを提供しました。彼らは、レトリーバーがHotpot QAでどれだけうまく機能するかを評価するために、RetrievalQA Chainを使用しました。Hotpotデータセットには、クエリ、回答、およびその文脈が含まれています。LLMが意図的に誤った言語に騙されないようにするための「distractor」モードを使用する場合、文脈は質問/回答に応じて変更されることがあります。テストの1つでは、データセットの元の文脈を検索APIが返すテキストの断片で置き換えるというものでした。情報を検索するため、APIはデータセットで提供されるスニペットのリストだけに頼るのではなく、インターネット全体を検索します。したがって、この場合、インターネットは分散させるテキストとしての役割を果たします。LLMと検索APIの効果をテストする際、彼らはシステムを「ウェブディストラクター」シナリオと呼んでいます。 可能な限り、より充実した情報の断片を返します。また、近々、返されるテキストの量を単一のサンプルから完全なページまで選択できるようになります。デフォルトのパラメータを使用すると、” great Keith”の27の結果があり、一部の文書には一部の内容が含まれています。RAG-QA環境で作業するLLMにとって、当社の検索APIは特に便利です。 彼らはHotPotQAデータセット上でテストを行いました。この情報をHuggingfaceデータセットから取得するために、彼らはdatasetsライブラリを使用しています。ここでは、分散者の代わりにフルウィキを使用していますが、先に述べたように、彼らは検索APIを利用して自分たちの文脈を生成します。 設定するための詳細な手順については、https://documentation.you.com/openai-language-model-integrationをご覧ください。 You.comは近々、より広範な検索調査を公開する予定ですので、情報をお楽しみに。アーリーアクセスパートナーになりたい方は、[email protected]に自己紹介、ユースケース、および予想される毎日のコール数に関する情報を書いてください。

『AI Time Journal(AI タイムジャーナル)が「デジタルマーケティングのトレンド2023」eBook をリリースし、AI パワードマーケティング戦略の未来について議論しています』

2019年10月19日、アメリカ、サンフランシスコ― AIタイムジャーナルは、人工知能とその応用に関する洞察情報を提供する主要な情報源として、最新の電子書籍「デジタルマーケティングトレンド2023」のリリースを喜んで発表いたしますこの包括的なガイドは、デジタルマーケティングの絶えず進化する風景に深く深入りし、人工知能が果たす突出した役割に焦点を当てています... AIタイムジャーナル、未来のAIパワードマーケティング戦略について論じる「デジタルマーケティングトレンド2023」電子書籍をリリース詳しくはこちらをご覧ください

Google DeepMindは、1M以上の軌跡データと汎用AIモデル(𝗥𝗧-X)を含むロボットデータセットであるOpen X-Embodimentをリリースし、ロボットが新しいスキルを学ぶ方法を進化させるための支援を行います

人工知能と機械学習の最新の進展は、多様で広範なデータセットからの大規模な学習能力を示し、非常に効果的なAIシステムの開発が可能であることを示しています。最良の例は、一般的なプリトレーニングモデルの作成であり、タスク固有の小規模なデータにトレーニングされた狭義の専門モデルよりも頻繁に優れた性能を示しています。オープンボキャブラリーの画像クラシファイアや大規模言語モデルは、専門化され制約のあるデータに基づいてトレーニングされたモデルと比較して、より優れたパフォーマンスを示しています。 しかし、ロボティクスのための比較可能なデータセットの収集は、コンピュータビジョンや自然言語処理(NLP)とは対照的に困難です。これらの分野では、大規模なデータセットがインターネットから簡単にアクセスできます。一方、ロボットインタラクションのためのデータセットは、ビジョンとNLPのベンチマークと比較してはるかに小さく、多様性に欠けるものです。これらのデータセットは、特定の場所、アイテム、または制限されたグループのタスクに集中することがよくあります。 ロボティクスの障壁を乗り越え、他の分野で効果を上げた大規模ビジョンや言語モデルに刺激を受けた大規模ロボット方針の開発に向け、研究チームが提案した解決策があります。チームはX具現トレーニングと呼ばれる手法を共有しています。この手法では、多くのロボットプラットフォームからのデータを利用して、汎用性のあるロボット方針を開発することが必要です。 チームはOpen X-Embodiment (OXE) リポジトリを公開しました。これには、21の機関から22の異なるロボット具現を特集したデータセットと、X具現モデルに関する研究を促進するためのオープンソースツールが含まれています。このデータセットには、50万以上のエピソードで500以上のスキルと15万以上のタスクが示されています。主な目的は、異なるロボットと環境のデータを使用して学習されたポリシーが、1つの特定の評価セットアップのデータのみを使用して学習されたポリシーよりも利益を上げることを示すことです。 研究者たちは、このデータセットで高容量モデルRT-Xをトレーニングしました。彼らの研究の主な発見は、RT-Xがポジティブな転移を示すということです。さまざまなロボットプラットフォームから学んだ知識を利用することで、この広範なデータセットのトレーニングにより、複数のロボットの能力を向上させることができます。この発見は、柔軟で効果的な一般的なロボットルールを、さまざまなロボットの文脈で実現することができる可能性を示唆しています。 チームは、幅広いロボットデータセットを使用して2つのモデルをトレーニングしました。大規模なビジョン言語モデルRT-2と効果的なトランスフォーマーベースのモデルRT-1は、位置、方向、グリッパー関連のデータを表す7次元ベクトル形式でロボットのアクションを生成するためにトレーニングされました。これらのモデルは、ロボットがオブジェクトを扱い操作するのを容易にするために作られています。さらに、これらはより幅広い範囲のロボットアプリケーションとシナリオにおけるより良い一般化を可能にするかもしれません。 まとめると、この研究は、NLPやコンピュータビジョンが成功してきたように、ロボティクスにおいてもプリトレーニングモデルを組み合わせるアイデアについて議論しています。実験結果は、ロボティクスの操作の文脈で、これらの一般的なX-ロボット戦略の可能性と効果を示しています。

You.comは、複雑な数学や科学の質問に対してより正確な回答を提供するためのコード実行機能を備えたAIエージェント、YouAgentをリリースしました

人工知能の急速に進化する風景の中で、長い言語モデル(LLM)は、インターネット上での学習と創造を変革したことは間違いありません。彼らは広範な対話的な回答を提供し、さまざまな質問に答えることができます。しかし、彼らはいくつかの制限を抱えています。彼らは最新の情報について追いつくのが難しく、しばしば誤った情報を生成し、数学、科学、論理などの複雑な主題についての推論にも課題があります。これらの欠点により、特にSTEM分野で正確かつ信頼性の高い情報を提供するためのギャップが生まれました。 これらの課題に対応するために、You.comは2022年に先駆者として登場し、LLMの機能を活用してインターネットにアクセスし、参照するためのコンシューマープロダクトを発売しました。これにより、回答が包括的で最新の情報で、引用文献も含まれるようになりました。この成功を基に、2023年の春には、You.comはマルチモーダルなチャット出力を導入し、プロット、チャート、アプリなどのインタラクティブな視覚的要素を提供することでユーザー体験を向上させ、特にリアルタイムのトピックにおいてテキストベースの応答に対する信頼性の高い代替手段を提供しました。 そして、You.comは画期的なYouAgentを紹介し、AIエージェントの概念を新たなレベルに引き上げました。従来のLLMとは異なり、YouAgentは情報を処理するだけでなく、自身の環境内でアクションを実行することもできます。これは、Pythonコードを実行するコンピューティング環境によって可能にされています。LLMはコードを記述し実行することができ、複雑なSTEM問題の解決の可能性を広げています。さらに、YouAgentのマルチステップの推論プロセスと組み合わされたこのコードインタプリタにより、YouAgentは無類の正確さで複雑なSTEMクエリに取り組むことができます。 YouAgentの使用は簡単です。ユーザーはAIチャットインターフェースで「@agent」または「/agent」とクエリを開始することができます。これにより、You.comがYouAgentとの対話を開始し、YouAgentが自身のコンピューティング環境でPythonコードを実行することができます。現在、ログインユーザーごとに1日最大5回までYouAgentのクエリを実行できます。YouProのサブスクリバーは、1日最大100回までの拡張制限を享受することができます。 STEMベンチマークでのYouAgentのパフォーマンスは非常に印象的です。強力なGPT-4と比較しても、YouAgentはさまざまなタスクで一貫して優れた正確さを示しています。特に、公式ACT数学セクションで正確さが27%も向上しています。これはC-の生徒とA+の生徒の違いに相当し、YouAgentの計算集中型評価における優れた能力を示しています。 YouAgentの特筆すべき機能の1つは、他の一般的なLLM製品に困惑を与えるSTEMの質問に対処できる能力です。コード実行環境へのアクセスとマルチステップの推論能力を備えたYouAgentは、複雑な数学的操作に関する質問に対して信頼性の高い回答を提供することができます。 成果にもかかわらず、YouAgentは自身の成長の余地を認識しています。ベンチマークでの100%の正確さを達成することは、継続的な研究と開発を必要とする持続的な追求です。さらに、チームはコードの実行を改善し、最適な問題解決のために適切に活用することを目指しています。 今後の展望として、YouAgentは能力を拡大するという野心的な計画を持っています。これには、ファイルのアップロードのサポート、プロットやグラフなどの画像出力の生成、コード実行でのウェブ検索の実行などが含まれます。さらに、より多くの数学的・科学的なライブラリの追加、数学的テキストの改善されたフォーマット、さまざまなSTEMベンチマークでの継続的なパフォーマンス向上も予定されています。 まとめると、YouAgentはAIエージェントの潜在能力を最大限に活用する大きな進歩を表しています。従来のLLMが直面する重要な制約に対処し、STEM分野で正確で信頼性の高い情報を提供します。Pythonコードを実行するためのコンピューティング環境を活用することで、YouAgentは複雑な問題解決において比類のない能力を示しています。将来に向けて、YouAgentはAIテクノロジーとのやり取り方法を革新し、STEM分野の学習と問題解決の新たな時代を切り拓くことになるでしょう。

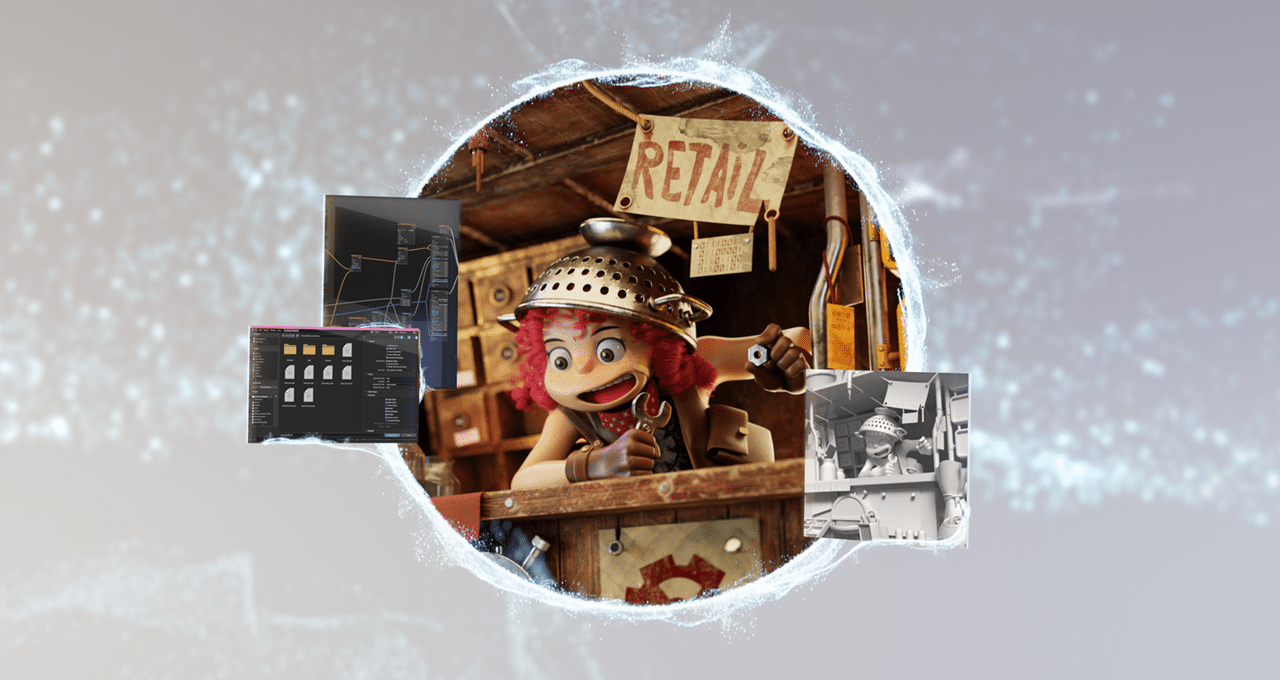

「オムニバースへ:Blender 4.0 アルファリリースが新しいOpenUSDアートの時代の幕開けを切る」

編集者の注:この記事は「Into the Omniverse」というシリーズの一部であり、アーティスト、開発者、エンタープライズが最新のOpenUSDとNVIDIA Omniverseの進歩を活用してワークフローを変革する方法に焦点を当てています。 経験豊富な3Dアーティストやデジタルクリエーション愛好家にとって、人気のある3DソフトウェアBlenderのアルファ版がクリエイティブな旅を高めています。 アップデートの機能には、複雑なシェーダーネットワークの作成や強化されたアセットエクスポート機能が含まれており、BlenderとUniversal Scene Descriptionフレームワーク(OpenUSD)を使用する開発コミュニティは、3Dの風景を進化させるのに役立っています。 NVIDIAのエンジニアは、BlenderのOpenUSDの機能を向上させるために重要な役割を果たしており、これによりNVIDIA Omniverseとの使用向上ももたらされています。NVIDIA Omniverseは、OpenUSDベースのツールやアプリケーションを接続して構築するための開発プラットフォームです。 Blenderワークフローのためのユニバーサルアップグレード Blender 4.0アルファでは、さまざまなユースケースに最適化されたOpenUSDワークフローにアクセスできるようになります。 たとえば、ミュンヘンのBMWグループテクノロジーオフィスのデザインインターンであるエミリー・ボーマーは、Omniverse、Blender、Adobe Substance 3D Painterの組み合わせのパワーを活用して、コンピュータビジョンAIモデルのトレーニングに使用するリアルなOpenUSDベースのアセットを作成しています。 ボーマーは、BMWグループが公開したAIデータセットであるSORDI.aiで使用するアセットを作成するために、チームと協力しました。このデータセットには80万枚以上の写真写実的な画像が含まれています。 工業用の木箱が仮想的に「経年変化」しているクリップ。 USDはボーマーのワークフローを最適化しました。「BlenderとSubstance 3D Painterの両方でUSDサポートが見られるのは素晴らしいことです」と彼女は言います。「USDを使用して3Dアセットを作成する際、それらが配置されるシーンで予想どおりの見た目と挙動をすることを確信できます。なぜなら、物理的な特性を追加できるからです。」 オーストラリアのアニメーター、マルコ・マトセヴィッチも、Blender、Omniverse、USDの組み合わせたパワーを3Dのワークフローで活用しています。…

報告書:OpenAIがGPT-VisionというマルチモーダルLLMをリリースするための取り組みを加速中

「The Information」の報告によると、ライバルのGoogleに先駆けて高度なマルチモーダルLLMを発表するため、OpenAIは報道によるとGPT-Vision(コードネーム:Gobi)のリリースを加速させているようですこれは、GoogleのマルチモーダルLLMであるGeminiが先週、一部の企業にリリースされた1週間後のことです...

Stability AIが初の日本語ビジョン言語モデルをリリース

単一かつ包括的なモデルを作成し、さまざまなユーザー定義のタスクを処理できるようにすることは、人工知能(AI)研究の分野で長い間関心を持たれてきました。これは特に「指示チューニング」という自然言語処理(NLP)において顕著であり、広範な自然言語の指示を通じて、大規模な言語モデル(LLM)を改善することにより、モデルが任意の指示を適切に実行できるようになる方法です。 その一例が「ビジョン・ランゲージ・モデル」の使用です。「ビジョン・ランゲージ・モデル」(VLM)は、テキストと画像を入力として理解することに長けた人工知能の一種です。これらは、画像のキャプション作成、ビジュアルな質問応答、ビジュアルな風景のテキスト化や言語間およびビジュアル表現の翻訳など、さまざまなビジュアルとテキストのデータの連携を必要とするタスクを実行するために使用されます。 最近、Stability AIの研究者が初の日本語ビジョン・ランゲージ・モデル、Japanese InstructBLIP Alphaのリリースを発表しました。ビジョン・ランゲージ・モデルは多く存在していますが、これが初めて日本語のテキスト記述を生成するものです。この新しいアルゴリズムは、写真に対する日本語のテキスト記述や画像に関連するクエリに対するテキスト応答を生成することを目的としています。 研究者は、モデルが特定の日本のランドマークを認識できることを強調しています。これにより、ロボット工学から観光まで、必要な地域特有の意識が提供されます。さらに、モデルはテキストと画像を処理できるため、視覚的な入力に基づくより複雑なクエリを処理できます。 研究者は、このモデルを開発するために徹底的な研究を行い、多様な指示データを使用してモデルをトレーニングしました。そのためにモデルをイメージエンコーダ、LLM、クエリトランスフォーマ(Q-Former)でトレーニングし、Q-Formerを指示チューニングのために微調整し、イメージエンコーダとLLMは凍結しました。 さらに、研究者は公開されている26のデータセットを収集し、幅広い機能と任務をカバーするように指示チューニング形式に変換しました。モデルは13のデータセットでトレーニングされ、すべての13の保持データセットで最先端のゼロショットパフォーマンスを示しました。研究者はまた、個々の下流タスクで微調整された場合も最先端のパフォーマンスを示すことを強調しました。また、指示に特化した情報要素を抽出する指示意識のあるクエリトランスフォーマも設計しました。 彼らは、「指示に応じて柔軟かつ有益な特徴を抽出する」点を示唆する「指示意識のあるビジュアル特徴抽出」という考え方を提示しました。Q-Formerが凍結された画像エンコーダから指示意識のあるビジュアル特徴を抽出するために、テキストの指示は凍結されたLLMとQ-Formerの両方に送られます。また、データセット間で学習の進行を同期させるためにバランスの取れたサンプリング技術も行いました。 研究者は、モデルの有用性と効果にもかかわらず、潜在的なバイアスや制約について注意を喚起しています。人間の判断による正確性と適切性に基づいて、応答を判断する必要があると警告しています。日本語のビジョン・ランゲージ・タスクにおけるモデルのパフォーマンスは、継続的な研究と開発により改善される必要があります。

「カーンアカデミーがジェネラティブAI学習チューターのカーンミゴをリリース」

2022年11月にChatGPTがリリースされて以来、AIは多くの教育者にとって懸念の対象となっていますしかし、Khan Academyの考え方によれば、AIは生徒の仕事をするのではなく、スーパーチャージされたチューターや教育アシスタントになるでしょうここでKhanmigoが登場します今年の秋に...

メタAIは、122の言語に対応した初の並列読解評価ベンチマーク「BELEBELE」をリリースしました

多言語モデルのテキスト理解能力を評価する上での重要な課題は、高品質で同時的な評価基準の不足です。FLORES-200などの高カバレッジの自然言語処理データセットがありますが、それらは主に機械翻訳に使用されています。100以上の言語が理解や生成テキストサービスを使用していますが、ラベル付きデータの不足は、ほとんどの言語で効果的なシステムを構築する上で重要な障壁となっています。 低リソース言語のためのNLPシステムの効率的かつ成功した開発を可能にするためには、LLM以外の重要な科学研究が必要です。多くのモデリングアプローチが言語に依存しないと主張していますが、それらの適用範囲はしばしば一部の言語でのみテストされます。 Meta AI、Abridge AI、およびReka AIによる新たな研究では、122の異なる言語バリエーションを横断して自然言語理解システムを評価するための重要なベンチマークであるBELEBELEが公開されました。データセットの各488パラグラフは、データセット全体の900の質問に対応しています。質問は言語理解能力の異なるモデルを区別し、注意深く作成されています。これらの質問は高い知識や推論を必要とはしませんが、一般化可能なNLUモデルを奨励し、バイアスのあるモデルを故意にペナルティを与えるように設計されています。英語で行われる質問は人間によってほぼ完璧な精度で回答することができます。さまざまなモデルの出力は、これがよく知られたLLMベンチマークであるMMLUと同様の識別的なNLUの課題であることを示しています。 BELEBELEシステムは、その種としては初めてであり、すべての言語で並列になっています。これにより、言語間でモデルの性能を直接比較することができます。データセットには29の文字システムと27の言語ファミリが含まれており、さまざまなリソースの利用可能性と言語の多様性を表しています。ヒンディー語、ウルドゥー語、ベンガル語、ネパール語、シンハラ語のローマ字化バージョンのための最初の自然言語処理(NLP)ベンチマークの一つは、これらの7つの言語を2つの異なるスクリプトで書かれたものに基づいています。 データセットの並列性により、さまざまな言語間シナリオでクロスリンガルなテキスト表現を評価することができ、単言語および多言語モデルの評価に使用することができます。タスクは、比較可能なQAデータセットからトレーニングセットを組み合わせてフルファインチューニングによって評価することができます。研究者たちは、多言語間および英語と他の言語間の翻訳のために多数のマスク言語モデル(MLM)を使用しています。ファイブショットのコンテキスト学習とゼロショット(言語内および翻訳テスト)評価を使用して、LLMのさまざまなモデルを比較しています。 研究結果は、英語中心のLLMが30以上の言語に広がり、VoAGIおよび低リソース言語で訓練されたモデルが大きな語彙サイズとバランスの取れた事前トレーニングデータの恩恵を最も受けることを示しています。 チームは、彼らの研究が既存のモデルアーキテクチャとトレーニング方法を改善するのに役立つことを願っています。

マイクロソフトリサーチがAIコンパイラの「ヘビーメタルカルテット」である「Rammer」「Roller」「Welder」「Grinder」をリリースしました

人工知能(AI)モデルとハードウェアアクセラレータの進化により、コンパイラには独自の課題が生じています。これらの課題は、AIモデルの絶えず変化するアーキテクチャから生じており、RNNやCNNから最近のTransformerなどのモデルへの移行、さらにはGPUやNPUなどのハードウェアアクセラレータの急速な進歩といったものです。その結果、効率的なコンパイルは、これらの新しいAIモデルが現代のハードウェア上で効果的に実行されることを保証するために重要となっています。 従来のAIコンパイラは、通常、深層ニューラルネットワーク(DNN)の実行を最適化する際に制約がありました。現在のコンパイラは、DNNの計算を不透明なライブラリ関数を持つデータフローグラフとして扱い、2段階のスケジューリングによる大幅なオーバーヘッドとハードウェアリソースの未使用を引き起こしています。さらに、AIモデルのデータのパーティショニングとメモリアクセスの最適化は、時間がかかる場合があります。 最後に、ほとんどのAIコンパイラは、主にデータフローの実行を最適化することに焦点を当てており、AIモデル内の制御フローコードの効率的な実行に注意を払っています。この制約は、複雑な制御ロジックを持つモデルに影響を与え、ハードウェアアクセラレーションを十分に活用する能力を妨げます。 Microsoft Researchの研究者グループは、AIコンパイルの特定の側面に対応するために設計された画期的なAIコンパイラのセット「ヘビーメタル・カルテット」を紹介しました。このカルテットには、Rammer、Roller、Welder、Grinderの4つのコンパイラが含まれています。 Rammer: Rammerは、AIコンパイルのスケジューリングスペースを二次元平面として再設計し、大規模な並列アクセラレータユニット上でのDNNワークロードの実行を最適化します。Rammerは、この平面上の計算タスクを「ブリック」として配置することで、実行時のスケジューリングオーバーヘッドを最小限に抑え、ハードウェアの利用効率を大幅に向上させます。 Roller: Rollerは、データブロックのパーティショニング戦略を効率的に定式化することで、コンパイルの効率を最適化します。既存のコンパイラと比較して、高度に最適化されたカーネルを数秒で生成し、コンパイル時間を3桁改善します。 Welder: Welderは、DNNモデルのメモリアクセス効率を包括的に最適化し、メモリ帯域幅と計算コアの利用率のギャップを縮小します。さまざまなDNNモデルとコンパイラで顕著なパフォーマンス向上を実現します。 Grinder: Grinderは、AIモデル内の制御フローの実行を最適化し、データフローに制御フローを効率的に統合することで、ハードウェアアクセラレータ上での効率的な実行を実現します。制御フロー集中型のDNNモデルに対して8.2倍の高速化を実現し、制御フローに対するDNNコンパイラの中で最速の性能を発揮します。 カルテットのパフォーマンスは、複数のデバイスとAIモデルで評価されました。Rammerは最先端のコンパイラを凌駕し、GPUで最大20.1倍の高速化を実現しました。Rollerは、競争力のあるパフォーマンスを維持しながら、コンパイル時間を3桁改善しました。Welderは、より高速な計算コアを持つハードウェアで、既存のフレームワークやコンパイラを最大21.4倍凌駕しました。Grinderは、制御フロー集中型のDNNモデルに対して8.2倍の高速化を実現し、制御フローに対するDNNコンパイラの中で最速の性能を発揮しました。 結論として、AIモデルとハードウェアが進化し続ける中で、効率的な実行を保証するためのコンパイラの役割はますます重要になっています。このカルテットの貢献は、画像認識からNLPまでさまざまなアプリケーションでより効果的なAI展開の道を開き、結果としてデジタル世界におけるAI技術の能力を向上させるものです。

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.