Learn more about Search Results T5 - Page 29

- You may be interested

- 「異常検知への推測を排除する:ヒストグ...

- 「UTオースティンの研究者が、LIBEROを導...

- モジラのコモンボイスでの音声言語認識 — ...

- 「金融機関は責任あるAIを活用して金融犯...

- 物理情報ニューラルネットワークとシンボ...

- キルギスタンからキングスクロスまで:コ...

- 『React開発の向上:ChatGPTの力を解き放...

- 「Midjourneyを使ってYouTubeのサムネイル...

- ‘製品およびエンジニアリングリーダーのた...

- 「The Reformer – 言語モデリングの...

- MLを学ぶ勇気:可能性、MLE、およびMAPの解読

- 武士と鬼の世界に入りましょう:GFN Thurs...

- カカオブレインからの新しいViTとALIGNモデル

- データアナリストのリアルライフでの確率...

- 「VoAGIニュース、11月15日 10の必須パン...

「Human Sketchesが物体検出にどのような役割を果たすことができるのか?スケッチベースの画像検索に関する洞察」

先史時代から、人類はアイデアを伝えたり記録したりするためにスケッチを使用してきました。言語の存在にもかかわらず、スケッチの表現力は比類のないものです。アイデアを紙とペン(またはZoom Whiteboard)でスケッチする必要性を感じる瞬間を考えてみてください。 過去10年間、スケッチに関する研究は著しい成長を遂げています。従来の分類や合成などの伝統的なタスクだけでなく、ビジュアル抽象モデリング、スタイル変換、連続ストロークの適合など、よりスケッチに特化したトピックにもさまざまな研究が行われています。また、スケッチを写真分類器に変換するなど、楽しい実用的な応用もあります。 しかし、スケッチの表現力の探求は主にスケッチベースの画像検索(SBIR)、特に細粒度のバリアント(FGSBIR)に焦点を当ててきました。たとえば、コレクション内で特定の犬の写真を探している場合、頭の中でその犬の絵をスケッチすることで、それをより速く見つけることができます。 驚くべき進歩がなされ、最近のシステムは商業利用に適した成熟度を達成しました。 この記事で報告された研究論文では、著者たちは人間のスケッチの潜在能力を活用して、基本的なビジョンタスク、特に物体検出を向上させることを目指しています。提案手法の概要は以下の図に示されています。 https://arxiv.org/abs/2303.15149 目標は、スケッチの内容に基づいてオブジェクトを検出するスケッチ対応の物体検出フレームワークを開発し、ユーザーが視覚的に自己表現できるようにすることです。たとえば、人が「草を食べるシマウマ」といったシーンをスケッチすると、提案されたフレームワークはシマウマの中からその特定のシマウマをインスタンスに基づいた検出を利用して検出することができます。さらに、ユーザーは物体の部分に特定をすることができるようになり、部分に基づいた検出が可能になります。したがって、「シマウマ」の「頭」にだけ焦点を当てたい場合、その望ましい結果を得るためにシマウマの頭をスケッチすることができます。 スクラッチからスケッチ対応の物体検出モデルを開発する代わりに、研究者たちはCLIPなどの基盤モデルとすでに利用可能なSBIRモデルのシームレスな統合を実証し、問題をエレガントに解決しています。このアプローチは、モデルの汎化性を活用するとともに、スケッチと写真の間のギャップを埋めるためにSBIRを利用します。 これを実現するために、著者たちはCLIPを適応させ、スケッチと写真のエンコーダ(共有SBIRモデル内のブランチ)を作成しました。各モダリティに対して独立したプロンプトベクトルを個別にトレーニングしています。トレーニング中、これらのプロンプトベクトルは、CLIPのViTバックボーンの最初のトランスフォーマーレイヤーの入力シーケンスに追加されますが、残りのパラメータは凍結されます。この統合により、学習されたスケッチと写真の分布にモデルの汎化性を導入します。 クロスカテゴリのFG-SBIRのリトリーバルタスクに特化したいくつかの結果が以下に報告されています。 https://arxiv.org/abs/2303.15149 これはスケッチベースの画像検索に関する新しいAI技術の概要でした。この研究に興味があり、さらに詳細を知りたい場合は、以下のリンクをクリックして詳細情報をご覧ください。

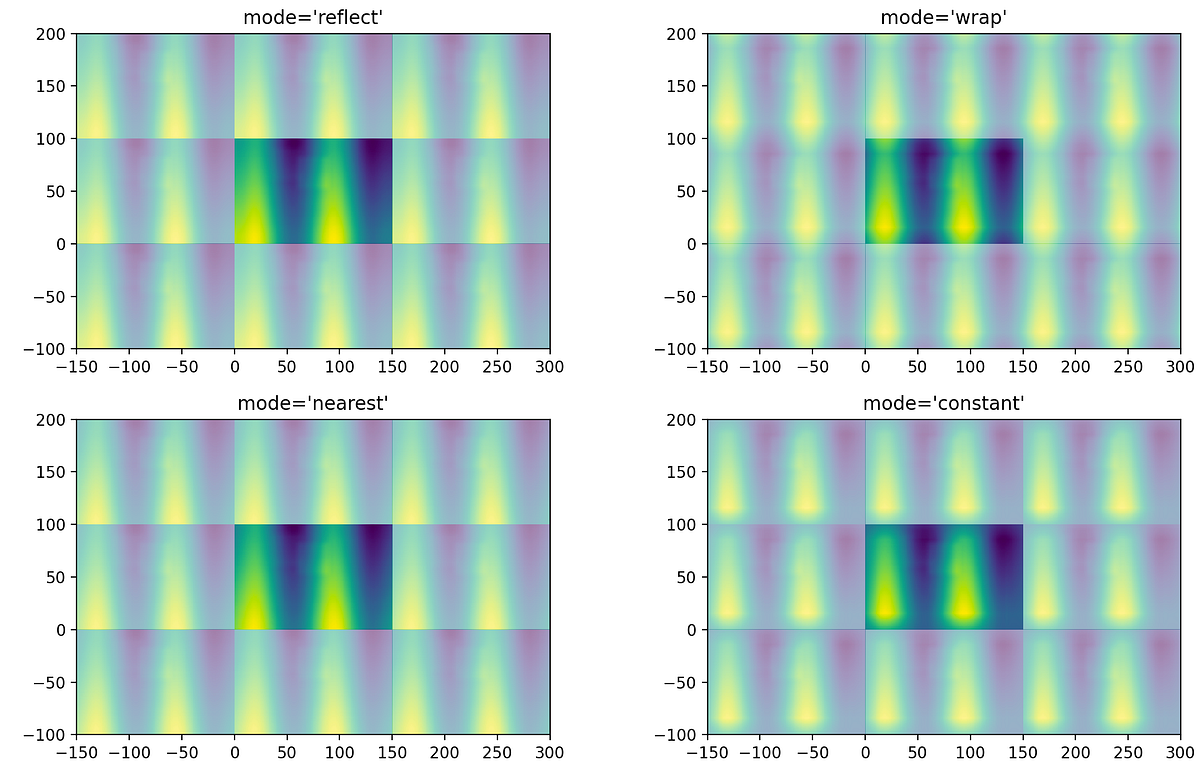

時間シリーズのフーリエ変換:画像畳み込みとSciPyについて

最初の投稿では、フーリエ変換が信号の畳み込みに非常に効率的に使用できる方法について説明しました私は、NumPyを使用したフーリエ変換を用いた畳み込みが桁違いに高速であることを示しました...

「アノテーターのように考える:データセットのラベリング指示の生成」

最近のAIモデルの進歩には、私たちはみな驚かされています。ジェネレーティブモデルがファンキーな画像生成アルゴリズムから、AIによって生成されたコンテンツとリアルなものを区別することが難しくなるまで、革命的な進化を遂げたことを目の当たりにしました。 これらの進歩は、2つの主要な要素によって可能になりました。高度なニューラルネットワーク構造と、おそらくより重要なことは、大規模なデータセットの利用可能性です。 例えば、安定した拡散を取り上げましょう。拡散モデルは以前から存在していましたが、それまでにそのような結果を見たことはありませんでした。安定した拡散が非常に強力になった要因は、トレーニングに使用された非常に大規模なデータセットです。ここで言う大規模とは、本当に大規模なものです。50億以上のデータサンプルについて話しています。 このようなデータセットの準備は明らかに非常に要求の厳しい作業です。代表的なデータポイントの慎重な収集と監督付きラベリングが必要です。安定した拡散では、これをある程度自動化することができました。しかし、常に人間の要素が絡んできます。ラベリングプロセスは、特にコンピュータビジョンの場合、監督学習において重要な役割を果たし、プロセス全体を成功させるか失敗させるかを左右することができます。 コンピュータビジョンの分野では、大規模なデータセットは多くのタスクと進歩の基盤となります。ただし、これらのデータセットの評価と利用は、クラスの所属を定義し、注釈者に指示を与えるためのラベリング指示(LIs)の品質と入手可能性に依存することがしばしばあります。残念ながら、公開されているラベリング指示はほとんどリリースされておらず、コンピュータビジョンの研究における透明性と再現性の欠如につながっています。 この透明性の欠如は重要な意味を持ちます。この見落としには重要な意味があり、モデルの評価における課題、注釈のバイアスへの対応、指示ポリシーによって課せられる制約の理解など、重要な影響を及ぼします。 このギャップを埋めるために行われた新しい研究が手に入りました。それは「ラベリング指示生成(LIG)タスク」と呼ばれています。 LIGは、公開されている指示のないデータセットに対して情報量の多いアクセス可能なラベリング指示(LIs)を生成することを目指しています。大規模なビジョンおよび言語モデルを活用し、プロキシデータセットキュレータ(PDC)フレームワークを提案することで、この研究は高品質なラベリング指示を生成し、コンピュータビジョンコミュニティのベンチマークデータセットの透明性と有用性を向上させることを目指しています。 LIGの概要。出典: https://arxiv.org/pdf/2306.14035.pdf LIGは、クラスの所属を定義するだけでなく、クラスの境界、同義語、属性、特殊なケースについての詳細な説明も提供する一連の指示を生成することを目指しています。これらの指示は、テキストの説明と視覚的な例の両方で構成され、包括的で情報量の多いデータセットのラベリング指示セットを提供します。 LIsを生成するという課題に取り組むために、提案されたフレームワークはCLIP、ALIGN、Florenceなどの大規模なビジョンおよび言語モデルを活用しています。これらのモデルは、さまざまなタスクで堅牢なパフォーマンスを実現する強力なテキストおよび画像表現を提供します。プロキシデータセットキュレータ(PDC)アルゴリズムフレームワークは、LIGのための計算効率の高い解決策として導入されています。事前学習済みのVLMを活用してデータセットを迅速にトラバースし、各クラスを代表する最良のテキスト-画像ペアを取得することができます。テキストと画像の表現をマルチモーダル融合を介して単一のクエリに縮約することにより、PDCフレームワークは広範で情報量の多いラベリング指示を生成する能力を示しており、広範な手動キュレーションの必要性はありません。 提案されたフレームワークは有望な結果を示していますが、いくつかの制約もあります。例えば、現在の焦点はテキストと画像のペアの生成にあり、より表現豊かなマルチモーダル指示については提案されていません。生成されたテキスト指示は、人間によって生成された指示と比べてよりニュアンスが少ない場合がありますが、言語およびビジョンモデルの進歩によってこの制約は解消されると予想されます。さらに、フレームワークには現在、ネガティブな例は含まれていませんが、将来のバージョンではより包括的な指示セットを提供するためにそれらが組み込まれる可能性があります。

「Hugging Faceを使用してLLMsを使ったテキスト要約機を構築する」

はじめに 最近、LLMs(Large Language Models)を使用したテキスト要約は多くの関心を集めています。これらのモデルは、GPT-3やT5などの事前訓練モデルであり、人間のようなテキストやテキスト分類、要約、翻訳などのタスクを生成することができます。Hugging Faceは、LLMsを使用するための人気のあるライブラリの一つです。 この記事では、特にHugging Faceに焦点を当てて、LLMの能力について検討し、難解なNLPの問題を解決するための適用方法について説明します。また、Hugging FaceとLLMsを使用して、Streamlit用のテキスト要約アプリケーションを構築する方法についても説明します。まずは、この記事の学習目標について見てみましょう。 学習目標 Hugging Faceをプラットフォームとして使用したLLMsとTransformersの機能と機能を探索する。 Hugging Faceが提供する事前訓練モデルとパイプラインを活用して、チャットボットなどのさまざまなNLPタスクを実行する方法を学ぶ。 Hugging FaceとLLMsを使用したテキスト要約の実践的な理解を開発する。 テキスト要約のための対話型Streamlitアプリケーションを作成する。 この記事は、データサイエンスのブログマラソンの一環として公開されました。 大規模言語モデル(LLMs)の理解 LLMモデルは大量のテキストデータで訓練されます。これらのモデルは、前の文脈に基づいて次の単語を予測することにより、複雑な言語パターンを捉え、一貫したテキストを生成することができます。 LLMsは大量のパラメータを含むデータセットで訓練されます。訓練データの膨大な量により、LLMsは言語の微妙なニュアンスを学び、印象的な言語生成能力を提供することができます。 LLMsは機械翻訳、テキスト生成、質問応答、感情分析などのさまざまなタスクでの突破口を可能にし、NLPの分野に大きな影響を与えました。 これらのモデルはベンチマークで優れたパフォーマンスを発揮し、多くのNLPタスクにおいて頼りになるツールとなっています。 Hugging Face…

「機械学習モデルのバリデーション方法」

大規模な言語モデルは既にデータサイエンス業界を大きく変革しています最大の利点の一つは、ほとんどのアプリケーションにおいてそのまま使用できることです

新しいAI研究が「方向性刺激プロンプティング(DSP)」を導入:望ましい要約を生成するためにLLMをより適切に導くための新しいプロンプティングフレームワーク

自然言語処理(NLP)は、最近の大規模言語モデル(LLM)の出現により、従来の比較的小さな言語モデル(LM)であるGPT-2やT5 Raffel et al.などを上回る性能を示すようになり、さまざまなNLPタスクでパラダイムシフトを経験しています。プロンプトは、LLMを使用して自然言語の指示を使用してさまざまなタスクを実行するための事実上の方法であり、パラメータの更新なしにLLMを誘導して望ましい出力を生成させるための方法です。これに対して、従来のファインチューニングパラダイムでは、LMのパラメータを各ダウンストリームタスクごとに更新することができます。 このプロンプトスキーマにより、LLMはゼロショットまたはフューショットの環境でさまざまなタスクで非常によいパフォーマンスを発揮することができますが、特定のダウンストリームタスクにおけるパフォーマンスはまだ改善が必要であり、特にトレーニングデータが利用可能な場合には追加の改良が必要です。それにもかかわらず、ほとんどのLLMはブラックボックスの推論APIのみを提供し、ファインチューニングにはコストがかかるため、ほとんどのユーザーや研究者はこれらのLLMを直接最適化することはできません。したがって、解決する必要のある難しいトピックは、トレーニングインスタンスが限られている場合にどのように効果的にLLMのパフォーマンスを向上させるか、です。カリフォルニア大学サンタバーバラ校とマイクロソフトの新しい研究では、指向性刺激プロンプティング(DSP)アーキテクチャを提案しています。このアーキテクチャは、小さなチューナブルLM(RL)を使用して、凍結されたブラックボックスLLMをダウンストリームタスクで強化するものです。 ソース:https://arxiv.org/pdf/2302.11520.pdf | 図1:通常のプロンプトアプローチと提案された指向性刺激プロンプティングを使用した要約タスクに使用される時間の比較。この例では、キーワードが刺激として使用され、それからLLMによって所望の要約がよりスコアリングスコアや他のメトリック(青色でハイライト表示)で提供されるように指示します。 具体的には、各入力テキストに対して、小さなLM(ポリシーLMと呼ばれる)が指示された刺激として一連の離散トークンを提供し、ジョブに対する一般的なキューではなく、入力サンプルに関する特定の情報や指示を提供するように学習します。目的の目標、例えばパフォーマンスメジャースコアの向上などに向けて、作成された刺激は元の入力とブレンドされ、LLMに供給されます。彼らは最初に、収集されたわずかなトレーニングサンプルを使用して、事前トレーニングされたLMを使用した教師ありファインチューニング(SFT)を行います。トレーニングは、ポリシーLMによって生成される刺激に基づいてLLM生成のダウンストリームパフォーマンスメジャーのスコアを最大化することを目指しています。より良い刺激を探索するための追加の最適化の後、洗練されたLMはRLでポリシーLMを初期化します。 図1は要約のジョブのサンプルを示しています。キーワードに基づいて必要な要約をLLMに生成させるために、キーワードは刺激(ヒント)として機能します。ポリシーLMは、ROUGEなどの評価メトリックスコアをインセンティブとして使用して最適化することができ、LLMがより良い要約を生成するためにポリシーLMがキーワードを提供するようにします。LLMは優れた生成スキルを持っていますが、しばしば望ましくない振る舞いを示すため、特定のダウンストリームタスクにおいて意図した生成特性と方向に対する詳細なガイダンスが必要です。これが彼らの提案手法の基礎です。小さなポリシーLMは、サンプルごとの細かいガイダンスを意図した目標に向けて提供するための一連のトークンを生成することができますが、人間の話し言葉に似たテキストを生成することはできません。 従来の研究がクエリをより明確に説明しようとするプロンプトエンジニアリング/最適化を介して最適なプロンプトを見つけるのに対して、RLは最適化されたオブジェクト(例:刺激を生成する小さなポリシーLM)とLLM生成によって定義される最適化目標とのギャップを埋める自然な解決策を提供します。彼らのアプローチは、各「質問」に対して「ヒント」または「手がかり」を提供しようとするものであり、推論タスクを解決する際に中間の推論ステップを生成することを促すチェーンオブソートプロンプティングとは異なります。彼らのアプローチは、1つの正しい「答え」だけではない生成タスクを対象とし、小さなチューナブルモデルを使用してLLMを制御およびガイドし、要約および対話応答生成タスクでフレームワークを評価しています。 たとえば、刺激を作り出す小さなポリシーLMは最適化されたオブジェクトですが、LLMの生成は最適化の目標を決定します。RLはこのギャップを埋めるための簡単な方法を提供します。以前の研究とは異なり、この研究ではプロンプトエンジニアリングや最適化を使用して「質問」を明確にしようと試みます。彼らの戦略は、各「質問」に対して「ヒント」や「手がかり」を提供することを目指しています。また、論理を必要とするタスクを完了する際に、Mindが独自の推論の中間ステップを生成することを奨励するチェーンオブソートプロンプティングとは異なります。彼らの手法は、複数の有効な「応答」を生成するジョブを対象とし、シンプルな調整可能なモデルを使用してLLMを制御・誘導します。ディスカッションの応答や要約の開発を必要とする課題に対して、彼らのフレームワークを評価します。テストでは、750M Flan-T5-largeをポリシーLMとし、175B CodexをLLMとして使用します。テスト結果によると、Codexは調整されたT5が生成した指示に依存すると、下流のタスクでのパフォーマンスが著しく向上します。要約に含まれるべきキーワードは、要約ジョブへの誘導刺激として使用されます。CNN/Daily Mailデータセットから2,000のサンプルを使用してトレーニングされたT5を使用することで、すでにCodexのパフォーマンスは7.2%向上しています。 MultiWOZデータセットからの500の対話に対して、意図された応答の背後の意味を指定する会話アクトを開発するために、彼らはポリシーLMをトレーニングします。ポリシーLMによって生成された対話アクションにより、Codexのパフォーマンスは合計スコアで52.5%向上しました。これにより、以前の完全なトレーニングデータ(8438の対話)でトレーニングされたシステムと同等またはそれ以上の性能を発揮します。

「GPT-4の能力と限界を探索する」

「GPT-4の公開:データサイエンスへの影響を解読し、その強みと限界を探る」

「時系列分析のための欠落した日付の修正方法」

「BigQueryでTVFを使用して、時系列分析のための日付範囲を簡単に生成する方法を学びましょう」

「大規模な言語モデルを使用した生成型AI:実践トレーニング」

この2時間のトレーニングでは、LLM(Language Model)の概要、その機能、およびそれらを開発・展開する方法について説明しますHugging FaceとPyTorch Lightningを使用した実践的なコードデモを行います

「LLMを使用して、会話型のFAQ機能を搭載したAmazon Lexを強化する」

Amazon Lexは、Amazon Connectなどのアプリケーションのために、会話ボット(「チャットボット」)、バーチャルエージェント、およびインタラクティブ音声応答(IVR)システムを迅速かつ簡単に構築できるサービスです人工知能(AI)と機械学習(ML)は、Amazonの20年以上にわたる焦点であり、顧客が利用する多くの機能の一部です

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.