Learn more about Search Results Tome - Page 28

- You may be interested

- アップルとEquall AIによる新しいAI研究が...

- Google AIによるコンテキストの力を解き放...

- 「HITL-TAMPを紹介します:自動計画と人間...

- 「Pythonデータ構造の基本を5つのステップ...

- 「2023年のトップコンピュータビジョンツ...

- ディープラーニングのためのPythonとC++に...

- 「🧨 JAXを使用したCloud TPU v5eでの高速...

- 「データサイエンスは難しいのか?現実を...

- 「大規模言語モデルにおける早期割れに打...

- GPT-エンジニア:あなたの新しいAIコーデ...

- 組織におけるデータ文化の重要性は何ですか?

- 「Pythonクライアントを使用してMyScaleを...

- 「DreamIdentityに会ってください:テキス...

- 「LangChainとChatGPTを使用してPythonコ...

- 「ODSC West Bootcampプログラムから期待...

パラメータ効率の高いファインチューニングを使用する 🤗 PEFT

動機 トランスフォーマーアーキテクチャに基づく大規模言語モデル(LLM)であるGPT、T5、BERTなどは、さまざまな自然言語処理(NLP)タスクで最先端の結果を達成しています。これらのモデルは、コンピュータビジョン(CV)(VIT、Stable Diffusion、LayoutLM)やオーディオ(Whisper、XLS-R)などの他の領域にも進出しています。従来のパラダイムは、一般的なWebスケールのデータでの大規模な事前学習に続いて、ダウンストリームのタスクに対する微調整です。ダウンストリームのデータセットでこれらの事前学習済みLLMを微調整することで、事前学習済みLLMをそのまま使用する場合(ゼロショット推論など)と比較して、大幅な性能向上が得られます。 しかし、モデルが大きくなるにつれて、完全な微調整は一般的なハードウェアで訓練することが不可能になります。また、各ダウンストリームタスクごとに微調整済みモデルを独立して保存および展開することは非常に高コストです。なぜなら、微調整済みモデルのサイズは元の事前学習済みモデルと同じサイズだからです。パラメータ効率の良い微調整(PEFT)アプローチは、これらの問題に対処するために開発されました! PEFTアプローチは、事前学習済みLLMのほとんどのパラメータを凍結しながら、わずかな(追加の)モデルパラメータのみを微調整するため、計算およびストレージコストを大幅に削減します。これにより、LLMの完全な微調整中に観察される「壊滅的な忘却」という問題も克服されます。PEFTアプローチは、低データレジメでの微調整よりも優れた性能を示し、ドメイン外のシナリオにもより適応します。これは、画像分類や安定拡散ドリームブースなどのさまざまなモダリティに適用することができます。 また、PEFTアプローチは移植性にも役立ちます。ユーザーはPEFTメソッドを使用してモデルを微調整し、完全な微調整の大きなチェックポイントと比較して数MBの小さなチェックポイントを取得することができます。たとえば、「bigscience/mt0-xxl」は40GBのストレージを使用し、完全な微調整では各ダウンストリームデータセットに40GBのチェックポイントが生成されますが、PEFTメソッドを使用すると、各ダウンストリームデータセットにはわずか数MBのチェックポイントでありながら、完全な微調整と同等の性能が得られます。PEFTアプローチからの小さなトレーニング済み重みは、事前学習済みLLMの上に追加されます。そのため、モデル全体を置き換えることなく、小さな重みを追加することで同じLLMを複数のタスクに使用することができます。 つまり、PEFTアプローチは、わずかなトレーニング可能なパラメータの数だけで完全な微調整と同等のパフォーマンスを実現できるようにします。 本日は、🤗 PEFTライブラリをご紹介いたします。このライブラリは、最新のパラメータ効率の良い微調整技術を🤗 Transformersと🤗 Accelerateにシームレスに統合しています。これにより、Transformersの最も人気のあるモデルを使用し、Accelerateのシンプルさとスケーラビリティを活用することができます。以下は現在サポートされているPEFTメソッドですが、今後も追加される予定です: LoRA:LORA:大規模言語モデルの低ランク適応 Prefix Tuning:P-Tuning v2:プロンプトチューニングは、スケールとタスクにわたって完全な微調整と同等の性能を発揮することができます Prompt Tuning:パラメータ効率の良いプロンプトチューニングの力 P-Tuning:GPTも理解しています ユースケース ここでは多くの興味深いユースケースを探求しています。以下はいくつかの興味深い例です: Google Colabで、Nvidia GeForce RTX…

Intel CPUのNNCFと🤗 Optimumを使用した安定したディフュージョンの最適化

潜在的な拡散モデルは、テキストから画像の生成問題を解決する際にゲームチェンジャーとなります。 安定した拡散は、コミュニティや産業界で広く採用されている最も有名な例の一つです。 安定した拡散モデルのアイデアはシンプルで魅力的です:ノイズベクトルから画像を複数の小さなステップで生成し、ノイズを潜在的な画像表現に洗練させます。 ただし、このようなアプローチは、全体的な推論時間を増加させ、クライアントマシンで展開された場合にユーザーエクスペリエンスの低下を引き起こします。 通常のように、強力なGPUがここで役立つことに注意することができますが、これに伴うコストも著しく増加します。 参考までに、H1’23では、8つのvCPUと64GBのRAMを備えた強力なCPU r6i.2xlargeインスタンスの価格は1時間あたり$0.504であり、同様のNVIDIA T4を搭載したg4dn.2xlargeインスタンスの価格は1時間あたり$0.75で、これは1.5倍以上です.. これにより、画像生成サービスは所有者とユーザーにとって非常に高価になります。 クライアントアプリケーションでは、GPUがまったくない場合もあります! これにより、安定した拡散パイプラインの展開は困難な問題となります。 過去5年間、OpenVINO Toolkitは高性能推論のための多くの機能をカプセル化しました。 最初はコンピュータビジョンモデルに設計されたものですが、現在でも最先端のモデルを含む多くのコンテンポラリーモデルにおいて、最高の推論パフォーマンスを示しています。 ただし、リソース制約のあるアプリケーションに安定した拡散モデルを最適化するには、ランタイム最適化にとどまらず、さらに進んだモデル最適化機能がOpenVINO Neural Network Compression Framework(NNCF)から必要とされます。 このブログ記事では、安定した拡散モデルの最適化の問題を概説し、CPUなどのリソース制約のあるHWで実行される場合に、そのようなモデルのレイテンシを大幅に削減するワークフローを提案します。 特に、PyTorchと比較して5.1倍の推論高速化と4倍のモデルフットプリントの削減を達成しました。 安定した拡散の最適化 安定した拡散パイプラインでは、UNetモデルが計算上最もコストがかかります。そのため、単一のモデルの最適化によって推論速度が大幅に向上します。 しかし、このモデルに対しては、従来のモデル最適化手法であるポストトレーニングの8ビット量子化は機能しないことがわかりました。その理由は2つあります。まず、セマンティックセグメンテーション、スーパーレゾリューションなどのピクセルレベル予測モデルは、タスクの複雑さにより、モデル最適化の観点では最も複雑なものの一つであり、モデルパラメータと構造の微調整が結果を多数の方法で崩してしまいます。…

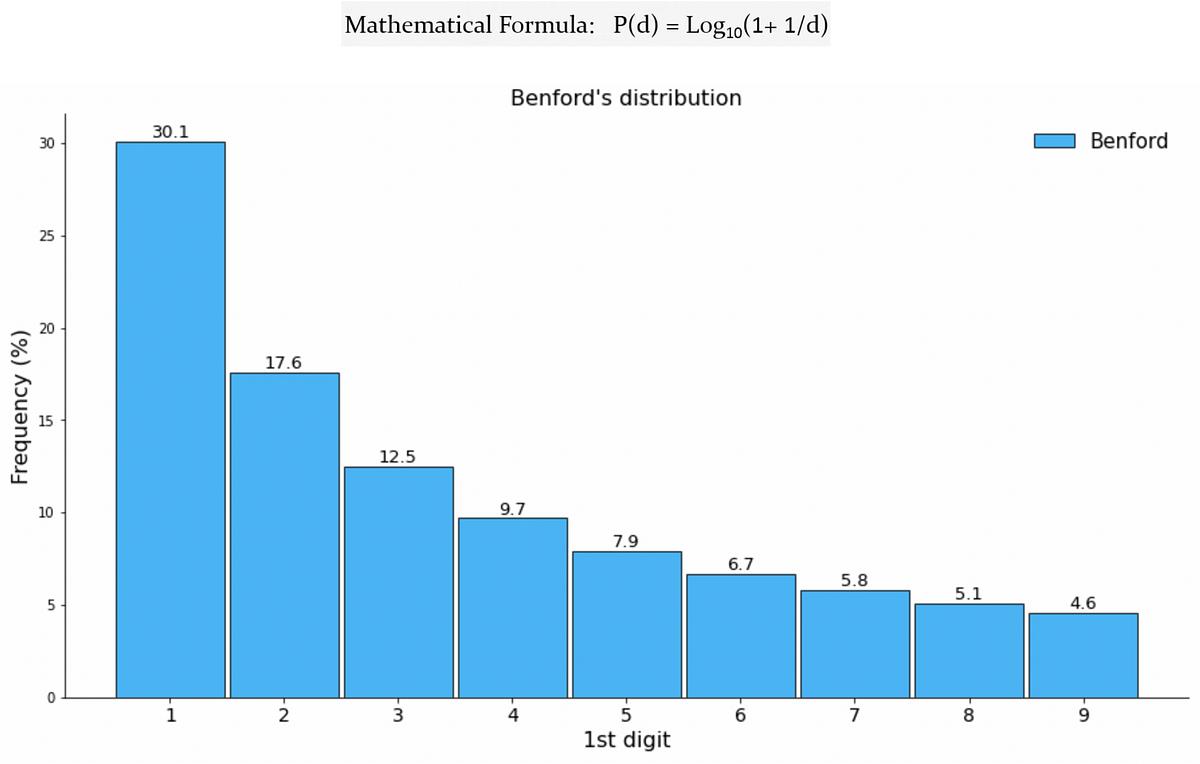

Benfordの法則が機械学習と出会って、偽のTwitterフォロワーを検出する

ソーシャルメディアの広大なデジタル領域において、ユーザーの真正性は最も重要な懸念事項ですTwitterなどのプラットフォームが成長するにつれ、フェイクアカウントの増加も増えていますこれらのアカウントは本物のアカウントを模倣します

AIハイパーソナライゼーションとは何ですか?利点、事例、倫理的懸念

AIのハイパーカスタマイズの概念、メカニズム、および事例について探求してくださいその利点と倫理的な問題について学びましょう

Google Cloudによるデジタルトランスフォーメーション

ここ数年、私たちはGoogle Cloudと提携し、彼らのお客様が利用するコアソリューションに私たちのAI研究を応用して、積極的な影響を与えることに取り組んできました以下では、ドキュメントの理解の最適化、風力エネルギーの価値向上、AlphaFoldのより簡単な利用など、いくつかのプロジェクトを紹介します

ロッテン・トマト映画の評価予測のデータサイエンスプロジェクト:2つ目のアプローチ

レビューの感情に基づいて映画の状態を予測する

クレジットカードの取引データを使用した顧客セグメンテーションのマスタリング

顧客セグメンテーションとは、過去の購買パターンに基づいて顧客セグメントを特定するプロセスですたとえば、リピート/ロイヤル顧客、高額な顧客の特定などを含むことがあります

2023年に知っておく必要のある2つの重要なSQL CASE WHENの例

eコマースの実際のデータアナリストの仕事面接でのSQLの問題ですCASE WHEN式を使用して解決する必要がありますアプローチ方法と解決方法を学びましょう

LangChainを使用したLLMパワードアプリケーションの構築

はじめに 言語処理の未来へようこそ!言語が人々と技術をつなぐ架け橋である世界において、自然言語処理(NLP)の進歩によって素晴らしい機会が広がりました。これらの進歩の中で、革命的な言語モデルであるLLM(大規模言語モデル)が登場し、テキストベースのデータとのやり取り方法を完全に変えました。私たちは、LLMの驚異を探求し、LLMを活用したアプリケーションを構築する方法を学びます。それには、LLMのフルポテンシャルを引き出す革新的なプラットフォームであるLangChainを使用します。 言語モデルは、人間らしいテキストを理解し生成する能力により、さまざまなアプリケーションで重要な役割を果たしています。これらのモデルは、機械翻訳、感情分析、チャットボット、コンテンツ生成など、自然言語処理のタスクを革新しました。彼らは貴重な洞察を提供し、コミュニケーションを改善し、ユーザーエクスペリエンスを向上させます。 学習目標 言語モデル(LLM)の基礎と、インテリジェントなアプリケーションの構築における重要性を理解する。 LangChainをアプリケーション開発ワークフローに統合し、そのAPIを活用する方法を学ぶ。 Langchainでできることについての洞察を得る。 Langchainを使用してさまざまなLLMと対話する。 LLMを使用して対話型チャットボットを作成する。 LangchainでのファインチューニングLLMの意味を理解する。 この記事は、データサイエンスブログマラソンの一環として公開されました。 LLMとは何ですか? LLM(Large Language Model)とは、膨大なテキストデータでトレーニングされた最新の言語モデルを指します。深層学習の技術を利用して人間らしいテキストを理解し生成するため、テキスト補完、言語翻訳、感情分析など、さまざまなアプリケーションにおいて強力なツールとなっています。LLMの最も有名な例の1つは、OpenAIのGPT-3であり、言語生成能力に対して大きな注目と賞賛を浴びています。 LangChainの紹介 あなたのアプリケーションが努力なく人間らしいテキストを理解し生成できる世界を想像してください。LangChainへようこそ。これは、言語モデル(LLM)の魅惑的な領域への入り口を開く先駆的なプラットフォームです。LangChainを使用することで、LLMの非凡な能力を連携させ、プロジェクトに統合することができます。LangChainが明らかにする魅力的な機能と無限の可能性を探求しましょう。 LangChainは、開発者にシームレスで直感的なインターフェースを提供し、アプリケーションでLLMのパワーを最大限に活用することができる高度なプラットフォームです。言語処理のフルポテンシャルを引き出すためのさまざまなAPIやツールを提供しています。 LangChainの特徴と機能 LangChainには、あなたを魅了するさまざまな機能と機能が満載されています。文章の補完から感情の分析、言語の翻訳から固有名詞の認識まで、LangChainは言語を使って驚きを生み出すためのツールを提供します。APIのドキュメントを探索することで、まるで魔法使いが呪文を使いこなすかのように、これらの機能を効果的に使用する方法の秘密を発見します。 LLMをプロジェクトに統合する LangChainの機能と能力を理解したら、それを自分自身のプロジェクトに魔法として織り込む時です。LangChain SDKを使用することで、既存のコードベースとLLMの非凡な能力をシームレスに統合することができます。わずか数行のコードで、LLMの言語処理能力を呼び出し、あなたのアプリケーションを人間らしいテキストを理解し生成するインテリジェントな存在に変えることができます。 LLMの魔法が解き放たれる…

レストランの革命:飲食業界におけるAIの力

レストラン業界は、人工知能(AI)の力を活用して、業務の効率化、顧客体験の向上、COVID-19パンデミックによる課題への適応を進めています。自動化技術が最前線にあり、過去のマクドナルドの仕事は効率と革新の新時代に置き換わるかもしれません。AIが飲食サービス業界と世界中のレストランを変革している驚くべき方法について探ってみましょう。食品の調理から顧客との対話まで、すべてが革新されています。 ロボットによる繰り返し作業の自動化 ロボットはもはやSFの幻想ではありません。絵のような街、イタリアのラパッロでは、ウェイターロボットが優雅に料理を提供し、技術と美食の融合を示しています。ロボットとAIを活用することで、レストランは食品の配達やキッチンの運営などの繰り返し作業を最適化することができます。これらのロボットは、チップを作ったりフライバスケットを空にしたりするのに長けており、手作業を減らし、効率を向上させます。 また読む: Zomatoが画期的な人工知能を始める 顧客との対話の効率化 パンデミックにより人手不足が発生し、非接触体験への需要が増加したことで、AIを活用した顧客との対話が普及しています。レストランは今やAIを利用してドライブスルーや電話注文などのプロセスを自動化しています。この自動化により、注文の正確性が向上し、人手不足を緩和することができます。AIを導入することで、レストランは運営能力を向上させ、顧客にとってシームレスで個別化された体験を提供できます。 メニューの個別化とアップセルにおけるAIの役割 マクドナルドの象徴的なゴールデンアーチもAI技術を取り入れています。マクドナルドは2019年からAIと機械学習への投資を始め、注文プロセスを革新しました。店内のタッチスクリーンキオスクを利用して、顧客は便利に注文をすることができます。さらに、ドライブスルーのデジタルメニューボードは、時間帯、天候、レストランの混雑具合に応じてダイナミックに調整されます。AIのアルゴリズムは補完的なアイテムを提案し、アップセルのプロセスを自動化し、食事の体験を向上させます。 デリバリーロボットによる人手不足の解消 レストラン業界の持続的な人手不足は、自律型のデリバリーロボットの台頭を促しました。これらのロボットヘルパーは短距離の配達を行い、人手不足による圧力を軽減します。大学キャンパスや都市部は、これらのデリバリーロボットの主要な導入地です。いくつかの施設では、導入後の売上の増加が報告されています。Grubhubが大学キャンパスでロボットを使用したり、Uber Eatsが歩道でデリバリーロボットのテストを行ったりするなど、自律型のデリバリーの可能性は広がっています。 また読む: 機械学習の視点からのロボティクスと自動化 バーチャルアシスタントと電話注文 電話での注文もAIによるアップグレードを受けています。有名なレストランチェーン、ウィングストップは、電話注文を受けるためのバーチャルアシスタントのパイロットを行っています。この技術は人間のような対話を再現し、顧客の好みに基づいて推奨をカスタマイズします。バーチャルアシスタントを活用することで、ウィングストップは待ち時間を短縮し、従業員が料理と接客に集中できるようにします。伝統的な注文体験を希望する顧客には引き続き人間のサポートも提供されます。 私たちの意見 AIの統合により、飲食サービス業界は効率の向上、顧客体験の向上、運用の最適化を推進しています。ロボットウェイターから個別化されたメニューの推奨まで、AI技術は食事体験のあらゆる側面を変革しています。レストランが適応し、革新を続けるにつれて、AIの可能性はますます興味深くなっています。人工知能による飲食の未来がここにあります。

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.