Learn more about Search Results T5 - Page 27

- You may be interested

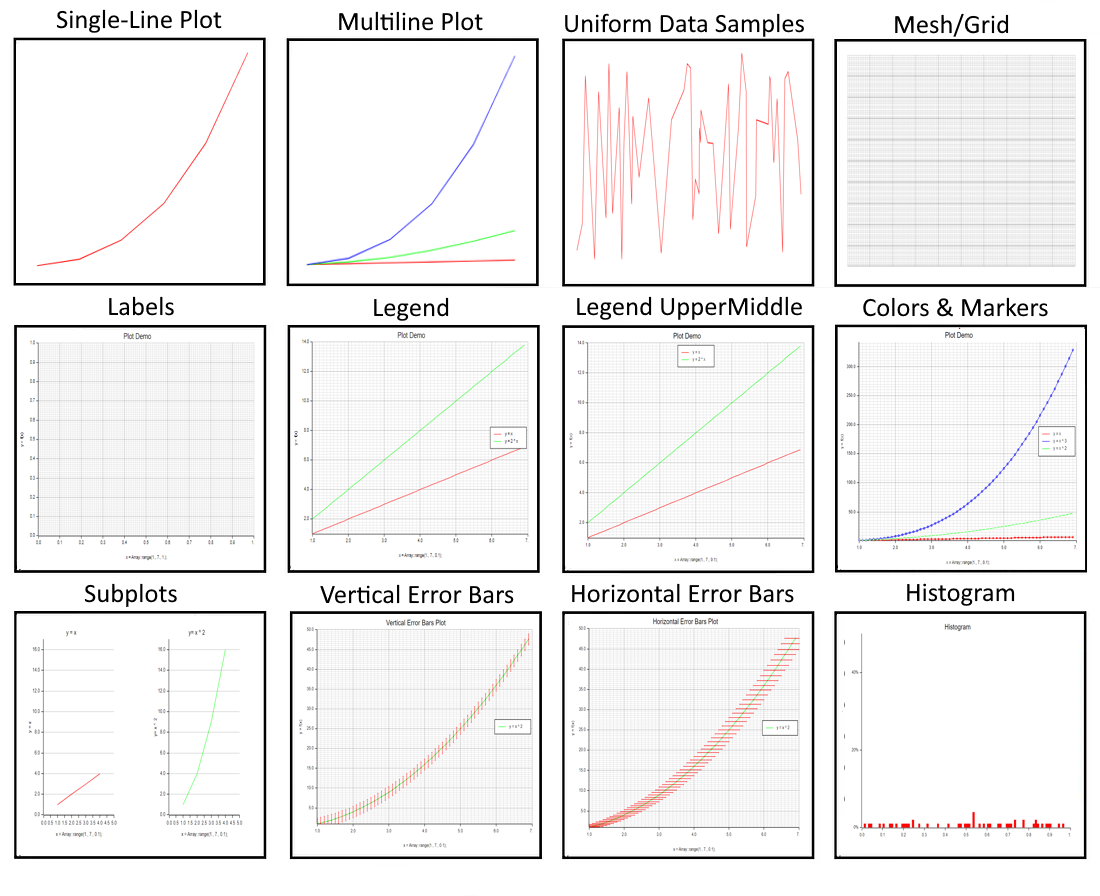

- 高度なチュートリアル:Matplotlibを絶対...

- 「模倣モデルとオープンソースLLM革命」

- 「前例のない緊急事態下でのオンライン機...

- 「カリフォルニアのプライバシー規制当局...

- 27/11から03/12までの週の主要なコンピュ...

- ドリームクラフト3D:ブートストラップさ...

- 「2023年のトップコンピュータビジョンツ...

- フェイブルスタジオは、TV番組の完全に新...

- 「フューショットラーニングの力を解き放つ」

- ビジネス戦略用のChatGPTパーソナを作成す...

- 機械学習プロジェクトのロードマップの設...

- 「ETLにおける進化:変換の省略がデータ管...

- 「確信せよ、ただし検証せよ」

- 「今日のビジネスの風景におけるプロフェ...

- 新しいタンパク質設計のためのディープラ...

遺伝的アルゴリズムを使用したPythonによるTV番組スケジューリングの最適化

「VoAGIに新しい投稿を書いたのは久しぶりです2年間、私は機械学習とディープラーニングを通じて伝統的なメディアセクターでどのような改善ができるかを研究してきました...」

「TR0Nに会ってください:事前学習済み生成モデルに任意のコンディショニングを追加するためのシンプルで効率的な方法」

最近、大規模な機械学習モデルが様々なタスクで優れた成績を収めています。しかし、このようなモデルのトレーニングには多くのコンピュータのパワーが必要です。そのため、現在の大規模な事前学習モデルを適切かつ効果的に活用することが重要です。しかし、複数のモデルの能力をプラグアンドプレイで統合するという課題はまだ解決されていません。このタスクを行うためのメカニズムは、モジュール化されていてモデルに中立的なものであることが好ましいです。これにより、簡単にモデルの部品を切り替えることができます(例えば、CLIPをVAEを使った新しい最先端のテキスト/画像モデルに置き換える)。 この研究では、Layer 6 AI、トロント大学、およびベクトル研究所の研究者が以前にトレーニングされたモデルを混合して条件付き生成を調査しています。条件付き生成モデルは、条件付きデータ分布を学習することを目指します。通常、これらは、クラスラベルと対応する写真xや言語モデルcを介して供給されるテキストプロンプトなど、一致するcを持つデータのペアリングでゼロからトレーニングされます。彼らは、事前学習された無条件のプッシュフォワード生成モデルを、事前分布p(z)からサンプリングされた潜在変数zをデータサンプルx = G(z)に変換するモデルGを使用して条件付きモデルに変更したいと考えています。これを行うために、彼らはTR0Nを提供します。これは、事前学習された無条件の生成モデルを条件付きにトレーニングするための幅広いフレームワークです。 TR0Nは、トレーニング済みの補助モデルf(分類器またはCLIPエンコーダ)へのアクセスを前提としています。また、関数E(z, c)にもアクセスすることを期待しています。この関数は、潜在変数zに対してG(z)が条件cを「よりよく満たす」値を割り当てます。TR0Nは、与えられたcに対してzに関するE(z, c)の勾配をTステップで最小化し、必要な条件付きデータサンプルを提供するlatentsを特定するために、この関数の勾配を最小化します。しかし、彼らは最初にEを単純に最適化することがより良い結果をもたらすことを示しています。このため、TR0Nは最適化プロセスをより効果的に最適化するために使用するネットワークの研究を開始します。 条件cからE(z, c)が最小となるような一致する潜在変数zへ「変換」するため、このネットワークは翻訳ネットワークとして知られています。翻訳ネットワークはGを調整せずに事前に作成されたデータセットを使用しないでトレーニングされます。TR0Nはゼロショットアプローチであり、訓練可能な部分は軽量な翻訳ネットワークのみです。TR0Nは、Gやfのいずれのコンポーネントも容易にアップグレードできるため、最新の最先端バージョンが利用可能になった場合にも非常に高価な条件付きモデルのトレーニングを回避できます。 図1 図1の左パネルでは、翻訳ネットワークのトレーニング方法について説明しています。翻訳ネットワークのトレーニングが完了した後、Eの最適化がその出力を使用して開始されます。単純な初期化に比べて、これによりアモルティゼーションギャップによる性能の低下を回復し、より良い局所最適解とより速い収束を実現します。TR0Nは、効果的な初期化戦略を使用してLangevinダイナミクスでサンプリングすると解釈することも可能です。翻訳ネットワークは条件付き分布q(z|c)であり、E(z, c)が小さいような潜在変数zに高い密度を割り当てます。また、Eの勾配最適化中にノイズも追加します。図1の右パネルでは、TR0Nでのサンプリング方法を示しています。 彼らは以下の3つの貢献を行っています:(i)翻訳ネットワークとそれらの特に効果的なパラメータ化の導入により、Langevinダイナミクスの異なる初期化方法が可能になります。(ii)TR0Nを非常に一般的なフレームワークとして位置付け、以前の関連研究は主に特定のGとfの選択肢に焦点を当てていました。(iii)TR0Nが画像品質と計算可能性のタスク全体で競合する代替手法を実証し、多様なサンプルを生成します。デモはHuggingFaceで利用可能です。

チャーン予測とチャーンアップリフトを超えて

データサイエンスで非常に一般的なタスクの1つは、離反予測ですただし、離反予測はしばしば中間ステップであり、ほとんどが最終目標ではありません通常、私たちが実際に関心を持つのは、削減することです...

「ラスティックデータ:Plottersを使用したデータの可視化ー第1部」

プロッターは、データの視覚化のための人気のあるRustライブラリです高品質のグラフ、チャート、およびその他の視覚化を作成するためのさまざまなツールと機能を提供していますこれは...

「DALL·E2に対する哲学的かつ芸術的な視点」

このブログポストのインタビューに応じていただいたヤロン・センデロヴィッツ教授とリアブ・アイザック・ショーペンに感謝しますDALL·E2はしばらく前にリリースされましたが、書くのが面白いと思いました...

LangChain 101 パート1. シンプルなQ&Aアプリの構築

LangChainは、テキストを生成し、質問に答え、言語を翻訳し、その他多くのテキスト関連の作業を行うアプリケーションを作成するための強力なフレームワークです私はLangChainと一緒に働いてから...

Amazon SageMaker JumpStartを使用して、インターネット接続がないVPCモードで、生成AIの基礎モデルを利用します

最近の生成AIの進歩により、さまざまな業界で特定のビジネス問題を解決するために生成AIをどのように活用するかについての議論が盛んに行われています生成AIは、会話、物語、画像、動画、音楽などの新しいコンテンツやアイデアを作成することができるAIの一種ですこれらはすべて非常に大きなモデルに裏打ちされています

「LLMの内部構造:言語モデルアーキテクチャの詳細な解説」

イントロダクション 大規模な事前学習に基づく言語モデル(LLMs)は、自然言語処理の分野を革新しました。これにより、機械は人間らしいテキストを驚くほど高い精度で理解し生成することが可能になりました。LLMsの能力を真に理解するには、その内部構造に深く入り込み、アーキテクチャの複雑さを理解することが不可欠です。LLMsの言語モデルアーキテクチャの謎を解き明かすことで、これらのモデルが言語を処理し生成する方法について貴重な洞察を得ることができ、言語理解、テキスト生成、情報抽出の進歩の道を開くことができます。 このブログでは、LLMsの内部構造に深く入り込み、人間との相互作用の可能性を永遠に変えた言語の理解と生成を可能にする魔法を明らかにします。 学習目標 トランスフォーマーとセルフアテンションメカニズムを含むLLMsの基本要素を理解する。 エンコーダとデコーダからなるLLMsのレイヤーアーキテクチャを探求する。 LLMsの事前学習と微調整の段階に関する洞察を得る。 GPT-3、T5、BERTなどのLLMアーキテクチャの最新の進展を発見する。 LLMsにおける注意機構とその重要性について包括的な理解を得る。 この記事はデータサイエンスブログマラソンの一環として公開されました。 もっと学ぶ:大規模言語モデル(LLMs)とは何ですか? LLMsの基礎:トランスフォーマーとセルフアテンションメカニズム LLMsの基礎に踏み入ると、トランスフォーマーとセルフアテンションメカニズムがこのモデルが言語を理解し生成するための基本的な要素となります。 トランスフォーマー トランスフォーマーは、Vaswaniらによる2017年の「Attention is All You Need」の論文で初めて紹介され、自然言語処理の分野を革新しました。これらの堅牢なアーキテクチャは、再帰ニューラルネットワーク(RNN)の必要性を排除し、セルフアテンションメカニズムを利用して入力シーケンス内の単語間の関係を捉えます。 トランスフォーマーは、LLMsがテキストを並列処理することを可能にし、効率的かつ効果的な言語理解を実現します。トランスフォーマーは、入力シーケンスのすべての単語に同時にアテンションを向けることで、長距離の依存関係や文脈の関係を伝えることができます。この並列処理により、LLMsはテキストから複雑なパターンや依存関係を抽出し、言語の意味の豊かな理解を実現します。 セルフアテンション さらに深く掘り下げると、トランスフォーマーベースのアーキテクチャの中心にあるのはセルフアテンションの概念です。セルフアテンションにより、LLMsは各単語を処理する際に入力シーケンスの異なる部分に焦点を当てることができます。 セルフアテンションでは、LLMsは現在処理している単語に関連する重要な情報に基づいて、異なる単語にアテンションの重みを割り当てます。この動的なアテンションメカニズムにより、LLMsは重要な文脈情報にアテンションを向け、関連性のないノイズのある入力部分を無視することができます。 関連する単語に選択的にアテンションを向けることで、LLMsは効果的に依存関係を捉え、意味のある情報を抽出することができ、言語理解能力を向上させます。…

MySQLのJSON_ARRAYAGG関数をハッキングして、動的で複数値の次元を作成する

「データチームのメンバーとして、定期購入ボックス会社で働いていると想像しましょうMySQLデータベースでは、購入の取引記録がsubscriptionsというテーブルに書き込まれますメタデータを除いた場合、...」

「集中データ管理における感度の取り組み」

特定の規模と年齢の多くの組織は、既にデータの処理と管理方法を向上させるための取り組みを開始していますデータ管理能力を構造化するための試みは…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.