Learn more about Search Results Ford - Page 25

- You may be interested

- 「マーケティングからデータサイエンスへ...

- Google Quantum AIの研究者が、拡張性のあ...

- 「機械学習リスク管理のための文化的な能力」

- 「APIのパワーを活用する:認証を通じて製...

- トップ投稿 7月31日〜8月6日:ChatGPTを忘...

- 毎日時間を節約する14のGoogle Driveアドオン

- 新たな人工知能の研究が、言語モデルの中...

- マンチェスター大学の研究者たちは、Menta...

- 「UCLとイギリス帝国大学の研究者が、タス...

- 「盲目的なキャリブレーションによる無線...

- デジタルツインは現代の物流を革命化しま...

- 「岩石とAIの衝突:鉱物学とゼロショット...

- 「最初の原則から旅行セールスマン問題を...

- ディープダイブ:Hugging Face Optimum Gr...

- カスタムレンズを使用してウェルアーキテ...

データ、アーキテクチャ、または損失:マルチモーダルトランスフォーマーの成功に最も貢献する要素は何ですか?

この研究では、マルチモーダルトランスフォーマーの成功において、注意機構、損失関数、事前学習データといった要素が重要であるかどうかを検証します私たちは、言語と画像のトランスフォーマーが互いに注意を払うマルチモーダルな注意機構が、これらのモデルの成功に重要であることを発見しました他の種類の注意機構を持つモデル(深さやパラメーターが増えていても)は、マルチモーダルな注意機構を持つ浅くて小さいモデルと比較して同等の結果を達成することができません

新しいAIリスクの早期警告システム

AI研究者はすでに、AIシステムが誤った声明をする、偏った意思決定をする、または著作権のあるコンテンツを繰り返すなど、AIシステムの望ましくない振る舞いを特定するためのさまざまな評価基準を使用しています今後、AIコミュニティがますます強力な汎用AIモデルを構築・展開するにつれて、操作や欺瞞、サイバー攻撃、または他の危険な能力に強いスキルを持つ汎用AIモデルからの極端なリスクの可能性を含めた評価ポートフォリオを拡大する必要があります

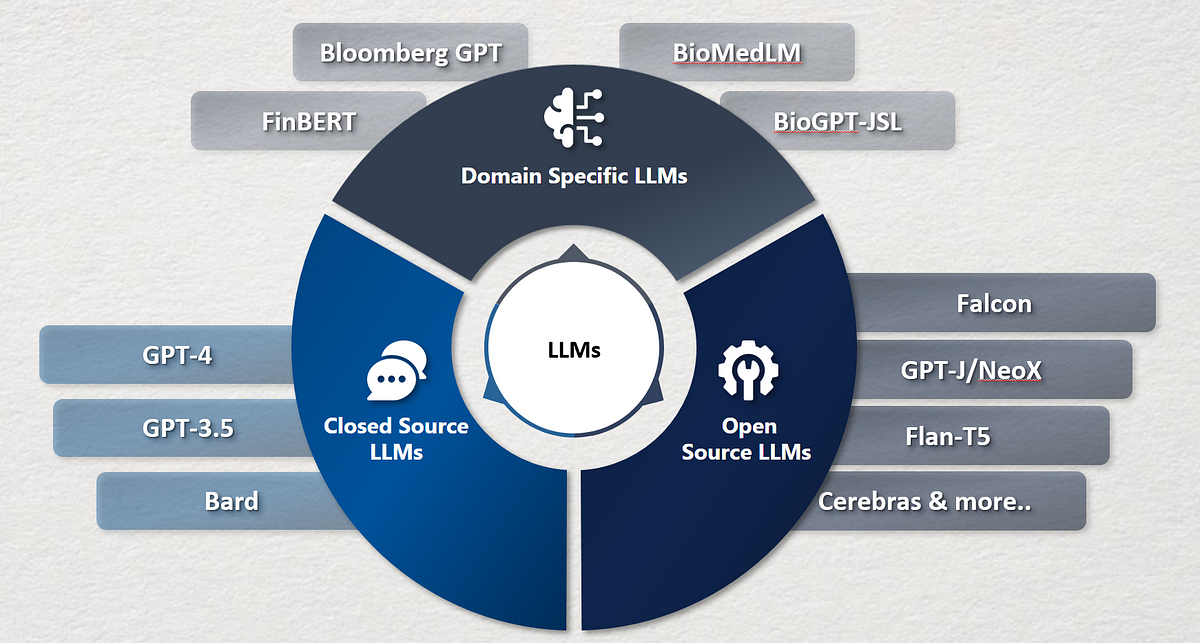

企業がOpenAIのChatGPTに類似した自社の大規模言語モデルを構築する方法

最近の数年間で、言語モデルは大きな注目を集め、自然言語処理、コンテンツ生成、仮想アシスタントなど、さまざまな分野を革新しました最も注目されているのは、

Magic123とは、高品質で高解像度の3Dジオメトリとテクスチャを生成するために、二段階の粗-細最適化プロセスを使用する新しい画像から3Dへのパイプラインです

2次元の世界しか見ることができないにもかかわらず、人間は3次元の環境でナビゲーションしたり、思考したり、相互作用したりする能力に長けています。これは、人間の本質的な認識能力の一環である3D環境の特性や動作に対する深く根付いた認識を示唆しています。単一の写真から詳細な3D再現を作成できるアーティストは、このスキルを新たなレベルに引き上げています。一方で、数十年にわたる研究と進歩にもかかわらず、非構造化画像からの3D再構築、ジオメトリとテクスチャの生成を含む、3D再構築は、コンピュータビジョンにおいて未解決である問題です。最近のディープラーニングの進展により、多くの3D生成活動は学習ベースで行うことができるようになりました。 ディープラーニングは画像の識別と生成において大きな進歩を遂げていますが、現実世界の特定の課題である単一画像からの3D再構築においては、さらなる改善が必要です。人間と機械の3D再構築能力の大きなギャップは、以下の2つの主要な問題に原因があるとされています:(i) 大規模な3Dジオメトリの学習を妨げる大規模な3Dデータセットの不足、および (ii) 3Dデータに取り組む際の詳細レベルとコンピュータリソースのトレードオフ。この問題を解決するための一つの戦略として、2Dの事前知識を利用する方法があります。オンラインには豊富な実際の2D画像データがあります。CLIPやStable Diffusionなどの最先端の画像解釈と生成アルゴリズムを訓練するための最も包括的なテキスト-画像ペアのデータセットの一つがLAIONです。 2D生成モデルの一般化能力の向上に伴い、2Dモデルを事前知識として使用した3D素材の作成に関する戦略が増加しています。DreamFusionは、テキストから3D作成のためのこの2D事前知識ベースの技術を先駆的に開発しました。この手法は、ゼロショットの状況でユニークな視点を指示し、ニューラル輝度場(NeRF)を強化する驚異的な能力を示しています。DreamFusionを基にした最近の研究では、RealFusionやNeuralLiftを使用して、これらの2D事前知識を単一の画像からの3D再構築に適応しようと試みています。別の戦略として、3D事前知識を使用する方法もあります。以前の取り組みでは、トポロジカル制約などの3D事前知識が3D作成を支援するために使用されました。これらの手作りの3D事前知識は一部の3Dコンテンツを作成することができますが、より良い3Dコンテンツを作成することができます。 最近、2D拡散モデルがビュー依存性に変更され、このビュー依存性拡散がZero-1-to-3や3Dimなどの3D事前知識として使用されました。彼らの行動分析によると、2D事前知識と3D事前知識の両方には利点と欠点があります。3D事前知識に比べて、2D事前知識は3D作成において優れた一般化能力を持っており、図1のドラゴン像の例で示されています。2D事前知識に完全に依存するアプローチは、限られた3D理解力のために最終的に3Dの精度と一貫性を失い、多くの面(ジャヌスの問題)、異なるサイズ、不均一なテクスチャなどの非現実的なジオメトリ結果をもたらします。図1のテディベアの例は失敗例です。 しかし、3Dトレーニングデータの量が少ないため、野外再構築には3D事前知識への厳しい依存以上のものが必要です。その結果、図1に示すように、3D事前知識を基にした解決策は一般的なアイテム(上段のテディベアの例など)をうまく処理できますが、より頻度の低いものには苦労し、単純化しすぎて場合によっては平坦な3Dジオメトリ(左下のドラゴン像など)を生成します。この研究では、King Abdullah University of Science and Technology(KAUST)、Snap Inc.、およびVisual Geometry Group、University of Oxfordの研究者たちは、2Dまたは3D事前知識に単純に依存するのではなく、画像から3D作成において革新的な視点を導くために両方の事前知識を同時に使用することを推進しています。2Dと3Dの事前知識の間の有用なトレードオフパラメータを変化させることで、生成された3Dジオメトリにおける探索と活用のバランスを制御することができます。 図1は、Magic123の2Dと3Dの事前情報のトレードオフを示しています。テディベア(頻繁に出現するアイテム)、積み重ねられたドーナツ2つ(あまり一般的ではないもの)、ドラゴンの像(一般的ではないオブジェクト)の3つのシナリオについて、単一画像の再構築を比較しています。右側に示されているように、2Dの背景のみを持つMagic123は、幾何学的な探索を重視し、より創造性のある3Dマテリアルを作成しますが、一貫性が低いかもしれません。一方、3Dの事前情報のみを持つMagic123(左側)は、幾何学的な利用を優先し、正確ですがより単純なジオメトリと特徴の少ないものになります。 2Dの事前情報を優先することで、各2D画像の部分的な3D情報を補完し、創造的な3Dスキルを向上させることができます。ただし、これにより3Dジオメトリの正確性が低下する可能性があります。一方、3Dの事前情報を優先すると、より3D制約のある解とより正確な3Dジオメトリが得られますが、創造性が低下し、困難で異常な状況に対して適切な解を見つける能力が低下する可能性があります。彼らはMagic123を提案し、2Dと3Dの事前情報の両方を使用する2段階の細粒度最適化手法を使用して、高品質な3D出力を生成する最先端の画像から3Dへのパイプラインを提供します。 彼らは粗い段階でニューラル放射場(NeRF)を洗練させます。NeRFは複雑なジオメトリを学習するための暗黙のボリューム表現を効果的に学習します。ただし、NeRFは多くのメモリを使用するため、低解像度の生成画像が拡散モデルに送信され、画像から3Dへのプロセスの出力品質が低下します。より効率的なリソースであるInstant-NGPは、16GBのメモリGPU上で128×128の解像度の画像から3Dへのパイプラインに制限されています。そのため、彼らは第2のステップを追加し、メモリ効率の良いテクスチャ分解されたSDF-Meshハイブリッド表現であるDeep Marching…

小さな言語モデルでも高い性能を発揮できるのか?StableLMに会ってみてください:適切なトレーニングで高性能なテキストとコードを生成できるオープンソースの言語モデル

Stability AIは、Stable Diffusion画像生成AI技術で知られる人工知能のスタートアップ企業です。今日、Stability AIはStableLMという新しい無料かつオープンソースの言語モデルを発表しました。このモデルはアルファフェーズで3つの異なるパラメータサイズ(30億、70億、150億、650億)で提供されます。CC BY-SA-4.0ライセンスの規則により、開発者はStableLMの基本モデルを個人や商業プロジェクトで確認、利用、修正することができます。 独自のAIに対するオープンかつ拡張可能で透明性の高い代替手段を提供する画期的なStable Diffusion画像モデルは、2022年にStability AIの努力によって一般に公開されました。Stability AIはStableLMモデルセットをリリースし、基本的なAIの能力を民主化するという使命をさらに推進しています。StableLMモデルは、テキストやコードの生成能力を持つさまざまなアプリケーションを活性化させます。これらのモデルは、小規模で効率的なモデルが優れたパフォーマンスを発揮する方法を示しています。 チームの以前のEleutherAIという非営利研究ハブとのオープンソースの共同作業により、StableLMのリリースの基盤が整いました。Pileというオープンソースのデータセットを使用して、GPT-J、GPT-NeoX、およびPythiaスイートなど、いくつかの人気のある言語モデルをトレーニングしました。Cerebras-GPTやDolly-2は、これらの以前のモデルを拡張した多くの新しいオープンソースの言語モデルのうちの2つの例です。 StableLMを教えるために使用される実験用のデータセットは、The Pileをベースにしており、トークン数は1.5兆個で3倍の大きさです。1750億のパラメータを持つGPT-3に対して、StableLMはこのデータセットの豊富さにより、会話やコーディングのタスクにおいて予想外に優れたパフォーマンスを達成しています。データセットに関する情報は後日公開されます。 彼らは、教室での使用に最適化された研究モデルのコレクションをリリースしました。これらの洗練されたモデルは、最近リリースされたオープンソースの会話エージェントのデータセット(Alpaca、GPT4All、Dolly、ShareGPT、HH)のデータを最初に使用します。StanfordのAlpacaライセンスに従い、これらのチューニングされたモデルは学術研究用に非営利のCC BY-NC-SA 4.0ライセンスで利用できます。 StableLMは、以下の機能を通じて、オープンでアプローチ可能で支援的なAI技術の開発を目指すチームのビジョンを描いています: 透明性:研究者はパフォーマンスを確認し、解釈可能なアプローチを確立し、危険を特定し、セーフガードの作成を支援するために「中身を見る」ことができます。企業や政府機関は、個人情報を開示することなく、またAIの能力に対する権限を放棄することなく、これらのオープンソースモデルを自分たちのニーズに合わせて修正(または「調整」)することができます。 アクセシビリティ:チームは一般の人々が自分たちのデバイスでモデルを利用できるようにエッジに構築しています。わずかな数の企業の専用サービスに依存するのではなく、開発者はこれらのモデルを使用して、より広範な公開可能なハードウェアと連携するアプリケーションを作成することができます。このようにして、AIの経済的な利益は、多くのユーザーとクリエイターの間で分散されます。提案されたモデルはオープンかつ詳細であり、研究者や学術関係者が解釈性と安全性の面で閉じたモデルの制約を超えることができます。 支援的:これらのモデルは、顧客を置き換えるためではなく、顧客を支援するために作られています。チームは、超人的な知性を追求するのではなく、AIの特定のタスクを実行する能力を現実世界の文脈で向上させることに焦点を当てています。彼らは、一般の人々や企業がイノベーションを促進し、生産性を向上させ、経済の可能性を拡大するために、AIの潜在能力を活用するためのリソースを構築しています。 チームは、ユーザーが受け取る応答の品質が異なる場合があり、不快な言葉や意見が含まれる場合があることを強調しています。これは、微調整や強化学習を行っていない事前学習された大規模言語モデルの場合に共通するものです。スケール、増加するデータ、コミュニティのフィードバック、最適化などが大幅な改善につながる要素です。

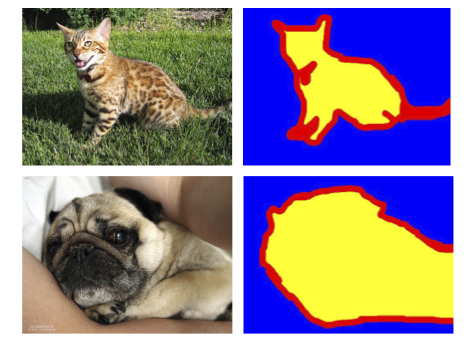

AWS上で動作する深層学習ベースの先進運転支援システムのための自動ラベリングモジュール

コンピュータビジョン(CV)では、興味のあるオブジェクトを識別するためのタグを追加したり、オブジェクトの位置を特定するためのバウンディングボックスを追加したりすることをラベリングと呼びますこれは、深層学習モデルを訓練するためのトレーニングデータを準備するための事前のタスクの1つです数十万時間以上の作業時間が、様々なCVのために画像やビデオから高品質なラベルを生成するために費やされています

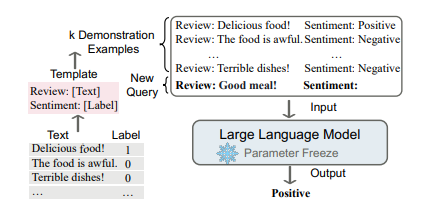

大規模な言語モデルにおけるコンテキストに基づく学習アプローチ

言語モデリング(LM)は、単語のシーケンスの生成的な尤度をモデル化することを目指し、将来の(または欠損している)トークンの確率を予測します言語モデルは自然言語処理の世界を革新しました...

テキストブック品質の合成データを使用して言語モデルをトレーニングする

マイクロソフトリサーチは、データの役割についての現在進行中の議論に新たな燃料を加える論文を発表しました具体的には、データの品質と合成データの役割に触れています

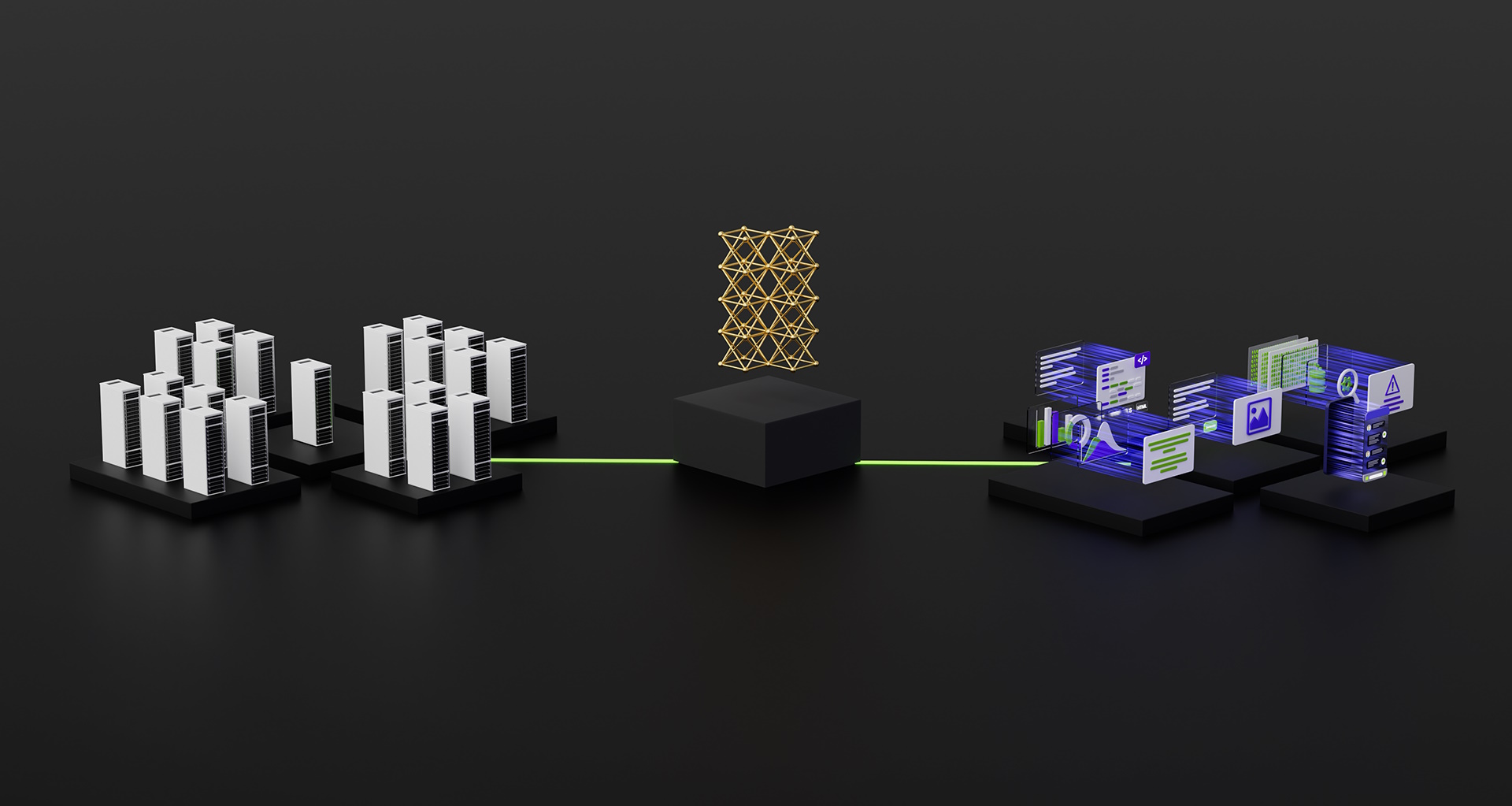

NVIDIA H100 GPUがMLPerfベンチマークのデビューで生成型AIの標準を設定

主要のユーザーと業界標準のベンチマークによれば、NVIDIAのH100 Tensor Core GPUは特に生成型AIを駆動する大規模言語モデル(LLMs)において、最高のAIパフォーマンスを提供しています。 H100 GPUは、最新のMLPerfトレーニングベンチマークのすべての8つのテストで新記録を樹立し、生成型AIの新しいMLPerfテストでも優れた性能を発揮しました。この優れた性能は、単一のアクセラレータあたりの性能だけでなく、大規模サーバーでの性能も提供されています。 たとえば、スタートアップのInflection AIとGPUアクセラレートワークロードに特化したクラウドサービスプロバイダーであるCoreWeaveが共同開発した3,584台のH100 GPUを搭載した商用クラスターでは、GPT-3ベースの大規模トレーニングベンチマークを11分以下で完了しました。 「当社のお客様は、数千のH100 GPUが高速で低レイテンシのInfiniBandネットワーク上で稼働しているため、現在スケールで最先端の生成型AIおよびLLMを構築しています。」と、CoreWeaveの共同設立者でありCTOであるブライアン・ベンチュロ氏は述べています。「NVIDIAとの共同MLPerfサブミッションにより、お客様が享受できる優れたパフォーマンスが明確に示されました。」 本日利用可能な最高のパフォーマンス Inflection AIは、そのパフォーマンスを活用して、パーソナルAI「Pi」の先進的なLLMを構築しました。同社はAIスタジオとして、ユーザーが簡単で自然な方法で対話できるパーソナルAIを作成します。 「当社の最先端の大規模言語モデルは、CoreWeaveの強力なH100 GPUネットワークでトレーニングされたものであり、誰でも今日からパーソナルAIの力を体験できます。」と、Inflection AIのCEOであるムスタファ・スレイマン氏は述べています。 2022年初頭にMustafaとDeepMindのKarén Simonyan、Reid Hoffmanが共同設立したInflection AIは、NVIDIA GPUを使用して世界で最大のコンピューティングクラスターの1つを構築するためにCoreWeaveと協力することを目指しています。 トップパフォーマンスが利用可能に これらのユーザー体験は、今日発表されたMLPerfベンチマークで示されたパフォーマンスを反映しています。…

PyTorchを使った効率的な画像セグメンテーション:パート1

この4部作では、PyTorchを使用して深層学習技術を使った画像セグメンテーションをゼロから段階的に実装しますシリーズを開始するにあたり、必要な基本的なコンセプトとアイデアについて説明します

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.