Learn more about Search Results プロバイダー - Page 25

- You may be interested

- 「ODSC Europe 2023に参加するためのすべ...

- 開発者や企業のためのジェミニAPIとさらに...

- 「自動通話要約を通じて、エージェントの...

- グーグルサーチは、Googleサーチで文法チ...

- Hugging FaceとIBMは、AIビルダー向けの次...

- 高速なトレーニングと推論 Habana Gaudi®2...

- 「トップ5のAIウェブスクレイピングプラッ...

- 「GeoJSONからネットワークグラフへ:Pyth...

- 「Amazon SageMakerの非同期エンドポイン...

- A. Michael West 医療現場における人間と...

- Relume AIによって生成されたワイヤーフレ...

- 「LLMベースの自律エージェントの成長」の...

- 「感覚AIの公開:人工汎用知能(AGI)の実...

- 組合せ最適化によるニューラルネットワー...

- 遺伝的アルゴリズムを使用して特徴セット...

DatabricksがMosaicMLとその他の最近のAIの買収を行いました

経済は非常にダイナミックであるにもかかわらず、AIはまだ熱い市場です過去数週間にいくつかの大規模な買収や合併があり、それぞれが近い将来に市場を再定義する可能性がありますでは、いくつかの最も注目すべきニュースメーカーを見てみましょう...

「Databricks、MosaicMLおよびその他の最近のAIの買収を発表」

経済は非常にダイナミックですが、AIはまだホットな市場です過去数週間にはいくつかの大規模な買収や合併があり、それぞれが近い将来の市場を再定義する可能性がありますそれでは、いくつかの最大のニュースメーカーを見てみましょう...

「DatabricksがMosaicMLとその他の最近のAIの買収を行う」

経済は非常にダイナミックであるにもかかわらず、AIはまだ注目の市場です過去数週間でいくつかの大規模な買収と合併が行われ、それぞれが近い将来の市場を再定義する可能性がありますでは、いくつかの最も注目すべきニュースメーカーを見てみましょう...

ダッシュカムの映像が警察の展開地を明らかにする

科学者たちは、ニューヨーク市の警察が地域に展開する方法に関する示唆を、ディープラーニングモデルとライドシェアドライバーのダッシュカム画像のデータセットを用いて発見しました

セグメントエニシングモデル:画像セグメンテーションの基礎モデル

「メタAI 最新のユニバーサルセグメンテーションモデルの理解」

LLM(Language Model)をアプリケーションに統合する際の複雑さと課題

「OpenAIのChatGPTとGPT APIがリリースされる前から、大規模な言語モデル(LLM)は存在していましたしかし、OpenAIの取り組みのおかげで、GPTは今や開発者や非開発者にとって簡単にアクセスできるようになりましたこのリリースは...」

パートナーシップ:Amazon SageMakerとHugging Face

この笑顔をご覧ください! 本日、私たちはHugging FaceとAmazonの戦略的パートナーシップを発表しました。これにより、企業が最先端の機械学習モデルを活用し、最新の自然言語処理(NLP)機能をより迅速に提供できるようになります。 このパートナーシップを通じて、Hugging Faceはお客様にサービスを提供するためにAmazon Web Servicesを優先的なクラウドプロバイダーとして活用しています。 共通のお客様に利用していただくための第一歩として、Hugging FaceとAmazonは新しいHugging Face Deep Learning Containers(DLC)を導入し、Amazon SageMakerでHugging Face Transformerモデルのトレーニングをさらに簡単にする予定です。 Amazon SageMaker Python SDKを使用して新しいHugging Face DLCにアクセスし、使用する方法については、以下のガイドとリソースをご覧ください。 2021年7月8日、私たちはAmazon SageMakerの統合を拡張し、Transformerモデルの簡単なデプロイと推論を追加しました。Hugging…

CPU上でBERT推論をスケーリングアップする(パート1)

.centered { display: block; margin: 0 auto; } figure { text-align: center; display: table; max-width: 85%; /* デモです; 必要に応じていくつかの量 (px や %) を設定してください */…

モダンなCPU上でのBERTライクモデルの推論のスケーリングアップ – パート2

イントロダクション:CPU上でのAI効率を最適化するためのIntelソフトウェアの使用 前のブログ記事で詳細に説明したように、Intel Xeon CPUは、AVX512やVNNI(Vector Neural Network Instructions)などのAIワークロードに特に設計された機能を提供しており、整数量子化されたニューラルネットワークを使用した効率的な推論をサポートするための追加のシステムツールも提供しています。このブログ記事では、ソフトウェアの最適化に焦点を当て、Intelの新しいIce Lake世代のXeon CPUのパフォーマンスについて紹介します。私たちの目標は、Intelのハードウェアを最大限に活用するためにソフトウェア側で利用可能なものをすべて紹介することです。前のブログ記事と同様に、ベンチマークの結果とグラフとともに、これらのツールと機能を簡単に使用できるようにします。 4月にIntelは最新のIntel Xeonプロセッサ、コードネームIce Lakeを発売しました。これはより効率的で高性能なAIワークロードをターゲットにしています。具体的には、Ice Lake Xeon CPUは、以前のCascade Lake Xeonプロセッサと比較して、さまざまなNLPタスクで最大75%高速な推論が可能です。これは、新しいSunny Coveアーキテクチャ上での新しい命令やPCIe 4.0のようなハードウェアおよびソフトウェアの改善の組み合わせによって実現されています。最後になりますが、Intelは、IntelのExtension for Scikit Learn、Intel TensorFlow、Intel PyTorch…

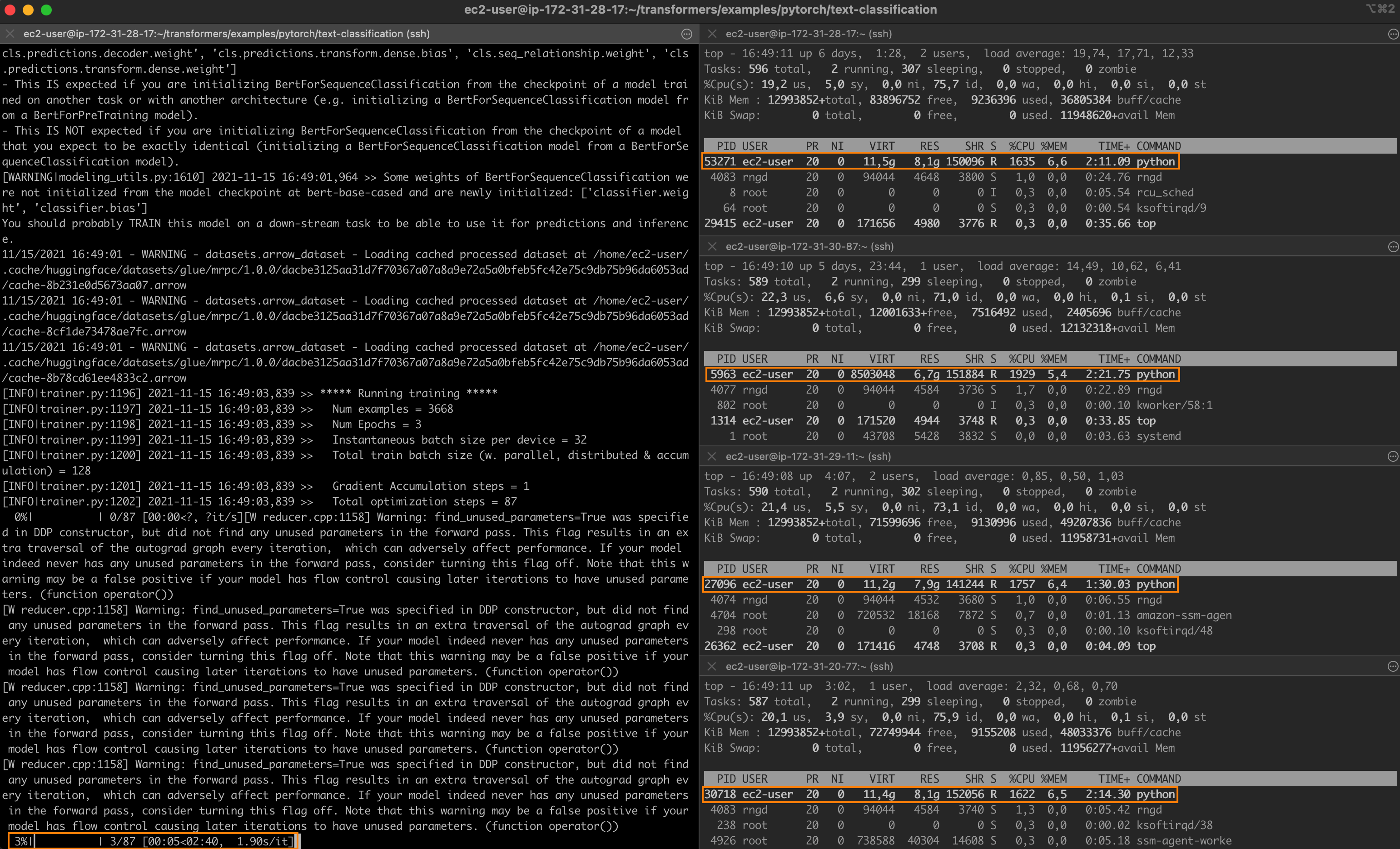

Intelのテクノロジーを使用して、PyTorchの分散ファインチューニングを高速化する

驚異的なパフォーマンスを持つ最先端のディープラーニングモデルでも、トレーニングには長い時間がかかることがよくあります。トレーニングジョブを高速化するために、エンジニアリングチームは分散トレーニングに頼っています。これは、クラスタ化されたサーバーがそれぞれモデルのコピーを保持し、トレーニングセットのサブセットでトレーニングを行い、結果を交換して最終的なモデルに収束するという分割統治技術です。 グラフィックプロセッシングユニット(GPU)は、ディープラーニングモデルのトレーニングにおいて長い間デファクトの選択肢でした。しかし、転移学習の台頭により、状況が変化しています。モデルは今や巨大なデータセットからゼロからトレーニングされることはほとんどありません。代わりに、特定の(より小さい)データセットで頻繁に微調整され、特定のタスクに対してベースモデルよりも精度の高い専用モデルが構築されます。これらのトレーニングジョブは短いため、CPUベースのクラスタを使用することは、トレーニング時間とコストの両方を管理するための興味深いオプションとなります。 この投稿の内容 この投稿では、インテル Xeon Scalable CPUサーバのクラスタ上でPyTorchのトレーニングジョブを分散して高速化する方法について説明します。Ice Lakeアーキテクチャを搭載し、パフォーマンス最適化されたソフトウェアライブラリを実行する仮想マシンを使用して、クラスタをゼロから構築します。クラウドまたはオンプレミスの環境で、簡単にデモを自身のインフラストラクチャに複製することができるはずです。 テキスト分類ジョブを実行し、MRPCデータセット(GLUEベンチマークに含まれるタスクの1つ)でBERTモデルを微調整します。MRPCデータセットには、ニュースソースから抽出された5,800の文のペアが含まれており、各ペアの2つの文が意味的に同等であるかどうかを示すラベルが付いています。このデータセットはトレーニング時間が合理的であり、他のGLUEタスクを試すのはパラメーターさえ変更すれば可能です。 クラスタが準備できたら、まずは単一のサーバーでベースラインのジョブを実行します。その後、2つのサーバーや4つのサーバーにスケールアップして、スピードアップを計測します。 途中で以下のトピックについて説明します: 必要なインフラストラクチャとソフトウェアのビルディングブロックのリストアップ クラスタのセットアップ 依存関係のインストール 単一ノードのジョブの実行 分散ジョブの実行 さあ、作業を始めましょう! インテルサーバの使用 最高のパフォーマンスを得るために、Ice Lakeアーキテクチャに基づいたインテルサーバを使用します。これには、Intel AVX-512やIntel Vector Neural Network…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.