Learn more about Search Results 認証 - Page 24

- You may be interested

- Intel CPUのNNCFと🤗 Optimumを使用した安...

- AIが統合セールスチームにより高速かつ高...

- 即座のハッキングとLLMの誤用

- 2023年5月のVoAGIトップ記事:Mojo Lang:...

- GPT-4は、誤情報を引き起こすプロンプトイ...

- 「効率的な変数選択のための新しいアルゴ...

- 「PhysObjectsに会いましょう:一般的な家...

- BERTopicとHugging Face Hubの統合をご紹...

- 「ヒュメインが革命的なAIパワードウェア...

- DeepMind RoboCat:自己学習ロボットAIモデル

- フリーユーについて紹介します:追加のト...

- クラウドインスタンスのスタートアップス...

- 「2023年のトップAI画像から動画を生成す...

- カナダ政府、オンラインニュース法に関し...

- 「Falcon 180B あなたのコンピューターで...

「エヴァ・マリー・ミュラー=シュトゥーラ博士による、倫理的なAIとデータサイエンスの実践の重要性について」

「データとAIのパイオニアであるDr. Eva-Marie Muller-Stuler氏が、EY MENAの貴重な旅を共有してくれたこと、倫理的なAIとデータサイエンスの実践に関するいくつかの見解、そして新たなプロフェッショナルを志す人々への貴重なアドバイスに感謝いたしますこのインタビューは、透明性、学際的な協力の重要性、倫理的なAIの採用をしないことの潜在的なリスクについて明らかにしています... Dr. Eva-Marie Muller-Stuler氏による倫理的なAIとデータサイエンスの実践の重要性についての記事を読む」

「ウェブ開発の未来:予測と可能性」

「ウェブ開発の未来を発見しましょう!AI、PWA、VRなどを探求しましょう可能性やウェブ開発者の役割についての洞察を得ましょう」

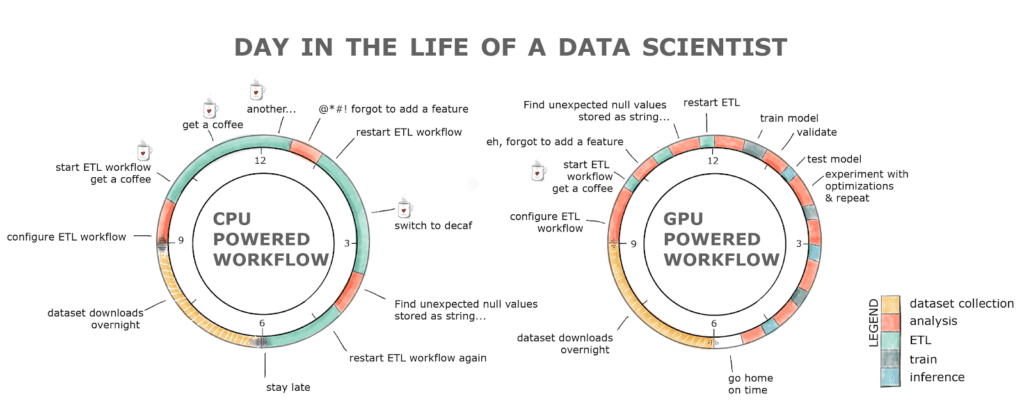

「GPUのマスタリング:PythonでのGPUアクセラレーテッドデータフレームの初心者ガイド」

「RAPIDS cuDFは、pandasのようなAPIを備えており、データサイエンティストやエンジニアがわずかなコードの変更でGPU上での並列計算の膨大な可能性に素早くアクセスできるようにします詳細は以下をお読みください」

「LLMの内部構造:言語モデルアーキテクチャの詳細な解説」

イントロダクション 大規模な事前学習に基づく言語モデル(LLMs)は、自然言語処理の分野を革新しました。これにより、機械は人間らしいテキストを驚くほど高い精度で理解し生成することが可能になりました。LLMsの能力を真に理解するには、その内部構造に深く入り込み、アーキテクチャの複雑さを理解することが不可欠です。LLMsの言語モデルアーキテクチャの謎を解き明かすことで、これらのモデルが言語を処理し生成する方法について貴重な洞察を得ることができ、言語理解、テキスト生成、情報抽出の進歩の道を開くことができます。 このブログでは、LLMsの内部構造に深く入り込み、人間との相互作用の可能性を永遠に変えた言語の理解と生成を可能にする魔法を明らかにします。 学習目標 トランスフォーマーとセルフアテンションメカニズムを含むLLMsの基本要素を理解する。 エンコーダとデコーダからなるLLMsのレイヤーアーキテクチャを探求する。 LLMsの事前学習と微調整の段階に関する洞察を得る。 GPT-3、T5、BERTなどのLLMアーキテクチャの最新の進展を発見する。 LLMsにおける注意機構とその重要性について包括的な理解を得る。 この記事はデータサイエンスブログマラソンの一環として公開されました。 もっと学ぶ:大規模言語モデル(LLMs)とは何ですか? LLMsの基礎:トランスフォーマーとセルフアテンションメカニズム LLMsの基礎に踏み入ると、トランスフォーマーとセルフアテンションメカニズムがこのモデルが言語を理解し生成するための基本的な要素となります。 トランスフォーマー トランスフォーマーは、Vaswaniらによる2017年の「Attention is All You Need」の論文で初めて紹介され、自然言語処理の分野を革新しました。これらの堅牢なアーキテクチャは、再帰ニューラルネットワーク(RNN)の必要性を排除し、セルフアテンションメカニズムを利用して入力シーケンス内の単語間の関係を捉えます。 トランスフォーマーは、LLMsがテキストを並列処理することを可能にし、効率的かつ効果的な言語理解を実現します。トランスフォーマーは、入力シーケンスのすべての単語に同時にアテンションを向けることで、長距離の依存関係や文脈の関係を伝えることができます。この並列処理により、LLMsはテキストから複雑なパターンや依存関係を抽出し、言語の意味の豊かな理解を実現します。 セルフアテンション さらに深く掘り下げると、トランスフォーマーベースのアーキテクチャの中心にあるのはセルフアテンションの概念です。セルフアテンションにより、LLMsは各単語を処理する際に入力シーケンスの異なる部分に焦点を当てることができます。 セルフアテンションでは、LLMsは現在処理している単語に関連する重要な情報に基づいて、異なる単語にアテンションの重みを割り当てます。この動的なアテンションメカニズムにより、LLMsは重要な文脈情報にアテンションを向け、関連性のないノイズのある入力部分を無視することができます。 関連する単語に選択的にアテンションを向けることで、LLMsは効果的に依存関係を捉え、意味のある情報を抽出することができ、言語理解能力を向上させます。…

「犯罪者がWormGPT(ダークウェブのChatGPT)を利用する恐ろしい4つの方法」

「WormGPTは、倫理的な制約や制限を持たないダークウェブ上のAIパワードチャットボットです」

「はい!OpenTelemetryはシステムのセキュリティを確保するための重要な要素です」

「OTelがシステムのセキュリティに果たす重要な役割や、OTelがテレメトリデータを安全に処理する方法、そしてOTelのベストプラクティスについて探求しましょう」

「Quivrに会ってください:第2の脳のように構造化されていない情報を保存し、取得するためのオープンソースプロジェクト」

過去数年間、OpenAIのドメインは持続的な成長を遂げてきました。多くの大学の研究者がオープンソースのプロジェクトを構築し、データサイエンスの発展に貢献しています。Stan Girarによって構築されたオープンソースプロジェクトの1つがQuivrです。それは第二の脳とも呼ばれ、現在のデータモデルやスキーマに従って整理されていないデータを格納し、従って伝統的な関係データベースやRDBMSに格納することはできません。テキストとマルチメディアは、非構造化コンテンツの2つの一般的なタイプです。 Quivrの公式ウェブサイトから、ボタン「試しにやってみる」をクリックしてQuivrのプレミアムバージョンにアクセスすることができます。制限なしでQuivrを使用したい場合は、デバイスにローカルにダウンロードすることもできます。Quivrのインストールには適切な手順があります。Quivrのリポジトリをローカルデバイスにクローンし、それをナビゲートする必要があります。また、仮想環境を作成し、デバイスでアクティベートする必要もあります。すべての依存関係をインストールし、Streamlitのシークレットをコピーし、重要な認証情報を追加する必要もあります。最後に、これらの手順を経てQuivrアプリを実行できるはずです。OpenAIの公式ウェブサイトからも参照できます。また、デバイスには公式で最新のPythonのバージョンが事前にインストールされている必要があります。Quivrをインストールするローカルデバイス上で仮想のPythonプログラミング環境を作成できる公式のツールも必要です。 QuivrのオープンAIソフトウェアには、非構造化データと情報を保存するためのさまざまな機能があります。Quivrは画像、テキスト、コードテンプレート、プレゼンテーション、ドキュメント、CSVおよびxlsxファイル、PDFドキュメントなど、任意のデータセットを保存できます。自然言語処理技術の助けを借りて、情報を生成し、より多くのデータを生成するのにも役立ちます。高度な人工知能の助けを借りて、失われた情報を取り戻すこともできます。Quivrは、データセットにできるだけ迅速にアクセスして出力を通じて提供するため、高速です。データはクラウドに適切に保存されているため、Quivrからデータを失うことはありません。 Quivrは情報検索の能力をクラウドシステムと統合したオープンソースのアプリケーションです。それは将来的にはほとんどの人々によって生産性を向上させるために使用されるソフトウェアになるでしょう。Quivrを使用する主な利点は、同時にさまざまなツールを処理できることです。これからのデータサイエンスや人工知能の分野で新興技術となることでしょう。

「機械学習と人工知能を利用した在庫管理の改善」

「人工知能(AI)は在庫管理システムの効果を大幅に向上させることができます需要予測をサポートし、在庫レベルを最適化し、廃棄物を削減するのに役立ちます」

2023年の機械学習研究におけるトップのデータバージョン管理ツール

生産に使用されるすべてのシステムはバージョン管理する必要があります。ユーザーが最新のデータにアクセスできる単一の場所です。特に多くのユーザーが同時に変更を加えるリソースには監査トレイルを作成する必要があります。 チーム全員が同じページにいることを確保するために、バージョン管理システムが担当しています。それにより、チーム全員が同時に同じプロジェクトで協力し、ファイルの最新バージョンで作業していることが保証されます。適切なツールがあれば、このタスクを迅速に完了することができます! 信頼性のあるデータバージョン管理方法を採用すると、一貫性のあるデータセットとすべての研究の完全なアーカイブを持つことができます。データバージョニングソリューションは、再現性、トレーサビリティ、およびMLモデルの履歴に関心がある場合、ワークフローに必須です。 データセットやモデルのハッシュなどのオブジェクトのコピーを取得し、区別して比較するために使用できるデータバージョンが頻繁にメタデータ管理ソリューションに記録されるようにすると、モデルのトレーニングがバージョン管理され、繰り返し可能になります。 さあ、コードの各コンポーネントを追跡できる最高のデータバージョン管理ツールを調べてみましょう。 Git LFS Git LFSプロジェクトの使用は制限されていません。Gitは、GitHub.comやGitHub Enterpriseなどのリモートサーバーに大きなファイルの内容を保存し、大きなファイルをテキストポインターで置き換えます。音声サンプル、映画、データベース、写真など、置き換えられるファイルの種類には大きなファイルが含まれます。 Gitを使用して大規模なファイルリポジトリを迅速にクローンして取得したり、外部ストレージを使用してGitリポジトリでより多くのファイルをホストしたり、数GBの大きさの大きなファイルをバージョン管理することができます。データの取り扱いにおいては比較的シンプルな解決策です。他のツールキット、ストレージシステム、スクリプトは必要ありません。ダウンロードするデータ量を制限します。これにより、大きなファイルのコピーがリポジトリから取得するよりも速くなります。ポイントはLFSを指し、より軽い素材で作られています。 LakeFS LakeFSは、S3またはGCSにデータを格納するオープンソースのデータバージョニングソリューションであり、Gitに似たブランチングおよびコミット方法をスケーラブルに実装しています。このブランチング方法により、別々のブランチで変更を可能にし、アトミックかつ即座に作成、マージ、およびロールバックできるようにすることで、データレイクをACID準拠にします。 LakeFSを使用すると、繰り返し可能でアトミックなデータレイクの活動を開発することができます。これは新しいものですが、真剣に取り組む必要があります。Gitのようなブランチングとバージョン管理の方法を使用してデータレイクとやり取りし、ペタバイト単位のデータをスケーラブルにチェックできます。 DVC Data Version Controlは、データサイエンスや機械学習のアプリケーションに適したアクセス可能なデータバージョニングソリューションです。このアプリケーションを使用してパイプラインを任意の言語で定義することができます。 DVCは、その名前が示すように、データバージョニングに特化しているわけではありません。このツールは、大きなファイル、データセット、機械学習モデル、コードなどを管理することで、機械学習モデルを共有可能かつ再現可能にします。さらに、チームがパイプラインと機械学習モデルを管理しやすくします。このアプリケーションは、迅速に設定できる簡単なコマンドラインを提供することで、Gitの例にならっています。 最後に、DVCはチームのモデルの再現性と一貫性を向上させるのに役立ちます。コードの複雑なファイルの接尾辞やコメントではなく、Gitのブランチを使用して新しいアイデアをテストします。旅行中にペーパーや鉛筆ではなく、自動的なメトリックトラッキングを使用します。 プッシュ/プルコマンドを使用して機械学習モデル、データ、およびコードの一貫したバンドルを製品環境、リモートマシン、または同僚のデスクトップに転送するためのアドホックなスクリプトではなく使用します。 DeltaLake DeltaLakeというオープンソースのストレージレイヤーにより、データレイクの信頼性が向上します。Delta Lakeは、バッチおよびストリーミングデータ処理をサポートするだけでなく、スケーラブルなメタデータ管理も提供します。現在のデータレイクに基づいており、Apache…

「DifFaceに会ってください:盲目の顔の修復のための新しい深層学習拡散モデル」

非常に古い写真を見ると、最近のカメラで撮影された写真とは明らかに異なることがわかります。ぼやけたりピクセル化された写真は以前はかなり一般的でした。写真の品質の理想が詳細、定義、鮮明さに関連していることから、古い写真がこれらの品質基準を提供できないのは簡単に理解できます。実際、古いカメラと最近のカメラで撮影された画像の大きな違いに気付きます。しかし、このような問題は最近の写真でも頻繁に発生します。それはカメラのシャッターや環境設定に依存することが多いからです。 もし、あなたがぼやけたポートレートを持っていたり、撮影したことがあって、その詳細がかなり見分けにくい場合はどうなるでしょうか?ぼやけた写真を鮮明で高解像度かつ詳細な写真に変換することが可能かどうか、そして可能な場合はその方法について考えたことはありますか? これが必要なのは、盲目的な顔の復元(BFR)です。これは、劣化(例えばノイズやぼやけ)または低品質の入力画像から、人の顔の明確で忠実な画像を再構築するタスクを指します。この難しい問題は、監視、生体認証、ソーシャルメディアなど、さまざまな実用的なアプリケーションで広範な関心を集めています。 近年、深層学習手法が盲目的な顔の復元において有望なアプローチとして登場しました。これらの手法は、人工ニューラルネットワークに基づいており、手作りの特徴量や劣化プロセスの明示的なモデリングを必要とせずに、さまざまなベンチマークで印象的な結果を示すことができます。 これらの手法は、復元の品質を向上させるために多くの複雑な指標、数式、およびパラメータに焦点を当てています。L1学習損失は、忠実性を確保するために一般的に使用されます。最近のBFR手法では、より現実的な結果を得るために敵対的損失と知覚損失が導入されています。他のいくつかの既存の手法では、顔の特定の事前条件(顔のランドマーク、顔の部品、生成事前条件など)も利用しています。これらの制約をすべて考慮することは、訓練を不必要に複雑にし、これらの制約の間でトレードオフを実現するために煩雑なハイパーパラメータの調整を必要とすることがしばしばあります。さらに、敵対的損失の悪名高い不安定性は、訓練をより困難にします。 これらの問題を克服するために、DifFaceという新しい手法が開発されました。この手法は、複雑な劣化に対して、状態の設計が複雑でないため、最先端の手法よりも優雅に対処することができます。その主な鍵は、低品質(LQ)画像から高品質(HQ)画像への事後分布です。具体的には、LQ画像から事前訓練された拡散モデルの中間状態に対する遷移分布を利用し、この中間状態からHQターゲットに対して事前訓練された拡散モデルを再帰的に適用して徐々に伝達します。 下の図は、提案されたフレームワークを示しています。 推論には、LQ画像y0から中間拡散変数xN(N<T)が関与します。この中間状態は、いわゆる拡散推定器を介して得られます。これは、入力画像y0から拡散ステップxNを推定するために開発されたニューラルネットワークアーキテクチャを表します。この中間状態から、望ましいx0が推論されます。これにより、いくつかの利点がもたらされます。まず第一に、xTからx0までの完全な逆拡散プロセスよりも効率的です。なぜなら、事前訓練された拡散モデル(xNからx0へ)を利用できるからです。第二に、ゼロから拡散モデルを再訓練する必要はありません。さらに、この手法は訓練に複数の制約を必要とせず、未知の複雑な劣化に対処することができます。 DifFaceとその他の最新手法の結果と比較は、以下の図に示されています。 生成された画像の詳細を見ると、DifFaceは最新の技術を凌駕し、低品質、ぼやけた、劣化した入力画像から高品質で詳細な鮮明な画像を生成することが明らかです。 これは、Blind Face Restorationの問題を解決するための新しいフレームワークであるDifFaceの概要でした。興味がある場合は、以下のリンクで詳細情報を見つけることができます。

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.