Learn more about Search Results ドキュメンテーション - Page 22

- You may be interested

- RLアンプラグド:オフライン強化学習のベ...

- PoisonGPT ハギングフェイスのLLMがフェイ...

- 「魔法の角度」グラフェンにおける磁気サ...

- コードの進化:ゼロから理解して遺伝的ア...

- 事前訓練された視覚表現は、長期的なマニ...

- 「機械学習におけるモデルの解釈性におい...

- 「社会教育指数は学校卒業者の結果にどの...

- 魅力的な生成型AIの進化

- 「2024年に成功したデータサイエンティス...

- メタはより強力なAIを発表し、それを使用...

- エッジでの視覚品質検査のためのエンド・...

- あなたのプロジェクトに最適な5つのデータ...

- 10倍の生産性を向上させるためのTop 10 VS...

- NumPyを使用した効率的なk最近傍(k-NN)解

- 「OpenAIの研究者たちは、敵対的なトレー...

モデルレジストリとAmazon SageMakerモデルカードを統合する

「Amazon SageMakerモデルカードにより、モデルのドキュメント化方法を標準化し、モデルの設計、構築、トレーニング、評価などのライフサイクルを可視化することができますモデルカードは、モデルに関するビジネスおよび技術的なメタデータの真実の一元的な情報源として、監査やドキュメンテーションに信頼性を持って使用できるように意図されています」

「2023年に知っておく必要のあるトップ10のディープラーニングツール」

コンピュータと人工知能の世界の複雑な問題には、ディープラーニングツールの支援が必要です。課題は時間とともに変化し、分析パターンも変わります。問題に対処するためのツールの定期的な更新と新しい視点には、実地の専門知識とディープラーニングツールの経験が必要です。トップツールの更新されたリストと各ツールの主な機能を確認してください。 ディープラーニングとは何ですか? ディープラーニングは、機械学習のサブセットであり、コンピュータの操作学習に重要な人工知能の一部です。関連するディープラーニングツールは、コンピュータのデータとパターンを処理して意思決定を行うプログラムのキュレーションを担当しています。アルゴリズムによる予測分析が可能です。 トップ10のビッグデータツール ビッグデータツールは、従来のシステムでは効率的に処理できない大量のデータを扱うために不可欠です。これらのツールを活用することで、企業はデータに基づいた意思決定を行い、競争力を持ち、全体的な業務効率を向上させることができます。以下はトップ10のビッグデータツールです: TensorFlow Keras PyTorch OpenNN CNTK MXNet DeeplearningKit Deeplearning4J Darknet PlaidML TensorFlow 主な機能: TensorFlowは、Go、Java、Pythonなどの異なる言語でインターフェースを提供しています。 グラフィックの可視化を可能にします。 組み込みおよびモバイルデバイスを含む、ビルドおよび展開のためのモデルを含んでいます。 コミュニティのサポート 効率的なドキュメンテーション機能 コンピュータビジョン、テキスト分類、画像処理、音声認識が可能です。 多層の大規模なニューラルネットワークに適しています。…

メタからのLlama 2基盤モデルは、Amazon SageMaker JumpStartで利用可能になりました

「本日、Metaによって開発されたLlama 2 ファウンデーションモデルがAmazon SageMaker JumpStartを通じてお客様に提供できることを喜んでお知らせしますLlama 2 ファミリーは、7兆から700兆のパラメータを持つ事前学習および微調整済みの生成テキストモデルのコレクションです微調整済みのLLMはLlama-2-chatと呼ばれています」

「AI駆動の洞察:LangChainとPineconeを活用したGPT-4」

「質的データと効果的に取り組むことは、プロダクトマネージャーが持つべき最も重要なスキルの一つですデータを収集し、分析し、効率的な方法で伝えることができるようにすることは、...」

「AI開発でこれらのミスを com しないでください」

「品質の高いAIデプロイメントを開発するには、準備が全体の90%を占めます以下に、最高のAIモデルを開発するために注意すべき10のAI開発の間違いを紹介します」

「GPT4Readability — リードミーをもう一度書く必要はありません」

複雑なPythonのコードベースをナビゲートすることは、特にプロジェクトに十分なドキュメンテーションがない場合には困難なタスクですこれはプログラマの生活において頻繁に起こることです幸いにも...

「AIはデータガバナンスにどのように影響を与えているのか?」

ジェネレーティブAIは既にデータガバナンスの世界を揺るがし始めており、今後もその影響力は続く予定ですChatGPTのリリースからわずか6ヶ月しか経っていませんが、振り返りが必要な感じがします...

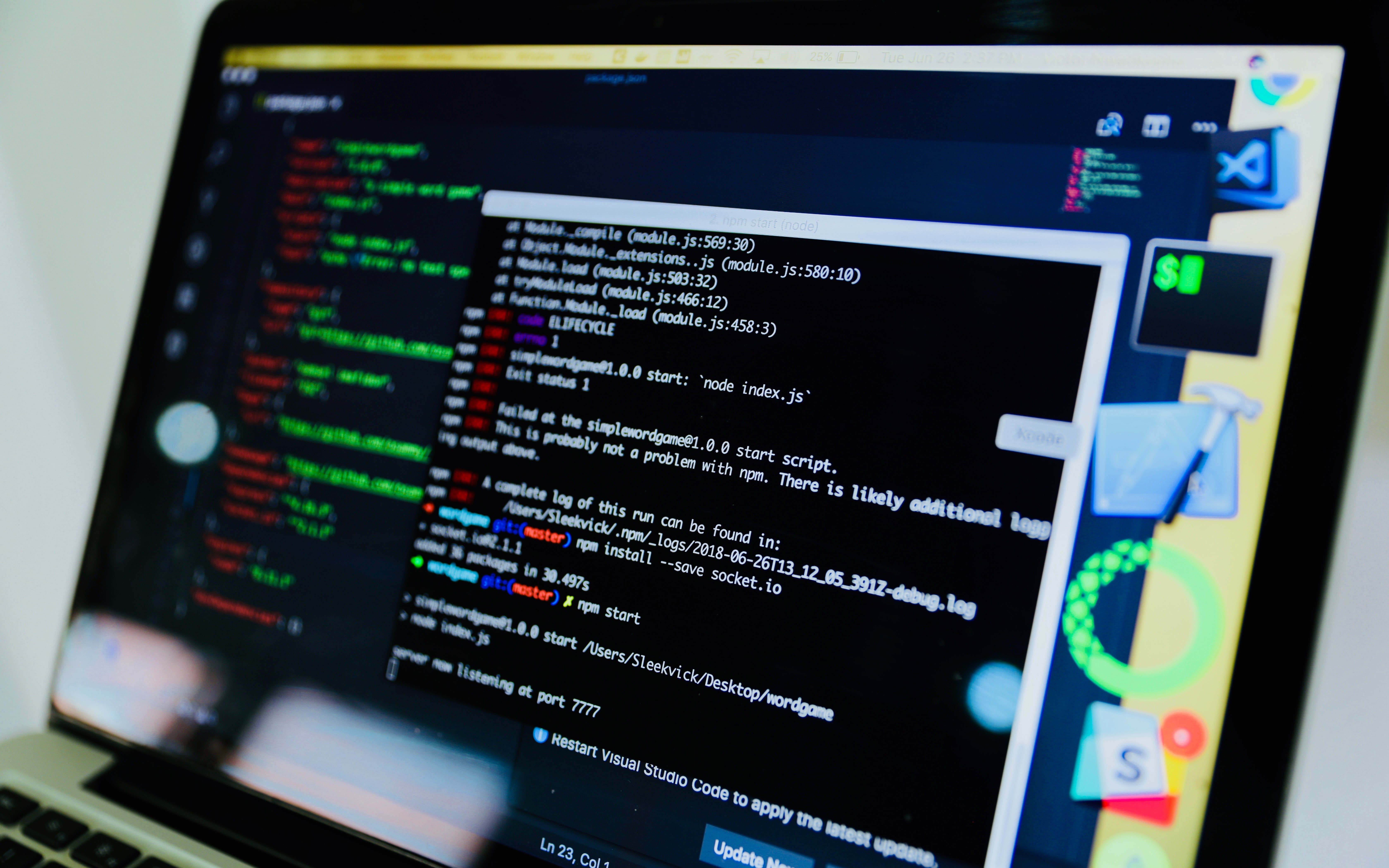

ソフトウェア開発の革命:AIとコードのダイナミックなデュオ

「AIとコードの融合により、タスクの自動化、コードの品質向上、開発の加速化によってソフトウェア開発が変革されます」

LangChainとLLMsのための非同期処理

「この記事では、LangChainを使用してLLMに非同期呼び出しを行い、長いワークフローを処理する方法について説明します実際のコードを使用した例を通じて、順次実行と比較しながら進めます...」

fairseqのwmt19翻訳システムをtransformersに移植する

Stas Bekmanさんによるゲストブログ記事 この記事は、fairseq wmt19翻訳システムがtransformersに移植された方法をドキュメント化する試みです。 私は興味深いプロジェクトを探していて、Sam Shleiferさんが高品質の翻訳者の移植に取り組んでみることを提案してくれました。 私はFacebook FAIRのWMT19ニュース翻訳タスクの提出に関する短い論文を読み、オリジナルのシステムを試してみることにしました。 最初はこの複雑なプロジェクトにどう取り組むか分からず、Samさんがそれを小さなタスクに分解するのを手伝ってくれました。これが非常に助けになりました。 私は、両方の言語を話すため、移植中に事前学習済みのen-ru / ru-enモデルを使用することを選びました。ドイツ語は話せないので、de-en / en-deのペアで作業するのははるかに難しくなります。移植プロセスの高度な段階で出力を読んで意味を理解することで翻訳の品質を評価できることは、多くの時間を節約することができました。 また、最初の移植をen-ru / ru-enモデルで行ったため、de-en / en-deモデルが統合されたボキャブラリを使用していることに全く気づいていませんでした。したがって、2つの異なるサイズのボキャブラリをサポートするより複雑な作業を行った後、統合されたボキャブラリを動作させるのは簡単でした。 手抜きしましょう 最初のステップは、もちろん手抜きです。大きな努力をするよりも小さな努力をする方が良いです。したがって、fairseqへのプロキシとして機能し、transformersのAPIをエミュレートする数行のコードで短いノートブックを作成しました。 もし基本的な翻訳以外のことが必要なければ、これで十分でした。しかし、もちろん、完全な移植を行いたかったので、この小さな勝利の後、より困難な作業に移りました。 準備 この記事では、~/portingの下で作業していると仮定し、したがってこのディレクトリを作成します:…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.