Learn more about Search Results huggingface.co - Page 21

- You may be interested

- 「アマゾンが「Q」という業務に合わせてカ...

- 「Google.orgの新しい助成金は、永久凍土...

- UCサンディエゴとクアルコムの研究者たち...

- 「データ注釈は機械学習の成功において不...

- 「Spring Bootを使用して自分自身のChatGP...

- ChatGPT’ の邪悪な双子 ‘Worm...

- 「AIは本当に面接に合格するのを助けてく...

- T5 テキストからテキストへのトランスフォ...

- 「NPって何? 最適化問題の複雑性タイプを...

- プリンストンの研究者たちは、革新的な軽...

- LMQL — 言語モデル用のSQL

- 検索における生成AIが120以上の新しい国と...

- 『基礎に戻る週間2 データベース、SQL、デ...

- マイクロソフトの研究者がKOSMOS-2を紹介...

- 『過学習から卓越へ:正則化の力を活用する』

私たちの新しいコンテンツガイドラインとポリシーをお知らせします

当社は、オープンで協力的かつ責任ある機械学習の推進を目指すコミュニティ主導のプラットフォームとして、私たちのコミュニティ全体に対して歓迎の場を維持しサポートすることを喜んでいます!この目標をサポートするために、私たちはコンテンツポリシーを更新しました。 完全なドキュメントに精通することをお勧めします。その間、このブログポストでは、私たちのコンテンツポリシーの更新の背景、理論の概要、および価値観について概説します。両方のリソースを参照することで、当社プラットフォームのコンテンツに対する期待と目標を包括的に理解することができます。 機械学習コンテンツのモデレーション 機械学習アーティファクトのモデレーションには新たな課題が生じます。静的なコンテンツよりも、人工知能システムやモデルの開発・展開に関連するリスクは、潜在的な損害を予測するために詳細な分析と包括的なアプローチが必要です。そのため、この新しいコンテンツポリシーの起草には、私たちの異なるメンバーや専門家からの努力が集約され、責任ある開発と展開をどのように実現するかについて明確化するために、全社的な視点と詳細な情報が必要とされています。 さらに、AIと機械学習の分野が拡大するにつれ、ユースケースとアプリケーションの多様性も増えています。これにより、最新の研究、倫理的考慮事項、ベストプラクティスについて常に最新情報にアップデートする必要があります。そのため、ユーザーの協力を促進することも、当社プラットフォームの持続可能性にとって重要です。具体的には、コミュニティタブなどのコミュニティ機能を通じて、リポジトリの著者、ユーザー、組織、および私たちのチームの間での協力的なソリューションを奨励・促進しています。 同意を基本とする価値観 機械学習システムの開発と使用において、人々の権利を尊重することを優先するため、技術と法律の進展に対応する前向きな視点を持ちます。機械学習によって可能になる情報処理の新たな方法は、AIの分野や規制の範囲で、人々の作業、イメージ、プライバシーに関する権利について全く新しい問題を提起しています。これらの議論の中心にあるのは、人々の権利をどのように具体化すべきかという点です。私たちはここで一つのアプローチを提供しています。 この変化し続ける法的状況の中で、害を引き起こすことを避けるために「同意」の本質的な価値を強調することがますます重要になっています。それにより、個人の主体性と主観的な経験に焦点を当てることができます。このアプローチは、同意に対する先見性とより共感的な理解をサポートするだけでなく、文化的および文脈的要素に対処するための積極的な措置を奨励します。特に、私たちのコンテンツポリシーは、ユーザーが見るコンテンツ、人々のアイデンティティと表現に関連する同意に対処することを目指しています。 このプラットフォームでの人々の同意と経験に対する配慮は、コミュニティコンテンツやユーザーの行動にも及びます。安全で歓迎する環境を維持するために、ユーザーやHugging Faceスタッフに対して攻撃的または嫌がらせの言葉を許容しません。ユーザーとリポジトリの著者の間の潜在的な紛争に対しては、必要な場合にのみ介入し、協力的な解決策の促進に重点を置いています。透明性を促進するために、私たちはコミュニティタブ内での公開討論を奨励しています。 私たちのアプローチは、私たちのユーザーの貴重な意見によって可能になり、改善を常に追求することを約束しています。ご質問やご心配事がある場合は、[email protected]までお問い合わせください。 オープンなAIとMLの協力を奨励する、友好的で支援的なコミュニティを築くために力を合わせましょう!皆さんとともに、誰もが歓迎される環境で大きな進歩を遂げることができます。

iPhone、iPad、およびMacでのCore MLによる高速で安定した拡散

先週、WWDC’23(Apple Worldwide Developers Conference)が開催されました。キーノート中のVision Proの発表に焦点が当てられましたが、それだけではありません。毎年のように、WWDC週はAppleのオペレーティングシステムとフレームワークの新機能について深く掘り下げる200以上の技術セッションが詰まっています。今年は特に、圧縮と最適化のためのCore MLの変更に興奮しています。これらの変更により、Stable Diffusionなどのモデルの実行が高速化され、メモリ使用量も少なくなります!一例として、12月にiPhone 13で実行したテストと現在の6ビットパレット化を使用した速度の比較を考えてみましょう: 12月のiPhoneでのStable Diffusionと現在の6ビットパレット化 目次 新しいCore MLの最適化 量子化および最適化されたStable Diffusionモデルの使用 カスタムモデルの変換と最適化 6ビット未満の使用 結論 新しいCore MLの最適化 Core MLは、Appleのデバイス内で効率的に機械学習モデルを実行するための成熟したフレームワークであり、CPU、GPU、およびMLタスクに特化したニューラルエンジンなど、Appleデバイスのすべてのコンピューティングハードウェアを活用します。デバイス上での実行は、Stable Diffusionや大規模な言語モデルの人気によって引き起こされた非常に興味深い時期を迎えています。多くの人々がこれらのモデルをさまざまな理由でハードウェア上で実行したいと考えており、利便性やプライバシー、APIのコスト削減などがその理由です。自然に、多くの開発者がデバイス上でこれらのモデルを効率的に実行する方法を探求し、新しいアプリやユースケースを作成しています。この目標を達成するためのCore MLの改善は、コミュニティにとって大きなニュースです!…

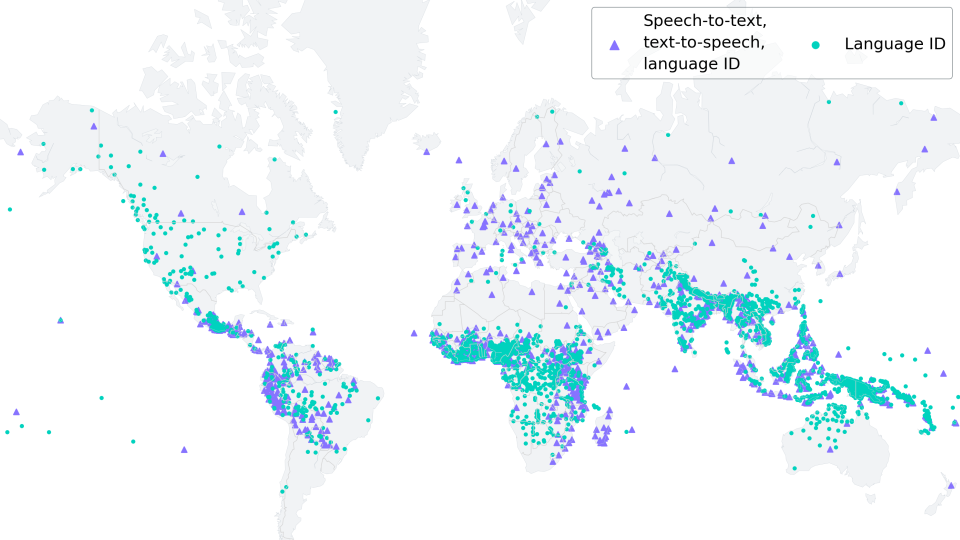

低リソースASRのためのMMSアダプターモデルの微調整

新しい(06/2023):このブログ記事は、「多言語ASRでのXLS-Rの微調整」に強く触発され、それの改良版として見なされるものです。 Wav2Vec2は、自動音声認識(ASR)のための事前学習モデルであり、Alexei Baevski、Michael Auli、およびAlex Conneauによって2020年9月にリリースされました。Wav2Vec2の強力なパフォーマンスが、ASRの最も人気のある英語データセットであるLibriSpeechで示された直後、Facebook AIはWav2Vec2の2つのマルチリンガルバージョンであるXLSRとXLM-Rを発表しました。これらのモデルは128の言語で音声を認識することができます。XLSRはクロスリンガル音声表現を意味し、モデルが複数の言語で有用な音声表現を学習する能力を指します。 Meta AIの最新リリースであるMassive Multilingual Speech(MMS)(Vineel Pratap、Andros Tjandra、Bowen Shiなどによる)は、マルチリンガル音声表現を新たなレベルに引き上げています。1,100以上の話されている言語が識別、転写、生成され、さまざまな言語識別、音声認識、テキスト読み上げのチェックポイントがリリースされます。 このブログ記事では、MMSのアダプタートレーニングが、わずか10〜20分の微調整後でも驚くほど低い単語エラーレートを達成する方法を示します。 低リソース言語の場合、私たちは「多言語ASRでのXLS-Rの微調整」と同様にモデル全体を微調整するのではなく、MMSのアダプタートレーニングの使用を強くお勧めします。 私たちの実験では、MMSのアダプタートレーニングはメモリ効率がよく、より堅牢であり、低リソース言語に対してはより優れたパフォーマンスを発揮することがわかりました。ただし、VoAGIから高リソース言語への場合は、Adapterレイヤーの代わりにモデル全体のチェックポイントを微調整する方が依然として有利です。 世界の言語多様性の保存 https://www.ethnologue.com/によると、約3000の「生きている」言語のうち、40%、つまり約1200の言語が、話者が減少しているために危機に瀕しています。このトレンドはますますグローバル化する世界で続くでしょう。 MMSは、アリ語やカイビ語など、絶滅危惧種である多くの言語を転写することができます。将来的には、MMSは、残された話者が母国語での記録作成やコミュニケーションをサポートすることで、言語を生き続けるために重要な役割を果たすことができます。 1000以上の異なる語彙に適応するために、MMSはアダプターを使用します。アダプターレイヤーは言語間の知識を活用し、モデルが別の言語を解読する際に役立つ役割を果たします。 MMSの微調整 MMSの非監視チェックポイントは、1400以上の言語で300万〜10億のパラメータを持つ、50万時間以上のオーディオで事前学習されました。 事前学習のためのモデルサイズ(300Mおよび1B)の事前学習のみのチェックポイントは、🤗 Hubで見つけることができます:…

Hugging Faceのパネル

私たちは、PanelとHugging Faceのコラボレーションを発表できることを喜んでいます!🎉 Hugging Face SpacesにPanelのテンプレートを統合しました。これにより、Panelアプリを簡単に構築し、Hugging Face上で簡単にデプロイすることができます。 Panelは何を提供していますか? Panelは、Pythonで強力なツール、ダッシュボード、複雑なアプリケーションを簡単に構築できるオープンソースのPythonライブラリです。PyDataエコシステム、パワフルなデータテーブルなどがすぐに利用できるようになっています。高レベルのリアクティブAPIと低レベルのコールバックベースのAPIにより、探索的なアプリケーションを素早く構築することができます。また、複雑なマルチページアプリケーションや豊富な相互作用を持つアプリケーションを構築することも制限されません。PanelはHoloVizエコシステムの一員であり、データ探索ツールの連携エコシステムへのゲートウェイです。Panelは、他のHoloVizツールと同様に、NumFocusがスポンサーとなっており、AnacondaとBlackstoneからのサポートを受けています。 以下は、私たちのユーザーが価値を見出しているPanelのいくつかの注目すべき機能です。 Panelは、Matplotlib、Seaborn、Altair、Plotly、Bokeh、PyDeck、Vizzuなど、さまざまなプロットライブラリに広範なサポートを提供しています。 すべての相互作用は、Jupyterとスタンドアロンのデプロイメントで同じように機能します。Panelは、Jupyterノートブックからダッシュボードにコンポーネントをシームレスに統合することができ、データ探索と結果の共有の間でスムーズな移行を実現します。 Panelは、複雑なマルチページアプリケーション、高度な相互作用機能、大規模データセットの可視化、リアルタイムデータのストリーミングを構築することができます。 PyodideとWebAssemblyとの統合により、PanelアプリケーションをWebブラウザでシームレスに実行することができます。 Hugging FaceでPanelアプリを構築する準備はできましたか?Hugging Faceのデプロイメントドキュメントをチェックして、このボタンをクリックして旅を始めましょう: 🌐 コミュニティに参加しましょう Panelコミュニティは活気があり、サポートが充実しており、経験豊富な開発者やデータサイエンティストが知識を共有したり、助け合ったりすることを楽しみにしています。以下の方法で参加し、私たちとつながりましょう: Discord Discourse Twitter LinkedIn Github

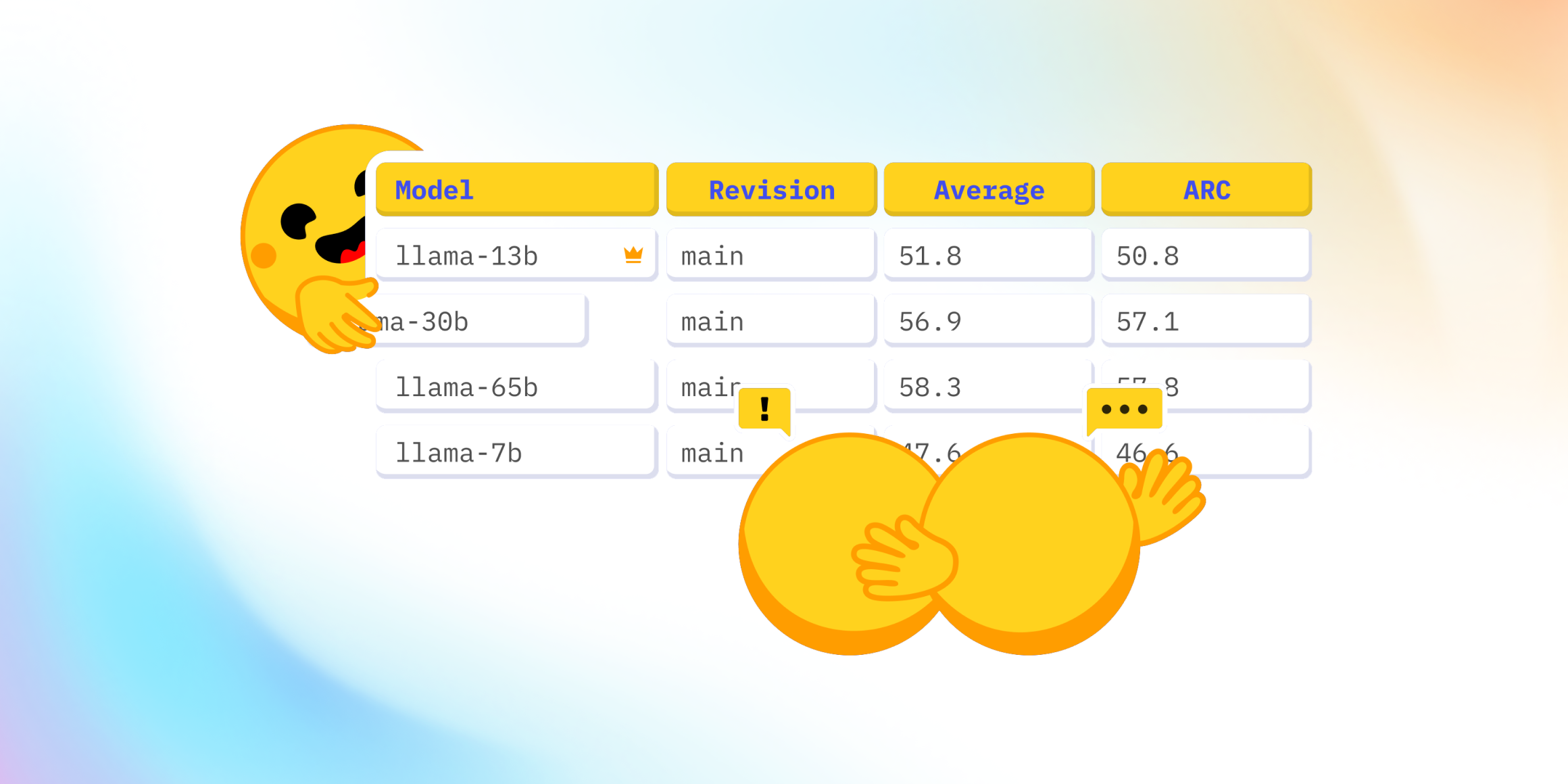

Open LLMのリーダーボードはどうなっていますか?

最近、Falcon 🦅のリリースおよびOpen LLM Leaderboardへの追加に関して、Twitter上で興味深い議論が起こりました。Open LLM Leaderboardは、オープンアクセスの大規模言語モデルを比較する公開のリーダーボードです。 この議論は、リーダーボードに表示されている4つの評価のうちの1つであるMassive Multitask Language Understanding(略称:MMLU)のベンチマークを中心に展開されました。 コミュニティは、リーダーボードの現在のトップモデルであるLLaMAモデル 🦙のMMLU評価値が、公開されたLLaMa論文の値よりも著しく低いことに驚きました。 そのため、私たちは何が起こっているのか、そしてそれを修正する方法を理解するために深堀りしました 🕳🐇 私たちとのこの冒険の旅において、私たちはLLaMAの評価に協力した素晴らしい@javier-m氏、そしてFalconチームの素晴らしい@slippylolo氏と話し合いました。もちろん、以下のエラーは彼らではなく、私たちに帰すべきです! この冒険の旅の中で、オンラインや論文で見る数値を信じるべきかどうか、モデルを単一の評価で評価する方法について多くのことを学ぶことができます。 準備はいいですか?それでは、シートベルトを締めましょう、出発します 🚀。 Open LLM Leaderboardとは何ですか? まず、Open LLM Leaderboardは、実際にはEleutherAI非営利AI研究所によって作成されたオープンソースのベンチマークライブラリEleuther…

倫理と社会ニュースレター#4:テキストから画像へのモデルにおけるバイアス

要約: テキストから画像へのモデルのバイアスを評価するためにより良い方法が必要です はじめに テキストから画像(TTI)生成は最近のトレンドであり、数千のTTIモデルがHugging Face Hubにアップロードされています。各モダリティは異なるバイアスの影響を受ける可能性がありますが、これらのモデルのバイアスをどのように明らかにするのでしょうか?このブログ投稿では、TTIシステムのバイアスの源泉、それらに対処するためのツールと潜在的な解決策について、私たち自身のプロジェクトと広範なコミュニティのものを紹介します。 画像生成における価値観とバイアスのエンコード バイアスと価値観には非常に密接な関係があります。特に、これらが与えられたテキストから画像モデルのトレーニングやクエリに埋め込まれている場合、この現象は生成された画像に大きな影響を与えます。この関係は、広範なAI研究分野で知られており、それに対処するためのかなりの努力が進行中ですが、特定のモデルで進化する人々の価値観を表現しようとする複雑さは依然として存在しています。これは、適切に明らかにし、対処するための持続的な倫理的な課題を提起します。 たとえば、トレーニングデータが主に英語である場合、それはおそらく西洋の価値観を伝えています。その結果、異なる文化や遠い文化のステレオタイプな表現が得られます。以下の例では、同じプロンプト「北京の家」に対してERNIE ViLG(左)とStable Diffusion v 2.1(右)の結果を比較すると、この現象が顕著に現れます: バイアスの源泉 近年、自然言語処理(Abidら、2021年)およびコンピュータビジョン(BuolamwiniおよびGebru、2018年)の両方の単一モダリティのAIシステムにおけるバイアス検出に関する重要な研究が行われています。MLモデルは人々によって構築されるため、すべてのMLモデル(そして技術全般)にはバイアスが存在します。これは、画像の中で特定の視覚的特性が過剰または過少に表現される(たとえば、オフィスワーカーのすべての画像にネクタイがある)ことや、文化的および地理的なステレオタイプの存在(たとえば、白いドレスとベールを着た花嫁のすべての画像、代表的な花嫁のイメージである赤いサリーの花嫁など)が現れることで現れます。AIシステムは広く異なるセクターやツール(例:Firefly、Shutterstock)に展開される社会技術的なコンテキストで展開されるため、既存の社会的なバイアスや不平等を強化する可能性があります。以下にバイアスの源泉の非徹底的なリストを示します: トレーニングデータのバイアス:テキストから画像への変換のための人気のあるマルチモーダルデータセット(たとえば、テキストから画像へのLAION-5B、画像キャプショニングのMS-COCO、ビジュアルクエスチョンアンサリングのVQA v2.0など)には、多数のバイアスや有害な関連が含まれていることが判明しています(Zhaoら、2017年、PrabhuおよびBirhane、2021年、Hirotaら、2022年)。これらのデータセットでトレーニングされたモデルには、画像生成の多様性の欠如や、文化やアイデンティティグループの共通のステレオタイプが永続化するという初期の結果がHugging Face Stable Biasプロジェクトから示されています。たとえば、CEO(右)とマネージャー(左)のDall-E 2の生成結果を比較すると、両方とも多様性に欠けていることがわかります: 事前トレーニングデータのフィルタリングにおけるバイアス:モデルのトレーニングに使用される前に、データセットに対して何らかの形のフィルタリングが行われることがよくあります。これにより、異なるバイアスが導入されます。たとえば、Dall-E 2の作者たちは、トレーニングデータのフィルタリングが実際にバイアスを増幅することを発見しました。これは、既存のデータセットが女性をより性的な文脈で表現するというバイアスや、使用されるフィルタリング手法の固有のバイアスに起因する可能性があると彼らは仮説を立てています。 推論におけるバイアス:Stable…

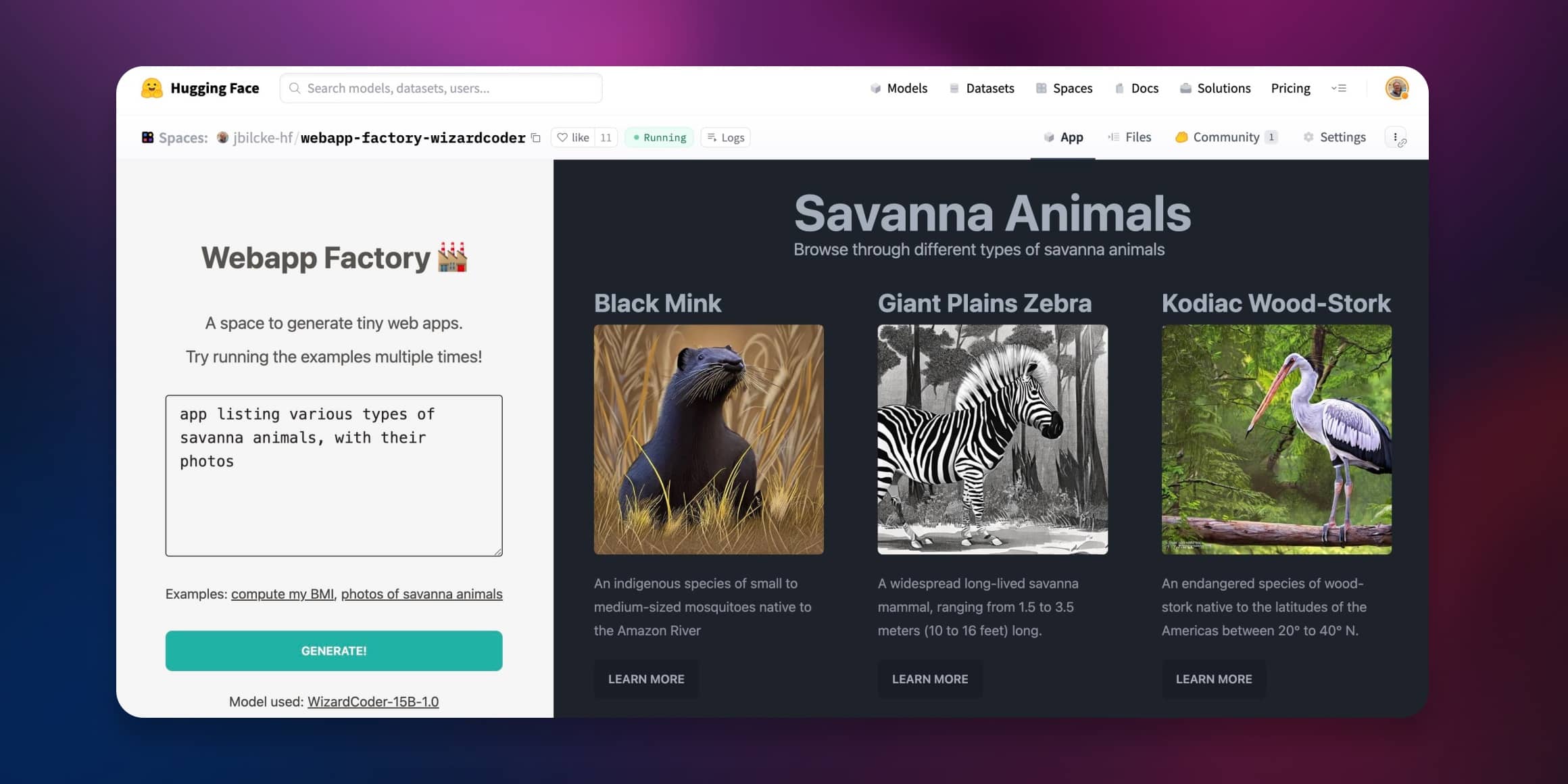

オープンなMLモデルを使用してWebアプリジェネレータを作成する

コード生成モデルがますます一般公開されるようになると、以前には想像もできなかった方法でテキストからウェブやアプリへの変換が可能になりました。 このチュートリアルでは、コンテンツのストリーミングとレンダリングを一度に行うことで、AIウェブコンテンツ生成への直接的なアプローチを紹介します。 ここでライブデモを試してみてください! → Webapp Factory NodeアプリでのLLMの使用方法 AIやMLに関連するすべてのことをPythonで行うと思われがちですが、ウェブ開発コミュニティではJavaScriptとNodeに大いに依存しています。 このプラットフォームで大きな言語モデルを使用する方法をいくつか紹介します。 ローカルでモデルを実行する JavaScriptでLLMを実行するためのさまざまなアプローチがあります。ONNXを使用したり、コードをWASMに変換して他の言語で書かれた外部プロセスを呼び出したりする方法などがあります。 これらの技術のいくつかは、次のような使いやすいNPMライブラリとして利用できます: コード生成をサポートするtransformers.jsなどのAI/MLライブラリの使用 ブラウザ用のllama-node(またはweb-llm)など、専用のLLMライブラリの使用 Pythoniaなどのブリッジを介してPythonライブラリを使用 ただし、このような環境で大きな言語モデルを実行すると、リソースをかなり消費することがあります。特にハードウェアアクセラレーションを使用できない場合はさらにリソースが必要です。 APIを使用する 現在、さまざまなクラウドプロバイダが言語モデルの使用を提案しています。以下はHugging Faceの提供するオプションです: コミュニティから小さなモデルからVoAGIサイズのモデルまで使用できる無料の推論API。 より高度で本番向けの推論エンドポイントAPIで、より大きなモデルやカスタム推論コードが必要な方向けのもの。 これらの2つのAPIは、NPM上のHugging Face推論APIライブラリを使用してNodeから利用できます。 💡…

Hugging Faceの推論エンドポイントを使用してLLMをデプロイする

オープンソースのLLMであるFalcon、(オープン-)LLaMA、X-Gen、StarCoder、またはRedPajamaは、ここ数ヶ月で大きく進化し、ChatGPTやGPT4などのクローズドソースのモデルと特定のユースケースで競合することができるようになりました。しかし、これらのモデルを効率的かつ最適化された方法で展開することはまだ課題です。 このブログ投稿では、モデルの展開を容易にするマネージドSaaSソリューションであるHugging Face Inference EndpointsにオープンソースのLLMを展開する方法と、応答のストリーミングとエンドポイントのパフォーマンステストの方法を紹介します。さあ、始めましょう! Falcon 40Bの展開方法 LLMエンドポイントのテスト JavaScriptとPythonでの応答のストリーミング 始める前に、Inference Endpointsについての知識をおさらいしましょう。 Hugging Face Inference Endpointsとは何ですか Hugging Face Inference Endpointsは、本番環境での機械学習モデルの展開を簡単かつ安全な方法で提供します。Inference Endpointsを使用することで、開発者やデータサイエンティストはインフラストラクチャの管理をせずにAIアプリケーションを作成できます。展開プロセスは数回のクリックで簡略化され、オートスケーリングによる大量のリクエストの処理、ゼロスケールへのスケールダウンによるインフラストラクチャのコスト削減、高度なセキュリティの提供などが可能となります。 LLM展開における最も重要な機能のいくつかは以下の通りです: 簡単な展開: インフラストラクチャやMLOpsの管理を必要とせず、本番用のAPIとしてモデルを展開できます。 コスト効率:…

Transformers.jsを使用してMLを搭載したウェブゲームの作成

このブログ記事では、ブラウザ上で完全に動作するリアルタイムのMLパワードWebゲーム「Doodle Dash」を作成した方法を紹介します(Transformers.jsのおかげで)。このチュートリアルの目的は、自分自身でMLパワードのWebゲームを作成するのがどれだけ簡単かを示すことです… ちょうどOpen Source AI Game Jam(2023年7月7日-9日)に間に合います。まだ参加していない場合は、ぜひゲームジャムに参加してください! ビデオ:Doodle Dashデモビデオ クイックリンク デモ:Doodle Dash ソースコード:doodle-dash ゲームジャムに参加:Open Source AI Game Jam 概要 始める前に、作成する内容について話しましょう。このゲームは、GoogleのQuick, Draw!ゲームに触発されており、単語とニューラルネットワークが20秒以内にあなたが描いているものを推測するというものです(6回繰り返し)。実際には、彼らのトレーニングデータを使用して独自のスケッチ検出モデルを訓練します!オープンソースは最高ですよね? 😍 このバージョンでは、1つのプロンプトずつできるだけ多くのアイテムを1分間で描くことができます。モデルが正しいラベルを予測した場合、キャンバスがクリアされ、新しい単語が与えられます。タイマーが切れるまでこれを続けてください!ゲームはブラウザ内でローカルに実行されるため、サーバーの遅延について心配する必要はありません。モデルはあなたが描くと同時にリアルタイムの予測を行うことができます… 🤯…

SQLクエリにおいてGPT-4よりも優れたもの:NSQL(完全なオープンソース)

ChatGPTや他のLLM(Language Model)を使用してSQLクエリを生成しようとしたことがある方は手を挙げてください私は試してみましたし、現在も試しています!しかし、新しいオープンソースのファミリーが登場したことをお伝えできるのがとても嬉しいです...

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.