Learn more about Search Results A - Page 218

- You may be interested

- 「生産性の向上のヒント、データキャリア...

- 異なる暗号通貨間のブリッジ

- 「接続の最適化:グラフ内の数理最適化」

- インフォグラフィックスでデータ可視化を...

- 「Llama 2をローカルでダウンロードしてア...

- 「NYUとGoogle AIの研究者が、機械学習の...

- BLOOMトレーニングの技術背後

- ビジネスにおける機械学習オペレーション...

- 中国の研究者が、脳損傷セグメンテーショ...

- METAのHiera:複雑さを減らして精度を高める

- 「データの視覚化を即座に改善する4つの簡...

- 「交通バスのカメラを使用して交通を監視...

- マーク外:AI進捗競争におけるメトリクス...

- 「Streamlitを使用してナンバープレート認...

- Inflection AIは、テックの巨人や業界の巨...

TensorRT-LLMとは、NVIDIA Tensor Core GPU上の最新のLLMにおいて推論パフォーマンスを高速化し最適化するためのオープンソースライブラリです

人工知能(AI)の大規模言語モデル(LLM)は、テキストを生成したり、言語を翻訳したり、さまざまな形式の創造的な素材を書いたり、質問に役立つ回答を提供したりすることができます。ただし、LLMにはいくつかの問題があります。例えば、バイアスが含まれる可能性のある大規模なテキストやコードのデータセットで訓練されていることです。LLMが生成する結果には、これらの偏見が反映され、否定的なステレオタイプを強化し、誤った情報を広める可能性があります。時には、LLMは現実に基づかない文章を生成することもあります。これらの体験を幻覚と呼びます。幻覚的なテキストを読むことで、誤解や誤った推論が生じる可能性があります。LLMの内部の動作原理を理解するには、作業が必要です。そのため、医療や金融など、オープンさと責任が重要な文脈で問題が生じる可能性があります。LLMのトレーニングと展開には、大量の計算能力が必要です。これにより、多くの中小企業や非営利団体にはアクセスできなくなる可能性があります。スパム、フィッシングメール、フェイクニュースなど、悪情報がLLMを使用して生成されることがあります。これによってユーザーや企業が危険にさらされる可能性があります。 NVIDIAの研究者は、Meta、Anyscale、Cohere、Deci、Grammarly、Mistral AI、MosaicML(現在はDatabricksの一部)、OctoML、Tabnine、Together AIなどの業界のリーダーと協力し、LLMの推論の高速化とパーフェクト化に取り組んでいます。これらの改善は、近日公開予定のオープンソースNVIDIA TensorRT-LLMソフトウェアバージョンに含まれます。TensorRT-LLMは、NVIDIAのGPUを利用して最適化されたカーネル、前処理および後処理フェーズ、およびマルチGPU/マルチノード通信プリミティブを提供するディープラーニングコンパイラです。開発者は、C++やNVIDIA CUDAの詳しい知識を必要とせずに、新しいLLMを試行することができ、優れたパフォーマンスと迅速なカスタマイズオプションを提供します。オープンソースのモジュラーなPython APIを備えたTensorRT-LLMは、LLMの開発において新しいアーキテクチャや改良を定義、最適化、実行することを容易にします。 NVIDIAの最新のデータセンターGPUを活用することで、TensorRT-LLMはLLMのスループットを大幅に向上させながら、経費を削減することを目指しています。プロダクションにおける推論のためのLLMの作成、最適化、実行には、TensorRT Deep Learning Compiler、FasterTransformerからの最適化されたカーネル、前処理および後処理、マルチGPU/マルチノード通信をカプセル化した、わかりやすいオープンソースのPython APIが提供されます。 TensorRT-LLMにより、より多様なLLMアプリケーションが可能になります。MetaのLlama 2やFalcon 180Bなどの700億パラメータのモデルが登場した現在、定型的なアプローチはもはや実用的ではありません。このようなモデルのリアルタイムパフォーマンスは、通常、マルチGPUの構成や複雑な調整に依存しています。TensorRT-LLMは、重み行列をデバイス間で分散させるテンソル並列処理を提供することで、このプロセスを効率化し、開発者が手動で断片化や再配置を行う必要をなくします。 また、LLMアプリケーションには非常に変動するワークロードが特徴であるため、フライト中のバッチ最適化は効果的に管理するための注目すべき機能です。この機能により、質問応答型チャットボットや文書要約などのタスクにおいて、動的な並列実行が可能となり、GPUの利用率を最大限に引き出すことができます。AIの実装の規模と範囲の拡大を考慮すると、企業は所有コストの削減を期待できます。 性能面でも驚異的な結果が出ています。TensorRT-LLMを使用した場合、TensorRT-LLMを使用しない場合やA100と比較した場合、NVIDIA H100を使用した場合の記事要約などのタスクで、8倍の性能向上が見られます。 図1. GPT-J-6B A100とTensorRT-LLMを使用したH100の比較 | テキスト要約、可変長の入出力、CNN /…

マイクロソフトの研究者が「InstructDiffusion:コンピュータビジョンタスクを人間の指示に合わせるための包括的かつ汎用的なAIフレームワーク」というタイトルで発表しました

マイクロソフトリサーチアジアの研究者たちは、適応性のある汎用的なビジョンモデルに向けた画期的な進展であるInstructDiffusionを発表しました。この革新的なフレームワークは、多様なビジョンタスクに統一されたインターフェースを提供することで、コンピュータビジョンの領域を革命化します。論文「InstructDiffusion: A Generalist Modeling Interface for Vision Tasks」では、さまざまなビジョンアプリケーションをシームレスに処理するモデルが紹介されています。 InstructDiffusionの核心には、直感的な画像操作プロセスとしてのビジョンタスクの形成があります。カテゴリや座標などの事前定義された出力空間に依存する従来の方法とは異なり、InstructDiffusionは柔軟なピクセル空間で操作を行い、人間の知覚により近づけます。 このモデルは、ユーザーが提供するテキスト指示に基づいて入力画像を変更するように設計されています。たとえば、「男性の右目を赤で囲んでください」という指示は、キーポイント検出などのタスクにおいてモデルを強化します。同時に、「右側の犬に青いマスクを適用してください」という指示はセグメンテーションの目的に役立ちます。 このフレームワークの基礎となるのは、ピクセル出力を生成するデノイジング拡散確率モデル(DDPM)です。トレーニングデータは、指示、ソース画像、目標出力画像の三つ組で構成されます。このモデルは、RGB画像、バイナリマスク、キーポイントという3つの主な出力タイプに対応しています。これには、セグメンテーション、キーポイント検出、画像編集、および強化など、さまざまなビジョンタスクが含まれます。 キーポイント検出 a) クジラの右目に黄色い円を作成します。(b) 車のロゴに青い円を付けます。 セグメンテーション a) 鏡の中の猫のピクセルを青くし、他の部分は変更しません。(b) 影のピクセルを青くし、他のピクセルの現在の外観を維持します。 画像編集 モデルによって生成された画像の結果 低レベルタスク InstructDiffusionは、画像のぼやけ除去、ノイズ除去、ウォーターマークの削除などの低レベルのビジョンタスクにも適用できます。 実験により、InstructDiffusionは個々のタスクで専門的なモデルを凌駕する能力を示しました。しかし、真の驚異は、一部のタスクにおいてトレーニング中に遭遇しなかったタスクにも適応する能力です。これは、人工一般知能(AGI)にしばしば関連付けられる特徴であり、コンピュータビジョンのための統一された柔軟なフレームワークに向けた重要な進展です。…

PyTorch FSDPを使用してLlama 2 70Bのファインチューニング

はじめに このブログ記事では、PyTorch FSDPと関連するベストプラクティスを使用して、Llama 2 70Bを微調整する方法について説明します。Hugging Face Transformers、Accelerate、およびTRLを活用します。また、AccelerateをSLURMと一緒に使用する方法も学びます。 Fully Sharded Data Parallelism(FSDP)は、オプティマイザの状態、勾配、およびパラメータをデバイス間でシャードするパラダイムです。フォワードパスでは、各FSDPユニットが完全な重みを取得するための全ギャザー操作を実行し、計算が行われた後に他のデバイスからのシャードを破棄します。フォワードパスの後、ロスが計算され、バックワードパスが行われます。バックワードパスでは、各FSDPユニットが完全な重みを取得するための全ギャザー操作を実行し、ローカルな勾配を取得するための計算が行われます。これらのローカルな勾配は平均化され、リダクション-スキャッタ操作を介してデバイス間でシャードされるため、各デバイスは自身のシャードのパラメータを更新することができます。PyTorch FSDPの詳細については、次のブログ記事を参照してください:PyTorch Fully Sharded Data Parallelを使用した大規模モデルトレーニングの加速。 (出典: リンク) 使用されたハードウェア ノード数:2。最小要件は1です。ノードあたりのGPU数:8。GPUタイプ:A100。GPUメモリ:80GB。ノード内接続:NVLink。ノードあたりのRAM:1TB。ノードあたりのCPUコア数:96。ノード間接続:Elastic Fabric Adapter。 LLaMa 70Bの微調整における課題…

Stability AIが初の日本語ビジョン言語モデルをリリース

単一かつ包括的なモデルを作成し、さまざまなユーザー定義のタスクを処理できるようにすることは、人工知能(AI)研究の分野で長い間関心を持たれてきました。これは特に「指示チューニング」という自然言語処理(NLP)において顕著であり、広範な自然言語の指示を通じて、大規模な言語モデル(LLM)を改善することにより、モデルが任意の指示を適切に実行できるようになる方法です。 その一例が「ビジョン・ランゲージ・モデル」の使用です。「ビジョン・ランゲージ・モデル」(VLM)は、テキストと画像を入力として理解することに長けた人工知能の一種です。これらは、画像のキャプション作成、ビジュアルな質問応答、ビジュアルな風景のテキスト化や言語間およびビジュアル表現の翻訳など、さまざまなビジュアルとテキストのデータの連携を必要とするタスクを実行するために使用されます。 最近、Stability AIの研究者が初の日本語ビジョン・ランゲージ・モデル、Japanese InstructBLIP Alphaのリリースを発表しました。ビジョン・ランゲージ・モデルは多く存在していますが、これが初めて日本語のテキスト記述を生成するものです。この新しいアルゴリズムは、写真に対する日本語のテキスト記述や画像に関連するクエリに対するテキスト応答を生成することを目的としています。 研究者は、モデルが特定の日本のランドマークを認識できることを強調しています。これにより、ロボット工学から観光まで、必要な地域特有の意識が提供されます。さらに、モデルはテキストと画像を処理できるため、視覚的な入力に基づくより複雑なクエリを処理できます。 研究者は、このモデルを開発するために徹底的な研究を行い、多様な指示データを使用してモデルをトレーニングしました。そのためにモデルをイメージエンコーダ、LLM、クエリトランスフォーマ(Q-Former)でトレーニングし、Q-Formerを指示チューニングのために微調整し、イメージエンコーダとLLMは凍結しました。 さらに、研究者は公開されている26のデータセットを収集し、幅広い機能と任務をカバーするように指示チューニング形式に変換しました。モデルは13のデータセットでトレーニングされ、すべての13の保持データセットで最先端のゼロショットパフォーマンスを示しました。研究者はまた、個々の下流タスクで微調整された場合も最先端のパフォーマンスを示すことを強調しました。また、指示に特化した情報要素を抽出する指示意識のあるクエリトランスフォーマも設計しました。 彼らは、「指示に応じて柔軟かつ有益な特徴を抽出する」点を示唆する「指示意識のあるビジュアル特徴抽出」という考え方を提示しました。Q-Formerが凍結された画像エンコーダから指示意識のあるビジュアル特徴を抽出するために、テキストの指示は凍結されたLLMとQ-Formerの両方に送られます。また、データセット間で学習の進行を同期させるためにバランスの取れたサンプリング技術も行いました。 研究者は、モデルの有用性と効果にもかかわらず、潜在的なバイアスや制約について注意を喚起しています。人間の判断による正確性と適切性に基づいて、応答を判断する必要があると警告しています。日本語のビジョン・ランゲージ・タスクにおけるモデルのパフォーマンスは、継続的な研究と開発により改善される必要があります。

「PyGraftに会ってください:高度にカスタマイズされた、ドメインに依存しないスキーマと知識グラフを生成する、オープンソースのPythonベースのAIツール」

データをグラフ構造で表現するための、ますます人気のある方法は、知識グラフ(KG)の使用です。KGは、s(主語)とo(目的語)という2つのグラフノード、およびそれらの間に存在する接続のタイプを記述する述語pからなるトリプル(s、p、o)のグループです。KGは、研究分野の主要なアイデアや関係性、およびこれらのアイデアや関係性がどのように相互作用するかを規定するスキーマ(オントロジーなど)によってしばしばサポートされます。KGが適用される多くの活動には、モデルのパフォーマンスを測定するための受け入れられた基準となるKGの数があります。 しかし、新たに提案されたモデルが一般化できるかどうかを判断するために、これら特定の主流のKGだけを使用することにはいくつかの問題があります。たとえば、ノードの分類において主流のデータセットは統計的特性、特に同質性を共有していることが示されています。そのため、同じ統計を持つデータセットが新しいモデルの評価に使用されます。その結果、共通のベンチマークデータセット以外では、パフォーマンスの向上への貢献は時折一貫性がありません。 同様に、既存のリンク予測データセットのいくつかはデータのバイアスを持っており、予測モデルが含めることができる多くの推論パターンを含んでいるため、楽観的すぎる評価パフォーマンスを示すことがあります。そのため、さまざまなデータセットが必要です。新しいモデルがさまざまなデータコンテキストでテストされるためには、研究者に異なるサイズと特性の架空のリアルなデータセットを作成する手段を提供することが重要です。一部のアプリケーションセクターでは、公にアクセス可能なKGが存在しないことが、わずかなKGに依存するよりも悪いです。 教育、法執行、医療などの分野では、現実の知識の収集や共有が不可能となるデータプライバシーの懸念が存在します。そのため、ドメイン指向のKGはこれらの地域ではほとんど利用できません。一方、エンジニア、実践者、研究者は通常、興味のある問題の特性について特定の考えを持っています。このような状況では、実際のKGの特性を模倣する合成KGを作成することが有利です。これら2つのコンポーネントはしばしば別々に扱われてきましたが、前述の問題がいくつかの試みを促し、スキーマとKGの合成ジェネレーターの構築に取り組んでいます。 ドメインニュートラルなKGは、確率ベースのジェネレーターによって生成することができます。これらのアプローチは、大規模なグラフを迅速に生成することでどれだけ効果的であるかに関わらず、データ生成の核心アイデアは基礎となる構造を考慮する必要があります。生成されたKGは、選択したアプリケーションセクターの実際のKGの特性を正確に模倣しない場合があります。一方、スキーマ駆動型のジェネレーターは、実世界のデータを反映したKGを作成することができます。ただし、彼らの知識によると、ほとんどの取り組みは既存のスキーマを使用して合成KGを作成することに焦点を当てています。スキーマとそれをサポートするKGの合成は、検討されていますが、まだ断片的な成功を収めていません。 彼らは、この問題を解決することを研究の目的としています。Université de LorraineとUniversité Côte d’Azurの研究者は、特に高度にカスタマイズ可能なドメインニュートラルなスキーマとKGを作成するためのPythonベースのツールであるPyGraftを紹介しています。彼らの研究の貢献は以下の通りです:彼らの知識によれば、PyGraftは、幅広いユーザー指定の基準に応じて非常に調整可能な新しいパイプラインでスキーマとKGを生成するために特に設計された唯一のジェネレーターです。特筆すべきは、作成されたリソースがドメインニュートラルであり、応用分野に関係なくベンチマークに適していることです。生成されたスキーマとKGは、拡張されたセットのRDFSとOWL要素を使用して構築され、DLリーズナーを使用してその論理的な整合性を保証します。これにより、詳細なリソースの記述と一般的なセマンティックウェブの標準に厳密に準拠することが可能となります。彼らは、使用の容易さのためにコードとドキュメント、および関連する例を公開しています。

大規模な言語モデルは本当に数学をできるのか?この人工知能AIの研究はMathGLMを紹介します:計算機なしで数学問題を解くための頑健なモデル

下流の自然言語処理(NLP)タスクにおいて、大規模言語モデル(LLMs)は非常に効果的であることが証明されています。GPT4やChatGPTなどの先駆的なモデルは、膨大な量のテキストデータで訓練され、一貫した文脈に即した応答を生成する能力を持っています。彼らのテキストの理解と生成能力により、彼らは幅広いNLPアプリケーションで非常に柔軟に使用できます。LLMsは、8桁以上の数字の掛け算や小数や分数を含む演算を正確に行うのに難しさを抱えていると一般的に考えられています。GPT-4は、さまざまなNLPタスクにおいて優れた能力を示していますが、数学的思考において同じ程度の熟練度を示すことはないかもしれません。 清華大学、TAL AI Lab、Zhipu.AIの研究者は、これらの誤った信念を払拭するために、LLMsの数学的スキルについて調査しています。彼らの最近の研究では、困難な算術演算を実行するために慎重に構築されたロバストなモデルであるMathGLMを提案しています。MathGLMは、GPT-4などの業界をリードするLLMsと比較して最高のパフォーマンスを実現しています。加算、減算、乗算、除算、冪乗などはすべて算術演算の例であり、括弧を使用して複数の種類の算術を組み合わせることも算術演算の一部です。彼らは「1つの原子操作」手順を実行し、他の手順と統合せずに単独で実行します。特に注目すべきは、MathGLMが整数、小数、分数、パーセンテージ、さらには負の数など、あらゆる数値型で算術演算を容易に実行できることです。 Ape210Kデータセットは、インターネット上から数学の問題を収集し、数学的な難しさの包括的な情報源を提供しています。このデータセットはMathGLMのトレーニングに役立ちます。オリジナルのデータセットは、明示的に計算された回答が含まれているという点でユニークです。しかし、チームは、MathGLMの回答のシンプルさによる重要な計算原則やパターンの認識の失敗の可能性があると指摘しています。 研究者たちは、ステップバイステップのアプローチを使用してApe210Kデータセットを再構築し、この可能性のある欠点を克服し、MathGLMの数学的な問題解決能力を向上させます。MathGLMは、複雑な算術計算プロセスを一連の連続的なフェーズに分解することで、数学の問題の回答を高い精度で作成できます。 広範な試験と詳細な分析により、MathGLMはGPT-4よりも優れた数学的な推論能力を持つことが示されました。オリジナルのデータセットでのファインチューニングと比較して、MathGLMの回答の正確さは42.29%の絶対的な向上を達成します。GLM-10Bからファインチューニングされた後、MathGLMは5,000件の数学の問題データセットでGPT-4に非常に近いパフォーマンスを発揮します。算術ワード問題を構成要素のステップに分解することで、MathGLMは複雑な計算プロセスを完全に理解し、基礎となる計算ルールを学び、より信頼性の高い結果を生み出すことができます。 これらの研究結果は、LLMsが困難な算術タスクを処理できないという従来の常識に大きな挑戦を与え、彼らの数学的思考能力の非凡な能力を明らかにします。

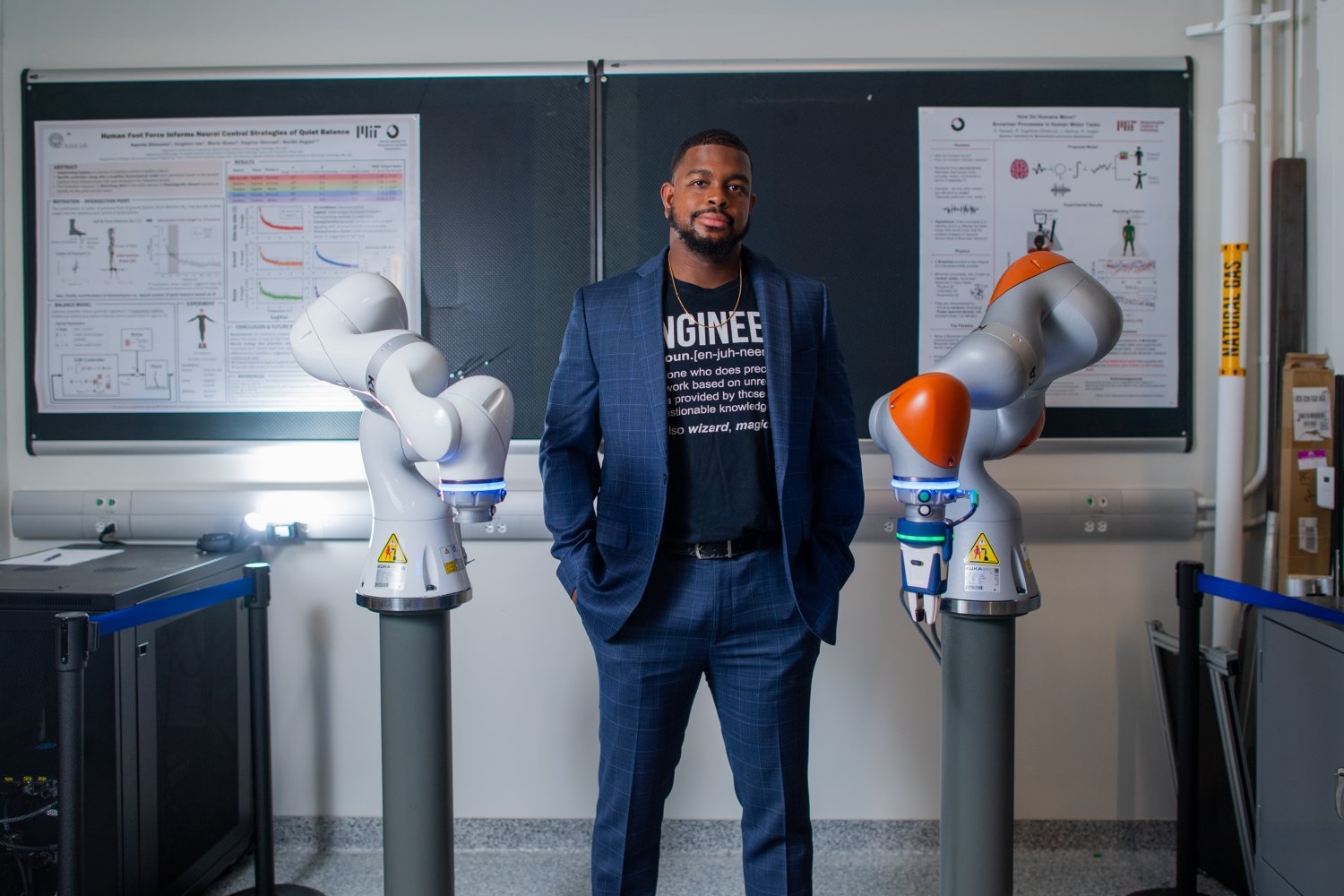

A. Michael West 医療現場における人間とロボットの相互作用の進展

「人間の運動制御を研究していない時、その大学院生は、自身が研究者として成長するのに役立ったプログラムにボランティア活動で恩返しをしています」

「ジュラシックパークへの待ち時間は終わりましたか?このAIモデルは、イメージからイメージへの変換を使用して、古代の化石を生き返らせます」

画像対画像変換(I2I)は、コンピュータビジョンと機械学習の興味深い分野であり、視覚コンテンツをシームレスに別のドメインに変換する力を持っています。この変換プロセスは、単純なピクセル値の変更を超えて、画像の基礎的な構造、意味、スタイルの深い理解を必要とします。 I2Iは、写真のアートな表現から衛星画像を地図に変換し、スケッチを写真のようなリアルな画像に変換するなど、さまざまなドメインで広範な応用が見られます。これは、生成的対抗ネットワーク(GAN)や畳み込みニューラルネットワーク(CNN)などの深層学習モデルの能力を活用しています。 従来のI2I手法は、主に写真から絵画や異なる種類の動物への変換など、ギャップが小さいドメイン間の変換に焦点を当ててきました。しかし、これらのタスクでは、変換プロセス中に大きく異なる視覚的特徴や形状に関する推論を生成する必要はありません。 それでは、I2Iの新しいアプローチであるRevive-2Iに出会いましょう。このアプローチは、スカルを生きている動物に変換するという、Skull2Animalとして知られるタスクを探求します。 Skull2Animalは、スカルを生きている動物の画像に変換するという難しいタスクです。このタスクは、新しい視覚的特徴、テクスチャ、色を生成し、対象ドメインのジオメトリに関する推論を行う必要があるため、大きな課題を提供します。 Skull2Imageタスク。出典:https://arxiv.org/abs/2308.07316 長いI2I変換の課題を克服するために、Revive-2Iは、画像の望ましい変更を説明するテキストプロンプトを使用します。これにより、現実的で検証可能な結果を生成することができます。このアプローチは、生成された画像が意図したターゲットドメインに合致するように厳しい制約を提供します。 Revive-2Iは、自然言語のプロンプトを使用してゼロショットのI2Iを行うための潜在的な拡散モデルを利用しています。 Revive-2Iは、エンコーディングとテキストによる誘導デコーディングの2つの主要なステップで構成されています。エンコーディングステップでは、ソース画像が拡散と呼ばれるプロセスを使用して潜在表現に変換されます。この潜在表現は、望ましい変更を取り込むためにノイズが加えられます。潜在空間で拡散プロセスを実行することにより、Revive-2Iはより速く効率的な変換を実現します。 Revive-2Iの概要。出典:https://arxiv.org/abs/2308.07316 Revive-2Iの最適なポイントを見つけることは容易な課題ではありませんでした。これには、前方拡散プロセスの異なるステップ数での実験が必要でした。部分的なステップを踏むことで、変換プロセスはソース画像の内容をよりよく保持しながら、ターゲットドメインの特徴を取り入れることができます。このアプローチにより、テキストプロンプトによって誘導される望ましい変更を注入しながら、より堅牢な変換が可能になります。 制約のある長いI2I変換を行う能力は、さまざまな分野で重要な意味を持ちます。たとえば、法執行機関は、スケッチに基づいて容疑者のリアルな画像を生成するためにこの技術を活用することができ、識別を支援することができます。野生生物保護活動家は、絶滅の危機に瀕した種の画像を生きている個体の画像に変換することで、気候変動の生態系や生息地への影響を示すことができます。また、古生物学者は、古代の化石をその生きている姿の画像に変換することで、新たな命を吹き込むことができます。ついにジュラシック・パークが実現しそうです。

「AIイノベーションのためのニューロエボリューションの活用」

イントロダクション ニューロエボリューションは、AIがニューラルネットワークと進化アルゴリズムを組み合わせて創造力を育む魅力的な分野です。それはAIの芸術的または音楽的な旅に似ており、傑作を描き、交響曲を作曲することができます。この記事では、ニューロエボリューションについて詳しく説明し、その仕組み、応用、重要性を探求します。これはAIの自己改善への探求であり、芽生えたアーティストが自分の技術を磨いていくのに似ています。ニューロエボリューションは、AIに進化の力を与え、問題解決能力、芸術的才能、ゲームの腕前を向上させます。この旅は、AIの成長を体現しており、人間の持続的な発展と同様に、創造的な優れた能力に向かって推進しています。 出典 – San Diego Consulting Group この記事は、データサイエンスブログマラソンの一環として公開されました。 ニューロエボリューションの理解 もしAIが生き物のように学び成長できるとしたら、それがニューロエボリューションの本質です。 進化アルゴリズム これはAIの生存ゲームのようなものです。多くのAIプレイヤーを作成し、競争させ、最も優れたものだけを残します。そして勝者は次の世代の親となります。このサイクルは、AIがタスクをマスターするまで繰り返されます。 出典 – Baeldung 初期化:初期の解のグループを作成します。 評価:問題の目標に基づいて、各解のパフォーマンスを評価します。 選択:次世代の親として最も優れた解を選択します。 交叉:親は自分の特性を組み合わせて新しい解を作ります。 突然変異:子孫に多様性を加えるためにランダムな変更を導入します。 解:数世代後、問題に対して改善された解が得られるはずです。 進化アルゴリズムは自然選択のプロセスを模倣しています。AIモデルの集団を作成し、そのパフォーマンスを評価し、最も優れたものを選択し、次世代を作り出すために交配します。 #…

「Falcon 180B あなたのコンピューターで動作しますか?」

2023年5月、アブダビのテクノロジーイノベーション研究所(TII)は、Falcon-7BとFalcon-40Bの2つの事前学習済みLLMとそれらのチャットバージョンをリリースしましたこれら2つのモデルは非常に優れた性能を示しました...

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.