Learn more about Search Results T5 - Page 19

- You may be interested

- AI倫理の役割:革新と社会的責任のバランス

- ロボット犬は、人間よりも侵略的なヒアリ...

- 不動産業界におけるAIの活用法

- 人工知能に投資するのですか? 考慮すべき...

- Zipperを使用してサーバーレスアプリを高...

- なぜすべての企業がAI画像生成器を使用す...

- ベースとブラスへの情熱が、より良いツー...

- 「ChatGPTのコピーライターへの影響:AIと...

- 2023年のトップ8のChatGPTプラグイン(お...

- 教育と学習の経験を向上させるために、生...

- バードは論理と推論力においてますます上...

- 学ぶための勇気: L1&L2正則化の解明(パ...

- この人工知能(AI)の研究では、SAMを医療...

- チャーン予測とチャーンアップリフトを超えて

- この人工知能に焦点を当てたチップは効率...

「Amazon SageMaker JumpStart上で、生成型AIベースのコンテンツモデレーションソリューションを構築する」

この記事では、マルチモーダルな事前学習と大規模な言語モデル(LLM)を使用した画像データのコンテンツモデレーションの新しい手法を紹介しますマルチモーダルな事前学習により、興味のある質問のセットに基づいて直接画像のコンテンツをクエリすることができ、モデルはこれらの質問に答えることができますこれにより、ユーザーは画像とチャットして、組織のポリシーに違反するような不適切なコンテンツが含まれているかを確認することができますLLMの強力な生成能力を利用して、安全/危険なラベルやカテゴリータイプを含む最終的な意思決定を生成しますさらに、プロンプトを設計することで、LLMに指定された出力形式(JSON形式など)を生成させることができます設計されたプロンプトテンプレートにより、LLMは画像がモデレーションポリシーに違反しているかどうかを判断し、違反のカテゴリーを特定し、なぜ違反しているのかを説明し、構造化されたJSON形式で出力を提供することができます

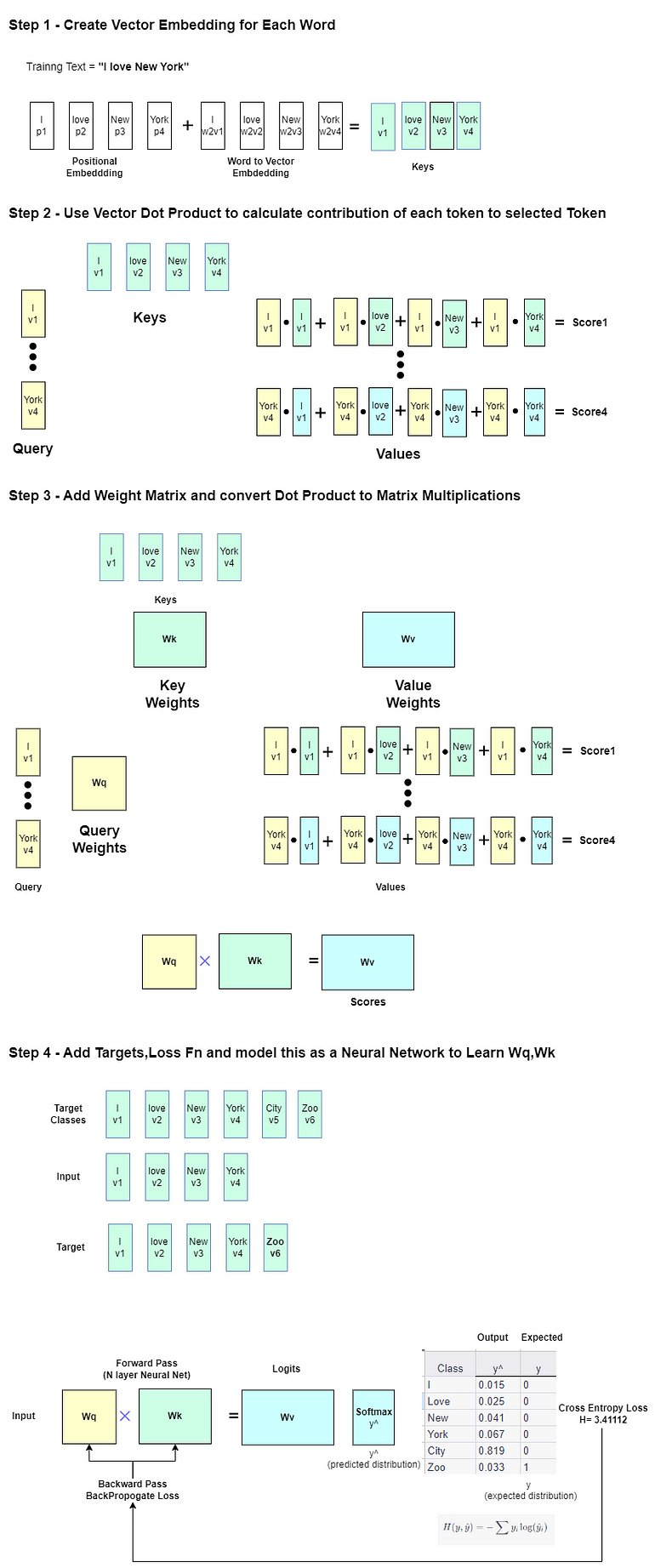

大規模言語モデルの探索 -Part 1

この記事は主に自己学習のために書かれていますそのため、広範囲かつ深い内容です興味のあるセクションをスキップしたり、自分が興味を持っている分野を探求するために、自由に特定のセクションをスキップしてください以下にいくつかの…

「大規模な言語モデルの探索-パート3」

「この記事は主に自己学習のために書かれていますしたがって、広く深く展開されています興味のあるセクションをスキップしたり、自分が興味を持っている分野を探求するために、自由に進めてください以下にはいくつかの...」

大規模言語モデルに追いつく

「もしここにいるということは、私と同様に、大規模言語モデル(LLM)を取り巻く情報の連続的な流れや誇大な投稿に圧倒されたのだということですこの記事は、あなたの助けになるために私が試みたものです...」

自然言語処理:BERTやGPTを超えて

技術の世界は常に進化しており、その中でも特に進歩が見られる分野の一つが自然言語処理(NLP)です数年前には、BERTとGPTという画期的なモデルが登場しました...

「LLMの力を活用する:ゼロショットとフューショットのプロンプティング」

はじめに LLMのパワーはAIコミュニティで新たなブームとなりました。GPT 3.5、GPT 4、BARDなどのさまざまな生成型AIソリューションが異なるユースケースで早期採用されています。これらは質問応答タスク、クリエイティブなテキストの執筆、批判的分析などに使用されています。これらのモデルは、さまざまなコーパス上で次の文予測などのタスクにトレーニングされているため、テキスト生成に優れていると期待されています。 頑健なトランスフォーマーベースのニューラルネットワークにより、モデルは分類、翻訳、予測、エンティティの認識などの言語に基づく機械学習タスクにも適応することができます。したがって、適切な指示を与えることで、データサイエンティストは生成型AIプラットフォームをより実践的で産業的な言語ベースのMLユースケースに活用することが容易になりました。本記事では、プロンプティングを使用した普及した言語ベースのMLタスクに対する生成型LLMの使用方法を示し、ゼロショットとフューショットのプロンプティングの利点と制限を厳密に分析することを目指します。 学習目標 ゼロショットとフューショットのプロンプティングについて学ぶ。 例として機械学習タスクのパフォーマンスを分析する。 フューショットのプロンプティングをファインチューニングなどのより高度な技術と比較評価する。 プロンプティング技術の利点と欠点を理解する。 この記事はData Science Blogathonの一部として公開されました。 プロンプティングとは? まず、LLMを定義しましょう。大規模言語モデル(LLM)とは、数億から数十億のパラメータを持つ、複数のトランスフォーマーとフィードフォワードニューラルネットワークの層で構築されたディープラーニングシステムです。これらはさまざまなソースの大規模なデータセットでトレーニングされ、テキストを理解し生成するために構築されています。言語翻訳、テキスト要約、質問応答、コンテンツ生成などが例です。LLMにはさまざまなタイプがあります:エンコーダのみ(BERT)、エンコーダ+デコーダ(BART、T5)、デコーダのみ(PALM、GPTなど)。デコーダコンポーネントを持つLLMは生成型LLMと呼ばれ、これがほとんどのモダンなLLMの場合です。 生成型LLMに特定のタスクを実行させるには、適切な指示を与えます。LLMは、プロンプトとも呼ばれる指示に基づいてエンドユーザーに応答するように設計されています。ChatGPTなどのLLMと対話したことがある場合、プロンプトを使用したことがあります。プロンプティングは、モデルが望ましい応答を返すための自然言語のクエリで私たちの意図をパッケージングすることです(例:図1、出典:Chat GPT)。 以下のセクションでは、ゼロショットとフューショットの2つの主要なプロンプティング技術を詳しく見ていきます。それぞれの詳細と基本的な例を見ていきましょう。 ゼロショットプロンプティング ゼロショットプロンプティングは、生成型LLMに特有のゼロショット学習の特定のシナリオです。ゼロショットでは、モデルにラベル付きのデータを提供せず、完全に新しい問題に取り組むことを期待します。例えば、適切な指示を提供することにより、新しいタスクに対してChatGPTをゼロショットプロンプティングに使用します。LLMは多くのリソースからコンテンツを理解しているため、未知の問題に適応することができます。いくつかの例を見てみましょう。 以下は、テキストをポジティブ、ニュートラル、ネガティブの感情クラスに分類するための例です。 ツイートの例 ツイートの例は、Twitter US…

「セマンティックカーネルへのPythonistaのイントロ」

ChatGPTのリリース以来、大規模言語モデル(LLM)は産業界とメディアの両方で非常に注目されており、これによりLLMを活用しようとする前例のない需要が生まれました...

「自然言語処理入門」

自然言語処理(NLP)は、コンピュータ科学の複雑な分野であることがほとんど真実ですSpaCyやNLTKなどのフレームワークは大規模であり、しばしば学習が必要ですしかし、...の助けを借りれば、

AIの生成体験を向上させる Amazon SageMakerホスティングでのストリーミングサポートの導入

「Amazon SageMakerリアルタイム推論を通じたレスポンスストリーミングの提供を発表し、大変興奮していますこれにより、チャットボット、仮想アシスタント、音楽ジェネレータなどの生成型AIアプリケーションのインタラクティブな体験を構築する際に、SageMakerリアルタイム推論を使用してクライアントに連続的に推論レスポンスをストリーミングできるようになりましたこの新機能により、レスポンス全体が生成されるのを待つのではなく、利用可能な場合にすぐにレスポンスをストリーミング開始できますこれにより、生成型AIアプリケーションの最初のバイトまでの時間を短縮できますこの記事では、インタラクティブなチャットのユースケースに対して、新しいレスポンスストリーミング機能を使用したSageMakerリアルタイムエンドポイントを使用してストリーミングWebアプリケーションを構築する方法を紹介しますサンプルデモアプリケーションのUIにはStreamlitを使用しています」

「PDF、txt、そしてウェブページとして、あなたのドキュメントと話しましょう」

LLMsを使用してPDF、TXT、さらにはウェブページなどのドキュメントに質問をすることができるウェブと知能を作成するための完全ガイド

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.