Learn more about Search Results Adam - Page 18

- You may be interested

- 「マイクロソフトが7TBの『プロジェクト・...

- このAI研究は、FireActを提案しますこれは...

- 2023年5月のVoAGIトップ記事:Mojo Lang:...

- この人工知能による調査研究は、医療領域...

- MEMSセンサーデータの探索的分析

- 「GPT-4と説明可能なAI(XAI)によるAIの...

- スタンフォード大学の研究者がSequenceMat...

- Rendered.aiは、合成データの生成にNVIDIA...

- 「テキスト分類タスクについての迅速なエ...

- 「システムは光と電子を組み合わせて、よ...

- 「自分の武器を選ぶ:うつ病AIコンサルタ...

- 「高い基数を持つカテゴリカルな特徴をエ...

- 「AIデザインスタジオ、OpenAIによってグ...

- 「生成型人工知能の新たな倫理的意味合い」

- 「Pythonによるロジスティック回帰のエラ...

NODE:表形式に特化したニューラルツリー

近年、機械学習は人気が爆発し、ニューラルディープラーニングモデルは画像やテキストなどの複雑なタスクにおいて、XGBoost [4] のような浅いモデルを圧倒しました…

Stack Overflowで最もよく尋ねられるPythonリストの10の質問

Stack Overflowは、ソフトウェア、コーディング、データサイエンスなど、さまざまな分野において、数千もの質問と回答を見つけることができる情報の宝庫ですもしコンテンツの作成者に尋ねるとしたら、何について尋ねますか?

TensorFlowの学習率の変更方法

TensorFlowで学習率を変更するには、使用している最適化アルゴリズムに応じてさまざまなテクニックを利用することができます

インデータベース分析:SQLの解析関数の活用

次のレベルにデータ分析スキルを活用するために、RANK()、NTILE()、CUME_DIST()などのさまざまなSQL分析関数について学びましょう

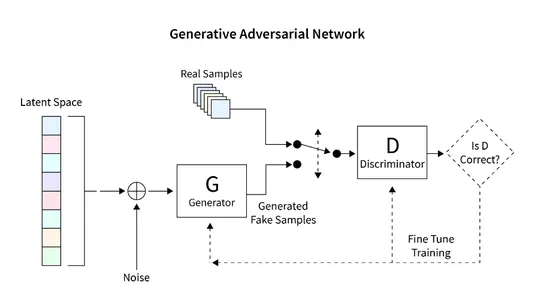

TensorFlowを使用したGANの利用による画像生成

イントロダクション この記事では、GAN(Generative Adversarial Networks)を使用して手書き数字のユニークなレンダリングを生成するためのTensorFlowの応用について探求します。GANフレームワークには、ジェネレータとディスクリミネータという2つの主要なコンポーネントがあります。ジェネレータはランダムな方法で新しい画像を生成し、ディスクリミネータは本物と偽物の画像を区別するために設計されています。GANのトレーニングを通じて、手書き数字に似たコレクションの画像を得ることができます。この記事の主な目的は、MNISTデータセットを使用してGANを構築し評価する手順を概説することです。 学習目標 この記事は、生成的対抗ネットワーク(GAN)の包括的な紹介を提供し、画像生成におけるその応用を探求します。 このチュートリアルの主な目的は、TensorFlowライブラリを使用してGANを構築する手順をステップバイステップで読者に案内することです。MNISTデータセットでGANをトレーニングして手書き数字の新しい画像を生成する方法をカバーしています。 この記事では、ジェネレータとディスクリミネータを含むGANのアーキテクチャとコンポーネントについて説明し、基本的な動作原理を読者の理解を深めるために探求します。 学習を支援するために、記事にはMNISTデータセットの読み込みと前処理、GANアーキテクチャの構築、損失関数の計算、ネットワークのトレーニング、結果の評価などさまざまなタスクをデモンストレーションするコード例が含まれています。 さらに、この記事ではGANの予想される成果物である手書き数字に酷似した画像のコレクションを探求します。 この記事は、データサイエンスブログマラソンの一環として公開されました。 何を構築するのか? 既存の画像データベースを使用して新しい画像を生成することは、生成的対抗ネットワーク(GAN)と呼ばれる特殊なモデルの主要な特徴です。GANは多様な画像データセットを活用して教師なしまたは半教師ありの画像を生成することに優れています。 この記事では、GANの画像生成の潜在能力を活用して手書き数字を作成します。手法としては、手書き数字のデータベースでネットワークをトレーニングすることが含まれます。この教示的な記事では、Tensorflowライブラリを利用して基本的なGANを構築し、MNISTデータセットでトレーニングを行い、手書き数字の新しい画像を生成します。 どのように設定しますか? この記事の主な焦点は、GANの画像生成の潜在能力を活用することです。手順は、画像データベースの読み込みと前処理から始まり、GANのトレーニングプロセスを容易にするためです。データが正常に読み込まれたら、GANモデルを構築し、トレーニングとテストのための必要なコードを開発します。次のセクションでは、この機能を実装し、MNISTデータベースを使用して新しい画像を生成するための詳細な手順が提供されます。 モデルの構築 構築するGANモデルは、2つの重要なコンポーネントで構成されています: ジェネレータ:このコンポーネントは新しい画像を生成する責任があります。 ディスクリミネータ:このコンポーネントは生成された画像の品質を評価します。 GANを使用して画像を生成するために開発する一般的なアーキテクチャは、以下の図に示されています。次のセクションでは、データベースの読み取り、必要なアーキテクチャの作成、損失関数の計算、ネットワークのトレーニングなどの詳細な手順について簡単に説明します。また、ネットワークの検査と新しい画像の生成に使用するコードも提供されます。 データセットの読み込み MNISTデータセットは、コンピュータビジョンの分野で非常に重要で、28×28ピクセルの大きさの手書き数字の広範なコレクションで構成されています。このデータセットは、グレースケールの単一チャンネルの画像形式であるため、GANの実装に理想的です。 次のコードスニペットは、Tensorflowの組み込み関数を使用してMNISTデータセットを読み込む例を示しています。読み込みが成功したら、画像を正規化し、3次元形式に変形します。この変換により、GANアーキテクチャ内で2D画像データを効率的に処理することができます。また、トレーニングデータと検証データの両方にメモリが割り当てられます。…

言語モデルの構築:ステップバイステップのBERTの実装ガイド

イントロダクション 言語処理を行う機械学習モデルの進歩は、ここ数年で急速に進んでいます。この進歩は、研究室を出て、いくつかの主要なデジタル製品の動力となり始めています。良い例として、BERTモデルがGoogle検索の重要な要素となったことが発表されたことがあります。Googleは、この進化(自然言語理解の進歩が検索に応用されること)は、「過去5年間で最大の進歩であり、検索の歴史上でも最大の進歩の1つ」と考えています。では、BERTとは何かについて理解しましょう。 BERTは、Bidirectional Encoder Representations from Transformersの略です。その設計では、未ラベルのテキストから左右の文脈の両方に依存して事前学習された深層双方向表現を作成します。我々は、追加の出力層を追加するだけで、事前学習されたBERTモデルを異なるNLPタスクに適用することができます。 学習目標 BERTのアーキテクチャとコンポーネントを理解する。 BERTの入力に必要な前処理ステップと、異なる入力シーケンスの長さを扱う方法を学ぶ。 TensorFlowやPyTorchなどの人気のある機械学習フレームワークを使用してBERTを実装するための実践的な知識を得る。 テキスト分類や固有表現認識などの特定の下流タスクにBERTを微調整する方法を学ぶ。 次に、「なぜそれが必要なのか?」という別の質問が出てきます。それを説明しましょう。 この記事は、データサイエンスブログマラソンの一環として公開されました。 なぜBERTが必要なのか? 適切な言語表現とは、機械が一般的な言語を理解する能力です。word2VecやGloveのような文脈非依存モデルは、語彙中の各単語に対して単一の単語埋め込み表現を生成します。例えば、”crane”という用語は、”crane in the sky”や”crane to lift heavy objects”といった文脈で厳密に同じ表現を持ちます。文脈モデルは、文内の他の単語に基づいて各単語を表現します。つまり、BERTはこれらの関係を双方向に捉える文脈モデルです。 BERTは、Semi-supervised…

ChatGPTでお金を稼ぐ5つの方法

もしChatGPTでお金を稼げるとは信じていないなら、この記事の終わりまでには信じるようになるでしょう

VoAGIニュース、6月28日:データサイエンスのチートシートのための10のChatGPTプラグイン • データ分析を自動化するChatGPTプラグイン

データサイエンスのチートシートのための10のChatGPTプラグイン • Noteableプラグイン:データ分析を自動化するChatGPTプラグイン • 無料でClaude AIにアクセスする方法は3つあります • ベクトルデータベースとは何か、なぜLLMにとって重要なのか • データサイエンティストのための探索的データ分析の必須ガイド

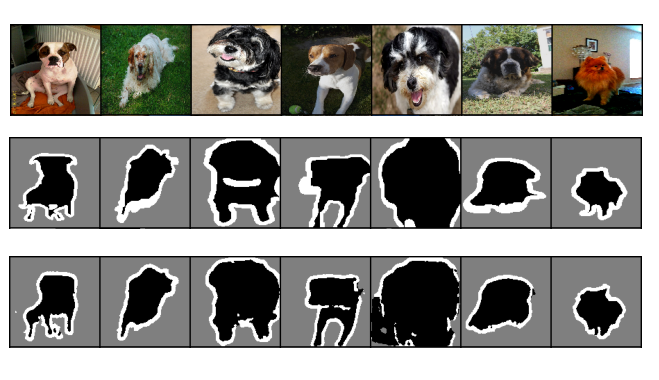

PyTorchを使った効率的な画像セグメンテーション:Part 2

これは、PyTorchを使用してディープラーニング技術を使ってゼロから画像セグメンテーションをステップバイステップで実装する4部作シリーズの第2部ですこの部分では、ベースライン画像の実装に焦点を当てます...

PyTorchを使用した効率的な画像セグメンテーション:パート3

この4部シリーズでは、PyTorchを使用して深層学習技術を使い、画像セグメンテーションをスクラッチからステップバイステップで実装しますこのパートでは、CNNベースラインモデルを最適化することに焦点を当てます

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.