Learn more about Search Results Falcon - Page 17

- You may be interested

- 📱 アップルが不正な認証からのiMessageア...

- 大規模言語モデルにおける推論力の向上:...

- トムソン・ロイターが6週間以内に開発した...

- ストラテゴをマスターする:情報の不完全...

- Falcon LLM:オープンソースLLMの新しい王者

- 「TikTokがAI生成コンテンツのためのAIラ...

- 「MLOpsを活用した顧客離反予測プロジェク...

- 「ダウンストリームタスクのためのFine-tu...

- 『Pythonの呼び出し可能オブジェクト:基...

- アクセラレータの加速化:科学者がGPUとAI...

- ウェブコンテンツの選択肢と制御を進化さ...

- 「作曲家はいつ最も成功するのか?」

- 「スマートな会話インターフェースのため...

- ドックスからコードの生成には、LLMsを使...

- 「YouTube動画の要約を作成するためのAIア...

ドキュメント指向エージェント:ベクトルデータベース、LLMs、Langchain、FastAPI、およびDockerとの旅

ChromaDB、Langchain、およびChatGPTを活用した大規模ドキュメントデータベースからの強化された応答と引用されたソース

北京大学の研究者たちは、ChatLawというオープンソースの法律用の大規模言語モデルを紹介しましたこのモデルには、統合された外部知識ベースが搭載されています

人工知能の成長と発展により、大規模な言語モデルが広く利用可能になりました。ChatGPT、GPT4、LLaMA、Falcon、Vicuna、ChatGLMなどのモデルは、さまざまな伝統的なタスクで優れたパフォーマンスを発揮し、法律業界にとっても多くの機会を開いています。ただし、信頼性のある最新かつ高品質なデータを収集することが、大規模な言語モデルの構築には不可欠です。したがって、効果的かつ効率的なオープンソースの法律言語モデルの作成が重要になっています。 人工知能による大規模モデルの開発は、医療、教育、金融など、いくつかの産業に影響を与えています。BloombergGPT、FinGPT、Huatuo、ChatMedなどのモデルは、難解な問題の解決や洞察に有用で効果的であることが証明されています。一方で、法律の領域では、その固有の関連性と正確さの必要性から、徹底的な調査と独自の法的モデルの作成が求められます。法律は、コミュニティの形成、人間関係の規制、そして正義を確保する上で重要です。法律実務家は、賢明な判断を下し、法律を理解し、法的助言を提供するために正確で最新の情報に頼る必要があります。 法的用語の微妙なニュアンス、複雑な解釈、法律の動的な性質は、特殊な問題を引き起こし、専門的な解決策を必要とします。最先端のGPT4などのモデルでも、法的な困難に関しては頻繁に幻覚現象や驚くべき結果が生じることがあります。多くの人々は、関連するドメインの専門知識でモデルを改善することが良い結果をもたらすと考えています。しかし、早期の法的LLM(LawGPT)にはまだ多くの幻覚と不正確な結果が存在するため、これは事実ではありません。当初は中国の法的LLMの需要があることが理解されました。しかし、13億以上のパラメータを持つ中国のモデルは、商業的に利用可能な時点では存在しませんでした。MOSSなどのソースからのトレーニングデータを組み合わせ、中国語の語彙を増やすことで、経済的に実現可能なモデルであるOpenLLAMAの基盤が改善されました。これにより、北京大学の研究者は、中国語の基本モデルを構築し、それに法律特有のデータを追加してChatLawという法的モデルをトレーニングすることができました。 以下は、論文の主な貢献です: 1. 幻覚を減らすための成功した方法:モデルのトレーニング手順を改善し、推論時に「相談」「参照」「自己提案」「応答」という4つのモジュールを組み込むことにより、幻覚を減らす方法を提案しています。参照モジュールを介して垂直モデルと知識ベースを統合することで、幻覚がより少なくなり、ドメイン固有の知識がモデルに組み込まれ、信頼性のあるデータが知識ベースから使用されます。 2. ユーザーの日常言語から法的特徴語を抽出するモデルがトレーニングされました。これはLLMに基づいています。法的な意味を持つ用語を認識するこのモデルの助けを借りて、ユーザーの入力内の法的状況を迅速かつ効果的に特定し、分析することができます。 3. BERTを使用して、ユーザーの普通の言語と930,000件の関連する裁判文書のデータセットとの類似度を測定するモデルがトレーニングされました。これにより、類似した法的文脈を持つ文章を迅速に検索し、追加の研究や引用が可能になります。 4. 中国語の法的試験評価データセットの開発:中国語を話す人々の法的専門知識を評価するためのデータセットを作成しました。また、さまざまなモデルが法的な多肢選択問題でどれだけ優れたパフォーマンスを発揮するかを判断するためのELOアリーナスコアリングシステムも作成しました。 また、一つの汎用的な法的LLMは、この領域で一部のタスクに対してのみうまく機能する可能性があります。そのため、彼らは複数の状況に対応するために、多肢選択問題、キーワード抽出、質問応答などのさまざまなモデルを開発しました。HuggingGPT技術を使用して、大規模なLLMをコントローラーとして使用し、これらのモデルの選択と展開を管理しました。ユーザーの要求に基づいて、このコントローラーモデルは動的に特定のモデルを選択してアクティブにし、タスクに最適なモデルを使用することを保証します。

ゼロから大規模言語モデルを構築するための初心者ガイド

はじめに TwitterやLinkedInなどで、私は毎日多くの大規模言語モデル(LLMs)に関する投稿に出会います。これらの興味深いモデルに対してなぜこれほど多くの研究と開発が行われているのか、私は疑問に思ったこともあります。ChatGPTからBARD、Falconなど、無数のモデルの名前が飛び交い、その真の性質を解明したくなるのです。これらのモデルはどのように作成されるのでしょうか?大規模言語モデルを構築するにはどうすればよいのでしょうか?これらのモデルは、あなたが投げかけるほとんどの質問に答える能力を持つのはなぜでしょうか?これらの燃えるような疑問は私の心に長く残り、好奇心をかき立てています。この飽くなき好奇心は私の内に火をつけ、LLMsの領域に飛び込む原動力となっています。 私たちがLLMsの最先端について議論する刺激的な旅に参加しましょう。一緒に、彼らの開発の現状を解明し、彼らの非凡な能力を理解し、彼らが言語処理の世界を革新した方法に光を当てましょう。 学習目標 LLMsとその最新の状況について学ぶ。 利用可能なさまざまなLLMsとこれらのLLMsをゼロからトレーニングするアプローチを理解する。 LLMsのトレーニングと評価におけるベストプラクティスを探究する。 準備はいいですか?では、LLMsのマスタリングへの旅を始めましょう。 大規模言語モデルの簡潔な歴史 大規模言語モデルの歴史は1960年代にさかのぼります。1967年にMITの教授が、自然言語を理解するための最初のNLPプログラムであるElizaを作成しました。Elizaはパターンマッチングと置換技術を使用して人間と対話し理解することができます。その後、1970年にはMITチームによって、人間と対話し理解するための別のNLPプログラムであるSHRDLUが作成されました。 1988年には、テキストデータに存在するシーケンス情報を捉えるためにRNNアーキテクチャが導入されました。2000年代には、RNNを使用したNLPの研究が広範に行われました。RNNを使用した言語モデルは当時最先端のアーキテクチャでした。しかし、RNNは短い文にはうまく機能しましたが、長い文ではうまく機能しませんでした。そのため、2013年にはLSTMが導入されました。この時期には、LSTMベースのアプリケーションで大きな進歩がありました。同時に、アテンションメカニズムの研究も始まりました。 LSTMには2つの主要な懸念がありました。LSTMは長い文の問題をある程度解決しましたが、実際には非常に長い文とはうまく機能しませんでした。LSTMモデルのトレーニングは並列化することができませんでした。そのため、これらのモデルのトレーニングには長い時間がかかりました。 2017年には、NLPの研究において Attention Is All You Need という論文を通じてブレークスルーがありました。この論文はNLPの全体的な景色を変革しました。研究者たちはトランスフォーマーという新しいアーキテクチャを導入し、LSTMに関連する課題を克服しました。トランスフォーマーは、非常に多数のパラメータを含む最初のLLMであり、LLMsの最先端モデルとなりました。今日でも、LLMの開発はトランスフォーマーに影響を受けています。 次の5年間、トランスフォーマーよりも優れたLLMの構築に焦点を当てた重要な研究が行われました。LLMsのサイズは時間とともに指数関数的に増加しました。実験は、LLMsのサイズとデータセットの増加がLLMsの知識の向上につながることを証明しました。そのため、BERT、GPTなどのLLMsや、GPT-2、GPT-3、GPT 3.5、XLNetなどのバリアントが導入され、パラメータとトレーニングデータセットのサイズが増加しました。 2022年には、NLPにおいて別のブレークスルーがありました。 ChatGPT は、あなたが望むことを何でも答えることができる対話最適化されたLLMです。数か月後、GoogleはChatGPTの競合製品としてBARDを紹介しました。…

7月号 データサイエンティストのための気候リソース

多くの人にとって、夏の訪れは以前は単純な興奮の原因でした:学校が終わる、仕事のスケジュールは少し忙しくないことが多い、ビーチでののんびりした午後や...

生成AI:世界はどこに向かっているのか?

はじめに テクノロジーの絶え間ない進化の世界で、AI製品の開発と展開が急速に拡大していることを目撃しています。過去6か月間、大手のテック企業や野心的なスタートアップ企業が人工知能の分野で大きな進展を遂げてきました。マイクロソフトやOpenAIなどの企業が注目を集めている一方で、彼らは氷山の一角に過ぎないことを認識することが重要です。 急速に成長しているエンタープライズAI産業で競争力を維持するために、事業は常に革新し、新たな可能性を探求しています。そのような戦略の一つは、他社との協力や非組織的な成長です。業界内の他の企業の専門知識とリソースを活用することで、事業は顧客向けに優れた製品やサービスを開発することができます。さらに、これらのパートナーシップは新たな市場や以前にアクセスできなかった機会を開くものです。合併、買収、そしてパートナーシップは、新しい技術、人材、顧客基盤へのアクセスを提供し、事業が提供するオファリングを拡大し、収益の多様化を図ることを可能にします。 私の観点から見ると、現在のAIの進化サイクルは3つの異なるフェーズに分けることができます。それぞれが成長と進歩を推進しています。 あらゆる技術の成長フェーズ あらゆる技術は成長の初期段階、成熟期、時代遅れの3つのフェーズを経ます。 出現:このフェーズでは、新しい技術が出現し注目を集めます。始まりは少数の先駆的な個人や組織が概念の探求と開発を行うことから始まることが多いです。このフェーズでは、応用が限定的で広範な認識や採用がないことがあります。主な焦点は研究、実験、概念の証明にあります。 成長と拡大:技術が実力を示し、その可能性を証明すると、成長と拡大のフェーズに入ります。開発により、機能性、効率性、使いやすさが向上します。公共および私的セクターからの投資の増加が進歩を推進する重要な役割を果たします。このフェーズでは、技術がより広範に受け入れられ、多くの企業が市場に参入し、消費者が採用し始めます。革新と競争が活気づき、急速な進展と改善が生まれます。このフェーズはまた、協力や戦略的パートナーシップを引き起こします。 成熟と統合:成熟フェーズでは、技術は業界や社会の確立された一部となります。成長率が安定し、進歩が革命的ではなく漸進的になるポイントに達します。技術は人々の生活や既存のシステムに深く統合されています。このフェーズでは優勝者が出始めます。標準化、最適化、相互運用性はこのフェーズで重要な焦点となります。重要なブレークスルーはまだ発生するかもしれませんが、初期のステージと比べると頻度は低くなります。 では、技術としての生成AIが進化のどの段階にあるのか見ていきましょう。これらのフェーズを1つずつ探っていきましょう。 詳細はこちら: 生成AI: 定義、ツール、モデル、利点など フェーズ1: 出現 – 新たなAIの時代の幕開け 最近、AIは前例のない出現のフェーズを経験しています。また、重要な製品の導入と新たな時代の幕開けを特徴としています。特に、GPT-3(Generative Pre-trained Transformer 3)の導入は、この変革を促進する上で重要な役割を果たしています。その結果、ベンチャーキャピタルの投資がAIの景気づけに注ぎ込まれ、数多くのスタートアップ企業が資金調達を行い、画期的なAI製品を開発するためにAI競争に参加しています。フェーズ1は進行中のプロセスであり、少なくともさらなる6-12か月間は続くと予想されています。 この初期フェーズでは、業界の革新者がチャンスを掴み、前進することが予想されます。OpenAIとマイクロソフトの協力が注目すべき例です。彼らの成功は、裏方で技術を磨くための膨大な努力と熱意に帰することができます。これらの組織は、この変革期にAIが提供する可能性を受け入れる者に待ち受ける潜在的な報酬の見本です。 フェーズ1で達成された重要なマイルストーンについて詳しく知るには、次の注目すべき発表を参照してください。 これらのマイルストーンは、この分野で行われた画期的な進展を証明し、AI革命の勢いが止まることのない未来が訪れる舞台を設定しています。…

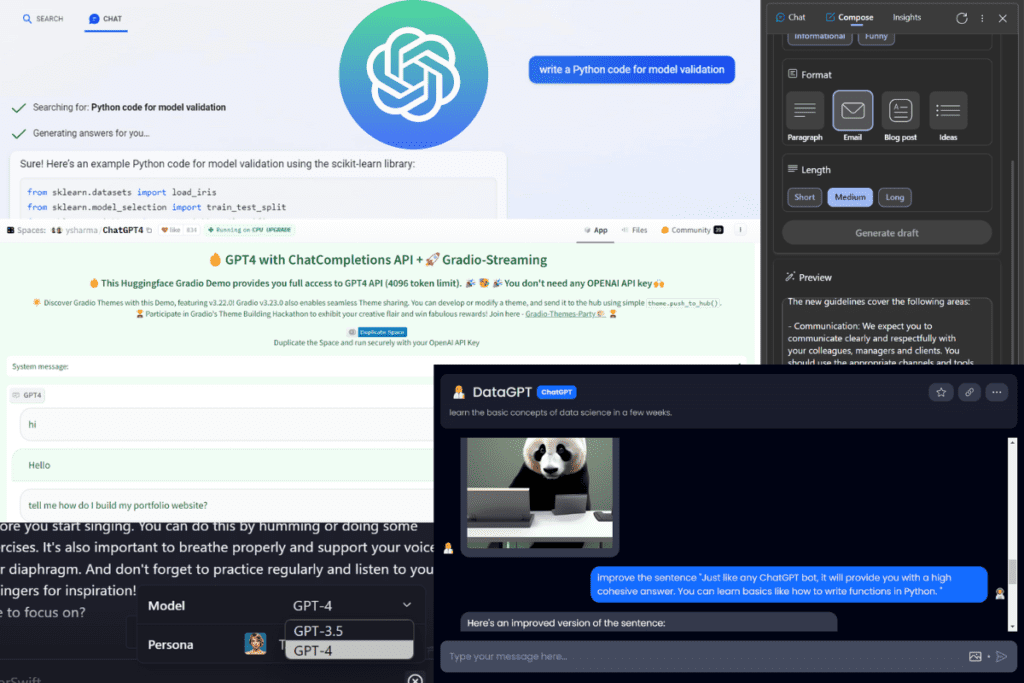

トップの投稿 6月26日から7月2日:GPT-4に無料でアクセスする3つの方法

無料でGPT-4にアクセスするための3つの方法 • データランドスケープの進化 • データサイエンティストのためのAI Chrome拡張機能チートシート • ChatGPTがあなたのコーディングをより良く、より速くする7つの方法 • PythonとRでの機械学習アルゴリズムの比較

新しい言語モデルを評価するための3つの重要な方法

毎週新しいLLMがリリースされますが、私のように考えると、これはついに私がLLMを利用したいすべてのユースケースに適合するのでしょうか?このチュートリアルでは、私は...を共有します

SalesforceはXGen-7Bを導入:1.5Tトークンのために8Kシーケンス長でトレーニングされた新しい7B LLMを紹介します

最近の人工知能の技術的なブレークスルーにより、Large Language Models(LLMs)はますます一般的になっています。過去数年間、研究者たちは、これらのモデルを膨大な量のデータでトレーニングして、複雑な言語関連のタスクを解決するための急速な進歩を遂げてきました。これには、複雑な言語パターンの理解、連続した回答の生成などが含まれます。特に研究者や開発者の関心を引いている研究の1つは、LLMsの長文コンテンツの取り扱いにおける応用です。これらのタスクの例は、テキストの要約やコードの生成などの比較的単純なタスクから、タンパク質の構造予測や情報検索などのより複雑な問題の記述まで様々です。長いテキストのシーケンスには、段落、表、画像などさまざまな形式の情報が含まれているため、LLMsはこれらの要素を処理し理解するためにトレーニングされなければなりません。さらに、長距離の構造的依存関係を効果的に考慮することで、LLMsはテキストの異なる部分間の関連性を特定し、最も関連性の高い情報を抽出することができます。したがって、より広範な知識に触れることで、LLMsはユーザーのクエリにより正確で文脈に即した回答を提供することができます。 しかし、数多くの潜在的なユースケースにもかかわらず、MetaのLLaMAからMosaicMLのMPT LLMモデルに至るまで、ほとんどのオープンソースのLLMsは、最大2Kトークンのシーケンスでトレーニングされています。この制限は、より長いシーケンスのモデリングにおいて大きな課題を提起します。さらに、モデルのスケーリングに関する以前の研究は、固定された計算予算が与えられた場合、トークン数が多いほど小さなモデルの方が大きなモデルよりも優れたパフォーマンスを発揮することを示しています。したがって、現在の進歩と課題に着想を受けて、Salesforce ResearchはXGen-7Bを導入し、1.5兆トークンの8Kシーケンス長でトレーニングされた一連の7B LLMsにおいて画期的な成果を上げました。このモデルシリーズには、4Kシーケンス長に対応するXGen-7B-4K-Base、8Kシーケンス長に対応するXGen-7B-8K-Base、および公開用の教育データでファインチューニングされたXGen-7B-8k-Instが含まれています(研究目的のみで公開されています)。これらのLLMsの注目すべき特徴は、XGenがMPT、Falcon、LLaMAなどといった同様のサイズの最先端のLLMsと比較して、標準のNLPベンチマークで同等または優れた結果を達成することです。 この研究で使用されたXGen-7bモデルは、Salesforceの独自のライブラリJaxFormerを使用してトレーニングされました。このライブラリは、TPU-v4ハードウェアに最適化されたデータとモデルの並列処理を利用した、効率的なLLMのトレーニングを可能にします。トレーニングプロセスはLLaMAのガイドラインに従い、さらに2つの追加の調査を行いました。最初の調査は「損失スパイク」の理解に焦点を当てました。これは、トレーニング中に損失が突然一時的に増加する現象であり、明確な原因がない状態です。これらのスパイクの原因はまだ不明ですが、研究者は「順次回路の並列化」、「swish-GLUの使用」、「RMS-Normの使用」などがトレーニングの不安定性に寄与する可能性があると特定しました。2つ目の調査はシーケンス長に関連しています。自己注意の二次の計算量のため、より長いシーケンスでのトレーニングは計算コストが著しく増加するため、段階的なトレーニングアプローチが採用されました。トレーニングは最初にシーケンス長2kの800Bトークンから始まり、次にシーケンス長4kの400Bトークン、最後にシーケンス長8kの300Bトークンを対象としました。 XGen-7b 8kモデルの長い文脈の理解能力を評価するために、研究者たちは3つの主要なタスクで評価を行いました。それらのタスクは、長い対話生成、テキストの要約、および質問応答です。研究者は、対象のタスクの難しさに基づいて、インストラクションに調整されたモデルを使用しました。長い対話生成に関しては、AMIミーティングの要約、ForeverDreaming、およびTVMegaSiteの脚本の要約の3つのタスクを評価に使用しました。すべての指標において、XGen-7B-instモデルは他のいくつかのインストラクションに調整されたモデルと比較して最高のスコアを達成し、優れたパフォーマンスを示しました。 長文の質問応答に関しては、研究者は物理学、工学、歴史、エンターテイメントなどさまざまなトピックをカバーするウィキペディアのドキュメントを基にChatGPTを使用して質問を生成しました。質問と元の文書の関連性、構成、および関連性に基づいて、256トークンのLLM生成された回答をGPT-4で評価しました。このシナリオでは、2kトークンに制限されたベースラインモデルに比べて、XGen-7B-8k-Instモデルのパフォーマンスが優れていることが示されました。テキストの要約に関しては、研究者は会議の会話と政府の報告書という2つの異なるドメインのデータセットを使用してXGen-7bモデルを評価しました。その結果、XGen-7bモデルはこれらのタスクで他のベースラインモデルを大幅に上回り、テキストの要約でも優れたパフォーマンスを発揮することが示されました。 評価により、XGen-7bモデルは、長い文脈を理解する能力に優れており、長い対話生成、質問応答、テキスト要約など、さまざまなタスクで優れた性能を発揮しました。その性能は、他の指示に調整されたモデルやベースラインモデルを上回り、広範なテキスト文脈での理解力と連続した応答生成能力を示しています。ただし、その効果的さにもかかわらず、XGenモデルには制約があることが研究者によって認識されており、バイアスが免除されず、有害な応答を生成する可能性があります。これは、他の多くのAIモデルと共有する特徴です。Salesforce Researchはまた、コードをオープンソース化して、コミュニティが研究内容を探求できるようにしています。 SF BlogとGithub Linkをチェックしてください。最新のAI研究ニュース、素晴らしいAIプロジェクトなどを共有している25k+ ML SubReddit、Discord Channel、Email Newsletterにもぜひ参加してください。上記の記事に関する質問や見落としがある場合は、お気軽に[email protected]までメールでお問い合わせください。

GEKKOを使用して、世界を確定的な方法でモデリングする

私たちの世界がますますデジタル化される中で、データ収集は急速に拡大していますこのデータによって、私たちはより正確なモデルを作成し、問題を解決し最適化するための手助けをしてきました...

MosaicMLは、彼らのMPT-30BをApache 2.0の下でリリースしました

MosaicML-7Bの大成功の後、MosaicMLは再び以前に設定した基準を上回りました。新しい画期的なリリースでは、MosaicML-30Bを発表しました。 MosaicMLは非常に正確で強力な事前学習済みトランスフォーマーです。MosaicMLは、MosaicML-30BがChatGPT3よりもさらに優れていると主張しています。 MosaicML-30Bの発売前、MosaicML-7BはAI界を席巻しました。MPT-7B Base-instruct、base-chat、およびストーリーライティングは大成功でした。同社は、これらのモデルが世界中で300万回以上ダウンロードされたと主張しています。以前にリリースしたモデルへのコミュニティの熱狂がさらに優れたエンジンを求める最大の理由であり、Mosaic MLはMPT-30Bでそれを実現しました。 コミュニティがこれらのMPTエンジンを適応し、より調整されたものを構築して具体的なユースケースに役立てる姿は信じられないほどでした。興味深いケースの一部はLLaVA-MPTです。LLaVa-MPTは、事前学習済みMPT-7Bにビジョン理解を追加します。 同様に、GGMLはMPTエンジンをApple SiliconとCPUでより良く実行できるように最適化します。GPT4ALLは、MPTを基にしたGPT4のようなチャットオプションを実行できる別のユースケースです。 よく見ると、MosaicMLがより優れており、大企業に対して強力な競争力を持ち、比較的簡単な統合でさまざまなユースケースにモデルを適応させることができるというのは、彼らが提供する競争力のある機能のリストとモデルの適応性のおかげです。 このリリースでは、Mosaic MLはまた、ChatGPTが使用するパラメータのおよそ三分の一のMPT-30Bが、既存の生成ソリューションと比較して非常に軽量なモデルであると主張しています。 MosaicMLの既存のMPT-7Bよりも優れており、このMPT-30Bは商業ライセンスの下で即座に商業利用が可能です。 それだけでなく、MPT-30BにはMPT-30B-InstructとMPT-30B-Chatの2つの事前学習済みモデルも付属しており、1つの単一指示に影響を受けることができ、より長い時間のマルチターン会話を追うことができます。 その優れた点は続きます。MosaicMLはMPT-30Bをボトムアップのアプローチでより良く、より効率的に設計しました。MPT-30Bは8kトークンのコンテキストウィンドウでトレーニングされています。ALiBiを介してより長いコンテキストをサポートしています。 FlashAttentionの助けを借りて、トレーニングと推論のパフォーマンスを改善しました。MPT-30Bは、データの多様性によるより強力なコーディング能力を備えています。このモデルはNvidiaのH100上で8Kコンテキストウィンドウに拡張されました。同社は、これがH100で訓練された最初のLLMモデルであり、お客様にすぐに利用可能であると主張しています。 MosaicMLはまた、モデルを軽量に保ち、新興企業が運用コストを低く抑えるのに役立てています。 MPT-30Bのサイズも、単一のGPU上で簡単に展開できるように特別に選ばれました。1つのA100-80GB(16ビット精度)または1つのA100-40GB(8ビット精度)でシステムを実行できます。Falcon-40Bなどの他の比較可能なLLMは、より大きなパラメータ数を持ち、単一のデータセンターGPUではサービスできません(現在)。これには2つ以上のGPUが必要であり、最小の推論システムコストが増加します。

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.