Learn more about Search Results 7 - Page 17

- You may be interested

- 「未来のコンピュータから秘密を守る競争」

- 「パーソナリティをピクセルにもたらす、I...

- 2023年のYouTuberに最適なAIツール

- エンドツーエンドのMLパイプラインの構築方法

- 「このディスインフォメーションはあなた...

- 「素晴らしいAIアプリケーションのクイッ...

- 「固有表現とニュース」

- 「ベルカーブの向こう側:t-分布の紹介」

- 「NVIDIAは3DワールドのためのOpenUSD標準...

- AI記事スキャンダルがアリーナグループに...

- LMSYS ORG プレゼント チャットボット・ア...

- チャーン予測とチャーンアップリフトを超えて

- 男性がテック業界の女性向けジョブフェア...

- UCサンタクルーズの研究者たちは、概念や...

- 「AIの問題を定義する方法」

7月20日に開催される無料の生成AIサミットで見逃せないセッションが発表されました

私たちの初のジェネレーティブAIサミットは、あと2週間で開催されます私たちは、多様な専門家、学者、業界リーダーなどを一堂に集め、この画期的な技術について議論することを心待ちにしていますサミット中に参加できるいくつかのセッションをご覧ください最近の進展について...

5つの最高のDeepfake検出ツールと技術(2023年7月)

デジタル時代において、ディープフェイクはオンラインコンテンツの真正性にとって重大な脅威として浮上していますこれらの洗練されたAI生成のビデオは、本物の人物を信じられるように模倣し、事実とフィクションを区別することがますます困難になっていますしかし、ディープフェイクの背後にある技術が進化するにつれて、それらを検出するために設計されたツールや技術も進化してきました

2023年7月のMac向けの最高のデータ復旧ツール10選

データの損失は、個人の写真から重要なビジネス文書まで、重要なファイルをコンピュータに頼っている人にとっては悪夢のようなものです幸いなことに、Macユーザー向けには、失われたファイルや誤って削除されたファイルを取り戻すのに役立つさまざまなデータ復旧ツールが利用可能ですこの記事では、10個のツールを紹介します

Falcon-7Bの本番環境への展開

これまでに、ChatGPTの能力と提供するものを見てきましたしかし、企業利用においては、ChatGPTのようなクローズドソースモデルは、企業がデータを制御できないというリスクがあるかもしれません...

トップ7の列操作でより効果的にPandasデータフレームを使用する

データ分析に関しては、データを操作して準備するために最もよく使用されるPythonライブラリはPandasですでは、列に対するトップ7の操作を見てみましょう

7月号 データサイエンティストのための気候リソース

多くの人にとって、夏の訪れは以前は単純な興奮の原因でした:学校が終わる、仕事のスケジュールは少し忙しくないことが多い、ビーチでののんびりした午後や...

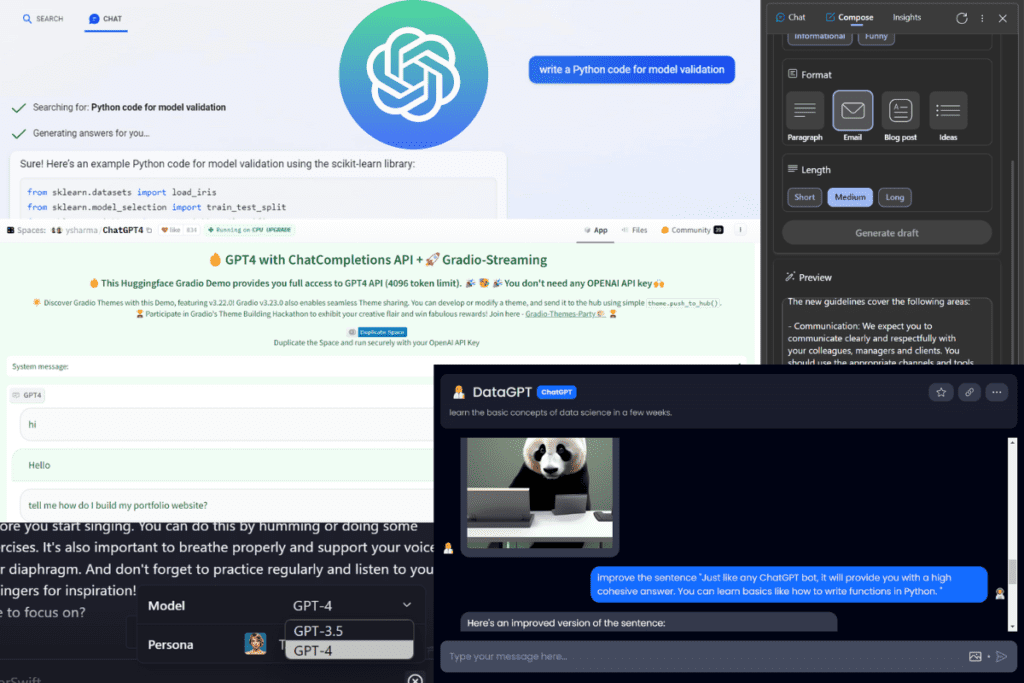

トップの投稿 6月26日から7月2日:GPT-4に無料でアクセスする3つの方法

無料でGPT-4にアクセスするための3つの方法 • データランドスケープの進化 • データサイエンティストのためのAI Chrome拡張機能チートシート • ChatGPTがあなたのコーディングをより良く、より速くする7つの方法 • PythonとRでの機械学習アルゴリズムの比較

今日、開発者の70%がAIを受け入れています:現在のテックの環境での大型言語モデル、LangChain、およびベクトルデータベースの台頭について探求する

人工知能には無限の可能性があります。それは、新しいリリースや開発によって明らかになっています。OpenAIが開発した最新のチャットボットであるChatGPTのリリースにより、AIの領域はGPTのトランスフォーマーアーキテクチャのおかげで常に注目を浴びています。ディープラーニング、自然言語処理(NLP)、自然言語理解(NLU)からコンピュータビジョンまで、AIは無限のイノベーションをもたらす未来へと皆を推進しています。ほぼすべての産業がAIの潜在能力を活用し、自己革新を遂げています。特に大規模言語モデル(LLMs)、LangChain、およびベクトルデータベースの領域での優れた技術的進歩がこの素晴らしい発展の原動力です。 大規模言語モデル 大規模言語モデル(LLMs)の開発は、人工知能における大きな進歩を表しています。これらのディープラーニングベースのモデルは、自然言語を処理し理解する際に印象的な正確さと流暢さを示します。LLMsは、書籍、ジャーナル、Webページなど、さまざまなソースからの大量のテキストデータを使用してトレーニングされます。言語を学ぶ過程で、LLMsは言語の構造、パターン、および意味的な関連性を理解するのに役立ちます。 LLMsの基本的なアーキテクチャは通常、複数の層からなるディープニューラルネットワークです。このネットワークは、トレーニングデータで発見されたパターンと接続に基づいて、入力テキストを分析し予測を行います。トレーニングフェーズ中にモデルの期待される出力と意図された出力の不一致を減少させるために、モデルのパラメータは調整されます。LLMは、トレーニング中にテキストデータを消費し、文脈に応じて次の単語または単語のシリーズを予測しようとします。 LLMsの使用方法 質問への回答:LLMsは質問に回答するのが得意であり、正確で簡潔な回答を提供するために、本や論文、ウェブサイトなどの大量のテキストを検索します。 コンテンツ生成 – LLMsは、コンテンツ生成に活用されることが証明されています。彼らは、文法的に正しい一貫した記事、ブログエントリ、および他の文章を生成する能力を持っています。 テキスト要約:LLMsはテキスト要約に優れており、長いテキストを短く、より理解しやすい要約にまとめることができます。 チャットボット – LLMsは、チャットボットや対話型AIを使用したシステムの開発に頻繁に使用されます。これらのシステムは、質問を理解し適切に応答し、対話全体で文脈を保持することで、ユーザーと自然な言語で対話することができます。 言語翻訳 – LLMsは、言語の壁を乗り越えて成功したコミュニケーションを可能にするため、テキストの正確な翻訳が可能です。 LLMのトレーニングの手順 LLMのトレーニングの最初の段階は、モデルが言語のパターンや構造を発見するために使用する大規模なテキストデータセットを編集することです。 データセットが収集されたら、トレーニングのためにそれを準備するために前処理が必要です。これには、不要なエントリを削除することによるデータのクリーニングが含まれます。 LLMをトレーニングするために適切なモデルアーキテクチャを選択することは重要です。トランスフォーマベースのアーキテクチャは、GPTモデルを含む自然言語の処理と生成に非常に効率的であることが示されています。 モデルのパラメータを調整してLLMをトレーニングし、バックプロパゲーションなどのディープラーニング手法を使用してその精度を向上させます。モデルはトレーニング中に入力データを処理し、認識されたパターンに基づいて予測を行います。 初期のトレーニング後、LLMは特定のタスクやドメインでさらに微調整され、それらの領域でのパフォーマンスが向上します。 トレーニングされたLLMのパフォーマンスを評価し、モデルのパフォーマンスを評価するためのパープレキシティや精度などの複数のメトリクスを使用して、その効果を決定することが重要です。 トレーニングと評価が完了したLLMは、実際のアプリケーションのためのプロダクション環境で使用されます。…

SalesforceはXGen-7Bを導入:1.5Tトークンのために8Kシーケンス長でトレーニングされた新しい7B LLMを紹介します

最近の人工知能の技術的なブレークスルーにより、Large Language Models(LLMs)はますます一般的になっています。過去数年間、研究者たちは、これらのモデルを膨大な量のデータでトレーニングして、複雑な言語関連のタスクを解決するための急速な進歩を遂げてきました。これには、複雑な言語パターンの理解、連続した回答の生成などが含まれます。特に研究者や開発者の関心を引いている研究の1つは、LLMsの長文コンテンツの取り扱いにおける応用です。これらのタスクの例は、テキストの要約やコードの生成などの比較的単純なタスクから、タンパク質の構造予測や情報検索などのより複雑な問題の記述まで様々です。長いテキストのシーケンスには、段落、表、画像などさまざまな形式の情報が含まれているため、LLMsはこれらの要素を処理し理解するためにトレーニングされなければなりません。さらに、長距離の構造的依存関係を効果的に考慮することで、LLMsはテキストの異なる部分間の関連性を特定し、最も関連性の高い情報を抽出することができます。したがって、より広範な知識に触れることで、LLMsはユーザーのクエリにより正確で文脈に即した回答を提供することができます。 しかし、数多くの潜在的なユースケースにもかかわらず、MetaのLLaMAからMosaicMLのMPT LLMモデルに至るまで、ほとんどのオープンソースのLLMsは、最大2Kトークンのシーケンスでトレーニングされています。この制限は、より長いシーケンスのモデリングにおいて大きな課題を提起します。さらに、モデルのスケーリングに関する以前の研究は、固定された計算予算が与えられた場合、トークン数が多いほど小さなモデルの方が大きなモデルよりも優れたパフォーマンスを発揮することを示しています。したがって、現在の進歩と課題に着想を受けて、Salesforce ResearchはXGen-7Bを導入し、1.5兆トークンの8Kシーケンス長でトレーニングされた一連の7B LLMsにおいて画期的な成果を上げました。このモデルシリーズには、4Kシーケンス長に対応するXGen-7B-4K-Base、8Kシーケンス長に対応するXGen-7B-8K-Base、および公開用の教育データでファインチューニングされたXGen-7B-8k-Instが含まれています(研究目的のみで公開されています)。これらのLLMsの注目すべき特徴は、XGenがMPT、Falcon、LLaMAなどといった同様のサイズの最先端のLLMsと比較して、標準のNLPベンチマークで同等または優れた結果を達成することです。 この研究で使用されたXGen-7bモデルは、Salesforceの独自のライブラリJaxFormerを使用してトレーニングされました。このライブラリは、TPU-v4ハードウェアに最適化されたデータとモデルの並列処理を利用した、効率的なLLMのトレーニングを可能にします。トレーニングプロセスはLLaMAのガイドラインに従い、さらに2つの追加の調査を行いました。最初の調査は「損失スパイク」の理解に焦点を当てました。これは、トレーニング中に損失が突然一時的に増加する現象であり、明確な原因がない状態です。これらのスパイクの原因はまだ不明ですが、研究者は「順次回路の並列化」、「swish-GLUの使用」、「RMS-Normの使用」などがトレーニングの不安定性に寄与する可能性があると特定しました。2つ目の調査はシーケンス長に関連しています。自己注意の二次の計算量のため、より長いシーケンスでのトレーニングは計算コストが著しく増加するため、段階的なトレーニングアプローチが採用されました。トレーニングは最初にシーケンス長2kの800Bトークンから始まり、次にシーケンス長4kの400Bトークン、最後にシーケンス長8kの300Bトークンを対象としました。 XGen-7b 8kモデルの長い文脈の理解能力を評価するために、研究者たちは3つの主要なタスクで評価を行いました。それらのタスクは、長い対話生成、テキストの要約、および質問応答です。研究者は、対象のタスクの難しさに基づいて、インストラクションに調整されたモデルを使用しました。長い対話生成に関しては、AMIミーティングの要約、ForeverDreaming、およびTVMegaSiteの脚本の要約の3つのタスクを評価に使用しました。すべての指標において、XGen-7B-instモデルは他のいくつかのインストラクションに調整されたモデルと比較して最高のスコアを達成し、優れたパフォーマンスを示しました。 長文の質問応答に関しては、研究者は物理学、工学、歴史、エンターテイメントなどさまざまなトピックをカバーするウィキペディアのドキュメントを基にChatGPTを使用して質問を生成しました。質問と元の文書の関連性、構成、および関連性に基づいて、256トークンのLLM生成された回答をGPT-4で評価しました。このシナリオでは、2kトークンに制限されたベースラインモデルに比べて、XGen-7B-8k-Instモデルのパフォーマンスが優れていることが示されました。テキストの要約に関しては、研究者は会議の会話と政府の報告書という2つの異なるドメインのデータセットを使用してXGen-7bモデルを評価しました。その結果、XGen-7bモデルはこれらのタスクで他のベースラインモデルを大幅に上回り、テキストの要約でも優れたパフォーマンスを発揮することが示されました。 評価により、XGen-7bモデルは、長い文脈を理解する能力に優れており、長い対話生成、質問応答、テキスト要約など、さまざまなタスクで優れた性能を発揮しました。その性能は、他の指示に調整されたモデルやベースラインモデルを上回り、広範なテキスト文脈での理解力と連続した応答生成能力を示しています。ただし、その効果的さにもかかわらず、XGenモデルには制約があることが研究者によって認識されており、バイアスが免除されず、有害な応答を生成する可能性があります。これは、他の多くのAIモデルと共有する特徴です。Salesforce Researchはまた、コードをオープンソース化して、コミュニティが研究内容を探求できるようにしています。 SF BlogとGithub Linkをチェックしてください。最新のAI研究ニュース、素晴らしいAIプロジェクトなどを共有している25k+ ML SubReddit、Discord Channel、Email Newsletterにもぜひ参加してください。上記の記事に関する質問や見落としがある場合は、お気軽に[email protected]までメールでお問い合わせください。

ベストAI画像生成器(2023年7月)

多くのビジネスの景色が人工知能によって変わりつつあり、画像作成もその一つです。 AI画像生成器は、テキストをグラフィックに変換するための人工知能アルゴリズムを使用します。これらのAIツールは、数秒で思考やアイデアを素早く視覚化するための素晴らしい手段です。 では、どのAI画像生成器が試す価値があるのでしょうか?2023年に利用可能ないくつかの優れたAI画像生成器を紹介します。 Shutterstock AI Image Generator Shutterstock AI Image Generatorは、デザインの世界において画期的な存在です。AIの力を活用することで、ユーザーは驚くべき美しいデザインを簡単に作成することができます。この素晴らしい新機能は、OpenAIとのパートナーシップによって実現しました。OpenAIはDALL-E 2技術を提供し、Shutterstockの画像とデータを使用してトレーニングされたこのソフトウェアは、完全にライセンス可能な画像を生成します。このブレイクスルーは、アート界にとって大きな意味を持ちます。他人の知的財産権を侵害することなく、AI生成のアートを使用することができるためです。倫理的なアート作品がわずか数秒でダウンロード可能な状態で用意されており、創造性を発揮するのに最適な時期です。Shutterstockの無料トライアルオファーでは、最大10枚のAI生成画像を無料で入手できます! FotorAI Image Generator FotorAI Image Generatorは、人工知能(AI)技術を使用して新鮮な写真を作成するツールです。ユーザーはサンプル画像を入力することで、それを元に全く新しいオリジナル画像を作成します。この機能によって生成される新しい写真は、非常にリアルで高品質だと主張されており、Generative Adversarial Network(GAN)を使用して生成されます。これは、グラフィックデザインやデジタルアートのための新鮮な画像を作成するためなど、さまざまな用途で使用することができます。Fotorのプレミアムバージョンでしか利用できません。 Nightcafe Nightcafeは最高のAIテキストから画像への生成器であり、キーワードをクリエイティブでリアルな画像に変換します。最も基本的な英単語だけを使用して、希望するものを正確に表現するカスタマイズされたグラフィックを作成することができます。Nightcafeはさまざまなクリエイティブやスタイルも提供しており、一般的な画像を芸術作品に変換するためにニューラルスタイル変換を利用することもできます。Nightcafeの使いやすいソフトウェアは初心者にも非常にアクセスしやすくなっています。使いやすく魅力的なウェブサイトデザインにより、誰でもクリックひとつで画像を作成し改善することができます。作成した作品をどこか別の場所に保存する必要はありません。それは常にアカウントに保管されます。 Dream By…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.