Learn more about Search Results Go - Page 15

- You may be interested

- WAYVE社がGAIA-1を発表:ビデオ、テキスト...

- 「CohereによるLLM大学に関する必要なすべ...

- 「Decafと出会う:顔と手のインタラクショ...

- 「ノイズのある量子プロセッサをクラシカ...

- AIがVRデバイスのユーザーエクスペリエン...

- 言語の愛好家であるなら、ChatGPTの多言語...

- 「目と耳を持つChatGPT:BuboGPTは、マル...

- LLM説明性への道:なぜ私のモデルはこの出...

- 「ジェネレーティブAIを活用してグローバ...

- Juliaでの一致するチャットボットの構築

- GopherCite 検証済みの引用を使用して回答...

- VoAGIニュース、6月28日:データサイエン...

- 「抗議を取り締まっているロシアは、監視...

- 「機械学習の未来:新興トレンドと機会」

- 「AIレポート2023年」を解説する

「Google DeepMindが、7100万件の「ミスセンス」変異の効果を分類する新しいAIツールを発表」

人類遺伝学における最大の課題は、おそらく人間のゲノムの複雑さと、健康と病気に寄与する遺伝要因の広範な多様性です。人間のゲノムは30億以上の塩基対から成り、タンパク質をコードする遺伝子だけでなく、遺伝子の調節と機能に重要な役割を果たすノンコーディング領域も含まれています。これらの要素とその相互作用のプロセスを理解することは、非常に困難な課題です。 病気に関連する遺伝子変異を知ることは単なる始まりにすぎません。これらの変異の機能的な結果、他の遺伝子との相互作用、および疾患の病理学的な役割を理解することは、複雑で資源を消費する作業です。高いシーケンス技術によって生成される膨大な遺伝データを分析するには、高度なコンピュータツールとインフラストラクチャが必要です。データの保存、共有、分析は、実務上の多大な課題を提起します。 Google DeepMindの研究者は、AlphaMissenseという新たなAIモデルを使用してAlphaMissenseカタログを開発しました。これには71百万通りのミッセンス変異のうち約89%が、病原性または良性のカテゴリに分類されています。ミッセンス変異は、DNA配列中の単一ヌクレオチドの置換によって生じる遺伝的変異です。ヌクレオチドはDNAの構成要素であり、特定の順序で配置されています。この配列は生物の基本的な遺伝情報とタンパク質構造を保持しています。平均して、一人の人が9000以上のミッセンス変異を持っています。 これらの分類されたミッセンス変異は、疾患の原因となるタンパク質の変化を理解するのに役立ちます。彼らの現在のモデルは、彼らが以前に成功したAlphaFoldというモデルのデータを訓練に使用しています。このモデルは、アミノ酸配列から既知のほぼすべてのタンパク質の構造を予測しました。ただし、AlphaMissenseは、データベースのタンパク質配列と変異の構造的文脈を分類するだけで、0から1までのスコアを生成します。スコア1は、その構造が病原体である可能性が非常に高いことを示します。与えられた配列に対して、スコアは変異を分類するための閾値を選択するために分析されます。 AlphaMissenseは、他のすべての計算方法やモデルを上回っています。彼らのモデルは、実験結果を予測するための最も正確な方法でもあり、病原性の測定方法の一貫性を反映しています。このモデルを使用すると、ユーザーは一度に何千ものタンパク質の結果のプレビューを取得できます。これは、リソースの優先順位付けと研究の加速に役立ちます。人間で見られる400万以上のミッセンス変異のうち、専門家によって病原性または良性として注釈が付けられたのは2%にすぎず、すべての71百万通りのミッセンス変異の約0.1%です。 人類の遺伝学は急速に進化しており、技術、データ分析、遺伝メカニズムの理解の進歩によってこれらの課題に取り組み続けています。これらの課題は重要ですが、遺伝研究を通じて人間の健康と個別化医療の向上に向けたエキサイティングな機会をもたらします。さまざまな生物のゲノムを解読することは進化についての洞察を提供します。

「ReLU vs. Softmax in Vision Transformers Does Sequence Length Matter? Insights from a Google DeepMind Research Paper」 ビジョン・トランスフォーマーにおけるReLU vs. Softmax:シーケンスの長さは重要か?Google DeepMindの研究論文からの洞察

今日一般的な機械学習アーキテクチャは、トランスフォーマーアーキテクチャです。トランスフォーマーの主要なパーツの1つであるアテンションは、トークン全体にわたる確率分布を生成するソフトマックスを持っています。ソフトマックスは、指数計算とシーケンスの長さの合計による計算量のため、並列化が困難です。この研究では、確率分布を常に提供しないポイントワイズのソフトマックスの代替手法について調査しています。特筆すべき発見の1つは、ビジュアルトランスフォーマーの場合、ReLUによるシーケンスの長さで分割されたアテンションのスケーリング動作が、クラシックなソフトマックスアテンションとほぼ同等または一致することです。 この発見により、ReLU-アテンションはシーケンスの長さ次元に沿って標準のアテンションよりも容易に並列化できる新たな可能性が開かれました。以前の研究では、ReLUまたは二乗ReLUがソフトマックスの代替手法として考慮されてきました。ただし、これらの手法はシーケンスの長さで分割されていないため、Google DeepMindの研究者によれば、ソフトマックスと同等の精度を達成するためにはこれが重要です。さらに、以前の研究では、ソフトマックスの役割を果たすことが考慮されており、シーケンスの長さの軸方向での正規化は依然として必要ですが、これにはギャザリングが必要です。さらに、アテンションを線形にするために活性化関数を排除する研究が豊富にあり、これは長いシーケンスの期間に有利です。 彼らの研究では、活性化が完全に除外されると精度が低下しました。彼らのテストは、ハイパーパラメータを変更せずに、BigVisionソースのImageNet-21kおよびImageNet-1kのトレーニング設定を使用しています。ImageNet-21kでは30エポック、ImageNet-1kでは300エポックトレーニングします。その結果、両方のトレーニング実行には約9e5ステップかかります。これは以前の研究でモデルサイズのスケーリング時の不安定性を避けるために必要であることが判明しているため、彼らはqkレイヤーの正規化を持つViTsを使用します。彼らは、これが彼らのスケールにおいて重要な要素ではないと結論づけています。 彼らは、ファインチューニングせずにImageNet-1k内のトップクラスのみを取ることによって、ImageNet-21kモデルのImageNet-1k精度を報告しています。彼らは、転送パフォーマンスを評価するために、3つのシードで平均化された10ショットのリニアプローブを使用します。転送先のタスクには、Caltech Birds、Caltech101、Stanford Cars、CIFAR-100、DTD、ColHsit、Pets、およびUC Mercedがあります。この研究は、多くの未解決の問題を提起しています。なぜ因子L^(-1)がパフォーマンスを向上させるのか、またはこの概念を学習できるかを彼らは発見しなければなりません。さらに、彼らが調査していないより効果的な活性化関数があるかもしれません。

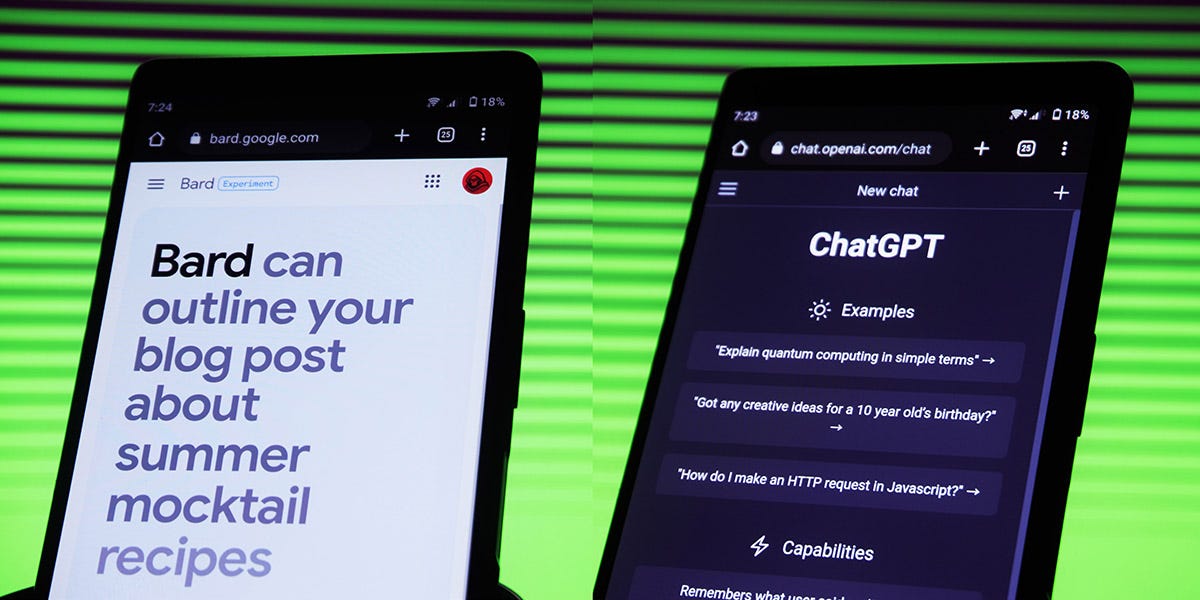

「LLMsを使用した用語の翻訳(GPTとVertex AI/Google Bard)」

ChatGPTのようなLLMは、人間よりも正確に翻訳を行うことができるのでしょうか?私たちが利用できるLLMのオプションは何ですか?さまざまな方法で翻訳を行うために生成型AIを使用する方法について詳しく学びましょう

GoogleのPaLM 2:言語モデルの革命化

イントロダクション 人工知能の急速な進化の中で、テック企業は世界に有意義な貢献をする高効率なAIモデルの開発を競っています。この競争において重要な役割を果たすGoogleは、AIが達成できる可能性の限界を押し広げるために、幅広い研究に積極的に投資しています。彼らの努力の成果は、最新の画期的な言語モデルであるPaLM 2など、革新的な製品の中に明らかに現れています。PaLM 2の進化により、AIとの対話やAIの活用方法が革新される可能性があります。この記事では、GoogleのPaLM 2が何であり、それが未来をどのように形作るかについて詳しく調べていきます。 Bardの理解:Googleの以前の言語モデル PaLM 2について詳しく説明する前に、まずその前身であるBardについて理解しましょう。Google AIが開発したBardは、コードやテキストを含む広範なデータセットで訓練されたチャットボットです。言語翻訳、テキスト生成、コンテンツ作成、情報の質問応答など、多様なスキルを持っています。BardはWebコンテンツの要約に優れ、オープンエンドや複雑な会話中にさらなる探求のためのリンクを提供することさえ可能です。 Bardの影響は特に教育分野で顕著であり、個別の学習、創造的な文章作成、研究、およびカスタマーサービスに役立っています。ただし、Bardには制限があり、不完全または曖昧なクエリに対して不正確またはバイアスのある情報を生成することがあります。これらの制限は、安全性と透明性の向上が必要であることを示しています。 また読む:Chatgpt-4対Google Bard:ヘッド・トゥ・ヘッドの比較 PaLM 2の紹介 Googleは、機械学習とAIの内部研究を基に、次世代の大規模言語モデルであるPaLM 2を発表しました。PaLM 2は、技術的な言語理解、多言語翻訳、自然言語生成の能力が向上した、言語モデル技術の大きな飛躍を表しています。 PaLM 2は5400億のパラメータを持ち、幅広い機能を実現し、より正確で情報豊かな応答を生成することができます。Bardを凌ぐ多様性を持ち、コードの生成、数学の問題の解決、デバッグ、多様なテキストコンテンツの作成などの能力を備えています。また、PaLM 2は20の異なるプログラミング言語でコーディングが可能であり、他のGoogle製品とシームレスに統合することができます。これにより、開発者やユーザーにとって無限の可能性が開けます。 言語理解の向上 PaLM 2の素晴らしい多言語能力は、それを特筆する要素です。PaLM 2は100以上の言語に対応し、グローバルなユーザーにとって貴重なツールとなります。アラビア語、ドイツ語、ヒンディー語、スペイン語、中国語、日本語など、多様な言語で翻訳、質問応答、コード生成、コンテンツ作成などで優れたパフォーマンスを発揮します。その言語の習熟度は、教育から医療、法律、ソフトウェア開発、メディアやエンターテイメントなど、さまざまな分野で有用なリソースとなります。…

「Google Bardの拡張機能を無料で使用する方法」

「Bard拡張機能を使用すると、Google Maps、YouTube、およびGmailをより効果的に利用できます」

Google Pub/SubからBigQueryへの簡単な方法

「過去には、Pub/SubメッセージをBigQueryテーブルに取り込みたいと思う状況に何度も遭遇しましたが、特に簡単な方法が見つからず、うまくいかないことが多かったです...」

アナリストによると、ジェネレーティブAIにおいて、AppleはMicrosoftやGoogleに比べて大幅に遅れているとのことです

「Appleの最新のiPhone 15の発表イベントは、画期的な製品革新で魅了することはなかったかもしれませんが、それはより深刻な懸念を明らかにしましたつまり、Appleの位置は急速に進化する生成AIの世界で、GoogleやMicrosoftなどの競合他社に比べて遅れを取っているということですNeedhamのシニアメディア&インターネットアナリスト、ローラによると...」

無料でGoogle Colab上でQLoraを使用してLLAMAv2を微調整する

「Google Colabで最も影響力のあるオープンソースモデルの微調整方法を無料で学びましょう」

「Googleの研究者は、シーンのダイナミクスに先行する画像空間をモデリングするための新しい人工知能アプローチを発表します」

風や水の流れ、呼吸、自然のリズムなどのために、静止しているように思われる画像にも微細な振動が含まれています。これは自然界が常に動いているためです。人間は特に動きに敏感であり、これが最も顕著な視覚信号の一つになります。動きのない(またはやや幻想的な動きがある)画像は時折不安定であり、超現実的に感じられることがあります。しかし、人々はシーン内の動きを理解したりイメージしたりすることは簡単です。モデルに現実的な動きを獲得させることはより複雑です。シーンの物理的なダイナミクス、または物体の質量、弾性などの特定の物理的特性によって物体に作用する力は、人々が外部の世界で見る動きを生み出します。 これらの力や特性は、大規模に測定・捉えることが困難ですが、観察された動きから捉えて学ぶことができるため、しばしば定量化する必要はありません。この観測可能な動きは多様な形であり、複雑な物理プロセスに基づいていますが、予測可能です。ろうそくは特定のパターンで揺らぎ、木々は揺れ動き、葉をなびかせます。彼らは、静止画像を見ることで、その画像に基づく自然な動きの分布やその時点で進行中だったかもしれない可能性のある動きを想像することができます。この予測可能性は、彼らの人間の現実のシーンへの知覚に根付いています。 図1: この手法がシーンのダイナミクスに先行する生成画像空間のモデリングをどのようにシミュレートするかが分かります。単一のRGB画像から始めて、モデルはフーリエ領域で密な長期的な動きの軌跡をシミュレートするニューラル確率モーションテクスチャを作成します。彼らは、このモーション先行情報が、単一の画像を滑らかにループするムービーに変換したり、インタラクティブなユーザーの刺激(オブジェクトの点をドラッグしてリリースするなど)に応じてオブジェクトのダイナミクスを模倣したりするためにどのように使用できるかを示しています。彼らは、ビデオの10秒間(入力画像に表示されるスキャンラインに沿った)の空間-時間X-tスライスを使用して、右側の出力フィルムを視覚化しています。 人間がこれらの潜在的な動きを容易に視覚化できるため、これをデジタル上で類似の分布をシミュレートすることは自然な研究課題です。最近の生成モデル、特に条件付き拡散モデルの進歩により、テキストに基づいた実際の画像の分布を含む非常に豊かで複雑な分布をシミュレートすることが可能になりました。この能力のおかげで、以前は実現不可能だったテキストに基づいたランダムで多様なリアルなビジュアル素材の生成など、多数の応用が実現可能になりました。これらの画像モデルの成功を受けて、ビデオや3Dジオメトリなど、さまざまなドメインのモデリングも同様に下流応用において有益であることが最近の研究で示されています。 この論文では、Google Researchの研究者が、単一の画像内の各ピクセルのモーション、または画像空間のシーンモーションとして知られるものの生成先行をモデリングしています。このモデルは、大量の実際のビデオシーケンスから自動的に取得されるモーション軌跡を使用してトレーニングされます。トレーニングされたモデルは、入力画像に基づいてニューラル確率モーションテクスチャを予測し、各ピクセルの将来の軌跡を記述するモーション基底係数の集合を生成します。彼らはフーリエ級数を基底関数として選択し、風で揺れる木や花など、振動するダイナミクスを持つ現実世界の風景に限定して分析します。彼らは、拡散モデルを使用してニューラル確率モーションテクスチャを予測し、1回の予測で1つの周波数の係数を生成し、これらの予測を周波数帯域全体で調整します。 図1に示されているように、生成された周波数空間のテクスチャは、画像ベースのレンダリング拡散モデルを使用して密な長距離ピクセルモーション軌跡に変換され、静止画像をリアルなアニメーションに変換します。モーションキャプチャに関する先行研究と比較して、動画合成を行う従来の技術とは異なり、彼らのモーション表現はより一貫性のある長期的な生成とより細かい制御を可能にします。さらに、彼らは生成されたモーション表現が、シームレスにループするビデオの作成、誘発されたモーションの編集、ユーザーが適用した力に対してオブジェクトがどのように反応するかをシミュレートするインタラクティブなダイナミックイメージなど、さまざまな下流応用に容易に使用できることを示しています。

「Google ResearchがMediaPipe FaceStylizerを紹介:少数のショットでの効率的な顔スタイリゼーションのための設計」

近年、研究者や消費者は、拡張現実(AR)を組み合わせたスマートフォンアプリケーションに対する関心を高めています。これにより、ユーザーはリアルタイムで短いビデオ、VR、ゲームのために顔の特徴を生成し変更することができます。生成的対抗ネットワーク(GAN)アプローチに基づく顔の生成と編集モデルは、優れた品質を維持しながら軽量であるため、人気があります。しかし、ほとんどのGANモデルは、計算の複雑さに厳しい制限があり、膨大なトレーニングデータセットを必要とします。また、GANモデルの倫理的な使用も重要です。 Googleの研究者は、これらのモデルの複雑さとデータ効率性を考慮したfew-shot顔スタイリゼーションの効果的な解決策として、MediaPipe FaceStylizerを開発しました。このモデルでは、GANの逆変換が画像を顔生成器の潜在コーディングに変換します。彼らは、粗いから細かいまでの粒度で高品質の画像を生成するために、顔生成器用のモバイルフレンドリーな合成ネットワークを導入しました。このネットワークには、各生成器レベルで特徴をRGBに変換する補助ヘッドも備えています。さらに、彼らは教師StyleGANモデルから学生ジェネレータを蒸留し、前述の補助ヘッドの損失関数を注意深く設計し、共通のGAN損失関数と組み合わせることで、良好な生成品質を維持する軽量なモデルを作り出しました。MediaPipeは提案されたソリューションへのオープンソースアクセスを提供しています。MediaPipe Model Makerを使用すると、ユーザーはジェネレータを微調整して1つまたは数枚の写真からスタイルを学ぶことができます。MediaPipe FaceStylizerにより、結果のモデルをデバイス上の顔スタイリゼーションアプリケーションに展開することができます。 MediaPipe Faceスタイライザータスクのヘルプを受けて、画像やビデオの中の顔を強化またはゼロから作成することができます。この活動により、幅広い美的オプションを持つ仮想キャラクターが作成されることがあります。 このタスクには、顔生成器と顔エンコーダを含むBlazeFaceStylizerモデルが使用されます。StyleGANモデルファミリーの軽量な実装であるBlazeStyleGANは、与えられた美的に合わせた顔を生成および洗練します。顔エンコーダは、入力写真を顔生成器によって生成された顔と関連付けます。 このプロジェクトの目的は、MediaPipe FaceStylizerモデルを様々なスタイルに合わせて微調整するのに役立つパイプラインを提供することです。研究者は、GANの逆変換エンコーダと効果的な顔生成器モデルを使用して、顔スタイリゼーションパイプラインを構築しました(詳細は以下参照)。エンコーダとジェネレータのパイプラインは、さまざまなスタイルの少数の例でトレーニングすることができます。まず、ユーザーは目的の美意識の代表的なサンプルを1つまたは複数送信します。微調整手順では、エンコーダモジュールは凍結され、ジェネレータのみが調整されます。入力スタイル画像のエンコーディング出力周辺のいくつかの潜在コードをサンプリングしてジェネレータをトレーニングします。その後、共通の美意識のある画像と同じ美意識で顔画像を再構築するために、ジョイント対立損失関数を最適化します。この微調整プロセスにより、MediaPipe FaceStylizerはユーザーの入力に柔軟に対応することができます。この方法では、実際の人間の顔のテスト写真にスタイリゼーションを適用することができます。 Googleの研究チームは、BlazeStyleGANを教師モデルとして広く使用されているStyleGAN2を使って知識蒸留を行いました。さらに、学習プロセスにマルチスケールパーセプチュアル損失を導入することで、モデルがより良い画像を生成するようにトレーニングしました。BlazeStyleGANはMobileStyleGANよりもパラメータが少なく、モデルが簡素化されています。彼らはBlazeStyleGANをいくつかのモバイルデバイスでベンチマークテストし、モバイルGPUでリアルタイム速度で実行できることを示しました。BlazeStyleGANの出力は、教師モデルと非常に近い視覚的品質を持っています。彼らはまた、BlazeStyleGANが教師モデルによって生成されるアーティファクトを減らすことで、一部の状況で視覚的品質を向上させることができると述べています。BlazeStyleGANのFrechet Inception Distance(FID)の結果は、教師のStyleGANの結果と比較可能です。以下に貢献の概要を示します: 研究者は、各生成器レベルで追加のUpToRGBヘッドを追加し、推論中のみ使用することで、モバイルフレンドリーなアーキテクチャを作成しました。 補助ヘッドを使用してマルチスケールのパーセプチュアル損失を計算し、実際の画像に対する対立損失を計算することで、蒸留技術を向上させ、画像生成を改善し、教師モデルのアーティファクトの影響を軽減しました。 BlazeStyleGANは、さまざまな人気のあるスマートフォン上でリアルタイムで高品質の画像を生成することができます。 Googleの研究チームは、ほとんどのプレミアムスマートフォンでリアルタイムに高品質な顔写真を生成できる世界初のStyleGANモデル(BlazeStyleGAN)を開発しました。効率的なオンデバイス生成モデルにはまだ多くの探索の余地があります。教師モデルのアーティファクトの影響を軽減するために、StyleGAN合成ネットワークの洗練されたアーキテクチャと蒸留技術の微調整を行いました。BlazeStyleGANは、モデルの複雑さが大幅に削減されたため、モバイルデバイスでリアルタイムのパフォーマンスを実現することができます。

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.