Learn more about Search Results プロバイダー - Page 15

- You may be interested

- 「生成AIにおけるニューラル微分方程式の...

- 人間に戻る:AIの道:コードからぬいぐる...

- 「機械学習が間違いを comitte たとき、そ...

- 「機械学習とAIが偽のレビューを迅速に検...

- 『検索増強生成(RAG)の評価に向けた3ス...

- 「リトリーバル付き生成(RAG)の詳細」

- コンピュータビジョンの進歩:画像認識の...

- 「マイクロソフト、『極めて無責任』なセ...

- RayはNVIDIA AIとの協業により、開発者が...

- 「人工知能AIを搭載したトップのChrome拡...

- 「米中のチップ紛争に新たな戦線が開かれる」

- 「ジェンAIができることとできないことの5...

- 「ニューラルネットワークの多様性の力を...

- 「感覚AIの公開:人工汎用知能(AGI)の実...

- 『完全な初心者のための量子コンピューテ...

「コンプライアンス自動化標準ソリューション(COMPASS), パート1 パーソナと役割」

「これは私たちのシリーズの最初の部分であり、組織やクラウドプロバイダが連続的なコンプライアンスを達成しようとする際に直面する課題を説明しています」

TIIのFalcon 180B基本モデルは、Amazon SageMaker JumpStartを通じて利用可能です

今日は、テクノロジーイノベーション研究所(TII)が開発したFalcon 180B基礎モデルが、お客様がAmazon SageMaker JumpStartを通じて利用できることをお知らせいたしますこのモデルは、推論実行のためのワンクリック展開が可能ですFalcon 180Bは、1800億パラメータのサイズであり、3.5兆トークンの巨大なデータセットでトレーニングされていますFalcon 180Bは、公開された重みを持つ最大かつ最もパフォーマンスの高いモデルの一つですSageMaker JumpStartを使用して、このモデルをお試しいただけますSageMaker JumpStartは、アルゴリズム、モデル、および機械学習(ML)ソリューションへのアクセスを提供するMLハブであり、迅速にMLを始めることができますこの記事では、SageMaker JumpStartを介してFalcon 180Bモデルを発見して展開する方法について説明します

「Verbaに会ってください:自分自身のRAG検索増強生成パイプラインを構築し、LLMを内部ベースの出力に活用するためのオープンソースツール」

Verbaは、RAGアプリにシンプルで使いやすいインターフェースを提供するオープンソースプロジェクトです。データにダイブして関連する会話をすばやく開始することができます。 Verbaは、データのクエリと操作に関する単なるツールではなく、むしろコンパニオンです。文書間の書類作成、比較、数値セット間の対比、データ分析など、WeaviateとLarge Language Models(LLMs)を通じて、Verbaはこれらすべてを実現することができます。 Weaviateの先端的なGenerative Searchエンジンに基づいて、Verbaは検索を実行するたびに必要な背景情報を自動的に取得します。LLMsの処理能力を使用して、徹底的でコンテキストに即したソリューションを提供します。Verbaのわかりやすいレイアウトにより、これらすべての情報を簡単に取得することができます。Verbaのわかりやすいデータインポート機能は、.txt、.mdなどさまざまなファイル形式をサポートしています。データをWeaviateにフィードする前に、技術はデータのチャンキングとベクトル化を自動的に実行し、検索と取得に適した形式にします。 Verbaを使用する際には、Weaviateの作成モジュールとハイブリッド検索オプションを利用してください。これらの高度な検索方法は、重要な文脈の断片を探し出すために論文をスキャンし、それを元にLarge Language Modelsが照会に対して詳細な応答を提供します。 将来の検索の速度を向上させるために、Verbaは生成された結果とクエリをWeaviateのSemantic Cacheに埋め込みます。質問に答える前に、VerbaはSemantic Cacheを調べて、すでに似たような質問に回答されているかどうかを判断します。 データ入力とクエリ機能を有効にするには、デプロイメントの方法に関係なくOpenAI APIキーが必要です。プロジェクトをクローンする際に、APIキーをシステムの環境変数に追加するか、.envファイルを作成してください。 Verbaは、特定のユースケースに応じてさまざまな方法でWeaviateインスタンスに接続することができます。VERBA_URLおよびVERBA_API_KEYの環境変数が存在しない場合、VerbaはWeaviate Embeddedを使用します。プロトタイピングやテストのためにWeaviateデータベースを起動する最も簡単な方法は、このローカルデプロイメントです。 Verbaは、さらなる処理のためのデータのインポートに関する簡単な指示を提供します。続行する前に、OpenAIアクセスキーの設定に基づいてデータのインポートにはお金がかかることに注意してください。OpenAIモデルはVerbaのみで使用されます。APIキーの料金はこれらのモデルの使用料にかかります。データの埋め込みと回答の生成が主なコスト要素です。 https://verba.weaviate.io/ で試すことができます。 Verbaには3つの主要なパートがあります: Weaviate Cloud Service(WCS)またはサーバー上でWeaviateデータベースをホストすることができます。 このFastAPIエンドポイントは、Large…

「なぜデータパイプラインには閉ループフィードバック制御が必要なのか」

クラウド上でデータチームがスケールアップするにつれて、データプラットフォームチームは、彼らが責任を持つワークロードがビジネス目標を満たしていることを確保する必要があります データエンジニアが数十人いる規模での実施...

「LeanTaaSの創設者兼CEO、モハン・ギリダラダスによるインタビューシリーズ」

モーハン・ギリダラダスは、AIを活用したSaaSベースのキャパシティ管理、スタッフ配置、患者フローのソフトウェアを提供する市場リーダーであるLeanTaaSの創業者兼CEOです同社のソフトウェアは、全国の175以上の医療システムで使用されていますLeanTaaSは最近、10億ドル以上の評価額を達成した最初のデジタルヘルス企業となりました

「RunPodを使用した生成的LLMsの実行 | サーバーレスプラットフォーム」

イントロダクション サーバーレスは、クラウドコンピューティングにおける画期的な戦略として浮上しています。開発者がアプリケーションの作成に完全に集中できる一方、基盤となるインフラストラクチャはクラウドプロバイダーが管理します。Generative AI Large Language Modelsは、これらの言語モデルが使用する高いGPU VRAMのため、ほとんどの開発者がローカルで実行できないため、Serverless GPUsの成長を後押ししています。RunPodは、リモートGPUサービスで人気が高まっているプラットフォームの1つです。RunPodは、GPUインスタンス、Serverless GPUs、APIエンドポイントなどのさまざまなコンピューティングサービスを提供することで、大規模な言語モデルを使用したアプリケーションの構築およびテストに強力なGPUへのアクセスを提供します。手頃な価格とさまざまなGPUの可能性があるため、リソース集約型の大規模言語モデルの実行には、RunPodでLLMsを学習してください。 学習目標 サーバーレスの概念と、LLMsで作業する開発者にとってなぜ役立つのかを学ぶ 大規模言語モデルを実行するための高いGPU VRAMの必要性を理解する クラウドでGPUインスタンスを作成して言語モデルを実行する方法を学ぶ LLMのサイズに基づいてGPU VRAMを割り当てる方法を学ぶ この記事は、Data Science Blogathonの一環として公開されました。 サーバーレスとは何ですか? サーバーレスは、クラウドプラットフォームのサービス/メソッドであり、開発とアプリケーションの展開に必要なインフラストラクチャをオンデマンドで提供します。サーバーレスでは、アプリケーションの開発に集中し、クラウドプロバイダーに基盤の管理を任せることができます。AWS、Azure、GCPなどの多くのクラウドプラットフォームがこれらのサービスを提供しています。 近年、サーバーレスGPUが人気を集めています。サーバーレスGPUは、メモリが不足している場合にクラウド上でGPUの計算能力を借りることです。大規模な言語モデルの導入以来、これらのサーバーレスプラットフォームは次々と台頭し、他のプラットフォームよりも優れたGPUサービスを提供しています。RunPodはそのようなサービスの1つです。 RunPodについて RunPodは、GPUインスタンス、Serverless…

「Llama 2をローカルでダウンロードしてアクセスする方法は2つあります」

メタの最新リリースであるLlama 2は、さまざまなユースケースにおいて人気を集め、非常に興味深いです7Bから始まる異なるサイズのLlama 2言語モデルをプリトレーニングおよびファインチューニングして提供しています

このAIニュースレターは、あなたが必要なすべてです#63

「AIの今週のハイライトでは、Large Language Models(LLM)の採用による西洋市場での収益成長のさらなる証拠と、新しいAIモデルの導入を紹介しています...」

なぜITスタッフオーグメンテーションを選ぶのですか?

テックプロジェクトの世界では、組織はしばしば2つの主要なデリバリーフレームワーク、つまりITスタッフの補完とプロジェクトのアウトソーシングの間を行ったり来たりしますこれらはいくつかの属性を共有していますが、その中心的な違いはコントロールと範囲にありますスタッフの補完は、専門知識を持つ人材を使って既存のチームを強化することができ、より多くのコントロールを得ることができます一方、アウトソーシングは…なぜITスタッフの補完を選ぶのですか? 詳しくはこちらをご覧ください

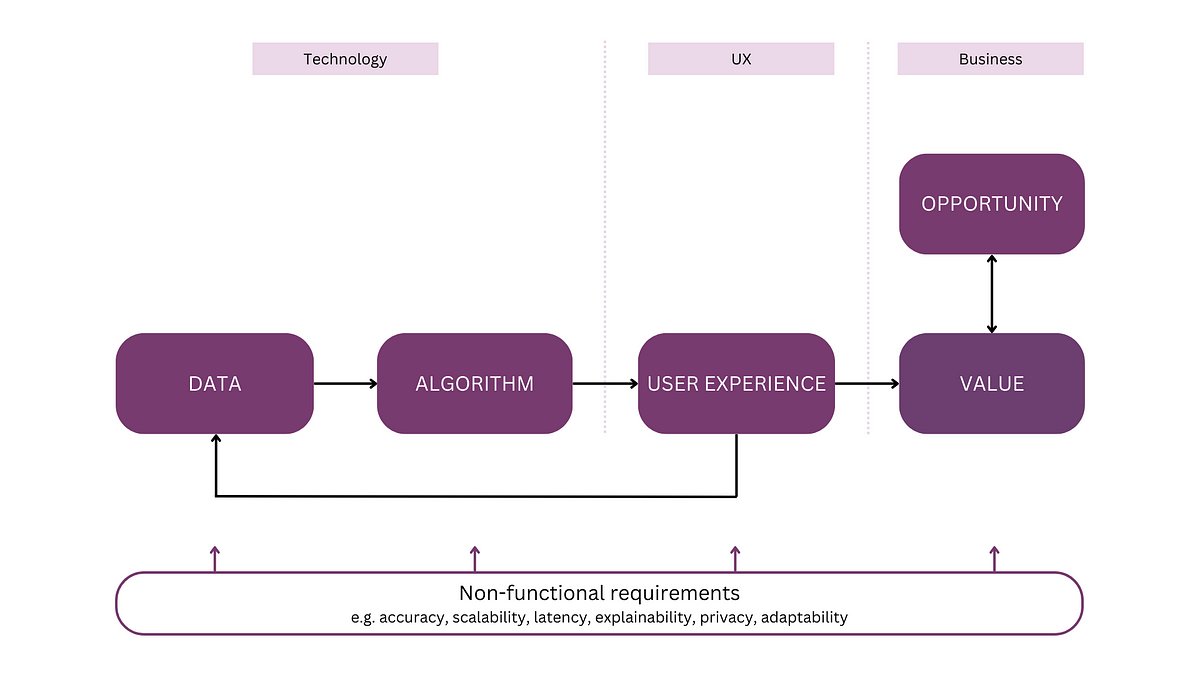

「全体的なメンタルモデルを持つAI製品の開発」

注:この記事は「AIアプリケーションの解析」というシリーズの最初の記事ですこのシリーズでは、AIシステムのためのメンタルモデルを紹介しますこのモデルは、議論や計画、そして...のためのツールとして機能します

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.