Learn more about Search Results EU - Page 158

- You may be interested

- このAI研究は、パーソン再識別に適したデ...

- 「データサイエンティストプロフェッショ...

- 「Gensimを使ったWord2Vecのステップバイ...

- 「医療保険の種類と現代の技術」

- スコア! チームNVIDIAが推薦システムでト...

- 真菌アーキテクチャと論理バクテリア

- ミストラルAIは、パワフルなスパースな専...

- 「SPHINXをご紹介します:トレーニングタ...

- 「キャリアのために右にスワイプ:仕事の...

- 「マスタリングモンテカルロ:より良い機...

- 「LLMsを使用したEコマース製品検索の強化」

- 「LAMPをご紹介します:テキストからイメ...

- グーグルとコーネル大学の研究者がDynIBaR...

- 「ジェネラティブAI:2024年の人事におけ...

- 2024年にデータアナリストになるための学...

大規模言語モデル(LLM)に関する驚くべき8つの事実

近年、大規模言語モデル(LLM)の公開的な展開が広範な関心と活動を引き起こしています。新しい技術がもたらす切迫した懸念があるため、この焦点は正当化されていますが、いくつかの重要な要因を見落とすこともあります。 最近では、ChatGPTなどのLLMとそれらに基づく製品について、ジャーナリスト、政策立案者、学者から様々な分野で関心が高まっています。しかし、この技術が多くの点で驚くべきものであるため、簡潔な説明では重要な詳細が抜け落ちることがあります。 以下に、この技術に関する8つの予想外の側面があります。 LLMの機能は、意図的なイノベーションがなくても、投資が増えるにつれて予測可能に増加します。 LLMに対する研究や投資の増加は、スケーリング法則の結果と言えます。研究者が将来のモデルに与えるデータの量、モデルのサイズ(パラメーターで測定)、およびトレーニングに使用されるコンピューティングの量を増やすと、スケーリング法則により、それらのモデルがどの程度能力があるか(FLOPsで測定)を精確に予測できます。そのため、コストのかかる実験を行うことなく、特定の予算内で最適なモデルのサイズなど、重要な設計上の決定を行うことができます。 予測の精度は、現代の人工知能研究の文脈でも前例のないレベルです。R&Dチームが経済的に有益なシステムを開発することに成功することが期待される多数のモデルトレーニングイニシアチブを提供することができるため、投資を推進するための有力な手段でもあります。 最新のLLMのトレーニング方法はまだ公開されていませんが、最近の詳細な報告によると、これらのシステムの基本的なアーキテクチャは、ほとんど変わっていないとされています。 LLMにリソースが注がれると、予想外に重要な行動がしばしば現れます。 ほとんどの場合、モデルが未完了のテキストの続きを正確に予測できる能力は、プレトレーニングテストの損失によって測定され、スケーリング規則によってのみ予測できます。 この指標は平均的に多くの実用的な活動におけるモデルの有用性と相関しますが、モデルが特定の才能を発揮し始めたり、特定のタスクを実行できるようになるタイミングを予測することは容易ではありません。 具体的には、GPT-3のfew-shot learning(つまり、1回の相互作用で新しいタスクを少数の例から学習する能力)や、chain-of-thought reasoning(つまり、数学のテストで生徒が行うように、難しいタスクの理由を書き出し、改善されたパフォーマンスを示す能力)などは、現代のLLMの中で最初のものとして際立っています。 将来のLLMは必要な機能を開発する可能性があり、一般的に受け入れられている境界はほとんどありません。 ただし、LLMの進歩は、専門家の予想よりも予期せぬものであることがあります。 LLMは、外部世界の表現を獲得し利用することがよくあります。 ますます多くの証拠が、LLMが世界の内部表現を構築し、テキストの特定の言語形式に対して無関心な抽象レベルで推論することを可能にしていることを示しています。この現象の証拠は、最大かつ最新のモデルで最も強力であるため、システムがより大規模にスケールアップされるとより堅牢になることが予想されます。ただし、現在のLLMはこれをより効果的に行う必要があります。 広範な実験技術や理論モデルに基づく以下の調査結果が、この主張を支持しています。 モデルの内部色表現は、人間が色を知覚する方法に関する経験的な知見と非常に一致しています。 モデルは、著者の知識や信念を推測し、文書の将来の方向性を予測することができます。 物語はモデルに情報を提供し、それが物語に表現されているオブジェクトの特徴や位置の内部表現を変更します。 モデルは、奇妙なものを紙に描く方法を提供することがあります。 Winograd Schema…

アーティストやクリエイターにとって最高のAIツール(2023年)

Otter.AI Otter.aiは、効率的なミーティングや会話の録音と記述を行うためのAIパワードプラットフォームです。自動音声認識を使用して、リアルタイムで暗号化され、簡単にアクセス可能で共有可能なノートを任意の議論から書き留めます。Otterは、Zoom、Microsoft Teams、Google Meetなどの一般的なプラットフォームで即座にミーティングに出席して録音することができます。私たちは、簡単に共有でき、重要なトピックを強調し、責任を割り当てる要約を作成します。Otterは、ビジネス、教育、個人の文脈で使用されているiOS、Android、Chromeの時間節約アプリです。精度、適応性(異なるスピーカーからの転写が可能)、時間節約の自動スライドキャプチャ機能に高い評価を受けています。 Runway 人工知能(A.I.)がRunwayを駆動する、コンテンツ作成プラットフォームで、人々がコンテンツを公開、編集、協力できるようにします。無制限の写真、テキストから画像の生成、消去と置換、テキストからカラーグレーディング、スーパースローモーション、A.I.トレーニングなど、AIが駆使された革新的な機能があります。グリーンスクリーン、インペインティング、モーショントラッキングは、ビデオ編集の機能の一部です。Runwayは、コンテンツ作成とビデオ編集の骨の折れる作業を効率化し、ユーザーが最終製品に完全に決定権を持つようにします。ソフトウェアには、安全に作曲、リソース、プロジェクトデータを共有するためのツールも含まれています。さらに、Runwayは、数分で変更できる専門的にデザインされたテンプレートの大規模なライブラリにアクセスできるようにしています。 DreamStudio DreamStudioは、テキストに基づいて画像を生成するために人工知能を使用するコンピュータプログラムです。プラットフォームは、高品質の画像を作成する能力でよく知られているStable Diffusionと呼ばれる生成対抗ネットワーク(GAN)技術を使用しています。DreamStudioの多くの有用な機能は、アーティストやデザイナーにとって優れたリソースとなっています。テキストの説明から画像を作成する、インスピレーションとしての画像のインポート、スタイルバリアントの探索などが利用可能です。組み込みのアーカイブにより、ユーザーは以前の貢献を振り返ることができます。DreamStudioは、まだ開発初期の段階ではありますが、クリエイティブなタイプの間で人気が急速に高まっています。このプラットフォームは、画像作成プロセスを根本的に変える可能性があるため、注目されています。 Synthesia Synthesiaは、A.I.ビデオを生成するためのプラットフォームで、A.I.ビデオを簡単かつ低コストで作成することができます。編集プログラムに触れることなく、誰でも本物の人物が主演のプロフェッショナルなビデオを作成できるブラウザ拡張機能です。 Synthesiaには、85種類以上の異なるタイプのA.I.アバター、120種類の異なる言語と方言、55種類の事前設計されたテンプレート、独自のA.I.アバターの作成が可能です。このプラットフォームには、カスタマーサポートや製品マーケティング映像から新しい従業員向けの内部トレーニング映像まで、さまざまな用途があります。 Synthesiaは、ビデオ制作コストを最大80%削減できる能力を持つため、様々な規模の30,000以上の企業が信頼しています。 Raw Shorts Raw Shortsは、テキストからビデオを作成するクリエイターや、Webやソーシャルメディア向けの説明映像、アニメーション、プロモーション映像を作成するためのテキスト-to-videoクリエーターと人工知能によるビデオエディターを提供することで、組織が作成を支援します。機械学習技術を使用して、脚本を読み取り、プロットポイントを抽出して適切なメディアを見つけます。任意のWebブラウザからアクセスできるプラットフォームには、テキストtoスピーチ、ダイナミックグラフィック、100万以上のメディアファイルなどの高度なツールが備わっています。A.I.があなたの映画の初期カットを生成し、ドラッグアンドドロップエディターで細かく調整して、望むように見せることができます。Capital One、American Airlines、Coca-Cola、IBM、Ocean Spray、Nielsen、Sony、Pfizerなどの有名企業が、Raw Shortsを信頼しています。 Murf AI Murf…

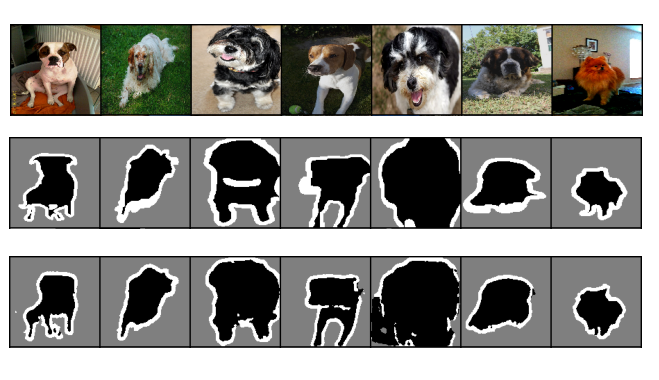

PyTorchを使った効率的な画像セグメンテーション:Part 2

これは、PyTorchを使用してディープラーニング技術を使ってゼロから画像セグメンテーションをステップバイステップで実装する4部作シリーズの第2部ですこの部分では、ベースライン画像の実装に焦点を当てます...

PyTorchを使用した効率的な画像セグメンテーション:パート3

この4部シリーズでは、PyTorchを使用して深層学習技術を使い、画像セグメンテーションをスクラッチからステップバイステップで実装しますこのパートでは、CNNベースラインモデルを最適化することに焦点を当てます

人工知能によって設計された薬剤が、人間の試験のために準備ができました

中国の複合企業フォン・グループとプライベートエクイティ企業ウォルバーグ・ピンカスに支援されたバイオテック企業Insilico Medicineは、人工知能(AI)だけで発見および設計された薬剤の中でも初めての中間段階の人間試験の1つを開始しました。Insilicoは、生成AIを使用して新しい薬剤のターゲットを選択し、特定の疾患に対処することができる分子を設計します。これは医療産業にとって重要なマイルストーンです。これらの臨床試験と医療産業への影響について知っておく必要があるすべてがここにあります。 また読む:画期的ニュース:FDAがイーロン・マスクのニューラリンクに人間試験の承認を与える 初めてのAI設計薬剤が第2相臨床試験に入る Insilicoは、INS018_055という薬剤の中間段階の人間試験を開始し、重要な成果を上げました。これにより、完全に人工知能によって発見および設計された最初の薬剤が第2相臨床試験に入ることになります。この驚異的なマイルストーンは、薬剤開発における重要なステップを表し、製薬業界の新しい可能性を開くものです。 InsilicoとAI産業全体にとって重要な瞬間 この画期的な薬剤の背後にあるバイオテック企業であるInsilicoは、今や真実の瞬間に直面しています。同社CEOのアレックス・ジャボロンコフ博士によると、この試験はInsilicoのテストであり、AIが製薬業界全体の可能性を批判的に検証するものです。ジャボロンコフ博士は、Insilicoが大手製薬会社の生産性を2倍にできると大胆に主張し、薬剤発見におけるAIの変革的な力を示しています。 また読む:2023年の医療における機械学習とAI AIを活用したバイオテック企業の出現 Insilicoは、AIツールを応用して薬剤開発を革新しようとして数十億ドルを調達した新しいバイオテック企業の一つです。Morgan Stanleyによると、製薬部門におけるAIの市場機会は約500億ドルと推定されており、これらの企業はその市場機会を活用しています。Insilicoの薬剤試験は、医学の未来を形作る人工知能の潜在能力を証明しています。 また読む:ギャップを埋める:薬剤発見とAI InsilicoのAIプラットフォーム:コスト削減と時間短縮 ジャボロンコフ博士は、彼らのプラットフォームが薬剤発見にかかる時間を半分にし、市場に投入する平均費用を大幅に削減できると断言しています。Deloitteによると、治療法1つあたりの平均費用は23億ドルと推定されています。Insilicoの先進的なプラットフォームは、生成AIを利用して、体内の新しい薬剤のターゲットを迅速に特定し、特定の疾患に効果的に対処できる分子を設計します。膨大な量のデータを処理できるこの能力により、薬剤発見プロセスが迅速化され、前臨床の発見に何年もの時間を節約できる可能性があります。臨床開発中に節約できる時間は限られていますが、AIによる改善された化学およびターゲット選択は、薬剤の成功の可能性を大幅に向上させます。 主要製薬会社との戦略的パートナーシップ InsilicoのAIによる薬剤開発に対する取り組みは注目されています。Sanofi、Fosun、Johnson & Johnsonなどの大手製薬会社は、InsilicoのAIプラットフォームの潜在力を認め、戦略的パートナーシップを締結しました。これらの協力関係により、これらの業界リーダーの薬剤発見パイプラインにInsilicoの先進的な技術を統合することができ、製薬研究開発の革新的な可能性がさらに確認されました。 AIの力を解き放つ:迅速な薬剤ターゲットの特定 薬剤発見における人工知能の真の強みは、体内の疾患関連タンパク質を迅速に特定し、効果的な薬剤に変換できる分子を特定することができる能力にあります。膨大な量のデータを処理できるAIプラットフォームは、薬剤ターゲットの特定において貴重なサポートを提供し、研究者がより効率的に革新的なソリューションを開発するのを支援します。 また読む:ライフブループリントの解読:AIのジーンフォーマー 薬剤開発におけるAIの台頭:有望なイノベーション Insilicoは、AIおよび機械学習ツールの支援を受けて進展した薬剤を発表した、Exscientia、Verge Genomics、Recursion…

グリーンAI:AIの持続可能性を向上させるための方法とソリューション

もし、あなたがこの記事を開いたのであれば、おそらく現在の大規模言語モデル(LLM)の安全性と信頼性に関する現在の論争について聞いたことがあるでしょう有名な人々によって署名された公開書簡...

Allen Institute for AI の研究者が、自然言語の指示に基づいて複雑で構成的な視覚的タスクを解決するための神経記号アプローチである VISPROG を紹介します

汎用AIシステムを探すことで、熟練したエンドツーエンドトレーニングモデルの開発が促進され、多くのモデルがユーザーがモデルと対話するためのシンプルな自然言語インターフェースを提供することを目的としています。大規模な自己教示学習に続く監視多目的学習がこれらのシステムを開発するための最も一般的な方法でした。彼らは最終的に、これらのシステムが困難なジョブの無限長尾にスケールするように望んでいます。しかしながら、この戦略は各タスクについて慎重に選択されたデータセットが必要です。自然言語で述べられた困難なアクティビティを、エンドツーエンドトレーニングされた特殊なモデルや他のプログラムが処理できるように、より単純なフェーズに分解することにより、この作業では大言語モデルを使用して複雑なタスクの長い尾を処理する方法について研究しています。 「この画像からBig Bang Theoryの7人の主要キャラクターをタグ付けしてください」とコンピュータビジョンプログラムに伝えます。システムは、以下の手順を実行する前に、指示の目的を最初に理解する必要があります。顔を検出し、知識ベースからBig Bang Theoryの主要キャラクターのリストを取得し、キャラクターリストを使用して顔を分類し、認識されたキャラクターの名前と顔を画像にタグ付けします。いくつかのビジョンおよび言語システムが各タスクを実行できますが、自然言語タスクの実行はエンドツーエンドトレーニングシステムの範囲外です。 図1:組成ビジュアル推論のためのモジュラーで解釈可能なニューロシンボリックシステム-VISPROG。 VISPROGは、自然言語の指示の少数のインスタンスと必要な高レベルのプログラムが与えられたGPT-3内の文脈学習を使用して、新しい指示ごとにプログラムを作成し、プログラムを入力画像に実行して予測を取得します。さらに、VISPROGは中間出力を理解可能な視覚的な正当化に縮小します。知識検索、算術、論理操作のさまざまなモジュールを組み合わせる呼び出しを行うジョブを実行するためにVISPROGを使用します。また、画像の分析と操作にも使用します。 AI研究所の研究者は、VISPROGと呼ばれるプログラムを提案しました。このプログラムは、視覚情報(単一の画像または画像のコレクション)と自然言語命令を入力とし、一連の命令、すなわちビジュアルプログラムを作成し、これらの命令を実行して必要な結果を生成します。ビジュアルプログラムの各行は、システムが現在サポートしている多くのモジュールの1つを呼び出します。モジュールは、事前に構築された言語モデル、OpenCV画像処理サブルーチン、算術および論理演算子であることができます。また、事前に構築されたコンピュータビジョンモデルにすることもできます。コードの前の行を実行して生成された入力は、モジュールによって消費され、後で使用できる中間出力を生成します。 前述の例では、VISPROGが作成したビジュアルプログラムで、顔検出器、GPT-3を知識検索システムとして、CLIPをopen-vocabulary画像分類器として使用して必要な出力を提供します(図1を参照)。VISPROGによってビジョンアプリケーションのプログラムの生成と実行の両方が向上します。ニューラルモジュールネットワーク(NMN)は、専門の、微分可能なニューラルモジュールを組み合わせて、ビジュアル質問応答(VQA)問題のための質問固有のエンドツーエンドトレーニング可能なネットワークを作成します。これらの方法は、REINFORCEの弱い回答監視を使用してレイアウトジェネレータをトレーニングするか、脆弱な、事前に構築された意味解析器を使用してモジュールのレイアウトを決定的に生成します。 対照的に、VISPROGは、強力な言語モデル(GPT-3)と文脈に限定された例を使用して、事前のトレーニングなしに複雑なプログラムを構築できるようにします。訓練された最先端のモデル、非ニューラルPythonサブルーチン、およびNMNよりも高い抽象レベルを呼び出すことにより、VISPROGプログラムはNMNよりも抽象的です。これらの利点により、VISPROGは迅速で効果的で柔軟なニューロシンボリックシステムです。さらに、VISPROGは非常に解釈可能です。まず、VISPROGは、ユーザーが確認できる論理的な正確さを持つ理解しやすいプログラムを作成します。第二に、予測を管理可能な部分に分解することにより、VISPROGはユーザーが中間段階の結果を調べて欠陥を見つけ、必要に応じてロジックを修正できるようにします。 予測の視覚的な正当化として、テキスト、バウンディングボックス、セグメンテーションマスク、生成された画像などの中間ステップの出力が接続された完成したプログラムが、情報の流れを示すために役立ちます。彼らはVISPROGを4つの異なる活動に使用して、その汎用性を紹介しています。これらのタスクには、一般的なスキル(画像解析など)が必要ですが、専門的な思考力と視覚的な操作スキルも必要です。これらのタスクには以下が含まれます: 構成的な視覚的質問に答えること。 画像ペアに対するゼロショットNLVR。 NL指示からの事実知識オブジェクトラベリング。 言語による画像操作。 彼らは、モジュールまたは言語モデルのいずれもが変更されていないことを強調しています。自然言語のコマンドと適切なプログラムのいくつかの文脈の例があれば、VISPROGを任意のタスクに適応することができます。VISPROGは使いやすく、構成的なVQAテストで2.7ポイントの大幅な利益、NLVRのゼロショットの正確さが62.4%、そして知識タグ付けと画像編集のタスクでの質的・量的な結果が良好です。

VRスーツはあなたがメタバース内で「感じる」ことができるようになるかもしれません

スイスのETHチューリッヒのエンジニアたちは、完全な全身触覚スーツを構築し、没入型仮想現実体験を増幅するために使用されています

これをデジタルパペットにしてください:GenMMは、単一の例を使用して動きを合成できるAIモデルです

コンピュータ生成のアニメーションは、毎日より現実的になっています。この進歩は、ビデオゲームで最もよく見ることができます。トゥームレイダーシリーズの最初のララ・クロフトと最新のララ・クロフトを考えてみてください。私たちは、230ポリゴンのパペットがおかしな動きをするのから、スクリーン上でスムーズに動くリアルなキャラクターに移行しました。 コンピュータアニメーションで自然で多様な動きを生成することは、長年にわたって難しい問題でした。モーションキャプチャシステムや手動アニメーション作成などの従来の方法は、高価で時間がかかり、スタイル、骨格構造、モデルタイプに多様性が欠けた動きのデータセットに結果をもたらします。アニメーション生成のこの手動で時間がかかる性質は、業界に自動化された解決策が必要とされています。 既存のデータ駆動型のモーション合成手法は、その効果が限定的です。しかし、近年、ディープラーニングがコンピュータアニメーションにおいて多様で現実的な動きを生成することができる強力な技術として登場しました。大規模かつ包括的なデータセットでトレーニングされた場合、多様で現実的な動きを合成できます。 ディープラーニング手法は、モーション合成において印象的な結果を示していますが、実用的な適用性が制限される欠点があります。まず、長時間のトレーニングが必要であり、アニメーションの製作パイプラインにおいて大きなボトルネックとなる可能性があります。さらに、ジッタリングや過度なスムージングなどの視覚的なアーティファクトが生じるため、合成された動きの品質に影響を与えます。最後に、複雑な骨格構造にスケーリングするのが困難であるため、複雑な動きが必要なシナリオで使用が制限されます。 私たちは、実用的なシナリオで適用できる信頼性のあるモーション合成手法が需要があると知っています。しかし、これらの問題を克服することは容易ではありません。では、解決策は何でしょうか?それでは、GenMMに出会う時間です。 GenMM は、モーション最近傍とモーションマッチングの古典的なアイデアに基づく代替アプローチです。キャラクターアニメーションに広く使用されるモーションマッチングを利用し、自然に見え、さまざまなローカルコンテキストに適応した高品質のアニメーションを生成します。 GenMMは、単一の入力を使用してモーションを生成できます。出典:http://weiyuli.xyz/GenMM/ GenMM は、単一または少数の例のシーケンスから多様な動きを抽出できる生成モデルです。これは、自然な動き空間全体の近似として広範なモーションキャプチャデータベースを活用することによって達成されます。 GenMM は、新しい生成コスト関数として双方向の類似性を組み込んでいます。この類似度測定により、合成されたモーションシーケンスには提供された例からのモーションパッチのみが含まれ、その逆も同様です。このアプローチは、モーションマッチングの品質を維持しながら、生成能力を可能にします。多様性をさらに高めるために、例と比較して分布の不一致が最小限に抑えられたモーションシーケンスを段階的に合成するマルチステージフレームワークを利用しています。また、画像合成におけるGANベースの手法の成功に着想を得て、パイプラインに対して無条件のノイズ入力が導入され、高度に多様な合成結果が実現されています。 GenMMの概要。出典:https://arxiv.org/pdf/2306.00378.pdf 多様なモーション生成能力に加え、GenMMは、モーションマッチング単独の能力を超えたさまざまなシナリオに拡張できる汎用的なフレームワークであることが証明されています。これには、モーション補完、キーフレームによる生成、無限ループ、モーション再構成が含まれ、生成モーションマッチングアプローチによって可能になる広範なアプリケーションの範囲を示しています。

メタAIのもう一つの革命的な大規模モデル — 画像特徴抽出のためのDINOv2

Mete AIは、画像から自動的に視覚的な特徴を抽出する新しい画像特徴抽出モデルDINOv2の新バージョンを紹介しましたこれはAIの分野でのもう一つの革命的な進歩です...

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.