Learn more about Search Results 14 - Page 140

- You may be interested

- 「自己教師あり学習とトランスフォーマー...

- 「2023年のトップ50以上のAIコーディング...

- 制約最適化とKKT条件

- 「AWSサービスを使用して完全なウェブアプ...

- 高度なプロンプトエンジニアリング

- ウェブサイトビルディングにおけるAIの台...

- Pythonでの機械学習のためのテキストの前...

- 私はスポティファイで3回の大量解雇を乗り...

- 「2030年までに注目すべき7つの先駆的なAI...

- ネットワークの強化:異常検知のためのML...

- 「現代の自然言語処理:詳細な概要パート3...

- 「ヘルスケアとゲノミクス産業が機械学習...

- 「シェアレンティングの危険性:オンライ...

- (LLMを活用した こきゃくセグメンテーショ...

- 「10/7から16/7までのトップコンピュータ...

ミッドジャーニープロンプトのTシャツデザイン

Tシャツビジネス帝国を築きたい場合は、Midjourneyは美しいTシャツデザインを作成するための素晴らしいツールです

生産性向上のための10の最高のAIツール(決定版リスト)

時間を取り戻したい、同僚を凌駕したい、そして好きなことにもっと時間を費やしたいのであれば、AIツールを使用することは明白です

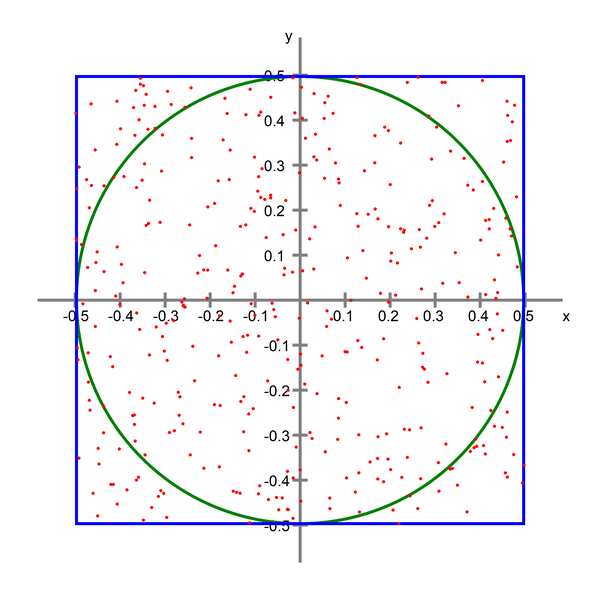

次元の呪いの真の範囲を可視化する

非常に多くの特徴を持つ観測の振る舞いを視覚化するために、モンテカルロ法を使用する

LangFlow | LLMを使用してアプリケーションを開発するためのLangChainのUI

イントロダクション 大規模言語モデルは世界中で大きな話題となっています。ChatGPT、GPT3、Bardなどの大規模言語モデルが登場することで、開発者はこれらのモデルを活用して新しい製品ソリューションを開発し続けています。新しいバージョンの大規模言語モデルや新しいモデルが毎日登場するため、これらに追いつくことは問題です。各大規模言語モデルのドキュメントを調べる必要があります。LangChainは、さまざまな大規模言語モデルにラップされたライブラリであり、作業を容易にします。さらに、LangChainに基づいたUIであるLangFlowは、直接アプリケーションを作成および操作できるようになり、作業がより簡単になりました。 学習目標 LangFlow UIの理解 LangFlowのインストールと操作 LangFlowの内部機能の理解 LangFlowを使用してアプリケーションを作成する LangFlowを通じて作成したアプリケーションの共有 この記事は、Data Science Blogathonの一環として公開されました。 LangFlowとは何か、なぜLangFlowを使用するのか LangFlowは、react-flowを使用して設計されたPythonパッケージであるLangChainに基づいたグラフィカルなUIです。LangChainは、大規模言語モデルを使用してアプリケーションを作成するためのPythonパッケージです。エージェント、大規模言語モデル、チェーン、メモリ、プロンプトなど、さまざまなコンポーネントで構成されています。開発者はこれらのブロックを連結させてアプリケーションを作成します。LangChainには、ほとんどの人気のある大規模言語モデルのラッパーが含まれています。しかし、LangChainを使用するには、アプリケーションを作成するためのコードを書く必要があります。コードを書くことは、時間がかかることもあり、エラーを引き起こすこともあります。 ここでLangFlowが登場します。LangFlowはLangChainに基づいたグラフィカルなUIです。LangChainで提供されるすべてのコンポーネントが含まれています。LangFlowはドラッグアンドドロップ機能を提供しており、コンポーネントをスクリーン上にドラッグして大規模言語モデルからアプリケーションを構築できます。さらに、誰でも使える豊富な例も含まれています。この記事では、このUIについて説明し、それを使用してアプリケーションを構築する方法を説明します。 Langflowを始めましょう LangFlowとは何か、およびその機能の理解を深めるために、これからLangFlowについて詳しく見ていきましょう。LangFlow UIはJavaScriptとPythonの両方で利用できます。どちらかを選んで使用することができます。Pythonのバージョンを使用する場合、システムにPythonがインストールされている必要があり、LangChainライブラリも必要です。 LangFlowを使用するには、次のパッケージが必要です pip install langchain pip install…

Amazon AIコンテンツモデレーションサービスを使用した安全な画像生成と拡散モデル

生成AI技術は急速に進化しており、テキスト入力に基づいてテキストや画像を生成することが可能になっていますStable Diffusionは、写真のようなリアルなアプリケーションを作成するためのテキストから画像へのモデルですAmazon SageMaker JumpStartを通じて、Stable Diffusionモデルを使用してテキストから簡単に画像を生成することができます以下は、テキスト入力とそれに対応する画像の例です

Amazon SageMaker Canvasを使用して、ノーコードの機械学習を活用して、公衆衛生の洞察をより迅速にキャプチャーしましょう

公衆衛生機関は、さまざまな種類の疾病、健康のトレンド、危険因子に関する豊富なデータを保有しています彼らのスタッフは、長年にわたり統計モデルや回帰分析を使用して、治療薬を用いた疾病の最も高いリスク要因を持つ人口を対象にするなど、重要な決定を行ってきましたまた、懸念される感染症の進行を予測するためのモデルも使われています

誰が雨を止めるのか? 科学者が気候協力を呼びかける

トップの科学者3人が、コンピューティング史上最も野心的な取り組みの一環として、地球のデジタルツインの構築を支援しています。 ピーター・バウアー、ビョルン・スティーブンス、フランシスコ「パコ」ドブラス・レジェスは、地球のデジタルツインが1キロメートルの解像度まで対応する必要があると考えており、気候変動のリスクとそれに適応する方法を探るために、利用者の数が増えるにつれて要件が増すと述べています。彼らは、この取り組みには高速なコンピューティング、AI、そして多くの協力が必要であると言います。 彼らのヒューズリアンな取り組みは、すでにNVIDIAの技術を使用しており、この共通の目的に対するNVIDIAの貢献であるEarth-2をインスピレーションとしています。 2021年末にEarth-2の取り組みを発表した際、NVIDIAの創設者兼CEOであるジェンスン・ホアンは、「私たちは自社の規模と計算科学の専門知識をNVIDIAの直接の支援として捧げ、世界の気候科学コミュニティと共に行動します」と述べています。 前例のないスケールで協力 ホアンのコミットメントは、地球のデジタルツインを作成するためのパンヨーロッパプロジェクトであるDestination Earth(DestinE)などの取り組みを支援することを示しています。 「それに対応するには単一のコンピューターでは十分ではないため、分散型の国際的な取り組みが必要です」とバウアーは述べています。バウアーは、ヨーロッパのトップ気象予報センターで20年以上の経験を持ち、2030年までに地球規模のモデルを利用可能にすることを目指すプロジェクトを率いています。 彼は昨年、ネイチャー誌で共著者となり、「前例のないスケールでの協力が必要である」と述べています。 バウアーは、新しい地球情報システムにおける広範な国際協力を呼びかけています。 バウアーは3月のGTCでの講演で、NVIDIAを含む多くの国と民間企業からのリソースを動員する「連邦」を想像しています。 ピーター・バウアー こうしたリソースによって、新しい数値モデルや機械学習モデルの開発、そして数十年にわたる予測を行うための大規模な推論ジョブの実行など、膨大な作業が可能になります。 DestinEは2008年の気候会議にそのルーツを持ち、欧州中期天気予報センター(英国レディング)で数々のプログラムを主導したバウアーを含む多くの人々の取り組みの成果です。同センターは世界で最も高度な気象予報モデルの開発に取り組んでいます。 1ペタバイトのデータを処理する 計算要件が膨大であるため、この協力は広範です。 フランシスコ・ドブラス・レジェス 「私たちは、非常に迅速に提供する必要がある1ペタバイトのデータを生成することを話しています」とドブラス・レジェスは述べています。彼は、バルセロナスーパーコンピューティングセンターの地球科学部門のディレクターであり、気候変動に関する最も確定的な報告書を作成する気候変動政府間パネル(IPCC)の主要著者でもあり、DestinEプログラムへの貢献者でもあります。 デジタルツインの取り組みは、従来の気象・気候予測のアプローチを「逆さまにし、利用者がプロセスの主導権を握ることができるようにする」と彼はGTC(NVIDIAの開発者会議)での講演で述べました。目標は、「気候適応により役立つ気候情報の生産をユーザーに提供すること」です。 彼の講演では、気候システムの混沌さを詳細に捉えるために必要な新しいモデル、ワークフロー、システムについて説明されました。 ビジョンを明確にする デジタルツインのビジョンは、ハンブルクのマックスプランク気象研究所のディレクターであるスティーブンスによるSC20スーパーコンピューティング会議の基調講演で明確化されました。スティーブンスは、気候応用のための世界トップの気象モデルと、現在の最高水準よりも桁違いに細かい1キロメートルレベルのシミュレーションを可能にする取り組みを率いています。 「私たちは、私たちの行動と政策の結果を検証するための地球情報システムのための新しいタイプの計算能力が必要です。これにより、より持続可能な未来を構築することができます」と彼は述べています。 スティーブンスはSC20での画期的な講演で、地球のデジタルツインのビジョンを明確化しました。…

専門AIトレーニングの変革- LMFlowの紹介:優れたパフォーマンスのために大規模な基盤モデルを効率的に微調整し、個別化するための有望なツールキット

大規模言語モデル(LLMs)は、大規模な基盤モデルの上に構築されており、以前は不可能だったさまざまなタスクを実行する一般的な能力を示しています。しかし、特定のドメインやジョブでのパフォーマンスを向上させるには、このようなLLMのさらなるファインチューニングが必要です。大規模モデルのファインチューニングには、以下のような一般的な手順が含まれます: ニッチな領域での継続的な事前学習により、広範な基礎モデルがそのような領域での専門知識を獲得することができます。 自然言語の特定のタイプの命令を理解し実行するために、大規模な汎用ベースモデルの調整。 必要な会話能力を備えた大規模な基礎モデルのトレーニング(RLHF:人間のフィードバックを用いた強化学習)。 すでにいくつかの大規模モデルが事前学習され、一般に公開されています(GPT-J、Bloom、LLaMAなど)。しかし、これらのモデル全体で効率的にファインチューニング操作を行うことができる公開ツールボックスはありません。 香港大学とプリンストン大学の研究者チームが、制約されたリソースで効率的に巨大モデルのファインチューニングと推論を支援するための使いやすく軽量なツールセットを作成しました。 Nvidia 3090 GPUと5時間あれば、7兆パラメータのLLaMAモデルに基づいたカスタムモデルをトレーニングすることができます。このフレームワークを使用して単一のマシン上で7、13、33、65兆パラメータのLLaMAのバージョンをファインチューニングした後、研究用にモデルの重みが提供されました。 オンラインで無償で利用できる大規模言語モデルの出力を最適化するには、以下の4つのステップがあります: 最初のステップは「ドメイン適応」であり、モデルを特定のドメインに対応させるためのトレーニングです。 2番目のステップはタスク適応であり、要約、質問応答、翻訳などの特定の目標を達成するためにモデルをトレーニングすることを意味します。 3番目のステージは、教示型質問・回答のペアに基づいてモデルのパラメータを調整する「教示型ファインチューニング」です。 最後のステップは、人々の意見に基づいてモデルを改善する「人間のフィードバックを用いた強化学習」です。 LMFlowは、これらの4つのステップに対する完全なファインチューニング手順を提供し、制約された計算リソースにもかかわらず、巨大言語モデルの個別のトレーニングを可能にします。 LMFlowは、連続的な事前トレーニング、命令調整、RLHFなどの機能を備えた大規模モデルの包括的なファインチューニング手法を提供し、使いやすく柔軟なAPIも提供しています。LMFlowによって、個別のモデルトレーニングが誰もが利用できるようになりました。質問応答、コンパニオンシップ、執筆、翻訳、さまざまな科目での専門的な相談などの活動において、各人は利用可能なリソースに基づいて適切なモデルを選択することができます。ユーザーが十分な大きさのモデルとデータセットを持っている場合、より長い期間のトレーニングにより優れた結果が得られます。チームは最近、ChatGPTよりも優れた33兆パラメータのモデルをトレーニングしました。

Langchainを使用してYouTube動画用のChatGPTを構築する

はじめに ビデオとチャットで話すことができたらどのくらい便利だろうかと考えたことがありますか?私自身、ブログを書く人間として、関連する情報を見つけるために1時間ものビデオを見ることはしばしば退屈に感じます。ビデオから有用な情報を得るために、ビデオを見ることが仕事のように感じることもあります。そこで、YouTubeビデオやその他のビデオとチャットできるチャットボットを作成しました。これは、GPT-3.5-turbo、Langchain、ChromaDB、Whisper、およびGradioによって実現されました。この記事では、Langchainを使用してYouTubeビデオのための機能的なチャットボットを構築するコードの解説を行います。 学習目標 Gradioを使用してWebインターフェースを構築する Whisperを使用してYouTubeビデオを処理し、テキストデータを抽出する テキストデータを適切に処理およびフォーマットする テキストデータの埋め込みを作成する Chroma DBを構成してデータを保存する OpenAI chatGPT、ChromaDB、および埋め込み機能を使用してLangchainの会話チェーンを初期化する 最後に、Gradioチャットボットに対するクエリとストリーミング回答を行う コーディングの部分に入る前に、使用するツールや技術に慣れておきましょう。 この記事は、Data Science Blogathonの一部として公開されました。 Langchain Langchainは、Pythonで書かれたオープンソースのツールで、Large Language Modelsデータに対応したエージェントを作成できます。では、それはどういうことでしょうか?GPT-3.5やGPT-4など、商用で利用可能な大規模言語モデルのほとんどは、トレーニングされたデータに制限があります。たとえば、ChatGPTは、すでに見た質問にしか答えることができません。2021年9月以降のものは不明です。これがLangchainが解決する核心的な問題です。Wordドキュメントや個人用PDFなど、どのデータでもLLMに送信して人間らしい回答を得ることができます。ベクトルDB、チャットモデル、および埋め込み関数などのツールにはラッパーがあり、Langchainだけを使用してAIアプリケーションを簡単に構築できます。 Langchainを使用すると、エージェント(LLMボット)を構築することもできます。これらの自律エージェントは、データ分析、SQLクエリ、基本的なコードの記述など、複数のタスクに設定できます。これらのエージェントを使用することで、低レベルな知識作業をLLMに外注することができるため、時間とエネルギーを節約できます。 このプロジェクトでは、Langchainツールを使用して、ビデオ用のチャットアプリを構築します。Langchainに関する詳細については、公式サイトを訪問してください。 Whisper Whisperは、OpenAIの別の製品です。これは、オーディオまたはビデオをテキストに変換できる汎用音声認識モデルです。多言語翻訳、音声認識、および分類を実行するために、多様なオーディオをトレーニングしています。…

Amazon SageMaker StudioでAmazon SageMaker JumpStartの独自の基盤モデルを使用してください

Amazon SageMaker JumpStartは、機械学習(ML)の旅を加速するのに役立つMLハブですSageMaker JumpStartを使用すると、公開されているものと独自のファウンデーションモデルを探索して、生成型AIアプリケーションのための専用のAmazon SageMakerインスタンスに展開できますSageMaker JumpStartは、ネットワーク隔離環境からファウンデーションモデルを展開することができます[...]

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.