Learn more about Search Results RLHF - Page 13

- You may be interested

- ポイントクラウド用のセグメント化ガイド...

- 「NVIDIAの収益報告書がAI革命での優位性...

- MIT CSAILの研究者が生成的AIの最前線につ...

- 2023年のトップ7人工知能絵画ジェネレーター

- AWS vs Azure:究極のクラウド対決

- 「教師付き機械学習と集合論を通じた現実...

- メタが彼らの有望なプロジェクトをすべて...

- 「50 ミッドジャーニーノーリングのヒント...

- エッジコンピューティング:データ処理と...

- 「トランスフォーマーと位置埋め込み:マ...

- ティーンエイジャーたちはAIのリテラシー...

- AIチップに対する潜在的な米国の輸出制限...

- 「ディープラーニングを用いたナノアレイ...

- 科学者たちは、AIと迅速な応答EEGを用いて...

- 「モデルガバナンスを向上させるために、A...

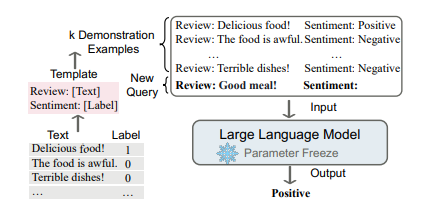

大規模な言語モデルにおけるコンテキストに基づく学習アプローチ

言語モデリング(LM)は、単語のシーケンスの生成的な尤度をモデル化することを目指し、将来の(または欠損している)トークンの確率を予測します言語モデルは自然言語処理の世界を革新しました...

専門AIトレーニングの変革- LMFlowの紹介:優れたパフォーマンスのために大規模な基盤モデルを効率的に微調整し、個別化するための有望なツールキット

大規模言語モデル(LLMs)は、大規模な基盤モデルの上に構築されており、以前は不可能だったさまざまなタスクを実行する一般的な能力を示しています。しかし、特定のドメインやジョブでのパフォーマンスを向上させるには、このようなLLMのさらなるファインチューニングが必要です。大規模モデルのファインチューニングには、以下のような一般的な手順が含まれます: ニッチな領域での継続的な事前学習により、広範な基礎モデルがそのような領域での専門知識を獲得することができます。 自然言語の特定のタイプの命令を理解し実行するために、大規模な汎用ベースモデルの調整。 必要な会話能力を備えた大規模な基礎モデルのトレーニング(RLHF:人間のフィードバックを用いた強化学習)。 すでにいくつかの大規模モデルが事前学習され、一般に公開されています(GPT-J、Bloom、LLaMAなど)。しかし、これらのモデル全体で効率的にファインチューニング操作を行うことができる公開ツールボックスはありません。 香港大学とプリンストン大学の研究者チームが、制約されたリソースで効率的に巨大モデルのファインチューニングと推論を支援するための使いやすく軽量なツールセットを作成しました。 Nvidia 3090 GPUと5時間あれば、7兆パラメータのLLaMAモデルに基づいたカスタムモデルをトレーニングすることができます。このフレームワークを使用して単一のマシン上で7、13、33、65兆パラメータのLLaMAのバージョンをファインチューニングした後、研究用にモデルの重みが提供されました。 オンラインで無償で利用できる大規模言語モデルの出力を最適化するには、以下の4つのステップがあります: 最初のステップは「ドメイン適応」であり、モデルを特定のドメインに対応させるためのトレーニングです。 2番目のステップはタスク適応であり、要約、質問応答、翻訳などの特定の目標を達成するためにモデルをトレーニングすることを意味します。 3番目のステージは、教示型質問・回答のペアに基づいてモデルのパラメータを調整する「教示型ファインチューニング」です。 最後のステップは、人々の意見に基づいてモデルを改善する「人間のフィードバックを用いた強化学習」です。 LMFlowは、これらの4つのステップに対する完全なファインチューニング手順を提供し、制約された計算リソースにもかかわらず、巨大言語モデルの個別のトレーニングを可能にします。 LMFlowは、連続的な事前トレーニング、命令調整、RLHFなどの機能を備えた大規模モデルの包括的なファインチューニング手法を提供し、使いやすく柔軟なAPIも提供しています。LMFlowによって、個別のモデルトレーニングが誰もが利用できるようになりました。質問応答、コンパニオンシップ、執筆、翻訳、さまざまな科目での専門的な相談などの活動において、各人は利用可能なリソースに基づいて適切なモデルを選択することができます。ユーザーが十分な大きさのモデルとデータセットを持っている場合、より長い期間のトレーニングにより優れた結果が得られます。チームは最近、ChatGPTよりも優れた33兆パラメータのモデルをトレーニングしました。

キャッシュの遷移に対する自動フィードバックによる優先学習

Googleのソフトウェアエンジニア、Ramki GummadiとYouTubeのソフトウェアエンジニア、Kevin Chenによって投稿されました。 キャッシュは、リクエストパターンに基づいてクライアントに近い場所に人気のあるアイテムの一部を保存することで、ストレージおよび検索システムのパフォーマンスを大幅に向上させる、コンピュータサイエンスにおける普遍的なアイデアです。キャッシュの管理における重要なアルゴリズムの一部は、格納されるアイテムのセットを動的に更新するために使用される決定ポリシーであり、数十年にわたって広範に最適化されてきました。これにより、いくつかの効率的で堅牢なヒューリスティクスが生まれました。機械学習をキャッシュポリシーに適用することは、最近の研究で有望な結果を示していますが(例:LRB、LHD、ストレージアプリケーションなど)、競争力のある計算およびメモリの負荷を維持しながら、信頼性のあるヒューリスティクスをベンチマークを超えて信頼性のある汎用的な設定に対して上回ることはまだ課題です。 NSDI 2023で発表された「YouTubeコンテンツデリバリーネットワークのためのヒューリスティック支援学習優先エヴィクションポリシー(HALP)」では、学習された報酬を基にしたスケーラブルな最先端のキャッシュエヴィクションフレームワークを紹介しています。HALPフレームワークは、軽量なヒューリスティックベースラインエヴィクションルールと学習された報酬モデルを組み合わせるメタアルゴリズムです。報酬モデルは、オフラインのオラクルを模倣するために設計された選好比較に基づく継続的な自動フィードバックでトレーニングされる軽量なニューラルネットワークです。HALPがYouTubeのコンテンツデリバリーネットワークのインフラストラクチャの効率性とユーザーのビデオ再生遅延を改善した方法について説明します。 キャッシュエヴィクションの決定のための学習済みの選好 HALPフレームワークは、2つのコンポーネントに基づいてキャッシュエヴィクションの決定を行います:(1)自動フィードバックを介した選好学習によってトレーニングされたニューラル報酬モデル、および(2)学習された報酬モデルと高速ヒューリスティックを組み合わせるメタアルゴリズム。キャッシュが入力リクエストを観察すると、HALPはペアワイズの選好フィードバックを介した選好学習法として、各アイテムに対してスカラー報酬を予測する小規模なニューラルネットワークを継続的にトレーニングします。HALPのこの側面は、人間のフィードバックからの強化学習(RLHF)システムに似ていますが、2つの重要な違いがあります: フィードバックは自動化されており、オフラインの最適キャッシュエヴィクションポリシーの構造に関するよく知られた結果を活用しています。 モデルは、自動フィードバックプロセスから構築されたトレーニングの例の一時バッファを使用して継続的に学習されます。 エヴィクションの決定は、2つのステップを持つフィルタリングメカニズムに依存しています。まず、パフォーマンスの観点ではサブオプティマルですが、効率的なヒューリスティックを使用して、小さな候補のサブセットが選択されます。次に、再ランキングステップによって、ベースラインの候補から内部の最終的な決定の品質を「ブーストする」ために、ニューラルネットワークのスコアリング関数が使用されます。 HALPは、エヴィクションの決定だけでなく、効率的なフィードバックの構築とモデルの更新に使用されるペアワイズの選好クエリのサンプリングのエンドツーエンドのプロセスを包括しています。 ニューラル報酬モデル HALPは、キャッシュ内の個々のアイテムを選択的にスコアリングするために、軽量な2層のマルチレイヤーパーセプトロン(MLP)を報酬モデルとして使用します。特徴は、メタデータのみの「ゴーストキャッシュ」として構築および管理されます(ARCなどの古典的なポリシーと同様)。任意のルックアップリクエストの後、通常のキャッシュ操作に加えて、HALPはダイナミックな内部表現を更新するために必要なブックキーピング(例:キャッシュルックアップリクエストと共にユーザーから提供される外部のタグ付き特徴、および各アイテムで観測されたルックアップ時間から構築された内部的な動的特徴など)を実行します。 HALPは、ランダムな重み初期化から完全にオンラインで報酬モデルを学習します。これは、報酬モデルを最適化するためにのみ決定が行われる場合、悪いアイデアのように思えるかもしれません。ただし、エヴィクションの決定は、学習された報酬モデルとLRUなどのサブオプティマルでシンプルかつ堅牢なヒューリスティックの両方に依存しています。これにより、報酬モデルが完全に一般化された場合に最適なパフォーマンスが得られる一方で、一時的に一般化されていないまたは変化する環境に追いつく途中の情報の少ない報酬モデルにも堅牢性があります。 オンライントレーニングのもう一つの利点は、専門化です。キャッシュサーバーはそれぞれ異なる環境(地理的位置など)で実行されるため、ローカルのネットワーク状況やローカルで人気のあるコンテンツなどに影響を受けます。オンライントレーニングは、この情報を自動的にキャプチャする一方で、単一のオフライントレーニングソリューションとは異なり、一般化の負担を軽減します。 ランダム化された優先度キューからのスコアリングサンプル エヴィクションの決定の品質を排他的に学習された目的に最適化することは、2つの理由で実用的ではありません。 計算効率の制約: 学習されたネットワークによる推論は、実際のキャッシュポリシーの計算に比べてかなり高コストになることがあります。これはネットワークと特徴の表現力だけでなく、各エビクションの決定時にこれらがどれくらい頻繁に呼び出されるかも制約します。 分布外の汎化のための堅牢性: HALPは、継続的な学習を伴うセットアップで展開されており、急速に変化するワークロードによって、以前に見たデータに関して一時的に分布外になるリクエストパターンが生成される可能性があります。 これらの問題に対処するために、HALPはまず、エビクションの優先順位に対応する安価なヒューリスティックスコアリングルールを適用し、小さな候補サンプルを特定します。このプロセスは、正確な優先順位キューを近似する効率的なランダムサンプリングに基づいています。候補サンプルを生成するための優先関数は、既存の手動調整アルゴリズム(例:LRU)を使用して素早く計算することを意図しています。ただし、これは簡単なコスト関数を編集することによって他のキャッシュ置換ヒューリスティックを近似するように構成できます。以前の研究とは異なり、ランダム化は近似と効率のトレードオフに使用されるものでしたが、HALPでは、トレーニングと推論の両方でサンプルされた候補の時間ステップごとの固有のランダム化にも依存しています。 最終的なエビクトされるアイテムは、提供された候補から選ばれ、ニューラル報酬モデルに従って予測された優先スコアを最大化するために再ランクされたサンプルに相当します。エビクションの決定に使用される候補のプールは、サンプル間のトレーニングと推論のズレを最小限に抑えるために、ペアワイズの優先クエリの構築にも使用されます。…

Microsoft AIは、バッチサイズや帯域幅の制限に阻まれることなく、効率的な大規模モデルのトレーニングにZeROを搭載した高度な通信最適化戦略を導入しています

マイクロソフトの研究者たちは、高いデータ転送オーバーヘッドと帯域幅の制限に対処するために、大規模なAIモデルのトレーニングを最適化するためにZeRO++という新しいシステムを開発しました。ZeRO++は既存のZeROの最適化を基盤にし、トレーニング効率を向上させ、トレーニング時間とコストを削減するために強化された通信戦略を提供します。 Turing-NLG、ChatGPT、GPT-4などの大規模なモデルのトレーニングには、複数のGPUデバイスを跨いで大量のメモリとコンピューティングリソースが必要です。DeepSpeedによって開発されたZeRO++は、GPUごとの小規模なバッチサイズまたは低帯域幅クラスタでのトレーニングのシナリオにおいて、ZeROの制限を克服するために通信最適化戦略を導入しています。 ZeRO-Inferenceを含むZeRO最適化のファミリーは、GPUメモリとコンピューティングパワーを集約してモデル状態をGPU間でパーティション化することで、複製ではなくパーティション化を実現します。ただし、ZeROはトレーニング中に高い通信オーバーヘッドを引き起こす場合があります。ZeRO++は、量子化された重み通信(qwZ)、階層的重みパーティション(hpZ)、および量子化勾配通信(qgZ)の3つのセットの通信最適化を組み込むことにより、これに対処します。 通信量を減らすために、ZeRO++は重みの量子化によって、訓練精度を保持するためのブロックベースの量子化を利用します。この最適化された量子化プロセスは、基本的な量子化よりも高速で正確です。逆伝搬中の通信オーバーヘッドを最小限に抑えるために、ZeRO++は、各マシン内で完全なモデルコピーを維持することによって、GPUメモリを通信に交換します。勾配通信については、ZeRO++は、クロスノードトラフィックとレイテンシを減らす新しい量子化勾配通信パラダイムqgZを導入しています。 これらの通信最適化により、通信量が大幅に削減されます。ZeRO++は、ZeROと比較して最大4倍の削減を実現し、トレーニングのスループットと効率を向上させます。ZeRO++は、GPUごとの小規模なバッチサイズを使用する場合に、高帯域幅クラスタでZeRO-3に比べて28%〜36%のスループット向上を実現します。ZeRO++は、ZeRO-3に比べて低帯域幅クラスタで平均2倍のスピードアップを達成し、AIのさまざまなクラスタで大規模なモデルのトレーニングをよりアクセス可能にします。 ZeRO++はトレーニングシナリオに限定されず、対話モデルで使用される人間からのフィードバック(RLHF)トレーニングにも拡張されます。DeepSpeed-Chatと統合することで、RLHFトレーニングは、ZeROに比べて最大2.25倍の生成スループットと1.26倍のトレーニングスループットの向上を実現できます。 DeepSpeedは、大規模なモデルのトレーニングを効率的かつアクセス可能にするためにZeRO++をリリースしました。このシステムは、トレーニングを加速し、通信オーバーヘッドを削減し、より大きなバッチサイズを可能にするように設計されており、最終的に時間とリソースを節約します。研究者や実践者は、ChatGPTなどのモデルのトレーニングをより効果的に行い、AIの新たな可能性を探索するためにZeRO++を活用できます。

新たな能力が明らかに:GPT-4のような成熟したAIのみが自己改善できるのか?言語モデルの自律的成長の影響を探る

研究者たちは、AlphaGo Zeroと同様に、明確に定義されたルールで競争的なゲームに反復的に参加することによってAIエージェントが自己発展する場合、多くの大規模言語モデル(LLM)が人間の関与がほとんどない交渉ゲームでお互いを高め合う可能性があるかどうかを調査しています。この研究の結果は、遠い影響を与えるでしょう。エージェントが独立に進歩できる場合、少数の人間の注釈で強力なエージェントを構築することができるため、今日のデータに飢えたLLMトレーニングに対して対照的です。それはまた、人間の監視がほとんどない強力なエージェントを示唆しており、問題があります。この研究では、エジンバラ大学とAIアレン研究所の研究者が、顧客と売り手の2つの言語モデルを招待して購入の交渉を行うようにしています。 図1:交渉ゲームの設定。彼らは2つのLLMエージェントを招待して、値切りのゲームで売り手と買い手をプレイさせます。彼らの目標は、より高い値段で製品を販売または購入することです。彼らは第三のLLMであるAI批評家に、ラウンド後に向上させたいプレイヤーを指定してもらいます。その後、批判に基づいて交渉戦術を調整するようにプレイヤーに促します。これを数ラウンド繰り返すことで、モデルがどんどん上達するかどうかを確認します。 顧客は製品の価格を下げたいと思っていますが、売り手はより高い価格で販売するように求められています(図1)。彼らは第三の言語モデルに批評家の役割を担ってもらい、取引が成立した後にプレイヤーにコメントを提供させます。次に、批評家LLMからのAI入力を利用して、再度ゲームをプレイし、プレイヤーにアプローチを改善するように促します。彼らは交渉ゲームを選んだ理由は、明確に定義されたルールと、戦術的な交渉のための特定の数量化目標(より低い/高い契約価格)があるためです。ゲームは最初は単純に見えますが、モデルは次の能力を持っている必要があります。 交渉ゲームのテキストルールを明確に理解し、厳密に遵守すること。 批評家LLMによって提供されるテキストフィードバックに対応し、反復的に改善すること。 長期的にストラテジーとフィードバックを反映し、複数のラウンドで改善すること。 彼らの実験では、モデルget-3.5-turbo、get-4、およびClaude-v1.3のみが交渉ルールと戦略を理解し、AIの指示に適切に合致している必要があるという要件を満たしています。その結果、彼らが考慮したモデルすべてがこれらの能力を示さなかったことが示されています(図2)。初めに、彼らはボードゲームやテキストベースのロールプレイングゲームなど、より複雑なテキストゲームもテストしましたが、エージェントがルールを理解して遵守することがより困難であることが判明しました。彼らの方法はICL-AIF(AIフィードバックからのコンテキスト学習)として知られています。 図2:私たちのゲームで必要な能力に基づいて、モデルは複数の階層に分けられます(C2-交渉、C3-AIフィードバック、C4-継続的な改善)。私たちの研究は、gpt-4やclaude-v1.3などの堅牢で適切に合致したモデルだけが反復的なAI入力から利益を得て、常に発展することができることを明らかにしています。 彼らは、AI批評家のコメントと前回の対話履歴ラウンドをコンテキストに応じたデモンストレーションとして利用しています。これにより、プレイヤーの前回の実際の開発と批評家の変更アイデアが、次のラウンドの交渉のためのフューショットキューに変換されます。2つの理由から、彼らはコンテキストでの学習を使用しています:(1)強化学習を用いた大規模な言語モデルの微調整は、高額であるため、(2)コンテキストでの学習は、勾配降下に密接に関連していることが最近示されたため、モデルの微調整を行う場合には、彼らが引き出す結論がかなり一般的になることが期待されます(資源が許される場合)。 人間からのフィードバックによる強化学習(RLHF)の報酬は通常スカラーですが、ICL-AIFでは、フィードバックが自然言語で提供されます。これは、2つのアプローチの注目すべき違いです。各ラウンド後に人間の相互作用に依存する代わりに、よりスケーラブルでモデルの進歩に役立つAIのフィードバックを検討しています。 異なる責任を負うときにフィードバックを与えられた場合、モデルは異なる反応を示します。バイヤー役のモデルを改善することは、ベンダー役のモデルよりも難しい場合があります。過去の知識とオンライン反復的なAIフィードバックを利用して、get-4のような強力なエージェントが常に意味のある開発を続けることができるとしても、何かをより高く売る(またはより少ないお金で何かを購入する)ことは、全く取引が成立しないリスクがあります。彼らはまた、モデルがより簡潔であるがより綿密(そして最終的にはより成功する)交渉に従事できることを証明しています。全体的に、彼らは自分たちの仕事がAIフィードバックのゲーム環境での言語モデルの交渉を向上させる重要な一歩になると期待しています。コードはGitHubで利用可能です。

再帰型ニューラルネットワークの基礎からの説明と視覚化

再帰型ニューラルネットワーク(RNN)は、順次操作が可能なニューラルネットワークです数年前ほど人気はありませんが、重要な発展を表しています...

あなたのLLMアプリケーションは公開に準備ができていますか?

大規模言語モデル(LLM)は、現代の自然言語処理アプリケーションにおいてパンとバターとなり、固有表現認識モデルなどのより専門的なツールの多様性を多くの面で置き換えています

あなたの究極のチャットGPTおよびその他の略語ガイド

ChatGPTについて、誰もが熱狂しているようですこれは文化現象になりましたまだChatGPTの利用者でない場合、この記事はこの革新に対する文脈と興奮をよりよく理解するのに役立つかもしれません

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.