Learn more about Search Results Pi - Page 12

- You may be interested

- 適切なバランスを取る:機械学習モデルに...

- プリンストン大学とメタAIの研究者たちは...

- どのような要素が対話エージェントを有用...

- ChatGPTコードインタープリタープラグイン...

- プールに飛び込む:CNNプーリングレイヤー...

- ユーロトリップの最適化:遺伝的アルゴリ...

- 「エローの有名なレーティングシステムに...

- 「タンパク質設計の次は何か?マイクロソ...

- 「研究によると、YouTube広告が子どもたち...

- 「Jupyter AIに会おう:マジックコマンド...

- メタAIは、IMAGEBINDを紹介します:明示的...

- 「ペンの向こう側:視覚的な原型からの手...

- 線形代数の鳥瞰図:基礎

- 「今日のビジネスの風景におけるプロフェ...

- 「2023年に就職するために必要な10のビッ...

「OpenAI(Python)APIを解説する」

「これは、実践において大規模な言語モデル(LLM)を使用するシリーズの2番目の記事ですここでは、OpenAI APIの初心者向けの紹介を行いますこれにより、制約のあるチャットを超えることができます...」

UCバークレーの研究者たちは、Gorillaという名前の、GPT-4を上回るAPIコールの記述において、Finetuned LLaMAベースのモデルを紹介しました

人工知能の分野における最近の大きな進歩は、大規模言語モデル(LLM)の導入です。これらのモデルは、自然言語処理(NLP)や自然言語理解(NLU)を最大限に活用するために、言語をより簡潔に理解することを可能にします。これらのモデルは、テキスト要約、質問応答、コンテンツ生成、言語翻訳など、あらゆるタスクで優れたパフォーマンスを発揮しています。これらのモデルは、論理的な推論を含む複雑なテキストのプロンプトを理解し、データのパターンや関係を特定することができます。 言語モデルは、さまざまなタスクで驚異的なパフォーマンスを示し、近年、その能力を大幅に向上させてきましたが、効率的なAPI呼び出しを行うことは依然として困難です。有名なLLMであるGPT-4でも、正確な入力引数を生成するのは困難であり、適切でないAPI呼び出しを頻繁に推奨します。この問題に対処するために、バークレーとマイクロソフトリサーチの研究者は、GPT-4を上回るAPI呼び出しの生成能力を持つ、Gorillaというfinetuned LLaMAベースのモデルを提案しました。Gorillaは、特定の活動を実行するために外部ツールと連携するLLMの能力を向上させるのに役立ちます。 研究者のチームは、APIBenchデータセットも作成しました。このデータセットは、重複する機能を持つAPIの大規模なコーパスで構成されています。このデータセットは、TorchHub、TensorHub、HuggingFaceなどの公開モデルハブから収集されました。TorchHubとTensorHubのすべてのAPIリクエストが各APIに含まれ、HuggingFaceの各タスクカテゴリにおける上位20モデルが選択されました。さらに、自己指導法を使用して、各APIに対して10の架空のユーザークエリプロンプトを生成しました。 このAPIBenchデータセットとドキュメント検索を使用して、研究者はGorillaをfinetuneしました。7兆パラメータのGorillaモデルは、APIの機能の正確さや幻覚的なミスを低下させる点でGPT-4を上回ります。ドキュメント検索ツールとの効果的な統合により、LLMがより正確にツールを使用できる可能性が示されています。Gorillaの改善されたAPI呼び出し生成能力と必要に応じてドキュメントを変更する能力は、モデルの結果の適用性と信頼性を向上させます。この開発は重要であり、定期的に更新されるドキュメントに追いつくことができるため、ユーザーにより正確かつ最新の情報を提供します。 研究者によって共有された例の1つでは、Gorillaが正しくタスクを認識し、完全に資格のあるAPI結果を提供する様子が示されています。モデルによって生成されたAPI呼び出しは、GPT-4が仮想のモデルに対するAPIリクエストを生成していることを示し、タスクの理解力の不足を示しています。一方、クロードは適切なライブラリを選択せず、正しいリソースを認識する能力の不足を示しました。これに対して、Gorillaはタスクを正しく認識します。したがって、GorillaはGPT-4やクロードとは異なり、API呼び出しの作成が正確であり、その性能とタスク理解力を示しています。 結論として、Gorillaは言語モデルのリストにおいて重要な追加です。それはAPI呼び出しの作成の問題にも対応しています。その能力により、幻覚や信頼性に関連する問題を軽減することができます。

「PIP、Conda、requirements.txtを忘れましょう!代わりにPoetryを使って、私に感謝してください」

「痛みのない依存関係管理がついに実現しました」

「RoboPianistに会いましょう:シミュレートされたロボットハンドを使用したピアノマスタリーにおける高次元制御のための新しいベンチマークスイート」

制御および強化学習の領域における計測プロセスは非常に困難です。特に、高次元制御に焦点を当てた頑健なベンチマークが不足していました。特に高次元ロボット工学の最も困難な「チャレンジ問題」である「二手(両手)多指制御」をマスターするためのベンチマークが不足していました。同時に、制御と強化学習のベンチマーク化の努力の中で、深さの異なる側面を集約し、探索し始める取り組みもあります。人間の手の器用さを模倣する研究が数十年にわたって行われているにもかかわらず、ロボットの高次元制御は依然として主要な難題です。 UCバークレー、Google、DeepMind、スタンフォード大学、およびサイモンフレーザー大学の研究者グループは、高次元制御のための新しいベンチマークスイート「ROBOPIANIST」を提案しています。彼らの研究では、二手(両手)シミュレートされた人型ロボットハンドが、ミュージカルインストゥルメントデジタルインターフェース(MIDI)トランスクリプションに基づいてさまざまな曲を演奏する課題を与えられています。ロボットハンドは合計で44個のアクチュエータを持ち、各手に22個のアクチュエータがあり、人間の手の僅かに非完全制御の特性を持っています。 曲をうまく演奏するためには、高次元制御ポリシーの多くの特性を示す方法でアクションをシーケンスする能力が必要です。これには以下が含まれます: 空間的および時間的な精度。 2つの手と10本の指の調整。 他のキープレスを容易にするためのキープッシュの戦略的な計画。 オリジナルのROBOPIANIST-repertoire-150ベンチマークには150の曲が含まれており、それぞれが独立した仮想作品として機能しています。研究者は、モデルフリー(RL)およびモデルベース(MPC)の手法による包括的な実験を通じてモデルフリーおよびモデルベースの手法の性能範囲を研究しています。その結果、提案されたポリシーは改善の余地が多いにもかかわらず、強力なパフォーマンスを発揮することができることが示されています。 ポリシーが曲を学ぶ能力は、曲(つまりタスク)を難易度順にソートするために使用することができます。研究者は、このような基準に基づいてタスクをグループ化する能力が、カリキュラムや転移学習など、ロボット学習に関連するさまざまな領域でのさらなる研究を促進する可能性があると考えています。ロボピアニストは、模倣学習、マルチタスク学習、ゼロショット汎化、およびマルチモーダル(音、ビジョン、タッチ)学習など、さまざまな研究アプローチに対する魅力的な機会を提供しています。全体的に、ROBOPIANISTはシンプルな目標、複製しやすい環境、明確な評価基準を示し、将来のさまざまな拡張の可能性に対して開かれています。

Google AIは、環境の多様性と報酬の指定の課題に対処するための、普遍的なポリシー(UniPi)を提案します

産業に関係なく、人々の生活の質を向上させるために、人工知能(AI)と機械学習(ML)技術は常に取り組んできました。最近のAIの主要な応用の一つは、さまざまなドメインで意思決定タスクを達成できるエージェントを設計・作成することです。たとえば、GPT-3やPaLMのような大規模言語モデルや、CLIPやFlamingoのようなビジョンモデルは、それぞれの分野でゼロショット学習に優れていることが証明されています。しかし、このようなエージェントの訓練には、1つの主要な欠点があります。それは、このようなエージェントが訓練中に環境の多様性を示すという固有の特性を持つためです。単純に言えば、異なるタスクや環境のための訓練は、時折学習や知識の移転、モデルの領域間の一般化能力を妨げるため、さまざまな状態空間の使用を必要とします。さらに、強化学習(RL)ベースのタスクでは、特定のタスクのための報酬関数を作成することが困難になります。 この問題に取り組んで、Google Researchのチームは、このようなツールがより汎用性のあるエージェントの構築に使用できるかどうかを調査しました。彼らの研究では、チームは特にテキストガイドの画像合成に焦点を当て、テキストの形で目標をプランナーに与え、意図した行動のシーケンスを生成し、その後生成されたビデオから制御アクションを抽出する方法を提案しました。したがって、Googleチームは、最近の論文で「テキストガイドされたビデオ生成によるユニバーサルポリシーの学習」と題された論文で、環境の多様性と報酬の指定の課題に取り組むためのユニバーサルポリシー(UniPi)を提案しました。UniPiポリシーは、テキストをタスクの説明のためのユニバーサルなインターフェースとし、ビデオをさまざまな状況でのアクションと観察の振る舞いを伝えるためのユニバーサルなインターフェースとして使用します。具体的には、チームは、ビデオジェネレータをプランナーとして設計し、現在の画像フレームと現在の目標を示すテキストプロンプトを入力として、画像シーケンスまたはビデオの形で軌跡を生成します。生成されたビデオは、その後、実行される基礎となるアクションを抽出する逆ダイナミクスモデルに入力されます。このアプローチは、言語とビデオの普遍性を利用して、新しい目標や異なる環境に対して一般化することができるという点で特筆すべきです。 ここ数年、テキストガイドの画像合成の分野で著しい進歩が達成され、洗練された画像を生成する驚異的な能力を持つモデルが生み出されています。これが研究チームがこの問題を選んだ動機となりました。Googleの研究者が提案するUniPiアプローチは、主に次の4つのコンポーネントで構成されています:タイリングによる軌跡の一貫性、階層的な計画、柔軟な行動調整、およびタスク固有のアクション適応。これらについて詳しく説明します。 1. タイリングによる軌跡の一貫性: 既存のテキストからビデオへの方法では、生成されるビデオは基礎となる環境状態が大きく変化することがあります。しかし、正確な軌跡プランナーを構築するためには、すべてのタイムスタンプで環境が一定であることが重要です。したがって、条件付けられたビデオ合成において環境の一貫性を強制するために、研究者は生成されたビデオの各フレームをノイズ除去しながら観測された画像を提供します。時間を超えて基盤となる環境状態を保持するために、UniPiは各ノイズの混入した中間フレームをサンプリングステップごとに条件付けられた観測された画像と直接連結します。 2. 階層的な計画: 複雑で洗練された環境で計画を立てる際には、すべての必要なアクションを生成することは困難です。この問題を克服するために、計画手法は自然な階層を利用して、小さい空間で大まかな計画を作成し、それをより詳細な計画に洗練していきます。同様に、ビデオ生成プロセスでは、UniPiはまず望ましいエージェントの振る舞いを示す粗いレベルのビデオを作成し、欠落しているフレームを埋めたり、滑らかにしたりして、より現実的なものに改善します。これは、各ステップがビデオの品質を向上させ、望ましい詳細レベルに達するまでビデオを改善する階層を使用することで実現されます。 3. 柔軟な行動調整: 小さな目標のためのアクションのシーケンスを計画する際には、生成されたプランを変更するために外部の制約を簡単に組み込むことができます。これは、プランの特性に基づいて望ましい制約を反映する確率的な事前知識を組み込むことによって行われることができます。この事前知識は、学習された分類器または特定の画像上のディラックデルタ分布を使用してプランを特定の状態に誘導するものです。このアプローチはUniPiとも互換性があります。研究者たちは、テキストに条件付けられたビデオ生成モデルを訓練するためにビデオ拡散アルゴリズムを使用しました。このアルゴリズムは、Text-To-Text Transfer Transformer(T5)からエンコードされた事前学習言語特徴量で構成されています。 4. タスク固有のアクション適応: 小さな逆動力学モデルは、合成されたビデオセットを使用してビデオフレームを低レベルの制御アクションに変換するためにトレーニングされます。このモデルはプランナーとは別であり、シミュレータによって生成された別の小さなデータセットでトレーニングすることができます。逆動力学モデルは、入力フレームと現在の目標のテキスト説明を取り、イメージフレームを合成し、将来の手順を予測するためのアクションのシーケンスを生成します。その後、エージェントはこれらの低レベルの制御アクションをクローズドループ制御を使用して実行します。 要約すると、Googleの研究者たちは、テキストベースのビデオ生成を使用して、組み合わせ的な汎化、マルチタスク学習、および現実世界の転送が可能なポリシーを表現する価値を示すことで、印象的な貢献をしました。研究者たちは、新しい言語ベースのタスクのいくつかで彼らのアプローチを評価し、UniPiが他のベースライン(Transformer BC、Trajectory Transformer、Diffuserなど)と比較して、言語のプロンプトの見たことも知らない組み合わせにもうまく一般化することが結論付けられました。これらの励みに満ちた発見は、生成モデルと利用可能な膨大なデータが、多目的な意思決定システムを作成するための貴重な資源としての潜在能力を浮き彫りにしています。

「AI駆動の洞察:LangChainとPineconeを活用したGPT-4」

「質的データと効果的に取り組むことは、プロダクトマネージャーが持つべき最も重要なスキルの一つですデータを収集し、分析し、効率的な方法で伝えることができるようにすることは、...」

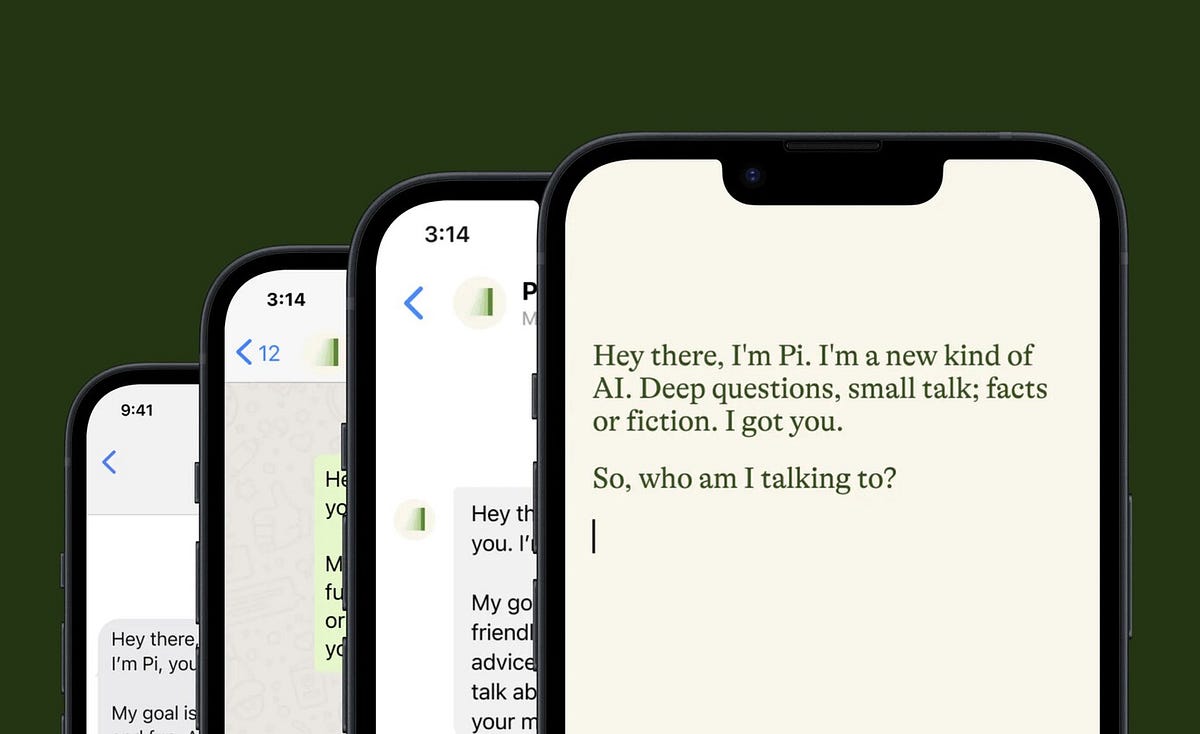

チャットGPTからPiへ、そしてなぜそうするのかをお伝えします!

2月にUX/UIデザインの旅が始まって以来、ChatGPT 🤖 を使い始めて以来、私はChatGPTを私のBFFと呼んでいます感情的になるわけではありませんが、それは私の研究のマインドセットの大きな一部でした...

「機械学習タスクの自動化:MLCopilotがLLMを活用して開発者を支援し、機械学習プロセスを効率化する方法」

機械学習モデルは、複雑なタスクを解決するための強力なツールとして証明されていますが、これらのモデルのトレーニングは通常、手動で時間がかかるものでした。しかし、GPT-3.5のような大規模な言語モデルの出現により、機械学習モデルのトレーニングは自動化されるようになりました。これにより、MLCopilotの開発が進められました。このツールは、数百の機械学習実験の知識ベースを利用して、与えられたタスクに対して最適なパラメータとアーキテクチャを自動的に選択することができます。 MLCopilotツールは、オフラインとオンラインの2つのレベルで機能します。オフラインの側では、ツールは意図やモデルアーキテクチャなどのエンティティを統一し、以前の機械学習実験から知識を抽出して知識ベースを形成します。オンラインの側では、ツールは過去の実験からの関連する例を含むプロンプトを適用して、与えられたタスクを解決するための最適なアプローチを決定します。このアプローチは、アルゴリズムの手動選択と適用よりも正確です。 MLCopilotを使用することの重要な利点の1つは、実行の速さと労働コストの削減です。このツールにより、研究者や組織は、時間とコストを節約しながら精度を向上させるために、機械学習モデルの力を活用することができます。さらに、このツールは個々の研究者から大企業や国家機関まで、誰にとっても具体的な利益をもたらします。 MLCopilotを効果的に使用するためには、その制約事項を考慮することが重要です。そのような制約事項の1つは、知識ベースを作成するために使用されるデータの精度です。モデルは最適なパフォーマンスを実現するために、新しい実験との連続的な更新が必要です。また、このツールは数値ではなく相対的な推定値を使用して、以前の実験の結果を表現しますが、特定のアプリケーションには適していない場合があります。言い換えれば、MLCopilotの成功は、知識ベースを構築するために使用されるデータの品質と精度に大きく依存しています。さらに、このツールの相対的な推定値は一部のアプリケーションにしか十分ではありません。したがって、正確で関連性のある結果を得るために、ツールのパフォーマンスを慎重に考慮し、監視することが重要です。 全体として、MLCopilotの開発はAI時代における重要な進歩を表しています。機械学習モデルの最適なパラメータとアーキテクチャの選択プロセスを自動化することにより、このツールは研究者や組織が複雑なタスクをより効率的かつ正確に解決することを可能にします。これは、正確な予測と意思決定が重要な医療、金融、交通などにおいて遠大な影響を及ぼす可能性があります。技術が進化し続ける中で、さらに興味深い開発が現れ、機械学習モデルの力が社会に利益をもたらすことが予想されます。

GoogleのAI研究者がPic2Wordを紹介:ゼロショット合成画像検索(ZS-CIR)への新しいアプローチ

画像検索は、正確に表現しようとすると複雑なプロセスです。多くの研究者が、与えられた実際の画像からの最小の損失を確保するために、このプロセスに取り組んでいます。研究者は、テキスト埋め込みを介して画像を表現する方法を見つけました。しかし、テキストを介した画像のフォーマットは、重大な損失と低い精度があるため、課題となっています。この画像表現は、コンピュータビジョンと畳み込みニューラルネットワークの広範なカテゴリに属しています。研究者たちは、最小の損失を持つ合成画像検索(CIR)システムを開発しましたが、この方法の問題は、モデルのトレーニングに大規模なデータセットが必要であることです。 この問題に対する解決策として、Google AIの研究者はPic2Wordという手法を導入しました。これは、xからyへの関数のマッピングと同じです。したがって、画像は単語にマッピングされ、ゼロショットの最小損失が保証されます。この手法の利点は、ラベル付きデータを必要としないことです。ラベルのない画像やキャプション付き画像にも適用できますが、これらはラベル付きデータセットよりも容易に収集できます。研究者たちは、これを畳み込みニューラルネットワークに非常に類似していると考えています。トレーニングセットには「クエリと説明」が含まれます。この情報は検索モデルに渡され、ニューラルネットワークと比較して隠れ層として機能します。この情報を隠れ層を通じて渡すことで、ベースライン画像と出力画像が得られます。この場合、入力と出力画像の間には最小の損失があります。 研究者が提案したコントラスティブ画像事前学習モデルは、テキストと画像の埋め込みを生成する機械学習モデルです。画像はビジュアルエンコーダに渡され、ビジュアル埋め込み空間を生成します。これはさらにテキストエンコーダに処理され、テキストの埋め込みを生成します。これらのビジュアル埋め込みとテキスト埋め込みはさらに処理され、このモデルを介して最小の損失が得られます。この損失はコントラスティブ損失と呼ばれます。テキスト埋め込みは画像の検索に使用され、検索された画像が得られます。画像の出力は異なる画像ですが、内容は元と同じです。したがって、この方法では最小の損失が発生します。ファッション属性合成モデルは、入力画像と同じ画像が出力される機械学習モデルです。このモデルで得られる色も、入力と同じです。 これらの手法は、画像を単語トークンにマッピングするのに非常に役立ちます。研究者は、画像をテキストトークンとして扱うトレーニング済みのCLIPモデルを使用することを提案しており、言語エンコーダが画像特徴とテキストの説明を柔軟に組み合わせることができます。研究者は、Pic2Wordをさまざまな多様なタスクで包括的な分析を行っています。

「OpenAI APIを使用して、大規模な言語モデルを用いた表データ予測の改善」

最近では、大規模な言語モデルやそのアプリケーションやツールがニュースやソーシャルメディアで話題になっていますGitHubのトレンディングページには、広範なリポジトリが大量に掲載されています...

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.