Learn more about Search Results Gin - Page 12

- You may be interested

- StableSRをご紹介します:事前トレーニン...

- MITエンジニアによって開発された心臓右心...

- このAI論文は、機械学習パイプライン内の...

- 「バイデン大統領の画期的なAI行政命令を...

- このAI論文は、コントロール可能なマルチ...

- 「アルマンド・ソラール・レザマが初代デ...

- 「現実的なシミュレーションを用いたデー...

- AIがセキュリティを向上させる方法

- あなたの言語モデルやAPIを活用するための...

- エントロピー正則化強化学習の説明

- 「研究者がドメイン固有の科学チャットボ...

- オープンソースのベクトルデータベースChr...

- スタンフォード大学の研究者たちは、「Hye...

- 「人種は心臓病を予測するために使用でき...

- SQLクエリにおいてGPT-4よりも優れたもの...

Hugging Faceの推論エンドポイントを使用してLLMをデプロイする

オープンソースのLLMであるFalcon、(オープン-)LLaMA、X-Gen、StarCoder、またはRedPajamaは、ここ数ヶ月で大きく進化し、ChatGPTやGPT4などのクローズドソースのモデルと特定のユースケースで競合することができるようになりました。しかし、これらのモデルを効率的かつ最適化された方法で展開することはまだ課題です。 このブログ投稿では、モデルの展開を容易にするマネージドSaaSソリューションであるHugging Face Inference EndpointsにオープンソースのLLMを展開する方法と、応答のストリーミングとエンドポイントのパフォーマンステストの方法を紹介します。さあ、始めましょう! Falcon 40Bの展開方法 LLMエンドポイントのテスト JavaScriptとPythonでの応答のストリーミング 始める前に、Inference Endpointsについての知識をおさらいしましょう。 Hugging Face Inference Endpointsとは何ですか Hugging Face Inference Endpointsは、本番環境での機械学習モデルの展開を簡単かつ安全な方法で提供します。Inference Endpointsを使用することで、開発者やデータサイエンティストはインフラストラクチャの管理をせずにAIアプリケーションを作成できます。展開プロセスは数回のクリックで簡略化され、オートスケーリングによる大量のリクエストの処理、ゼロスケールへのスケールダウンによるインフラストラクチャのコスト削減、高度なセキュリティの提供などが可能となります。 LLM展開における最も重要な機能のいくつかは以下の通りです: 簡単な展開: インフラストラクチャやMLOpsの管理を必要とせず、本番用のAPIとしてモデルを展開できます。 コスト効率:…

HuggingFace Researchが紹介するLEDITS:DDPM Inversionと強化された意味的なガイダンスを活用したリアルイメージ編集の次なる進化

テキストガイド拡散モデルを利用した写真生成の現実感と多様性の向上により、関心が大幅に高まっています。大規模モデルの導入により、写真の作成時には前例のないほどのクリエイティブな柔軟性がユーザーに与えられるようになりました。その結果、画像操作にこれらの強力なモデルを使用する方法を調査するための継続的な研究プロジェクトが開発されました。テキストベースの画像操作に関する最近の進歩が示されました。他の研究者は最近、拡散モデルに対する意味的なガイダンス(SEGA)のアイデアを発表しました。 SEGAは、高度な画像の構成と編集のスキルを持ち、現在の生成プロセス全体で外部の監視や計算を必要としませんでした。SEGAに関連するアイデアベクトルは、信頼性があり、独立しており、組み合わせが柔軟であり、単調にスケーリングすることが示されました。さらなる研究では、Prompt-to-Promptなどのセマンティック理解に基づく画像の生成方法について検討しました。この方法では、モデルのクロスアテンション層のセマンティックデータを使用してピクセルとテキストプロンプトトークンをリンクさせます。SEGAはトークンベースの条件付けを必要とせず、多くの意味的な変更の組み合わせを可能にする一方、クロスアテンションマップ上の操作により、生成される画像への多様な変更が可能になります。 実際の写真のテキストガイド編集には、提供された画像を反転させるために現代の技術が必要です。これには、拡散プロセスに入力された場合に入力画像となる一連のノイズベクトルを見つける必要があります。ほとんどの拡散ベースの編集研究では、単一のノイズマップから生成された画像への確定的マッピングであるDenoising Diffusion Implicit Model(DDIM)技術が使用されています。他の研究者によって、Denoising Diffusion Probabilistic Model(DDPM)スキームの反転アプローチも提案されました。 DDPMスキームの拡散生成プロセスで使用されるノイズマップが、従来のDDPMサンプリングで使用されるものとは異なる動作をするため、より大きな分散を持ち、タイムステップ間でより相関があります。ノイズマップの計算には、新しい方法が提案されています。DDIMベースの反転技術とは対照的に、Edit Friendly DDPM Inversionは、テキストベースの編集ジョブで最先端の結果を提供し、各入力画像とテキストに対してさまざまな出力を生成することが実証されています。このレビューでは、HuggingFaceの研究者がSEGAとDDPM反転手法またはLEDITSの組み合わせと統合を気軽に調査することを目的としています。 セマンティックに指示された拡散生成メカニズムは、LEDITSで変更されます。このアップデートにより、SEGAの手法が実際の写真に拡張されます。両手法の同時編集機能を利用する統合編集戦略が提案され、最先端の技術を使用して競争力のある質的な結果が示されています。HuggingFaceデモとコードも提供されています。

JavaScriptを使用してOracleデータベース内からHugging Face AIを呼び出す方法

JavaScriptとオープンソースを使用して完全に無料でAIアーキテクチャを最適化し、SQL、JSON、またはRESTを使用して同じデータにアクセスしてください

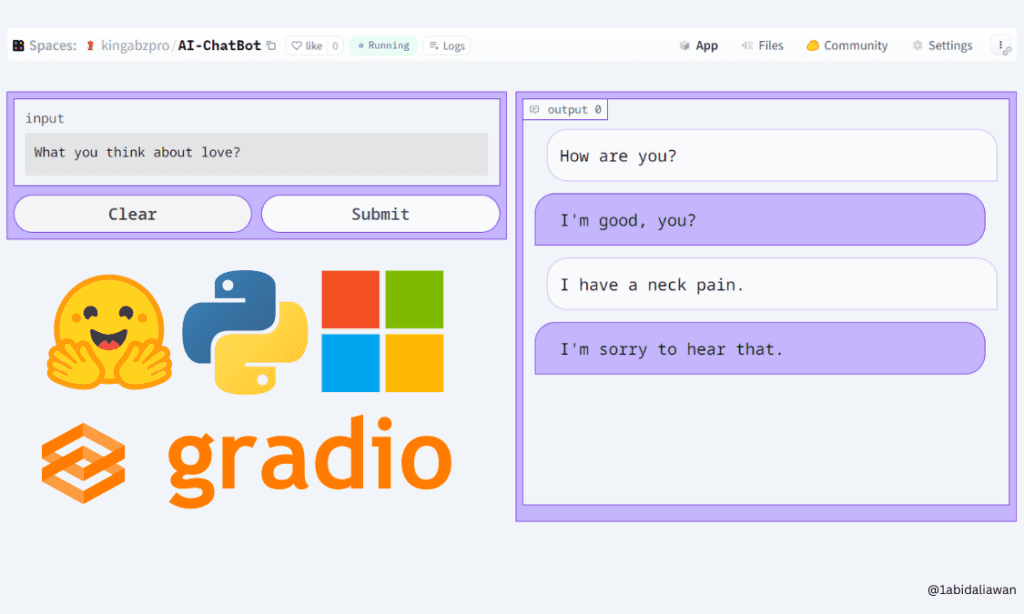

Hugging FaceとGradioを使用して、5分でAIチャットボットを構築する

この簡単なチュートリアルを使って、ブラウザ上で低コード技術を使ってGradioチャットボットを作成する方法を学びましょう

Hugging Face Datasets での作業

AIプラットフォームであるHugging Faceは、最先端のオープンソースの機械学習モデルの構築、トレーニング、展開を行いますこれらのトレーニング済みモデルをホスティングするだけでなく、Hugging Faceはデータセットもホスティングしています...

vLLMについて HuggingFace Transformersの推論とサービングを加速化するオープンソースLLM推論ライブラリで、最大24倍高速化します

大規模言語モデル、略してLLMは、人工知能(AI)の分野において画期的な進歩として登場しました。GPT-3などのこのようなモデルは、自然言語理解を完全に革新しました。これらのモデルが既存の大量のデータを解釈し、人間らしいテキストを生成できる能力を持っていることから、これらのモデルは、AIの未来を形作るために膨大な可能性を秘めており、人間と機械の相互作用とコミュニケーションに新たな可能性を開くことができます。ただし、LLMで達成された大成功にもかかわらず、このようなモデルに関連する重要な課題の1つは、計算の非効率性であり、最も強力なハードウェアでも遅いパフォーマンスにつながることがあります。これらのモデルは、数百万から数十億のパラメータで構成されているため、このようなモデルをトレーニングするには、広範囲な計算リソース、メモリ、および処理能力が必要であり、常にアクセスできるわけではありません。さらに、これらの複雑なアーキテクチャによる遅い応答時間により、LLMはリアルタイムまたはインタラクティブなアプリケーションでは実用的ではなくなることがあります。そのため、これらの課題に対処することは、LLMのフルポテンシャルを引き出し、その利点をより広く利用可能にするために不可欠なことになります。 この問題に取り組むため、カリフォルニア大学バークレー校の研究者たちは、vLLMというオープンソースライブラリを開発しました。このライブラリは、LLMの推論とサービングのためのよりシンプルで、より速く、より安価な代替方法です。Large Model Systems Organization (LMSYS)は、現在、このライブラリをVicunaとChatbot Arenaの駆動力として使用しています。初期のHuggingFace Transformersベースのバックエンドに比べて、vLLMに切り替えることで、研究機関は限られた計算リソースを使用しながらピークトラフィックを効率的に処理することができ、高い運用コストを削減することができました。現在、vLLMは、GPT-2、GPT BigCode、LLaMAなど、いくつかのHuggingFaceモデルをサポートしており、同じモデルアーキテクチャを維持しながら、HuggingFace Transformersのスループットレベルを24倍に向上させることができます。 バークレーの研究者たちは、PagedAttentionという革新的なコンセプトを導入しました。これは、オペレーティングシステムでのページングの従来のアイデアをLLMサービングに拡張した、新しいアテンションアルゴリズムです。PagedAttentionは、キーと値のテンソルをより柔軟に管理する方法を提供し、連続した長いメモリブロックが必要なくなるため、非連続のメモリスペースにそれらを格納することができます。これらのブロックは、アテンション計算中にブロックテーブルを使用して個別に取得することができ、より効率的なメモリ利用を実現します。この巧妙な技術を採用することで、メモリの無駄を4%未満に減らし、ほぼ最適なメモリ使用を実現できます。さらに、PagedAttentionは、5倍のシーケンスをまとめてバッチ処理できるため、GPUの利用率とスループットが向上します。 PagedAttentionには、効率的なメモリ共有の追加的な利点があります。複数の出力シーケンスが単一のプロンプトから同時に作成される並列サンプリング時に、PagedAttentionは、そのプロンプトに関連する計算リソースとメモリを共有することを可能にします。これは、論理ブロックを同じ物理ブロックにマッピングすることによって実現されます。このようなメモリ共有メカニズムを採用することで、PagedAttentionはメモリ使用量を最小限に抑え、安全な共有を確保します。研究者たちによる実験評価により、並列サンプリングによりメモリ使用量を55%削減し、スループットを2.2倍に向上させることができることが明らかになりました。 まとめると、vLLMは、PagedAttentionメカニズムの実装により、アテンションキーと値のメモリ管理を効果的に処理します。これにより、優れたスループット性能が実現されます。さらに、vLLMは、よく知られたHuggingFaceモデルとシームレスに統合され、並列サンプリングなどの異なるデコーディングアルゴリズムと一緒に使用することができます。ライブラリは、簡単なpipコマンドを使用してインストールでき、オフライン推論とオンラインサービングの両方に現在利用可能です。

Amazon SageMakerのHugging Face推定器とモデルパラレルライブラリを使用してGPT-Jを微調整する

GPT-Jは、Eleuther AIによってリリースされたオープンソースの60億パラメータのモデルですこのモデルはPileで訓練され、言語処理の様々なタスクを実行することができますテキスト分類、トークン分類、テキスト生成、質問応答、エンティティ抽出、要約、感情分析など、様々なユースケースをサポートすることができますGPT-Jは、...

「言語モデルの逆スケーリングの謎を解明する」

This aspect of inverse scaling is a crucial point to keep in mind, as it can affect the performance of larger LLMs. However, this…

チャットボットは学校での不正行為を助長しているのか?最新の研究結果が驚くべき結果を明らかにしています

「スタンフォード大学の研究者によると、ChatGPTなどのA.I.ツールの使用は高校での不正行為の増加にはつながらなかったということが分かりましたこの結果は、この種のツールの効果的かつ倫理的な使用を証明する上で非常に価値があります」

Googleは独占禁止法訴訟で敗訴:ビッグテックにとって何を意味するのか?

「エピックゲームズが検索大手との法的闘争に勝利した事は画期的な勝利であり、同社の強さと決断力を示す重要な節目となりました」

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.