Learn more about Search Results 18 - Page 127

- You may be interested

- 「最初の機械学習モデルの作成と提供」

- 「ConDistFLとの出会い:CTデータセットに...

- 「非構造化データファンネル」

- TaatikNet(ターティクネット):ヘブライ...

- 「Pythonデータ操作スキルを向上させるた...

- 「最適効率のための証明済み戦略:Azure V...

- 「GPT-4が怠け者です:OpenAIが認める」

- 「NSFが1,090万ドルの資金を安全なAI技術...

- 「P-値:統計的有意性の理解を平易な言葉で」

- デジタルアート保護の革命:不正なAIウェ...

- 「Glazeとの出会い:アーティストが生成AI...

- 「2Dマテリアルがハードウェアのために3D...

- Microsoft BingはNVIDIA Tritonを使用して...

- 「Muybridge Derby AIによる動物の運動写...

- 「Serverlessを導入するのは難しいですか?」

非教師あり学習シリーズ:階層クラスタリングの探索

前回の「教師なし学習シリーズ」の投稿では、最も有名なクラスタリング手法の1つであるK平均法クラスタリングについて探究しました今回の投稿では、別の手法の背後にある方法について説明します...

ソフトウェア開発活動のための大規模シーケンスモデル

Google の研究科学者である Petros Maniatis と Daniel Tarlow が投稿しました。 ソフトウェアは一度に作られるわけではありません。編集、ユニットテストの実行、ビルドエラーの修正、コードレビューのアドレス、編集、リンターの合意、そしてより多くのエラーの修正など、少しずつ改善されていきます。ついには、コードリポジトリにマージするに十分な良い状態になります。ソフトウェアエンジニアリングは孤立したプロセスではなく、人間の開発者、コードレビュワー、バグ報告者、ソフトウェアアーキテクト、コンパイラ、ユニットテスト、リンター、静的解析ツールなどのツールの対話です。 今日、私たちは DIDACT(Dynamic Integrated Developer ACTivity)を説明します。これは、ソフトウェア開発の大規模な機械学習(ML)モデルをトレーニングするための方法論です。 DIDACT の新規性は、完成したコードの磨き上げられた最終状態だけでなく、ソフトウェア開発のプロセス自体をトレーニングデータのソースとして使用する点にあります。開発者が作業を行う際に見るコンテキストと、それに対するアクションを組み合わせて、モデルはソフトウェア開発のダイナミクスについて学び、開発者が時間を費やす方法により合わせることができます。私たちは、Google のソフトウェア開発の計装を活用して、開発者活動データの量と多様性を以前の作品を超えて拡大しました。結果は、プロのソフトウェア開発者にとっての有用性と、一般的なソフトウェア開発スキルを ML モデルに注入する可能性という2つの側面で非常に有望です。 DIDACT は、編集、デバッグ、修復、およびコードレビューを含む開発活動をトレーニングするマルチタスクモデルです。 私たちは DIDACT Comment…

Imagen EditorとEditBench:テキストによる画像補完の進展と評価

グーグルリサーチの研究エンジニアであるスー・ワンとセズリー・モンゴメリーによる投稿 過去数年間、テキストから画像を生成する研究は、画期的な進展(特に、Imagen、Parti、DALL-E 2など)を見ており、これらは自然に関連するトピックに浸透しています。特に、テキストによる画像編集(TGIE)は、完全にやり直すのではなく、生成された物と撮影された視覚物を編集する実践的なタスクであり、素早く自動化されたコントロール可能な編集は、視覚物を再作成するのに時間がかかるか不可能な場合に便利な解決策です(例えば、バケーション写真のオブジェクトを微調整したり、ゼロから生成されたかわいい子犬の細かいディテールを完璧にする場合)。さらに、TGIEは、基礎となるモデルのトレーニングを改良する大きな機会を表しています。マルチモーダルモデルは、適切にトレーニングするために多様なデータが必要であり、TGIE編集は高品質でスケーラブルな合成データの生成と再結合を可能にすることができ、おそらく最も重要なことに、任意の軸に沿ってトレーニングデータの分布を最適化する方法を提供できます。 CVPR 2023で発表される「Imagen Editor and EditBench: Advancing and Evaluating Text-Guided Image Inpainting」では、マスクインペインティングの課題に対する最先端の解決策であるImagen Editorを紹介します。つまり、ユーザーが、編集したい画像の領域を示すオーバーレイまたは「マスク」(通常、描画タイプのインターフェイス内で生成されるもの)と共にテキスト指示を提供する場合のことです。また、画像編集モデルの品質を評価する方法であるEditBenchも紹介します。EditBenchは、一般的に使用される粗い「この画像がこのテキストに一致するかどうか」の方法を超えて、モデルパフォーマンスのより細かい属性、オブジェクト、およびシーンについて詳細に分析します。特に、画像とテキストの整合性の信頼性に強い重点を置きつつ、画像の品質を見失わないでください。 Imagen Editorは、指定された領域にローカライズされた編集を行います。モデルはユーザーの意図を意味を持って取り入れ、写真のようなリアルな編集を実行します。 Imagen Editor Imagen Editorは、Imagenでファインチューニングされた拡散ベースのモデルで、編集を行うために改良された言語入力の表現、細かい制御、および高品質な出力を目的としています。Imagen Editorは、ユーザーから3つの入力を受け取ります。1)編集する画像、2)編集領域を指定するバイナリマスク、および3)テキストのプロンプトです。これら3つの入力は、出力サンプルを誘導します。 Imagen Editorは、高品質なテキストによる画像インペインティングを行うための3つの核心技術に依存しています。まず、ランダムなボックスとストロークマスクを適用する従来のインペインティングモデル(例:Palette、Context…

スピードは必要なすべてです:GPU意識の最適化による大規模拡散モデルのオンデバイス加速化

コアシステム&エクスペリエンスのソフトウェアエンジニアであるJuhyun LeeとRaman Sarokinによる投稿 画像生成のための大規模な拡散モデルの普及により、モデルサイズと推論ワークロードは大幅に増加しました。モバイル環境でのオンデバイスML推論には、リソース制約のために緻密なパフォーマンス最適化とトレードオフの考慮が必要です。コスト効率とユーザープライバシーの必要性により、大規模拡散モデル(LDM)のオンデバイスでの実行は、これらのモデルの大幅なメモリ要件と計算要件のために更に大きな課題を提供します。 本稿では、私たちの「速さこそがすべて:GPUによる大規模拡散モデルのオンデバイスアクセラレーションによる最適化」に焦点を当て、モバイルGPU上の基本的なLDMモデルの最適化された実行について述べます。このブログ記事では、Stable Diffusionなどの大規模拡散モデルを高速で実行するために使用した主なテクニックをまとめ、512×512ピクセルのフル解像度で20回イテレーションを行い、蒸留なしでオリジナルモデルの高性能推論速度で12秒未満で実行できるようにしました。前回のブログ記事で述べたように、GPUアクセラレーションされたML推論は、メモリのパフォーマンスに制限されることがよくあります。そして、LDMの実行も例外ではありません。したがって、私たちの最適化の中心テーマは、演算論理ユニットの効率性を優先するものよりも、メモリの入出力(I/O)の効率性であり、ML推論の全体的なレイテンシを減らすことです。 LDMのサンプル出力。プロンプトテキスト:「周りの花と可愛い子犬の写真リアルな高解像度画像」。 メモリ効率のための強化されたアテンションモジュール ML推論エンジンは通常、最適化されたさまざまなML操作を提供します。しかし、各ニューラルネット演算子を実行するためのオーバーヘッドがあるため、最適なパフォーマンスを達成することは依然として難しい場合があります。このオーバーヘッドを緩和するため、ML推論エンジンは、複数の演算子を1つの演算子に統合する広範な演算子フュージョンルールを組み込んで、テンソル要素を横断するイテレーション数を減らすことで、イテレーションあたりの計算を最大限に増やします。たとえば、TensorFlow Liteは、畳み込みのような計算負荷の高い演算と、後続の活性化関数であるReLUのような演算を組み合わせる演算子フュージョンを利用しています。 最適化の明らかな機会は、LDMのデノイザーモデルで採用された頻繁に使用されるアテンションブロックです。アテンションブロックにより、重要な領域に重みを割り当てることで、モデルは入力の特定の部分に焦点を当てることができます。アテンションモジュールを最適化する方法は複数ありますが、以下に説明する2つの最適化のうち、どちらが優れたパフォーマンスを発揮するかに応じて、選択的に1つを使用します。 第1の最適化である部分的にフュージョンされたsoftmaxは、アテンションモジュール内のsoftmaxと行列乗算の間の詳細なメモリ書き込みと読み取りを省略します。アテンションブロックが単純な行列乗算であると仮定すると、Y = softmax(X)* Wの形式で表されます。ここで、XとWはそれぞれa×bおよびb×cの2D行列です(下図参照)。 数値の安定性のために、T= softmax(X)は、通常、3つのパスで計算されます。 リストの最大値を決定し、行ごとに行列Xを計算します 各リスト項目の指数関数と最大値(パス1から)の差を合計します アイテムから最大値を引いた指数関数を、パス2からの合計で除算します これらのパスを単純に実行すると、中間テンソル T に全体のsoftmax関数の出力が格納されるため、巨大なメモリ書き込みが必要になります。パス1と2の結果のみを保存するテクニックを使用することで、m と…

デジタルルネッサンス:NVIDIAのNeuralangelo研究が3Dシーンを再構築

NVIDIA Researchによる新しいAIモデル、Neuralangeloは、ニューラルネットワークを使用して3D再構築を行い、2Dビデオクリップを詳細な3D構造に変換し、建物、彫刻、およびその他の現実世界のオブジェクトのリアルなバーチャルレプリカを生成します。 ミケランジェロが大理石のブロックから驚くべきリアルなビジョンを彫刻したように、Neuralangeloは複雑なディテールと質感を持つ3D構造を生成します。クリエイティブなプロフェッショナルは、これらの3Dオブジェクトをデザインアプリケーションにインポートし、アート、ビデオゲーム開発、ロボット工学、および産業用デジタルツインに使用するためにさらに編集することができます。 Neuralangeloは、屋根の瓦、ガラスの板、滑らかな大理石などの複雑な素材の質感を、従来の手法を大幅に上回る精度で2Dビデオから3Dアセットに変換することができます。この高い信頼性により、開発者やクリエイティブなプロフェッショナルは、スマートフォンでキャプチャされた映像を使用してプロジェクトに使用できる仮想オブジェクトを迅速に作成できます。 「Neuralangeloが提供する3D再構築機能は、クリエイターにとって大きな利益になります。現実世界をデジタル世界に再現するのを支援することで、開発者は小さな像や巨大な建築物などの詳細なオブジェクトを仮想環境にインポートできるようになります。」と、研究のシニアディレクターであり、論文の共著者でもあるMing-Yu Liu氏は述べています。 デモでは、NVIDIAの研究者が、ミケランジェロのダビデ像やフラットベッドトラックなどといったアイコニックなオブジェクトを再現する方法を紹介しました。Neuralangeloは、建物の内部および外部も再構築することができ、NVIDIAのベイエリアキャンパスの公園の詳細な3Dモデルで実証されました。 ニューラルレンダリングモデルが3Dで見る 3Dシーンを再構築するための以前のAIモデルは、繰り返しのテクスチャパターン、同質的な色、および強い色の変化を正確に捉えることができませんでした。Neuralangeloは、これらの微細なディテールを捉えるために、NVIDIA Instant NeRFの背後にある技術であるインスタントニューラルグラフィックスプリミティブを採用しています。 さまざまな角度から撮影されたオブジェクトまたはシーンの2Dビデオを使用して、モデルは異なる視点を捉えたいくつかのフレームを選択します。これは、アーティストが対象を多角的に考慮して深度、サイズ、および形状を把握するのと同じです。 フレームごとのカメラ位置が決定されたら、NeuralangeloのAIはシーンの大まかな3D表現を作成します。これは、彫刻家が主題の形を彫刻し始めるのと同じです。 次に、モデルはレンダリングを最適化してディテールをシャープにします。これは、彫刻家が石を注意深く削って布の質感や人物の形を再現するのと同じです。 最終的な結果は、仮想リアリティアプリケーション、デジタルツイン、またはロボット工学の開発に使用できる3Dオブジェクトまたは大規模なシーンです。 CVRPでNVIDIA Researchを見つける、6月18日〜22日 Neuralangeloは、6月18日から22日にバンクーバーで開催されるコンピュータビジョンとパターン認識のカンファレンス(CVRP)で発表されるNVIDIA Researchの約30のプロジェクトの1つです。これらの論文は、ポーズ推定、3D再構築、およびビデオ生成などのトピックをカバーしています。 これらのプロジェクトの1つであるDiffCollageは、長いランドスケープ方向、360度パノラマ、およびループモーション画像を含む大規模なコンテンツを作成する拡散法です。標準的なアスペクト比の画像のトレーニングデータセットをフィードすると、DiffCollageはこれらの小さな画像をコラージュのピースのように扱い、より大きなビジュアルのセクションとして扱います。これにより、拡散モデルは、同じスケールの画像のトレーニングを必要とせずに、継ぎ目のない大規模なコンテンツを生成できるようになります。 この技術は、テキストプロンプトをビデオシーケンスに変換することもできます。これは、人間の動きを捉える事前訓練された拡散モデルを使用して実証されました。 NVIDIA Researchについてもっと学ぶ。

フォトグラメトリとは何ですか?

「ストリートビュー」のおかげで、現代の地図ツールを使って、レストランを調べたり、周辺のランドマークを見て方向を確認したり、道路上にいるかのような体験をシミュレーションしたりすることができます。 これらの3Dビューを作成するための技術は、フォトグラメトリと呼ばれます。つまり、画像をキャプチャして繋ぎ合わせて物理世界のデジタルモデルを作成するプロセスです。 それはまるでジグソーパズルのようで、各ピースは画像で構成されます。そして、キャプチャされた画像が多ければ多いほど、3Dモデルはより現実的で詳細になります。 フォトグラメトリの作業方法 フォトグラメトリ技術は、建築や考古学などのさまざまな産業にも応用できます。例えば、フォトグラメトリの早い例の一つは、1849年にフランスの軍人アイメ・ローセダがテラストリアル写真を使用して、パリのイノディル旅館で最初の建築調査を行ったことです。 可能な限り多くの領域や環境の写真を撮影して、チームは現場のデジタルモデルを構築して表示・分析することができます。 3Dスキャンは、シーン内のポイントの位置を測定するために構造化されたレーザー光を使用するのに対し、フォトグラメトリは実際の画像を使用してオブジェクトをキャプチャして3Dモデルに変換します。これは、良好なフォトグラメトリには良好なデータセットが必要であることを意味します。また、サイト、記念碑、または遺物のすべての領域がカバーされるように、正しいパターンで写真を撮ることが重要です。 フォトグラメトリの種類 今日、シーンを繋ぎ合わせたい場合、被写体の複数の角度から写真を撮影し、専用のアプリケーションで組み合わせてオーバーラップデータを抽出して3Dモデルを作成することができます。 3ds-scan.de提供のイメージ。 フォトグラメトリには、空中フォトグラメトリと地上フォトグラメトリの2種類があります。 空中フォトグラメトリは、カメラを空中に置いて上から写真を撮影することで、一般的には大きなサイトやアクセスが困難な場所で使用されます。空中フォトグラメトリは、林業や自然資源管理で地理情報データベースを作成するために最も広く使用されています。 地上フォトグラメトリ、またはクローズレンジフォトグラメトリは、よりオブジェクトに焦点を当てたもので、手持ちのカメラまたは三脚に取り付けたカメラで撮影された画像に頼ることが多いです。これにより、現場でのデータ収集が迅速に行われ、より詳細な画像キャプチャが可能になります。 GPUを使用したフォトグラメトリワークフローの加速 最も正確なフォトグラメトリの結果を得るには、チームは巨大な高精度のデータセットが必要です。より多くの写真を撮影すると、より正確で精密なモデルが得られます。ただし、大規模なデータセットは処理に時間がかかり、チームはファイルを処理するためにより多くのコンピュータパワーが必要です。 GPUの最新の進歩は、チームがこれを解決するのに役立ちます。NVIDIA RTXカードなどの高度なGPUを使用することで、ユーザーは処理を高速化し、より高精度なモデルを維持しながら、より大きなデータセットを入力することができます。 例えば、建設チームは、建設現場の進捗状況を示すためにフォトグラメトリ技術を頼りにすることがよくあります。一部の企業は、サイトの画像をキャプチャして仮想的なウォークスルーを作成します。しかし、パワー不足のシステムはチョッピーな視覚体験をもたらし、クライアントやプロジェクトチームとの作業セッションから注意を逸らしてしまいます。 RTXプロフェッショナルGPUの大きなメモリを使用すると、建築家、エンジニア、デザイナーは巨大なデータセットを簡単に管理して、フォトグラメトリモデルをより速く作成・処理することができます。 考古学者ダリア・ダバルは、NVIDIA RTXを使用して、遺物やサイトの高品質なモデルを作成・レンダリングするスキルを拡大しています。 フォトグラメトリは、写真のベクトル化を支援するためにGPUパワーを使用するため、何千もの画像を繋ぎ合わせる作業を加速します。そして、RTXプロフェッショナルGPUのリアルタイムレンダリングとAI機能により、チームは3Dワークフローを加速し、フォトリアルなレンダリングを作成し、3Dモデルを最新の状態に保つことができます。 フォトグラメトリの歴史と将来 フォトグラメトリのアイデアは、写真術の発明の4世紀前の15世紀末にまで遡ります。レオナルド・ダ・ヴィンチは、透視と射影幾何学の原理を開発し、フォトグラメトリの基盤となる柱を築きました。…

メイカーに会おう:ソフトウェアエンジニアがNVIDIA Jetsonを活用して自律運転スケートパークを構築

Kirk Kaiser Kirk Kaiserは、自転車に乗り新聞を配達するというプレイヤーが、通りの中央に出現するランプなどの障害物に遭遇しながら新聞を配達するビデオゲーム「Paperboy」のファンで育ちました。 これが、ソフトウェア開発者の最新プロジェクトのインスピレーション元となり、NVIDIA Jetsonプラットフォームを利用したエッジAIやロボット技術を使用した自動運転スケートランプを作りました。 フロリダ州のナポリに拠点を置く熱心なスケートボーダーであるKaiserは、「私の人生にPaperboyの不条理さと楽しさが加わることを望んでいた」と語ります。「ある日、私は犬のBenjiが私の傍らを走っているのを見ながらボードに乗っていたときに、『私が一緒に持っていけるランプがあったらどうだろうか?』と思いました。」 彼は今、それを実現する技術を構築しています。携帯可能な自律型スケートパークにつながる可能性のある技術です。 これまでに、彼は電動プラットフォームを開発し、ランプを持ち上げて地面と水平にすることができるようにしました。PS4コントローラーを使用し、NVIDIA Jetson Nano Developer KitにBluetoothで接続して操縦できます。 今は、新しいNVIDIA Jetson Orin Nano Developer Kitの助けを借りて、プラットフォームが通りや障害物を認識し、AIモデルをトレーニングするためのデータを収集して、最終的に完全に自律的になることができるようにしています。 これは、彼がGitpodという、ソフトウェアメーカー向けのクラウド開発環境を提供するスタートアップの開発者関係の責任者として没頭していないときに取り組むプロジェクトです。 メーカーについて Kaiserは、若いうちからソフトウェアエンジニアリングを学び、テクノロジーに特化した名門高校に奨学金を受け入れました。そこで、彼はプログラミングスキルを磨き、若い大人になる前に、まったく異なる方法で世界を見て体験する時間を過ごしました。 18歳のとき、彼はバッグを詰め、コスタリカの野生生物保護区で1年間暮らし、パーマカルチャーファームで働き、食べ物を育てて飲料用の雨水を集めました。その後、バーモントに移り、禅仏教徒と一緒に農業を行い、アパラチアン・トレイルの1,000マイルのハイキングをし、4つの州を通り抜けました。 トレイルを去った後、Kirkは旅行ウェブサイトを立ち上げ、化粧品会社で最初のソフトウェアの仕事を得て、照明会社の研究開発部門で働き、家族を養うためにソフトウェアエンジニアリングの情熱を再燃させました。現在、4歳の息子を含む家族を養うために働いています。…

Rendered.aiは、合成データの生成にNVIDIA Omniverseを統合します

Rendered.aiは、プラットフォームとして提供される合成データ生成(SDG)により、開発者、データサイエンティスト、その他の人々のAIトレーニングを簡素化しています。 コンピュータビジョンAIモデルのトレーニングには、膨大で高品質で多様で偏りのないデータセットが必要です。これらを入手することは困難でコストがかかるため、AIの需要と供給の双方が増大する中で特に課題になります。 Rendered.aiのプラットフォームは、3Dシミュレーションから作成された物理的に正確な合成データを生成することにより、コンピュータビジョンモデルのトレーニングに役立ちます。 「実世界のデータは、AIモデルを一般化するために必要なすべてのシナリオとエッジケースをキャプチャできないことがあり、それがAIおよび機械学習エンジニアにとってキーとなるSDGの場所です」と、シアトルの郊外であるベルビューに拠点を置くRendered.aiの創設者兼CEOであるNathan Kundtzは述べています。 NVIDIA Inceptionプログラムの一員であるRendered.aiは、オンライントレーニング、ロボティクス、自律走行などの多くのアプリケーションにラベル付き合成データを生成することができるOmniverse Replicatorをプラットフォームに統合しました。 Omniverse Replicatorは、Universal Scene Description(「OpenUSD」)、Material Definition Language(MDL)、およびPhysXを含む3Dワークフローのオープンスタンダードに基づいて構築され、仮想世界の風景と植生のモデリング、衛星画像のオブジェクト検出、さらには人間の卵細胞の生存可能性のテストに使用されています。 Omniverse Replicatorを使用して生成された合成画像。Rendered.ai提供。 Rendered.aiは、Omniverse ReplicatorのRTXアクセラレーション機能を活用することで、レイトレーシング、ドメインランダム化、マルチセンサーシミュレーションなどの機能を利用することができます。コンピュータビジョンエンジニア、データサイエンティスト、およびその他のユーザーは、クラウド上の簡単なウェブインターフェイスを介して合成データを迅速かつ簡単に生成することができます。 「AIをトレーニングするために持つ必要があるデータは、実際にAIのパフォーマンスを支配する要因です」とKundtzは述べています。「Omniverse ReplicatorをRendered.aiに統合することで、さまざまな産業分野でより大きく、より優れたAIモデルをトレーニングするために合成データを利用するユーザーにとって、新しいレベルの簡単さと効率が実現されます。」 Rendered.aiは、カナダのバンクーバーで6月18日から22日まで開催されるコンピュータビジョンとパターン認識のカンファレンス(CVPR)で、Omniverse Replicatorとのプラットフォーム統合をデモンストレーションします。 クラウドでの合成データ生成 AWS…

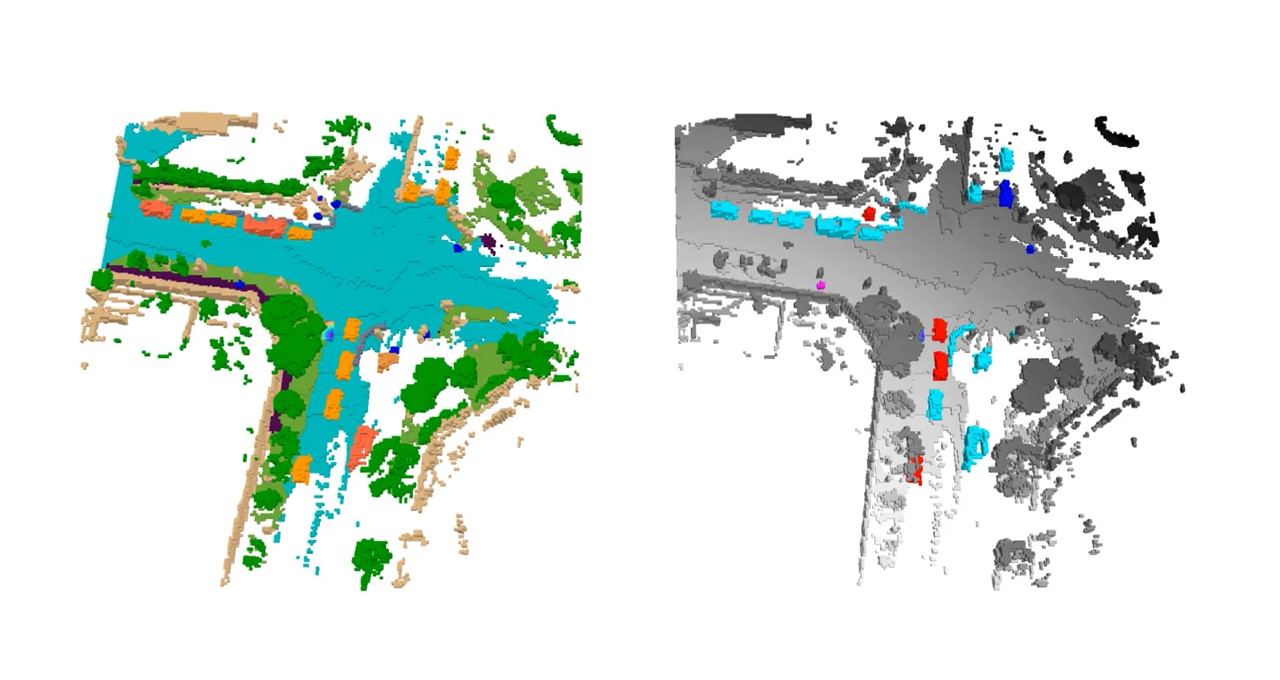

NVIDIAリサーチがCVPRで自律走行チャレンジとイノベーション賞を受賞

NVIDIAは、カナダのバンクーバーで開催されるComputer Vision and Pattern Recognition Conference(CVPR)において、自律走行開発の3D占有予測チャレンジで激戦を制し、優勝者として紹介されます。 この競技には、10地域にまたがる約150チームから400以上の投稿がありました。 3D占有予測とは、シーン内の各ボクセルの状態を予測するプロセスであり、つまり3Dバードアイビューグリッド上の各データポイントを指します。ボクセルは、フリー、占有、または不明として識別することができます。 安全で堅牢な自動運転システムの開発に不可欠な3D占有グリッド予測は、NVIDIA DRIVEプラットフォームによって可能になる最新の畳み込みニューラルネットワークやトランスフォーマーモデルを使用して、自律車両(AV)の計画および制御スタックに情報を提供します。 「NVIDIAの優勝ソリューションには、2つの重要なAVの進歩があります」と、NVIDIAの学習と知覚のシニアリサーチサイエンティストであるZhiding Yu氏は述べています。「優れたバードアイビュー認識を生み出す最新のモデル設計を実証することができます。さらに、3D占有予測での10億パラメーターまでのビジュアルファウンデーションモデルの効果と大規模な事前学習の有効性を示しています。」 自動運転の知覚は、画像内のオブジェクトや空きスペースなどの2Dタスクの処理から、複数の入力画像を使用して3Dで世界を理解することに進化しています。 これにより、複雑な交通シーン内のオブジェクトについて柔軟で精密な細かい表現が提供されるようになり、これはNVIDIAのAV応用研究および著名な科学者であるJose Alvarez氏によれば、「自律走行の安全感知要件を達成するために重要です。」 Yu氏は、NVIDIA Researchチームの受賞作品を、6月18日(日)10:20 a.m. PTに開催されるCVPRのEnd-to-End Autonomous Driving Workshopおよび6月19日(月)4:00 p.m. PTに開催されるVision-Centric…

データサイエンスのワークフローにChatGPTを統合する:ヒントとベストプラクティス

ChatGPT をデータサイエンスワークフローに統合したい場合は、以下の例とヒント、ベストプラクティスを参考にして、ChatGPT を最大限に活用してください

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.