Learn more about Search Results これ - Page 11

- You may be interested

- 「KOSMOS-2:Microsoftによるマルチモーダ...

- vLLM:24倍速のLLM推論のためのPagedAtten...

- 「OpenAIやLM Studioに頼らずにAutoGenを...

- 「ステレオタイプやディスインフォメーシ...

- 「信頼性のあるLLMテストの5つの柱」

- レイザーのエッジに VFXスターであるサー...

- 「AIにおけるアメリカのリーダシップの確...

- LLMsによる非構造化データから構造化デー...

- 私たちの早期警戒システムへのサポート

- 「DeepMindからスタートアップの成功へ:A...

- 「RNNにおける誤差逆伝播法と勾配消失問題...

- 『Amazon SageMaker を使用して、Talent.c...

- 「AIは医療セキュリティにおいて重要である」

- 「AIと産業のデジタル化の時代に、開かれ...

- 「AIレポート2023年」を解説する

CMU、AI2、およびワシントン大学の研究グループが、NLPositionalityというAIフレームワークを導入しましたこれは、デザインのバイアスを特徴づけ、NLPのデータセットとモデルの位置性を定量化するためのものです

研究者の立場性は、NLPデータセットとモデルの開発時に彼ら自身の経験、アイデンティティ、文化、背景によって形成される視点に影響を与えます。 潜在的な設計の選択肢と研究者の立場性は、データセットとモデルの制作における設計のバイアスの2つの要因です。これにより、データセットとモデルの機能には異なる人口に対しての違いが生じます。しかし、あるグループの基準を世界中の他の人々に強制することで、制度的な不平等を維持することができます。問題は、取る必要のある様々な設計の選択肢の幅広さであり、これらの選択肢のサブセットのみがデータセットとモデルの構築時に記録される場合があることです。さらに、プロダクションで広く使用されているモデルの多くはAPIの外部に露出されていないため、設計のバイアスを直接特徴づけることが困難です。 ワシントン大学、カーネギーメロン大学、Allen Institute for AIの最近の研究では、NLP(自然言語処理)のデータセットとモデルの立場性と設計のバイアスを記述するためのパラダイムであるNLPositionalityを提案しています。研究者は、さまざまな文化的・言語的バックグラウンドを持つグローバルなボランティアコミュニティを採用し、データセットのサンプルに注釈を付けることで設計のバイアスを測定します。次に、異なるアイデンティティと文脈を対比させ、どのアイデンティティが元のデータセットのラベルやモデルの予測とより一致しているかを調べます。 NLPositionalityは、他の方法(有料のクラウドソーシングや実験室での実験など)と比較して3つの利点があります: 他のクラウドソーシングプラットフォームや従来の実験室研究と比較して、LabintheWildはより多様な参加者人口を有しています。 金銭的な報酬に頼るのではなく、この方法は参加者自身の自己認識を広げるという内発的な欲求に基づいています。参加者の学習の可能性が増し、データの品質が有料のクラウドソーシングプラットフォームと比較して向上します。したがって、他の研究で見られるような一回限りの有料研究とは異なり、このプラットフォームでは新しい注釈を自由に収集し、より最新の設計バイアスの観察を長期間にわたって反映することができます。 この方法は、任意のデータセットやモデルに事後に適用するための既存のラベルや予測を必要としません。 研究者は、社会的に受け入れられる性質と憎悪表現の検出という2つのバイアスのあるNLPタスクの例にNLPositionalityを使用しています。彼らはタスク固有とタスク一般の大規模な言語モデル(つまり、GPT-4)と関連するデータセットと教師付きモデルを調査します。2023年5月25日現在、平均して87カ国から1,096の注釈者が1日あたり38の注釈を提供し、16,299の注釈が寄せられました。チームは、英語圏の白人で大学教育を受けたミレニアル世代が「WEIRD」(Western, Educated, Industrialized, Rich, Democratic)人口のサブセットであり、調査対象のデータセットとモデルに最も適していることを発見しました。さまざまな情報源からデータと注釈を収集する重要性も、データセットが元の注釈者と高いレベルで整合していることによって強調されています。彼らの研究結果は、より多様なモデルとデータセットを含めたNLPの研究の拡大の必要性を示唆しています。

LAION AIは、Video2Datasetを紹介しますこれは、効率的かつスケールでビデオとオーディオのデータセットをキュレーションするために設計されたオープンソースツールです

CLIP、Stable Diffusion、Flamingoなどの大規模な基盤モデルは、過去数年間にわたり、マルチモーダルな深層学習を劇的に向上させました。テキストと画像の共同モデリングは、ニッチなアプリケーションから、今日の人工知能の領域で最も関連性の高い問題の1つ(もしくは最も関連性の高い問題)にまで進化しました。これらのモデルは、壮観で高解像度のイメージを生成したり、難しい下流の問題を解決するといった、卓越した能力を持っています。驚くべきことに、これらのモデルは、非常に異なるタスクに取り組み、非常に異なる設計を持っているにもかかわらず、強力なパフォーマンスに貢献する共通の3つの基本的な特性を持っています。それは、(事前)トレーニング中のシンプルで安定した目的関数、よく調査されたスケーラブルなモデルアーキテクチャ、そしておそらく最も重要なこととして、大規模で多様なデータセットです。 2023年現在、マルチモーダルな深層学習は、テキストと画像のモデリングに主に関心があり、ビデオ(および音声)などの追加のモダリティにはほとんど注意が払われていません。モデルをトレーニングするために使用される技術は通常モダリティに依存しないため、なぜ他のモダリティ用の堅牢な基盤モデルが存在しないのか疑問に思うかもしれません。その簡単な説明は、高品質で大規模なアノテーション付きデータセットの希少性です。クリーンなデータの不足は、特にビデオの領域において、大規模なマルチモーダルモデルの研究開発を妨げています。これに対し、画像モデリングでは、LAION-5B、DataComp、COYO-700Mなどのスケーリング用の確立されたデータセットやimg2datasetなどのスケーラブルなツールが存在します。 革新的なイニシアチブ、例えば高品質なビデオや音声の作成、改良された事前学習済みモデルのロボット工学への応用、盲人コミュニティ向けの映画ADなどを可能にするため、研究者はこのデータの問題解決を(オープンソースの)マルチモーダル研究の中心的目標として提案しています。 研究者は、高速で包括的なビデオおよび音声データセットのキュレーションを行うためのオープンソースプログラムであるvideo2datasetを提案しています。video2datasetは、いくつかの大規模なビデオデータセットで正常にテストされており、適応性があり、拡張性があり、多数の変換を提供しています。このメソッドを複製するための詳細な手順と、これらのケーススタディをリポジトリで見つけることができます。 研究者は、個々のビデオデータセットをダウンロードし、それらを結合し、新しい特徴と大量のサンプルを持つより管理しやすい形状に整形することで、既存のビデオデータセットをベースにvideo2datasetを活用してきました。より詳細な説明については、例セクションを参照してください。video2datasetが提供するデータセットで異なるモデルをトレーニングした結果は、このツールの効果を示しています。今後の研究では、新しいデータセットと関連する調査結果について詳しく議論します。 まずは、video2datasetを定義しましょう。 Webdatasetが受け入れ可能なinput_formatであるため、video2datasetは以前にダウンロードしたデータを再処理するためのチェーンで使用することができます。前の例でダウンロードしたWebVidデータを使用して、このスクリプトを実行すると、各ムービーの光流を計算し、それをメタデータシャードに保存します(光流メタデータのみを含むシャード)。 アーキテクチャ img2datasetをベースにしているvideo2datasetは、URLのリストと関連するメタデータを受け取り、単一のコマンドでロード可能なWebDatasetに変換します。さらに、同じシャードの内容を保持したまま、WebDatasetを追加の変更のために再処理することもできます。video2datasetはどのように機能するのでしょうか。説明します。 アイデアの交換 最初のステップは、入力データを均等にワーカー間で分割することです。これらの入力シャードは一時的にキャッシュされ、それらとそれらに対応する出力シャードとの一対一のマッピングにより、障害のない回復が保証されます。データセットの処理が予期せず終了した場合、既に対応する出力シャードを持つ入力シャードをスキップすることで時間を節約することができます。 コミュニケーションと研究 ワーカーは、シャードに含まれるサンプルを読み取り、処理するために交互に行動します。研究者は、マルチプロセス、pyspark、slurmの3つの異なる分散モードを提供しています。前者は単一マシンのアプリケーションに最適であり、後者は複数のマシンにスケーリングするために有用です。着信データセットの形式は、読み取り戦略を決定します。データがURLのテーブルである場合、video2datasetはインターネットからビデオを取得し、データセットに追加します。video2datasetは、見つからないビデオを要求するためにyt-dlpを使用するため、さまざまなビデオプラットフォームで動作します。ただし、ビデオサンプルが既存のWebデータセットから来る場合、そのデータセットのデータローダーはバイトまたはフレームのテンソル形式を読み取ることができます。 サブサンプリング ビデオが読み込まれ、ワーカーがビデオのバイトを取得した後、バイトはジョブの設定に従ってサブサンプラーのパイプラインを通過します。この段階では、ビデオはフレームレートと解像度の両方でオプションでダウンサンプリングされる場合があります。また、クリップされたり、シーンが識別されたりする場合もあります。一方、入力モダリティから解像度/圧縮情報、合成キャプション、オプティカルフローなどのメタデータを抽出および追加することを目的としたサブサンプラーもあります。video2datasetに新しい変換を追加するには、新しいサブサンプラーを定義するか、既存のサブサンプラーを変更するだけで十分です。これは大いに助けになり、リポジトリの他の場所で数か所の変更を行うだけで実装できます。 ログ記録 Video2datasetは、プロセスの複数のポイントで詳細なログを保持しています。各シャードの完了は、関連する「ID」_stats.jsonファイルに結果を記録します。ここには、処理されたサンプルの総数、正常に処理されたサンプルの割合、および発生したエラーの内容と性質などの情報が記録されます。Weights & Biases(wand)は、video2datasetと組み合わせて使用できる追加のツールです。この統合をオンにするだけで、成功と失敗の詳細なパフォーマンスレポートやメトリクスにアクセスできます。これらの機能は、ジョブ全体に関連するベンチマーキングやコスト見積りのタスクに役立ちます。 書き込み 最後に、video2datasetは変更された情報を出力シャードにユーザー指定の場所に保存し、次のトレーニングまたは再処理操作で使用します。データセットは、各サンプルが含まれるシャードで構成されたいくつかの形式でダウンロードできます。これらの形式には、フォルダ、tarファイル、レコード、およびparquetファイルが含まれます。デバッグ用の小規模データセットにはディレクトリ形式、ローディングにはWebDataset形式でtarファイルが使用されます。 再処理 video2datasetは、出力シャードを読み込んでサンプルを新しい変換に通過させることで、以前の出力データセットを再処理することができます。この機能は、しばしば重いサイズと扱いにくい性質が特徴のビデオデータセットに対して特に有利です。これにより、大量の大きなデータセットのダウンロードを回避するためにデータを慎重にダウンサンプリングすることができます。次のセクションでは、研究者がこれに関する実践的な例を探求します。…

「ディープランゲージモデルは、コンテキストから次の単語を予測することを学ぶことで、ますます優れてきていますこれが本当に人間の脳が行っていることなのでしょうか?」

ディープラーニングは、テキスト生成、翻訳、および補完の分野で最近大きな進歩を遂げています。周囲の文脈から単語を予測するために訓練されたアルゴリズムは、これらの進歩を実現する上で重要な役割を果たしてきました。しかし、膨大な訓練データにアクセスできるにもかかわらず、ディープ言語モデルはまだ長いストーリーの生成、要約、一貫した対話、情報検索などのタスクを実行するための支援が必要です。これらのモデルは、文法や意味的な特性を捉えるのに支援が必要であり、言語的な理解がより表面的である必要があります。予測コーディング理論は、人間の脳が多様な時間スケールと表現のレベルで予測を行うことを示唆しています。以前の研究では、脳内での音声予測の証拠が示されていましたが、予測された表現の性質とその時間的範囲はほとんど知られていませんでした。最近、研究者は304人の被験者が短編小説を聞いている際の脳の信号を分析し、長距離および多レベルの予測を深層言語モデルに組み込むことで脳のマッピングを改善することがわかりました。 この研究の結果、言語の予測は大脳皮質で階層的に組織されていることが明らかになりました。これらの結果は、脳が表現の多レベルと時間スケールにわたって予測を行うことを示唆する予測コーディング理論と一致しています。これらの考えを深層言語モデルに取り入れることで、人間の言語処理とディープラーニングアルゴリズムのギャップを埋めることができます。 この研究では、予測コーディング理論の具体的な仮説を評価するために、深層言語モデルと304人の被験者が話された物語を聞いている際の脳活動を比較しました。その結果、長距離および高レベルの予測を補完した深層言語アルゴリズムの活性化が脳活動を最もよく説明することがわかりました。 この研究は3つの主な貢献をしました。まず、上角回と側頭、側頭葉、および前頭葉の活性化が最も長い予測距離を持ち、将来の言語表現を積極的に予測していることがわかりました。優越的な側頭溝と上角回は低レベルの予測で最もよくモデル化され、中間頭頂、頭頂葉、および前頭領域は高レベルの予測で最もよくモデル化されます。次に、予測表現の深さは同様の解剖学的なアーキテクチャに沿って変化します。最後に、長期予測に影響を与えるのは構文ではなく意味的な特性です。 データによれば、側頭、側頭葉、前頭葉、上角回は最も長い予測距離を持つことが示されました。これらの脳の領域は、抽象的な思考、長期計画、注意の調整、高レベルの意味といった高レベルの実行活動に関連しています。研究によれば、これらの領域は言語の階層のトップに位置し、過去の刺激を受動的に処理するだけでなく、将来の言語表現を積極的に予測する可能性があります。 この研究はまた、同じ解剖学的な組織に沿って予測表現の深さに変動があることを示しました。優越的な側頭溝と上角回は低レベルの予測で最もよくモデル化され、中間頭頂、頭頂葉、および前頭領域は高レベルの予測で最もよくモデル化されます。その結果は仮説と一致しています。現代の言語アルゴリズムとは異なり、脳は単語レベルだけでなく、さまざまなレベルで表現を予測します。 最後に、研究者は脳の活性化を構文的な表現と意味的な表現に分け、長期予測には構文的な要素ではなく意味的な要素が影響を与えることを発見しました。この結果は、長い文章の言語処理の核心が高レベルの意味的な予測に関わる可能性があることを支持しています。 この研究の総括として、自然言語処理のベンチマークを改善し、モデルを脳とより似たものにするために、アルゴリズムを一貫して多くの時間スケールと表現レベルを予測するように訓練することができる可能性が示唆されています。

「Amazon SageMakerトレーニングワークロードで@remoteデコレータを使用してプライベートリポジトリにアクセスする」

「ますます多くの顧客が機械学習(ML)のワークロードを本番環境に展開しようとする中、MLコードの開発ライフサイクルを短縮するために、組織内での大きな推進があります多くの組織は、試験的なスタイルではなく、Pythonのメソッドやクラスの形式でMLコードを本番向けに書くことを好みます」

「Amazon SageMakerのトレーニングワークロードで、@remoteデコレータを使用してプライベートリポジトリにアクセスする」

「機械学習(ML)のワークロードを本番環境に展開しようとする顧客がますます増えているため、MLコードの開発ライフサイクルを短縮するための組織内での大きな取り組みが行われています多くの組織は、探索的スタイルではなく、Pythonのメソッドとクラスの形式で、本番環境に対応したスタイルでMLコードを記述することを好む...」

「これらの仕事はAIによって置き換えられると考える人もいる私たちは異論を唱えます」

「人工知能が仕事を置き換えるという議論は、ChatGPTや他の生成型AIツールが世界中で大流行するにつれてますます広がっていますしかし、信じるかどうかは別として、それだけが全てではありません実際、産業革命と同様に、AI革命も仕事を...」

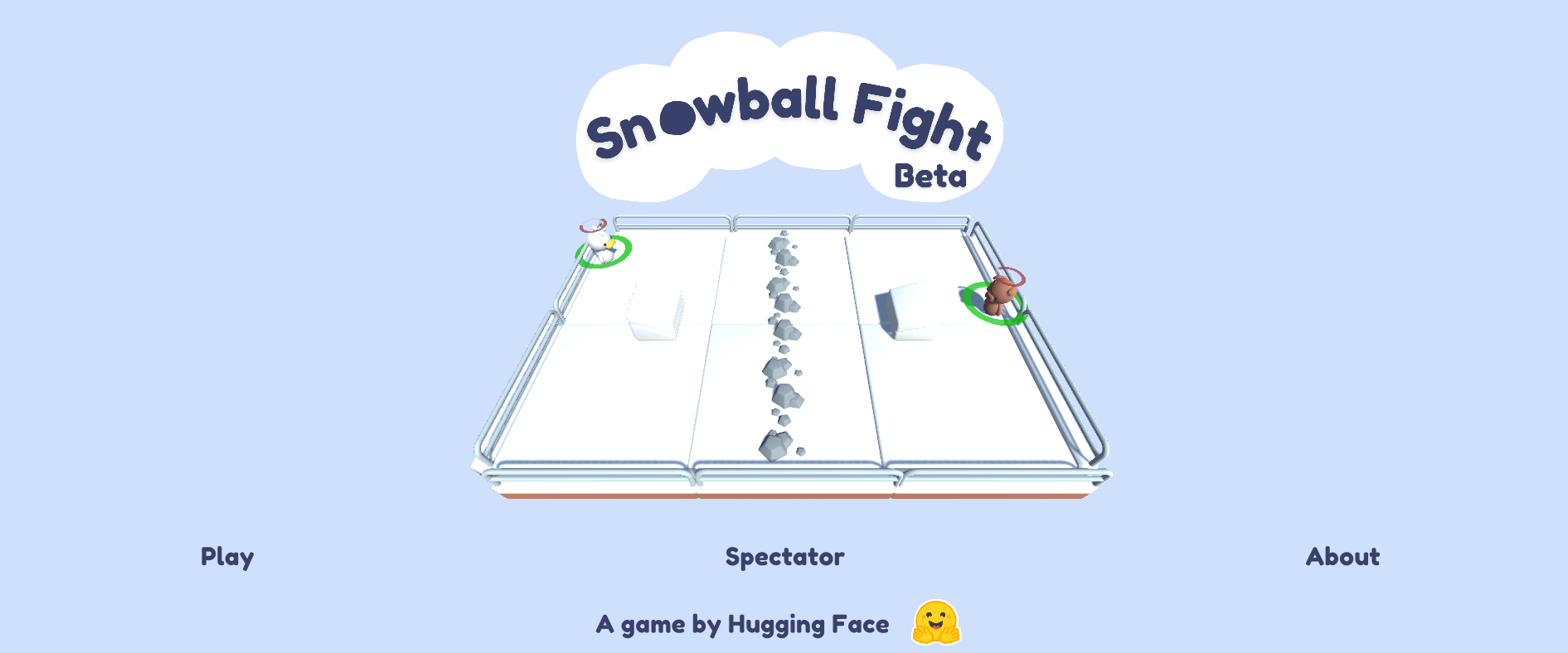

スノーボールファイト ☃️をご紹介しますこれは私たちの最初のML-Agents環境です

私たちは、初めてのカスタムDeep Reinforcement Learning環境:Snowball Fight 1vs1 🎉を共有できることを嬉しく思います。 Snowball Fightは、Unity ML-Agentsを使用して作成されたゲームで、Deep Reinforcement Learningエージェントに対して雪玉を撃つことができます。このゲームはHugging Face Spacesでホストされています。 👉オンラインでプレイすることができます この投稿では、Unity ML-Agentsを使用するDeep Reinforcement Learning研究者や愛好家向けのエコシステムについて説明します。 Hugging FaceのUnity ML-Agents Unity Machine Learning…

ウィスコンシン大学とバイトダンスの研究者は、PanoHeadを紹介しますこれは、単一のビュー画像のみでビュー一貫性のあるフルヘッド画像を合成する、初の3D GANフレームワークです

コンピュータビジョンとグラフィックスでは、写真のような写実的な肖像画像合成が常に強調されており、仮想アバター、テレプレゼンス、没入型ゲームなど、さまざまな領域で下流アプリケーションが広がっています。現在の生成的対抗ネットワーク(GAN)の最近の進展により、本物の画像と区別できないほどの高品質な画像合成が実現されています。しかし、現代の生成手法では、基礎となる3Dシーンをモデル化するのではなく、2D畳み込みネットワーク上で操作されます。その結果、異なる位置にある頭部画像を合成する際に3Dの一貫性を適切に保証することは不可能です。従来の手法では、広範な3Dスキャンコレクションから学習したパラメトリックなテクスチャ付きメッシュモデルを使用して、さまざまな形状と外観を持つ3Dヘッドを生成します。 ただし、生成された画像はより細かなディテールが必要であり、表現力と知覚品質が低いです。よりリアルな3D認識顔画像を作成するために、異なるiable renderingとimplicit neural representationの登場により、条件付き生成モデルが作成されました。ただし、これらの手法は、しばしばマルチビュー画像または3Dスキャンの監督に依存します。これは入手が困難であり、通常は制御された環境で記録されるため外観分布が制約されます。3Dシーンモデリングと画像合成のためのimplicit neural representationの最近の進展により、3D認識生成モデルの開発が加速されています。 図1は、PanoHeadが高品質なジオメトリと360ビューに一貫した写真のような完全なヘッド画像合成を可能にする方法を示しています。 これらのうち、先駆的な3D GANであるEG3Dは、視点に一貫した画像合成の印象的な品質を持ち、野生のシングルビュー画像セットを使用してトレーニングされました。ただし、これらの3D GANメソッドは、ほぼ正面からの視点でしか合成できません。ByteDanceとウィスコンシン大学マディソン校の研究者は、ユニークな3D認識GANであるPanoHeadを提案しています。これは野生の非構造化写真のみを使用してトレーニングされ、360で高品質な完全な3Dヘッド合成を可能にします。テレプレゼンスやデジタルアバターなど、さまざまな没入型インタラクション状況では、彼らのモデルがすべての視点から見える一貫した3Dヘッドを合成できる能力が役立ちます。彼らは、彼らの手法が完全に360度の3Dヘッド合成を実現する最初の3D GANアプローチであると考えています。 EG3Dなどの3D GANフレームワークを使用した場合、完全な3Dヘッド合成にはいくつかの主要な技術的障害があります。多くの3D GANは前景と背景を区別できず、2.5Dヘッドジオメトリになってしまいます。一般的に壁構造として構成される背景は、3Dで作成されたヘッドと絡み合ってしまいますので、大きなポーズはレンダリングできません。彼らは、2D画像セグメンテーションからの以前の情報を使用して、前景ヘッドの3D空間での分解を同時に学習する前景認識トライディスクリミネータを開発しました。さらに、トライプレーンなどのハイブリッド3Dシーン表現は、360度カメラのポーズに対して重要な投影の不確実性を持っており、効率とコンパクトさにもかかわらず、後頭部に「反転した顔」が表示されます。 彼らは、トライプレーン表現の効果を保持しながら、前面の特徴を後頭部から分離する独自の3Dトライグリッドボリューム表現を提供します。最後に、野生の後頭部の正確なカメラ外部パラメータを取得することは非常に困難です。また、これらと正面写真との画像配置には顕著な顔ランドマークの違いがあります。配置のギャップからは、魅力的でないヘッドジオメトリとノイズのある外観が生じます。そのため、彼らは、すべての視点からの写真を信頼性の高い方法で整列させるユニークな2段階の整列方法を提案しています。この手順により、3D GANの学習曲線が大幅に短縮されます。 彼らは、リアヘッドの画像のアライメントのずれを考慮に入れるために、レンダリングカメラの位置を動的に修正するカメラ自己適応モジュールを提案しています。図1に示すように、彼らのアプローチは、任意の視点からの野外全頭写真に適応する3D GANの能力を大幅に向上させています。その結果、生成される3D GANは、定量的な指標で最先端の技術を上回る高品質な360° RGB画像とジオメトリを生成します。このモデルを使用すると、単眼で撮影された映像から全頭の3Dポートレートを簡単に再構築する方法が示されています。 以下は、彼らの主な貢献の要約です: ・ビューの整合性があり、高品質な360度全頭画像合成が可能な、最初の3D GANフレームワーク。フィールドで撮影された高品質の単眼3D頭部再構成を使用して、彼らの手法を説明しています。…

プリンストンの研究者たちは、革新的な軽量フレームワーク「InterCode」を導入しましたこれにより、人間のような言語からコード生成のための言語モデルの相互作用が効率化されました

ChatGPTは、OpenAIによって開発された最新のチャットボットであり、リリース以来話題になっています。このGPTトランスフォーマーアーキテクチャベースのモデルは、人間のように正確に質問に答えるだけでなく、ブログやソーシャルメディア、研究などのためのコンテンツを生成し、言語を翻訳し、長いテキスト段落を要点を保持しながら要約し、コードサンプルさえ生成します。GPT、BERT、PaLM、LLaMaなどの大規模言語モデルは、人工知能の分野の進歩に成功を収めています。これらのディープラーニングモデルは、自然言語処理と自然言語理解の可能性を効果的に活用しています。 近年では、自然言語仕様からコードを自動生成するモデルの開発が人気を集めています。これらのモデルは、数千のコードベースでの広範な事前学習により、静的ベンチマークで印象的なパフォーマンスを発揮していますが、タイプミス、コードの作成プロセスと実行の間のギャップ、限られた人間の関与など、特定の制限もあります。 これらの課題に対処するために、プリンストン大学のコンピュータサイエンス部の研究者は、インタラクティブなコーディングを標準的な強化学習(RL)環境として容易に行えるようにする軽量かつ柔軟なフレームワークであるInterCodeを提案しました。InterCodeでは、コードをアクションとして扱い、実行フィードバックを観測として考慮します。このRLベースの手法により、コーディングをより反復的に行うことができ、言語やプラットフォームに依存しないように設計されているため、多くのプログラミング言語や環境と使用することができます。 InterCodeは、安全で繰り返し可能な実行を保証するために独立したDocker環境も使用します。これは従来のシーケンス対シーケンス(seq2seq)コーディング技術と互換性があり、現在の手法を簡単に採用および統合することができます。また、インタラクティブなコード生成に特化した新しいアプローチの開発を容易にすることも可能です。 評価のために、チームはBashとSQLをアクションスペースとして使用した2つのインタラクティブなコード環境を構築し、InterCodeの有用性を示しました。彼らはReActやPlan&Solveなどのさまざまなプロンプティング手法を備えたいくつかの優れた言語モデルを、静的なSpiderとNL2Bashデータセットのデータを使用して訓練および評価しました。InterCodeの実験は、インタラクティブなコード生成の利点を示しながら、コード理解と生成能力の向上を目指す難しいベンチマークとしての潜在能力を強調しました。 チームは以下のように主な貢献をまとめています。 InterCodeは、新しい汎用的なインタラクティブコード生成フレームワークであり、使いやすさ、拡張性、安全性を提供します。ユーザーフレンドリーでアクセスしやすく、研究者が簡単に実験に利用できます。 InterCodeを使用して、いくつかの信じられないほど優れた最先端のモデルにアクセスし、評価し、潜在的な改善点を指摘しました。 InterCodeベンチマークは、インタラクティブなコード生成タスクの標準化された評価プラットフォームとして機能し、異なるモデルのパフォーマンスを共通のフレームワークを使用して比較することができます。これにより、静的なコードの新しいデータセットをインタラクティブな活動に変換することができます。 結論として、InterCodeは、人工知能の分野の進歩において有望なアプローチであり、インタラクティブなコード生成を大幅に進化させ、標準化された評価プラットフォームを提供し、この領域のさらなる研究と開発を促進します。

ML プレゼンテーションに PowerPoint を使うのをやめて、代わりにこれを試してみてください

悪いパワーポイントは、注意散漫な聴衆を生み出します(彼らはカメラをオフにし、複数のタスクを同時に行います)また、そのようなパワーポイントは、プレゼンターが過剰な専門用語を使用するなどの悪い習慣に甘んじることを容易にします

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.