Learn more about Search Results ML - Page 10

- You may be interested

- ChatGPTを使用したメール自動化の方法

- MLコードを保守しやすくするためのソフト...

- ルーシッドドリーマー:インターバルスコ...

- 本番環境向けのベクトル検索の構築

- 「MLOpsの全機械学習ライフサイクルをカバ...

- 「プラットプス:データセットのキュレー...

- ETH Zurichの研究者が、推論中に0.3%のニ...

- 物理情報を組み込んだDeepONetによるオペ...

- 「金融機関は責任あるAIを活用して金融犯...

- 「Pythonを使用した地理空間データの分析...

- 「(ベクター)インデックスの隠れた世界」

- 「NASAが宇宙探査用に3Dプリントでロケッ...

- 正確にピークと谷を検出するためのステッ...

- 人間の嗅覚とAIが匂いの命名で競い合う

- 「トップ5のクラウドマシンラーニングプラ...

「Feature Store Summit 2023 プロダクション環境でのMLモデルの展開の実践的な戦略」

2023年10月11日、Feature Store Summitでは、UberやWeChatなどの主要な機械学習企業が集まり、データとAIについての詳細な議論が行われます

「Amazon SageMaker Feature Store Feature Processorを使用して、MLの洞察を解き放つ」

Amazon SageMaker Feature Storeは、機械学習(ML)のための特徴量エンジニアリングを自動化するためのエンドツーエンドのソリューションを提供します多くのMLユースケースでは、ログファイル、センサーの読み取り、トランザクションレコードなどの生データを、モデルトレーニングに最適化された意味のある特徴に変換する必要があります特徴量の品質は、高精度なMLモデルを確保するために重要です[...]

「Amazon SageMakerとHugging Faceを使用して、FetchはML処理の遅延を50%削減します」

この記事は、元々2023年9月にAWSのウェブサイトで公開された記事のクロスポストです。 概要 消費者エンゲージメントと報酬会社であるFetchは、ユーザーがレシートをスキャンして購入に対して報酬を得ることができるアプリケーションを提供しています。同社はまた、これらのレシートを解析して消費者の行動に関する洞察を生成し、ブランドパートナーに提供しています。週ごとのスキャンが急速に増加するにつれて、Fetchはスピードと精度を向上させる必要がありました。 Amazon Web Services(AWS)上で、FetchはHugging FaceとAmazon SageMakerを使用して機械学習(ML)パイプラインを最適化しました。Amazon SageMakerは、完全に管理されたインフラストラクチャ、ツール、ワークフローを備えたMLモデルの構築、トレーニング、展開を行うためのサービスです。これにより、Fetchアプリはスキャンをより速く、かつ大幅に高い精度で処理することができます。 機会 | FetchのMLパイプラインを12か月でAmazon SageMakerを使用して高速化する Fetchアプリを使用して、顧客はレシートをスキャンし、ポイントを受け取り、それらのポイントをギフトカードと交換することができます。Fetchは、領収書のスキャンに対してユーザーに即座に報酬を与えるために、領収書からテキストをキャプチャし、関連するデータを抽出し、その他のシステムが処理および分析できるように構造化する必要がありました。ピークトラフィック時には週に8000万枚以上のレシートを処理する必要があり、秒間数百枚のレシートを素早く、正確に処理する必要がありました。 2021年、Fetchはアプリのスキャン機能を最適化することを決定しました。FetchはAWSネイティブの会社であり、MLオペレーションチームは既に多くのモデルでAmazon SageMakerを使用していました。これにより、モデルをAmazon SageMakerに移行してMLパイプラインを強化する決定は容易なものでした。 プロジェクト全体を通じて、FetchはAWSチームと週次の通話を行い、AWSがFetchとペアになった専門家からサポートを受けました。Fetchは12か月でAmazon SageMakerを使用して5つ以上のMLモデルを構築、トレーニング、展開しました。2022年末に、Fetchは更新されたモバイルアプリと新しいMLパイプラインをリリースしました。 「Amazon SageMakerはFetchにとって画期的なものです。ほぼすべての機能を広範に使用しています。新しい機能が登場すると、すぐに価値があります。Amazon SageMakerの機能なしでこのプロジェクトを行うことは想像できません。」 Sam Corzine、機械学習エンジニア、Fetch…

Rocket Money x Hugging Face プロダクションで変動するMLモデルのスケーリング

「彼らはただのサービスプロバイダではなく、私たちの目標と結果に投資しているパートナーだと気づきました」- ニコラス・クザック、ロケットマネーのシニアMLエンジニア。 MLOpsチームなしでの本番環境でのMLモデルのスケーリングとメンテナンス 私たちは、Rocket Money(以前の名前はTruebillの個人ファイナンスアプリ)を作成し、ユーザーが自分の財務状況を改善できるようにしました。ユーザーは銀行口座をアプリにリンクさせ、トランザクションを分類し、カテゴリ分けし、繰り返しのパターンを特定して、個人の財務状況を総合的かつ包括的に表示します。トランザクション処理の重要な段階は、Rocket Moneyが会員のためにキャンセルし、費用を交渉できるいくつかの既知の販売業者やサービスを検出することです。この検出は、短く、しばしば切り詰められ、暗号化された形式のトランザクション文字列をクラスに変換して、製品体験を豊かにするために使用します。 新しいシステムへの旅 最初に、正規表現ベースの正規化器を使用してトランザクションからブランドと製品を抽出しました。これらは、文字列を対応するブランドにマッピングする複雑になる決定表と併用されました。このシステムは、キャンセルと交渉に対応する製品にのみ結び付けられたクラスが存在する場合には効果的でしたが、ユーザーベースが拡大し、サブスクリプションエコノミーが急速に発展し、製品の範囲が拡大するにつれて、新しいクラスの数と正規表現のチューニングや衝突の防止に追いつく必要がありました。これを解決するために、バッグオブワーズモデルとクラスごとのモデルアーキテクチャを使用したさまざまな従来の機械学習(ML)ソリューションを検討しました。このシステムはメンテナンスとパフォーマンスに苦労し、保留となりました。 私たちは、まっさらな状態から新しいチームと新しい命令を組み立てることに決めました。最初の課題はトレーニングデータを蓄積し、ゼロから社内システムを構築することでした。私たちはRetoolを使用してラベリングキュー、ゴールドスタンダードの検証データセット、ドリフト検出モニタリングツールを構築しました。さまざまなモデルトポロジーを試しましたが、最終的にはBERTファミリーのモデルを選び、テキスト分類の問題を解決しました。初期のモデルのテストと評価のほとんどは、GCPのデータウェアハウス内でオフラインで実施されました。ここでは、4000以上のクラスを持つモデルのパフォーマンスを測定するために使用したテレメトリとシステムを設計および構築しました。 Hugging Faceとのパートナーシップによるドメインの課題と制約の解決 私たちのドメイン内には、商品を提供する業者や処理/支払い会社、機関の違い、ユーザーの行動の変化など、独自の課題がいくつかあります。効率的なモデルのパフォーマンスアラート設計と現実的なベンチマーキングデータセットの構築は、継続的に課題となっています。もう1つの重要な課題は、システムの最適なクラス数を決定することです-各クラスは作成とメンテナンスに相当な労力を要するため、ユーザーとビジネスへの価値を考慮する必要があります。 オフラインのテストでうまく機能するモデルと少数のMLエンジニアのチームを持つ私たちは、新たな課題に直面しました:そのモデルを私たちの本番パイプラインにシームレスに統合すること。既存の正規表現システムは、月間100万以上のトランザクションを処理し、非常に負荷の高い状態で動作していましたので、パイプライン内で低い全体的なレイテンシを維持するために動的にスケーリングできる高可用性のシステムが重要でした。当時の小さなスタートアップとして、モデルサービングソリューションを構築する代わりに購入することにしました。当時、社内でのモデルオペレーションの専門知識はなく、MLエンジニアのエネルギーを製品内のモデルのパフォーマンス向上に集中させる必要がありました。これを念頭に置いて、私たちは解決策を探しました。 最初は、プロトタイピングに使用していた手作りの社内モデルホスティングソリューションをAWS SagemakerとHugging Faceの新しいモデルホスティング推論APIと比較して試してみました。データの保存にはGCPを使用し、モデルトレーニングにはGoogle Vertex Pipelinesを使用していたため、AWS Sagemakerへのモデルのエクスポートは不便でバグがありました。幸いなことに、Hugging Faceの設定は迅速かつ簡単であり、1週間以内に一部のトラフィックを処理することができました。Hugging Faceはそのまま動作し、この摩擦の低減により、私たちはこの道を進むことになりました。 約3か月にわたる評価期間の後、私たちはHugging Faceをモデルのホスティングに選びました。この期間中、トランザクションのボリュームを徐々に増やし、最悪のケースシナリオのボリュームに基づいた数々のシミュレートされた負荷テストを実施しました。このプロセスにより、システムを微調整し、パフォーマンスを監視し、トランザクションの拡張負荷を処理する推論APIの能力に自信を持つことができました。 技術的な能力を超えて、私たちはハギングフェイスのチームとの強い関係を築きました。彼らは単なるサービスプロバイダーではなく、私たちの目標と成果に投資しているパートナーであることを発見しました。コラボレーションの初期段階で、私たちは貴重な存在であるとわかる共有のSlackチャンネルを設置しました。彼らが問題に対して迅速に対応し、積極的な問題解決のアプローチを取る姿勢には特に感銘を受けました。彼らのエンジニアやCSMは、私たちの成功への取り組みと正しい方法での取り組みを常に示しました。これにより、最終的な選択をする時に私たちは追加の自信を得ることができました。…

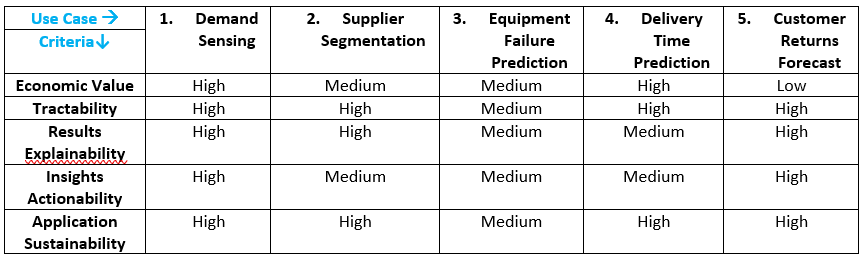

AI/MLを活用してインテリジェントなサプライチェーンを構築するための始め方

「異なる供給チェーンの要素に対するAI/MLの使用事例と価値提案:計画、調達、製造、配送、逆物流」

AutoMLのジレンマ

「AutoMLは過去数年間、注目の的となってきましたそのハイプは非常に高まり、人間の機械学習の専門家を置き換えるという野心さえも持っていますしかし、長期間にわたってほとんど採用されていないという現実があります…」

「Google AIの新しいパラダイムは、多段階の機械学習MLアルゴリズムの組成コストを削減して、強化されたユーティリティを実現する方法は何ですか」

今日のデータ駆動型の環境では、機械学習やデータ分析アルゴリズムの有用性を最大化しながらプライバシーを確保することが重要な課題となっています。複数の計算ステップによるプライバシー保証の劣化である合成のコストは、大きな障害となっています。基礎研究の進展や差分プライバシーの導入にもかかわらず、プライバシーと有用性の適切なバランスを取ることは未だに困難です。 DP-SGDなどの既存の手法は、機械学習モデルのトレーニング中にプライバシーを保護する面で進歩を遂げています。しかし、これらの手法はトレーニング例をミニバッチにランダムに分割することに依存しており、データに依存した選択が必要なシナリオでは効果が制限されます。 Reorder-Slice-Compute (RSC) パラダイムは、STOC 2023で発表された画期的な開発です。この革新的なフレームワークは、適応的なスライス選択を可能にし、合成コストを回避します。順序付けられたデータポイント、スライスサイズ、差分プライバシーアルゴリズムを特定の構造に従わせることにより、RSCパラダイムはプライバシーを犠牲にすることなく有用性を向上させる新たな可能性を切り開きます。 広範な研究と実験から得られた指標は、RSCパラダイムの威力を示しています。従来の手法とは異なり、RSC解析はステップ数に依存しないため、全体的なプライバシー保証は単一ステップと同等です。この突破は、基本的な集計や学習タスクにおけるDPアルゴリズムの有用性を大幅に向上させます。 RSCパラダイムの注目すべき応用の一つは、プライベートな区間点問題の解決です。スライスの選択と新たな解析を組み合わせることで、RSCアルゴリズムはlog*|X|の順序でプライバシーを保護する解を実現し、従来のDPアルゴリズムの大きな障害を克服します。 RSCパラダイムは、プライベートな近似中央値や軸に平行な長方形の学習など、一般的な集計タスクにも取り組んでいます。特定の問題に適したRSCステップのシーケンスを利用することで、アルゴリズムは誤ラベルのある点を制限し、正確かつプライベートな結果を提供します。 さらに、RSCパラダイムは機械学習モデルのトレーニングに革新的なアプローチを提供します。トレーニング例のデータ依存的な選択順序を許容することで、DP-SGDとシームレスに統合し、合成によるプライバシーの劣化を排除します。この進歩は、実稼働環境におけるトレーニングの効率を革新するものとなるでしょう。 まとめると、Reorder-Slice-Compute (RSC) パラダイムは、データ駆動型環境におけるプライバシーと有用性のバランスを取るという長年の課題に対する画期的な解決策です。その独自の構造と新しい解析は、さまざまな集計や学習タスクにおいて新たな可能性を開拓することを約束します。RSCパラダイムは、合成コストを排除することで、より効率的かつプライバシーを保護した機械学習モデルのトレーニングを実現します。このパラダイムシフトは、ビッグデータの時代における頑健なデータプライバシーの追求において重要な瞬間を迎えるものです。

マイクロソフトリサーチがBatteryMLを紹介:バッテリー劣化における機械学習のためのオープンソースツール

リチウムイオン電池は、高いエネルギー密度、長いサイクル寿命、低い自己放電率のおかげで、現代のエネルギー蓄積の要となっています。これらの特性により、電気自動車や家電製品から再生可能エネルギーシステムまで、さまざまな産業で不可欠な存在となっています。しかし、これらの電池には容量の減少や性能の最適化といった課題があります。これらは、電池技術の改善において焦点となっている要素です。 容量の減少の複雑さ リチウムイオン電池の容量の減少は、温度や充放電率、充電状態など、さまざまな要素に影響を受ける多面的な問題です。これらの変数に対処することは、これらの電池の性能と寿命を向上させるために重要です。産業界は、高度なバッテリー管理システムの開発や機械学習技術の活用により、予測の精度向上と性能の最適化を図っています。 BatteryMLの紹介 これらの課題に取り組むため、Microsoftは最近、機械学習の研究者、バッテリーの科学者、材料研究者向けにオープンソースのツールであるBatteryMLを発表しました。このツールは、特に容量の減少に関連する課題に対する包括的な解決策を提供することを目指しています。 バッテリー最適化のための機械学習の活用 BatteryMLは、機械学習アルゴリズムを使用して、バッテリーの性能のさまざまな側面を向上させます。これには、容量のフェードモデリング、健康状態の予測、充電状態の推定などが含まれます。機械学習の方法を使用することで、BatteryMLは、より正確で効率的な方法でバッテリーの性能を予測・分析し、運用寿命と信頼性を向上させます。 結論 効率的で長寿命のエネルギー蓄積ソリューションへの需要が高まるにつれて、BatteryMLのようなツールはますます重要になっています。高度な機械学習技術を活用することで、BatteryMLは容量の減少の課題に対処し、性能の最適化の新たな可能性を開拓します。これは、さまざまな産業の絶えず増え続けるエネルギー需要に応えるため、リチウムイオン電池の信頼性と効率性を向上させるための重要な進展です。

「MLCommonsがAIモデルを実行するための新しいベンチマーク速度テストを公開しました」

月曜日、AIのベンチマークグループであるMLCommonsが、最高のハードウェアがAIモデルをどれくらい高速に実行できるかを判断するための新しいテストの結果を発表しましたReutersによると、このテストのトップパフォーマーはNvidiaのチップでしたテストは大規模な言語...

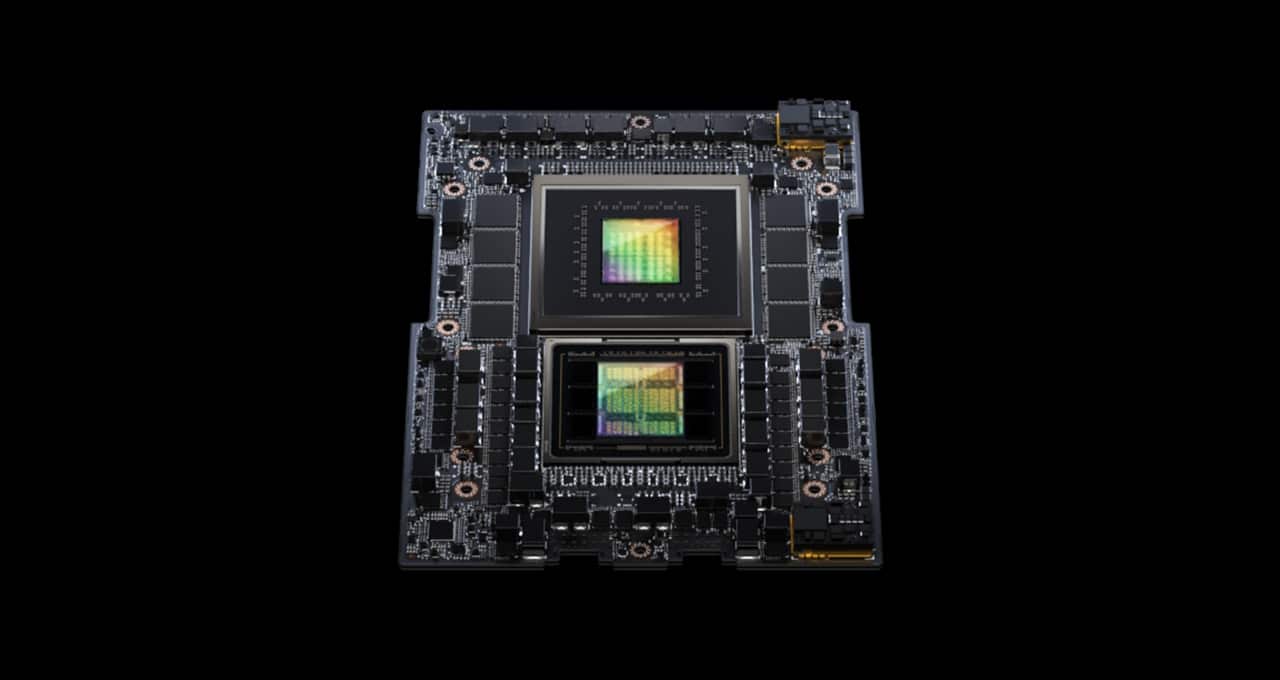

「NVIDIAのグレース・ホッパー・スーパーチップがMLPerfの推論ベンチマークを席巻する」

MLPerf業界ベンチマークに初登場したNVIDIA GH200 Grace Hopperスーパーチップは、すべてのデータセンターインファレンステストを実行し、NVIDIA H100 Tensor Core GPUのリーディングパフォーマンスを拡張しました。 全体的な結果は、NVIDIA AIプラットフォームの卓越したパフォーマンスと多機能性を示しており、クラウドからネットワークのエッジまでの幅広い領域で活躍しています。 別途、NVIDIAは性能、エネルギー効率、総所有コストの向上をユーザーにもたらすインファレンスソフトウェアを発表しました。 GH200スーパーチップがMLPerfで輝く GH200は、Hopper GPUとGrace CPUを1つのスーパーチップに結合しています。この組み合わせにより、より多くのメモリ、帯域幅、およびCPUとGPUの間で自動的に電力を切り替えてパフォーマンスを最適化する能力が提供されます。 また、8つのH100 GPUを搭載したNVIDIA HGX H100システムは、今回のMLPerfインファレンステストのすべての項目で最も高いスループットを実現しました。 Grace HopperスーパーチップとH100 GPUは、コンピュータビジョン、音声認識、医療画像などのMLPerfのデータセンターテスト全般でリードし、推薦システムや生成AIにおける大規模言語モデル(LLM)など、より要求の厳しいユースケースでも優れたパフォーマンスを発揮しました。 全体的に、これらの結果は、2018年のMLPerfベンチマークの開始以来、NVIDIAがAIトレーニングとインファレンスのパフォーマンスリーダーシップを証明し続ける記録を続けています。 最新のMLPerfラウンドでは、推薦システムのテストが更新され、AIモデルのサイズの大まかな指標である6兆パラメータを持つGPT-Jの最初のインファレンスベンチマークが実施されました。…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.