Learn more about Search Results Adam - Page 10

- You may be interested

- 「AI企業は、彼らが引き起こす損害につい...

- Hugging FaceでのDecision Transformersの...

- ロボットを教えるためのより速い方法

- 『LSTM-CRFモデルの詳細解説』

- 「ユナイテッド航空がコスト効率の高い光...

- 「意思決定科学は静かに新しいデータサイ...

- 「AIのリスクと絶滅:AI革命の中での人類...

- 新しいディープラーニングの研究で、抗マ...

- 簡単なアプリの統合に最適な安定した拡散A...

- ChatGPTから独自のプライベートなフランス...

- 「2023年に注目すべきマーケティングトレ...

- ニューヨーク市がAIに照準を合わせる

- 「AIにおけるプロダクションシステムとは...

- ユリーカに会ってください:大規模な言語...

- メタの戦略的な優れた点:Llama 2は彼らの...

RGBビデオから3Dビデオを作成する

「私は常に、私たちがデジタルな思い出を2Dの形式でアーカイブしていることに不満を感じてきました写真やビデオは鮮明さに欠けることはないものの、体験の深さや没入感が欠けているのです…」

「LoRAとQLoRAを用いた大規模言語モデルのパラメータ効率的なファインチューニング」

概要 パラメータ効率の高いファインチューニング(PEFT)の世界に深く没入するにつれて、この革新的な手法の背後にある駆動要因と方法論を理解することが不可欠となってきます。この記事では、PEFT手法が大規模言語モデル(LLM)を特定のタスクに最適化する方法について探求します。PEFTの利点と欠点を解明し、PEFT技術の複雑なカテゴリについて掘り下げ、2つの注目すべき技術であるLow-Rank Adaptation(LoRA)とQuantized Low-Rank Adaptation(QLoRA)の内部動作を解読します。この旅は、これらの技術の包括的な理解を身につけることで、言語処理の取り組みにおいてその力を活用できるようにすることを目指しています。 学習目標: 事前学習済み言語モデルとNLPにおけるファインチューニングの概念を理解する。 ファインチューニング大規模モデルにおける計算およびメモリ要件がもたらす課題について探求する。 Low-Rank Adaptation(LoRA)やQuantized Low-Rank Adaptation(QLoRA)などのPEFT技術について学ぶ。 PEFT手法の利点と欠点を見つける。 T-Few、AdaMix、MEFTなどのさまざまなPEFT手法を探求する。 LoRAとQLoRAの動作原理を理解する。 QLoRAがパラメータ効率を高めるためにどのように量子化を導入するかを学ぶ。 LoRAとQLoRAを使用したファインチューニングの実際の例を探索する。 PEFT技術の適用性と利点を理解する。 NLPにおけるパラメータ効率の高いファインチューニングの将来の展望を理解する。 はじめに 自然言語処理の刺激的な世界では、大規模な事前学習済み言語モデル(LLM)がこの分野を革新しました。ただし、特定のタスクにこれらの巨大なモデルをファインチューニングすることは、高い計算コストとストレージ要件のために困難を伴います。研究者はパラメータ効率の高いファインチューニング(PEFT)技術に取り組み、より少ない訓練可能なパラメータで高いタスクパフォーマンスを達成することを目指しています。 事前学習済みLLMとファインチューニング 事前学習済みLLMは、一般的なドメインの大量のデータでトレーニングされた言語モデルであり、豊富な言語パターンと知識を捉えることに優れています。ファインチューニングは、これらの事前学習済みモデルを特定の下流タスクに適応させることで、専門的なタスクで優れたパフォーマンスを発揮するためにその知識を活用します。ファインチューニングでは、事前学習済みモデルをタスク固有のデータセットで訓練し、元のトレーニングデータよりも一般的で集中したものにします。ファインチューニング中、モデルのパラメータはターゲットタスクのパフォーマンスを最適化するために調整されます。 パラメータ効率の高いファインチューニング(PEFT)…

「生成AIにおけるニューラル微分方程式の探索」

はじめに 生成AIは大きく進化し、新しい多様なデータを生成するためのさまざまな技術が含まれるようになりました。GANやVAEなどのモデルが注目を集めていますが、あまり探求されていないが非常に興味深い領域として、ニューラル微分方程式(NDEs)の世界があります。本記事では、Generative AIにおけるNDEsの未知の領域に深く掘り下げ、その重要な応用と包括的なPython実装を紹介します。 この記事はData Science Blogathonの一環として公開されました。 ニューラル微分方程式の力 ニューラル微分方程式(NDEs)は微分方程式とニューラルネットワークの原理を組み合わせたものであり、連続かつ滑らかなデータを生成するダイナミックなフレームワークを生み出します。従来の生成モデルは、離散的なサンプルを生成することが多く、その表現力が制限されており、時系列の予測、流体力学、現実的な動きの合成など、連続的なデータが必要なアプリケーションには適していません。NDEsは、連続的な生成プロセスを導入することで、時間とともに滑らかに進化するデータの生成を可能にし、このギャップを埋めます。 ニューラル微分方程式の応用 時系列データ 時系列データは、金融市場から生理学的信号まで、さまざまな領域で頻繁に使用されるデータです。ニューラル微分方程式(NDEs)は、時系列生成の画期的なアプローチとして登場し、時間的な依存関係を理解しモデル化するための独自の視点を提供します。微分方程式の優雅さとニューラルネットワークの柔軟性を組み合わせることで、NDEsは連続的に進化するデータを精巧に合成するAIシステムを可能にします。 時系列生成の文脈では、NDEsは流体の時間的な遷移の調整者となります。彼らは隠れたダイナミクスを捉え、変化するパターンに適応し、将来に予測を外挿します。NDEベースのモデルは、不規則な時間間隔を巧みに扱い、ノイズのある入力を受け入れ、正確な長期予測を容易にします。この驚異的な能力により、予測の景色が再定義され、トレンドの予測、異常の予測、およびさまざまな領域での意思決定の向上が可能になります。 NDEによる時系列生成は、AIによる洞察を提供します。金融アナリストは市場のトレンドを予測するために、医療従事者は患者のモニタリングに、気候科学者は環境変化を予測するためにそれを利用しています。NDEの連続的かつ適応的な性質は、時系列データを生き生きとさせ、AIシステムが時間のリズムと調和して踊ることを可能にします。 物理シミュレーション 物理シミュレーションの領域に進むと、ニューラル微分方程式(NDEs)は、自然現象の複雑な模様を解き明かすことができる才能豊かな存在として現れます。これらのシミュレーションは、科学的な発見、エンジニアリングのイノベーション、およびさまざまな分野での創造的な表現の基盤となっています。微分方程式とニューラルネットワークを融合させることで、NDEsは仮想世界に生命を吹き込み、複雑な物理的プロセスを正確かつ効率的にエミュレーションすることが可能になります。 NDEによる物理シミュレーションは、流体力学から量子力学に至るまで、私たちの宇宙を支配する法則を包括して再現します。従来の方法では、広範な計算リソースと手動のパラメータ調整が必要でしたが、NDEsは明示的な方程式の設定を回避し、動的なシステムに学習し適応することで、シミュレーションのワークフローを加速し、実験を迅速化し、シミュレーションの範囲を拡大します。 航空宇宙、自動車、エンターテイメントなどの産業は、NDEによるシミュレーションを活用して設計を最適化し、仮説を検証し、現実的な仮想環境を作り出しています。エンジニアや研究者は、以前は計算上困難なシナリオを探求し、未知の領域を航海します。要するに、ニューラル微分方程式は、仮想と具体的な世界の間に橋を架け、デジタル領域内で物理学の複雑な交響曲を具現化します。 モーション合成 モーション合成は、アニメーション、ロボティクス、ゲームなどにおける重要な要素であり、ニューラル微分方程式(NDEs)はそこで芸術的かつ実用的な能力を発揮します。従来、自然で流体的なモーションシーケンスの生成は、基礎となるダイナミクスの複雑さにより課題がありました。NDEsはこの領域を再定義し、AIによるキャラクターやエージェントに人間の直感とシームレスに共鳴するような生命のあるモーションを与えます。 NDEsは連続性をモーション合成に与え、ポーズや軌跡をシームレスにリンクし、離散的なアプローチによるジャリングしたトランジションを排除します。彼らはモーションの基礎的なメカニクスを解読し、キャラクターに優雅さ、重み、反応性を注入します。蝶の羽ばたきのシミュレーションからヒューマノイドロボットのダンスの振り付けまで、NDEによるモーション合成は創造性と物理学の調和の取れた融合です。 非破壊検査(NDE)駆動のモーション合成の応用は広範で変革的です。映画やゲームでは、キャラクターが真正さを持って動き、感情的な関与を引き起こします。ロボティクスでは、機械が優雅かつ精密に環境を移動します。リハビリテーション装置はユーザーの動きに適応し、回復を促進します。NDEが指揮することで、モーション合成は単なるアニメーションを超え、作成者と観客の両方に共鳴する動きのシンフォニーを編成するための道となります。 ニューラル微分方程式モデルの実装 NDEの概念を説明するために、PythonとTensorFlowを使用して基本的な連続時間VAEを実装してみましょう。このモデルは連続的な生成プロセスを捉え、微分方程式とニューラルネットワークの統合を示しています。 (注:以下のコードを実行する前に、TensorFlowと関連する依存関係をインストールしてください。)…

「Lineが『japanese-large-lm』をオープンソース化:36億パラメータを持つ日本語言語モデル」

2020年11月以来、LINEは日本語に特化した先進的な大規模言語モデルの研究開発に取り組んできました。この旅の重要なマイルストーンとして、LINEのMassive LM開発ユニットは、日本語の言語モデル「Japanese-large-lm」をオープンソースソフトウェア(OSS)として公開しました。このリリースは、先端の言語モデルを活用しようとする研究コミュニティとビジネスに大きな影響を与えることが期待されています。 これらの言語モデルには、36億(3.6B)パラメータモデルと17億(1.7B)パラメータモデルの2つのバリエーションがあり、それぞれ3.6Bモデルと1.7Bモデルと呼ばれています。これらのモデルを公開し、言語モデルの構築に関する包括的な知識を共有することで、LINEは自社のアプローチの複雑さに一瞥を提供し、この分野の進歩に貢献することを目指しています。 1.7Bモデルと3.6Bモデルは、HuggingFace Hub(1.7Bモデル、3.6Bモデル)を介してアクセスでき、人気のあるtransformersライブラリを通じてさまざまなプロジェクトにシームレスに統合することができます。これらのモデルをApache License 2.0の下でライセンスすることで、研究者や商業企業など、さまざまなユーザーが多様なアプリケーションでそれらの機能を活用することができます。 高性能な言語モデルを開発するための基盤となる重要な要素は、広範で高品質なトレーニングデータセットの活用です。LINEは、これを達成するために、独自の日本語ウェブコーパスを活用して多様なテキストデータを充実させました。ただし、ウェブから派生するコンテンツの課題は、ソースコードや非日本語の文などのノイズが含まれることです。LINEは、HojiChar OSSライブラリを活用した細心のフィルタリングプロセスを採用することで、大規模で高品質なデータセットを取り出し、モデルの堅牢性の基盤を形成しました。 モデルのトレーニング効率も重要な考慮事項であり、LINEは3DパラレリズムやActivation Checkpointingなどの革新的なテクニックを導入することで、効率的なデータの吸収を実現し、計算能力の限界を押し上げました。驚くべきことに、1.7BモデルはA100 80GB GPU上でわずか4000時間のGPUを使用して開発されました。これは彼らの学習アプローチの効果を示すものです。 特筆すべきは、この日本語言語モデルの開発軌跡がHyperCLOVAとは異なることです。LINEの専任のMassive LM開発ユニットによって厳格に監視された独自の開発ラインに沿って構築されたこのモデルは、日本語のための優れた事前学習モデルを作り上げるLINEの取り組みを示しています。彼らの総合的な目標は、大規模言語モデルの幅広い経験から得られた洞察と教訓を統合することです。 LINEは、モデルの効果を評価するためにパープレキシティスコア(PPL)と質問応答および読解タスクの精度率を調査しました。PPLはモデルの予測能力を示し、精度率は具体的なパフォーマンス指標を提供します。その結果、LINEのモデルは、さまざまなタスクで競争力のあるパフォーマンスを示し、分野で確立されたモデルと肩を並べるものでした。 彼らの成功の基盤となったのは、効果的な大規模言語モデルのトレーニングに関する一連の貴重なヒントです。これには、微調整の考慮事項、ハイパーパラメータAdam’s beta2、最適な学習率、適切な学習率スケジューラの適用などが含まれます。LINEはこれらの技術的な複雑さに深入りすることで、広範なコミュニティに利益をもたらす力強いモデルを開発し、知見を共有しています。 まとめると、LINEが1.7Bモデルと3.6Bモデルの日本語言語モデルを公開したことは、自然言語処理の重要な進歩です。彼らは将来の調整モデルの公開に対する取り組みを強調することで、言語モデルの機能を向上させることへの彼らの取り組みを示しています。LINEが進歩を続ける中で、グローバルコミュニティは彼らの持続的な貢献の影響を熱望しています。

アーサーがベンチを発表:仕事に最適な言語モデルを見つけるためのAIツール

ニューヨーク市の通りでは、AIの新興スタートアップ「Arthur」が機械学習の世界で話題をさらっています。生成型AIに関するブンブンとした話題の中、Arthurは革新的なソリューションを提供し、企業が求める最高の言語モデルを提供するゲームチェンジャーとなるでしょう。革新の輝きと共に、同社は誇りを持って「Arthur Bench」を紹介します。これは、従来のように言語モデルのパフォーマンスを評価し比較するために設計されたオープンソースの宝石です。 また読む:大規模言語モデルの微調整の包括的なガイド 先見の明を持つリーダーの視点:Arthur Benchの誕生 Arthurの先見の明を持つCEO兼共同創設者であるAdam Wenchelは、この画期的なツールの創造の背後にあるストーリーを共有しています。彼と彼のチームは、生成型AIと言語モデルへの関心の高まりに気付き、企業が言語モデルの力を活用する方法を再定義する解決策を作り上げるために努力しました。Arthur Benchは、他のツールとの効果的な比較方法が欠如しているという問題に対処します。この欠如は、最適な言語モデルを求める企業にとってしばしば悩みの種となります。Arthur Benchは、このジレンマを解決し、アプリケーションに最適なモデルへの道を示すAIの騎士です。 Arthur Benchの解読:LLMのパフォーマンス評価の向上 Arthur Benchを手に入れることで、可能性は無限大です。このツールにより、企業は異なる言語モデルが独自の文脈でどのように機能するかを評価することができます。Arthur Benchが提供するメトリクスは、正確性や読みやすさからヘッジングなどの属性まで、包括的な評価プロセスを保証します。 また読む:大規模言語モデル(LLM)の評価方法 完璧を調整する:ニーズに合わせたカスタマイズ基準 Arthurは単なる事前パッケージ化されたソリューションを提供するだけではありません。このツールは、LLMの比較のための一連のスターター基準を提供するだけでなく、ビジネスは固有の要件に完全に合致する基準を追加することができます。それは、ニーズに合わせた卓越性を実現する絶頂です。 力を活用する:LLMテストツールの公開 Arthur Benchは、約束を守るだけではありません。方法論的なテストのために設計されたツールのスイートを提供します。しかし、真の魔力は、ツールがユーザーの現実世界の対話を反映するプロンプトに対してさまざまなLLMのパフォーマンスをシミュレートする能力にあります。100のプロンプトをテストし、アプリケーションのニーズに最適なマッチを見つけることを想像してみてください。 また読む:LLMのマスタリング:効率的なプロンプトの包括的ガイド 卓越の未来:オープンソースの創造性を受け入れる 今日、Arthur Benchはオープンソースの驚異として世界に踏み出します。シームレスな体験を希望する人々のためにSaaS版も開発中ですが、プロジェクトのオープンソースの核心に焦点が当てられています。これは、Arthurのイノベーションへの取り組みとAIの力へのアクセスの民主化を強調しています。…

VoAGI ニュース、8月16日:テキストをパワーポイントプレゼンテーションに変換するための ChatGPT の利用 • ジェネラティブ AI アプリケーションを構築するための最高の Python ツール チートシート

テキストをパワーポイントプレゼンテーションに変換する方法 • ジェネレーティブAIアプリケーションのための最高のPythonツール チートシート • テックウィンターを生き残るためにデータサイエンティストは専門化する必要がある • Pythonベクトルデータベースとベクトルインデックス LLMアプリケーションのアーキテクチャ設計 • SQLクエリの高速化方法...

JEN-1に会ってください:テキストまたは音楽表現に応じて条件付けられた高品質な音楽を生成するために、双方向および単方向のモードを組み合わせたユニバーサルAIフレームワーク

音楽は、ヘンリー・ワズワース・ロングフェローによって「人間の普遍的な言語」として讃えられ、調和、メロディ、リズムの本質を内包し、文化的な意義を織り交ぜて、世界中の人々と深く共鳴するものです。深層生成モデルの最近の進歩により、音楽生成の進歩が実現されています。ただし、テキストの説明に基づいて条件付けられた場合に、その複雑さやニュアンスを捉えた、高品質で現実的な音楽を生成するという課題は、依然として困難です。 既存の音楽生成方法は大きな進歩を遂げていますが、自由形式のテキストプロンプトと一致する複雑でリアルな音楽を開発するためには、さらなる改善が必要です。楽器やハーモニーの複雑な相互作用とメロディやハーモニーのアレンジにより、複雑で複雑な音楽構造が生まれます。音楽は不協和音に非常に敏感であるため、精度が重要です。 音楽は広い周波数スペクトルを持っており、細部を捉えるために44.1KHzステレオのような高いサンプリングレートが必要です。これは、低いサンプリングレートで動作する音声とは対照的です。 楽器の複雑な相互作用とメロディやハーモニーのアレンジは、複雑で複雑な音楽構造を生み出します。音楽は不協和音に非常に敏感であるため、精度が重要です。 キー、ジャンル、メロディのような属性を制御し続けることは、意図した芸術的なビジョンを実現するために重要です。 テキストから音楽を生成するという課題に対処するために、Futureverse研究チームはJEN-1を設計しました。JEN-1は、オートレグレッシブ(AR)と非オートレグレッシブ(NAR)のパラダイムを組み合わせたユニークな全方向拡散モデルを活用し、シーケンシャルな依存関係を捉えながら生成を加速することができます。音声データをメルスペクトログラムに変換する従来の方法とは異なり、JEN-1は生のオーディオ波形を直接モデル化し、より高い忠実度と品質を維持します。これは、ノイズに強いマスク付きオートエンコーダを使用して元のオーディオを潜在表現に圧縮することによって実現されます。研究者は、潜在埋め込みにおける異方性を減少させる正規化ステップを導入し、モデルのパフォーマンスをさらに向上させました。 JEN-1のコアアーキテクチャは、バイドとユニディレクショナルモードを組み合わせた全方向1D拡散モデルです。このモデルは、Efficient U-Netアーキテクチャに触発された時間的な1D効率的なU-Netを活用しています。このアーキテクチャは、波形を効果的にモデル化するために設計されており、シーケンシャルな依存関係と文脈情報の両方を捉えるために、畳み込み層とセルフアテンション層の両方を含んでいます。音楽生成において時系列性が重要であるため、ユニディレクショナルモードは因果パディングとマスク付きセルフアテンションを介して組み込まれており、生成された潜在埋め込みが右側の潜在埋め込みに依存するようにしています。 JEN-1のユニークな強みの一つは、統一された音楽マルチタスクトレーニングアプローチにあります。JEN-1は、主に次の3つの音楽生成タスクをサポートしています: 双方向テキストガイドの音楽生成 双方向音楽インペインティング(欠落セグメントの復元) ユニディレクションの音楽継続(外挿) マルチタスクトレーニングにより、JEN-1はタスク間でパラメータを共有し、より良い汎化性能を持ち、シーケンシャルな依存関係をより効果的に処理することができます。この柔軟性により、JEN-1はさまざまな音楽生成シナリオに適用できる多目的なツールとなります。 実験設定では、JEN-1を高品質の音楽データを5,000時間分トレーニングしました。モデルはマスク付き音楽オートエンコーダとFLAN-T5を使用しています。トレーニング中には、マルチタスク目的をバランスさせ、分類器フリーガイダンスを採用しています。JEN-1は、8つのA100 GPUでAdamWオプティマイザを使用して200kステップでトレーニングされました。 JEN-1の性能は、客観的および主観的な評価基準を用いていくつかの最新の手法と比較されます。JEN-1は、信憑性(FAD)、音声テキストの整合性(CLAP)、人間の評価に基づくテキストから音楽への品質(T2M-QLT)および整合性(T2M-ALI)の面で他の手法を上回っています。計算効率にもかかわらず、JEN-1はテキストから音楽への合成において競合モデルを上回っています。 除去実験により、JEN-1の異なる構成要素の効果が示されています。自己回帰モードの組み込みとマルチタスキング目標の採用により、音楽の品質と汎化性能が向上しています。提案手法は、トレーニングの複雑さを増加させることなく、一貫して高品質な音楽生成を実現しています。 総括すると、JEN-1はテキストから音楽を生成するための強力な解決策を提供し、この分野を大幅に前進させています。波形の直接モデリングと自己回帰および非自己回帰トレーニングの組み合わせにより、高品質な音楽を生成します。統合拡散モデルとマスクされたオートエンコーダーは、シーケンスモデリングを向上させます。JEN-1は、強力なベースラインと比較して主観的品質、多様性、および制御性において優れた性能を発揮し、音楽合成における効果を示しています。

「DARPAがハッカーを起用し、サイバー脅威から重要なソフトウェアを強化する」

競争は、トップのAIおよびサイバーセキュリティの才能に対して、ソフトウェアの脆弱性を自動的に見つけて修正し、重要なインフラストラクチャをサイバー攻撃から守ることを求めます

グラフ畳み込みネットワーク:GNNの紹介

この記事では、ステップバイステップでグラフニューラルネットワークのアーキテクチャを紹介し、PyTorch Geometricを使用してグラフ畳み込みネットワークを実装します

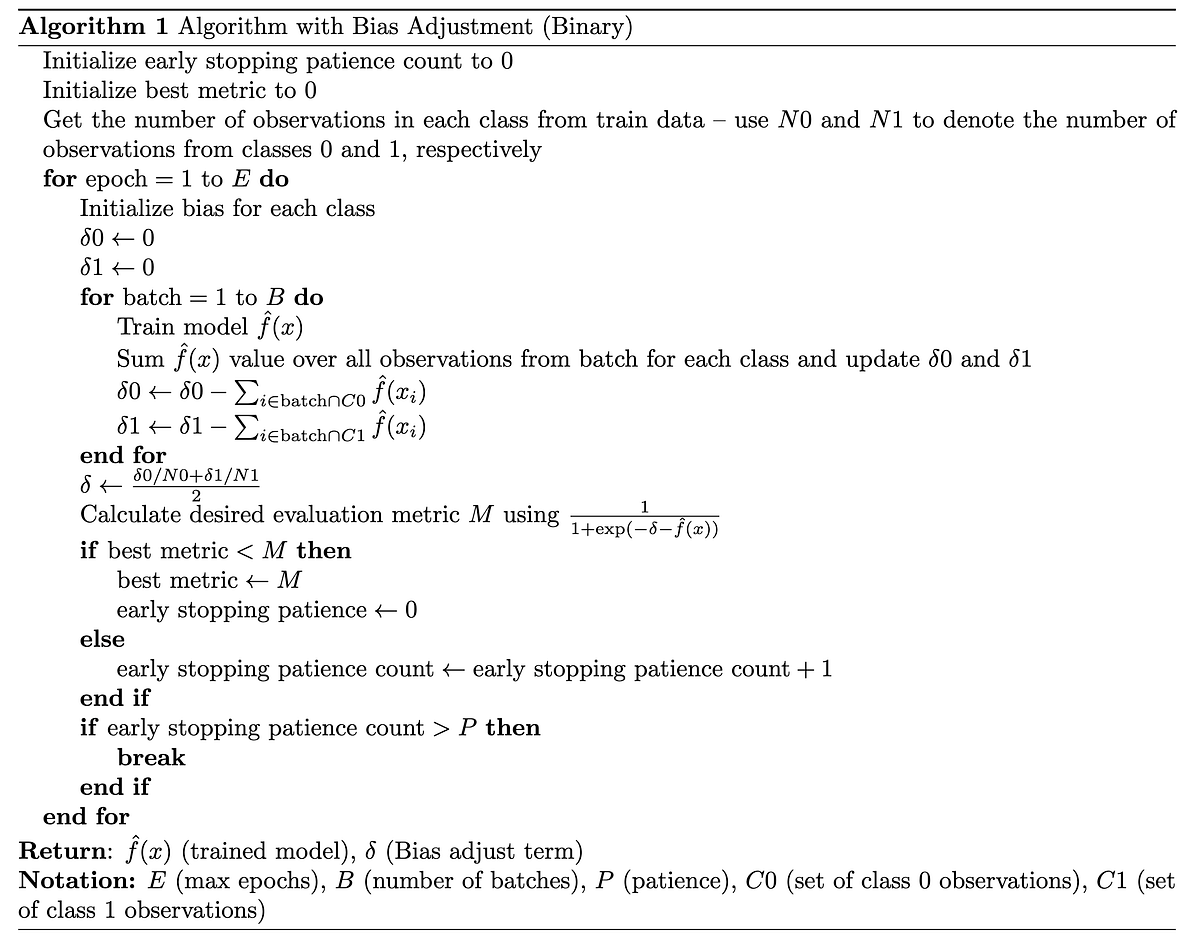

「バイアス調整の力を明らかにする:不均衡なデータセットにおける予測精度の向上」

データサイエンスの領域では、不均衡なデータセットを効果的に管理することが正確な予測には重要です主要なクラスの差異が顕著な不均衡なデータセットは、バイアスを引き起こす可能性があります...

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.