Learn more about Search Results ARES - Page 10

- You may be interested

- 生成AIの逆説を調和させる:生成と理解に...

- Transformers.jsを使用してMLを搭載したウ...

- スマートフォンにおける通話セキュリティ...

- JupyterAI 生成AI + JupyterLab

- 「人工知能がゼロトラストを強化する方法」

- ChatGPTのバイアスを解消するバックパック...

- 郵便番号レベルでの地理空間データの操作

- 現代AIにおける知識蒸留の力:パワフルで...

- 「サイバーセキュリティとAI、テキサスサ...

- ユーザーに扱える以上を提供する

- 「時間の逆転:拡散モデルと確率微分方程式」

- 「生成AI解放:ソフトウェアエンジニアの...

- ファルコンはHugging Faceのエコシステム...

- X / Twitterでお金を稼ぐ方法

- パンダのGroupByを最大限に活用する

注釈付き拡散モデル

このブログ記事では、Denoising Diffusion Probabilistic Models(DDPM、拡散モデル、スコアベースの生成モデル、または単にオートエンコーダーとも呼ばれる)について詳しく見ていきます。これらのモデルは、(非)条件付きの画像/音声/ビデオの生成において、驚くべき結果が得られています。具体的な例としては、OpenAIのGLIDEやDALL-E 2、University of HeidelbergのLatent Diffusion、Google BrainのImageGenなどがあります。 この記事では、(Hoら、2020)による元のDDPMの論文を取り上げ、Phil Wangの実装をベースにPyTorchでステップバイステップで実装します。なお、このアイデアは実際には(Sohl-Dicksteinら、2015)で既に導入されていました。ただし、改善が行われるまでには(Stanford大学のSongら、2019)を経て、Google BrainのHoら、2020)が独自にアプローチを改良しました。 拡散モデルにはいくつかの視点がありますので、ここでは離散時間(潜在変数モデル)の視点を採用していますが、他の視点もチェックしてください。 さあ、始めましょう! from IPython.display import Image Image(filename='assets/78_annotated-diffusion/ddpm_paper.png') まず必要なライブラリをインストールしてインポートします(PyTorchがインストールされていることを前提としています)。 !pip install -q -U…

機械学習におけるバイアスについて話しましょう!倫理と社会に関するニュースレター #2

機械学習におけるバイアスは普遍的であり、また複雑です。実際には、単一の技術的介入では問題を意味のある形で解決することはできないほど複雑です。機械学習モデルは社会技術システムであり、その展開コンテキストに依存し、常に進化しながら、不平等や有害なバイアスを悪化させる社会的な傾向を増幅させます。 これは、慎重に機械学習システムを開発するためには警戒心が必要であり、展開コンテキストからのフィードバックに対応することが求められます。これには、コンテキスト間での教訓の共有や、機械学習開発のあらゆるレベルでバイアスの兆候を分析するためのツールの開発などが必要です。 このブログポストでは、Ethics and Societyのメンバーが学んだ教訓と、機械学習におけるバイアスに対処するために開発したツールを共有しています。最初の部分では、バイアスとそのコンテキストについて幅広く考察しています。既に読んでいて、具体的にツールについて戻ってきた場合は、データセットやモデルのセクションに移動してください! 機械学習におけるバイアスに対処するために🤗のチームメンバーが開発したツールの一部を選択 目次: 機械バイアスについて 機械バイアス:機械学習システムからリスクへ バイアスをコンテキストに置く ツールと推奨事項 機械学習開発全体でのバイアスの対処 タスクの定義 データセットのキュレーション モデルのトレーニング 🤗のバイアスツールの概要 機械バイアス:機械学習システムから個人および社会的なリスクへ 機械学習システムは、さまざまなセクターやユースケースで展開されるため、以前に見たことのないスケールで複雑なタスクを自動化することができます。技術が最も効果的に機能する場合、人々と技術システムの間の相互作用をスムーズにし、高度に繰り返しの多い作業の必要性をなくしたり、研究をサポートするための情報処理の新しい方法を開放することができます。 しかし、同じシステムは、特にデータが人間の行動をエンコードする場合、差別的で虐待的な行動を再現する可能性があります。その結果、これらの問題は大幅に悪化する可能性があります。自動化とスケール展開は、次のようなことができます: 時間の経過とともに行動を固定化し、社会的な進歩が技術に反映されるのを妨げる オリジナルのトレーニングデータのコンテキストを超えて有害な行動を広める 予測を行う際にステレオタイプな関連性に過度に焦点を当てて不公平を増幅させる バイアスを「ブラックボックス」システム内に隠すことで救済の可能性を排除する これらのリスクをよりよく理解し対処するために、機械学習の研究者や開発者は、機械バイアスやアルゴリズムのバイアスなど、システムが展開コンテキストでさまざまな人口集団に対して負のステレオタイプや関連性をエンコードする可能性のあるメカニズムを研究し始めています。…

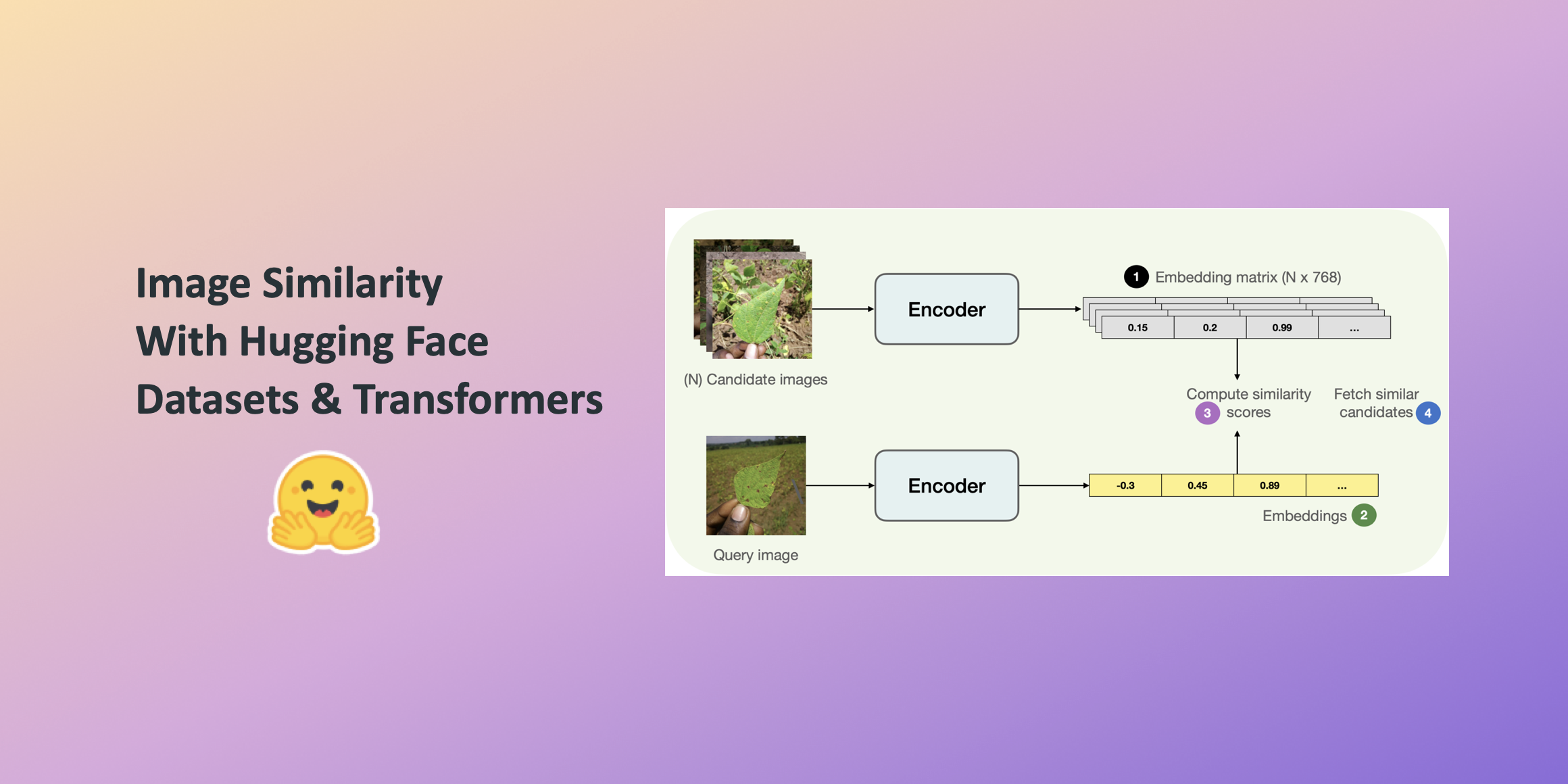

Hugging Faceデータセットとトランスフォーマーを使用した画像の類似性

この投稿では、🤗 Transformersを使用して画像の類似性システムを構築する方法を学びます。クエリ画像と候補画像の類似性を見つけることは、逆画像検索などの情報検索システムの重要なユースケースです。システムが答えようとしているのは、クエリ画像と候補画像セットが与えられた場合、どの画像がクエリ画像に最も類似しているかということです。 このシステムの構築には、このシステムの構築時に便利な並列処理をシームレスにサポートする🤗のdatasetsライブラリを活用します。 この投稿では、ViTベースのモデル( nateraw/vit-base-beans )と特定のデータセット(Beans)を使用していますが、ビジョンモダリティをサポートし、他の画像データセットを使用するために拡張することもできます。試してみることができるいくつかの注目すべきモデルには次のものがあります: Swin Transformer ConvNeXT RegNet また、投稿で紹介されているアプローチは、他のモダリティにも拡張できる可能性があります。 完全に動作する画像の類似性システムを学習するには、最初に2つの画像間の類似性をどのように定義するかを定義する必要があります。 このシステムを構築するためには、まず与えられた画像の密な表現(埋め込み)を計算し、その後、余弦類似性指標を使用して2つの画像の類似性を決定する一般的な方法があります。 この投稿では、画像をベクトル空間で表現するために「埋め込み」を使用します。これにより、画像の高次元ピクセル空間(たとえば224 x 224 x 3)を意味のある低次元空間(たとえば768)にうまく圧縮する方法が得られます。これによる主な利点は、後続のステップでの計算時間の削減です。 画像から埋め込みを計算するために、入力画像をベクトル空間で表現する方法について理解しているビジョンモデルを使用します。このタイプのモデルは画像エンコーダとも呼ばれます。 モデルをロードするために、AutoModelクラスを活用します。これにより、Hugging Face Hubから互換性のあるモデルチェックポイントをロードするためのインターフェースが提供されます。モデルと共に、データ前処理に関連するプロセッサもロードします。 from transformers…

Hugging Face Hubへ、fastText をようこそお迎えください

fastTextは、テキストの表現と分類の効率的な学習のためのライブラリです。Meta AIによって2016年にオープンソース化され、fastTextは過去数十年間の自然言語処理と機械学習において影響力のあるキーワードを統合しています。具体的には、文を単語の袋とn-gramの袋を使用して表現し、サブワード情報を利用し、クラス間で情報を共有するための隠れた表現を使用します。 計算を高速化するために、fastTextはクラスの不均衡な分布を活用した階層的なソフトマックスを使用します。これらの技術により、ユーザーはテキストの表現と分類のためのスケーラブルなソリューションを提供します。 Hugging Faceは、現在、157か国のすべての言語と最新の言語識別モデルの公式ミラーをホストしています。これは、Hugging Faceを使用することで、数回のコマンドでモデルを簡単にダウンロードして使用できることを意味します。 モデルの検索 157か国の言語の単語ベクトルと言語識別モデルは、Meta AIのorgで見つけることができます。例えば、こちらで英語の単語ベクトルのモデルページを見つけることができます。また、こちらで言語識別モデルを見つけることができます。 ウィジェット この統合には、テキスト分類と特徴抽出のウィジェットのサポートが含まれています。こちらで言語識別ウィジェットを試してみることができます。また、こちらで特徴抽出ウィジェットを試してみることができます。 使用方法 以下は、事前学習済みのベクトルを読み込んで使用する方法です: >>> import fasttext >>> from huggingface_hub import hf_hub_download >>> model_path =…

はい、トランスフォーマーは時系列予測に効果的です(+オートフォーマー)

イントロダクション 数ヶ月前、AAAI 2021のベストペーパーアワードを受賞したTime Series TransformerであるInformerモデル(Zhou, Haoyiら、2021)を紹介しました。また、Informerを使用した多変量確率予測の例も提供しました。この記事では、「Transformerは時系列予測に効果的か?」(AAAI 2023)という疑問について議論します。見ていくとわかりますが、それらは効果的です。 まず、Transformerは確かに時系列予測に効果的であることを経験的に証明します。私たちの比較では、線形モデルであるDLinearが主張されるほど優れていないことが示されています。線形モデルと同じ設定の同等の大きさのモデルと比較した場合、Transformerベースのモデルは私たちが考慮するテストセットのメトリックでより優れた性能を発揮します。その後、Informerモデルの後にNeurIPS 2021で発表されたAutoformerモデル(Wu, Haixuら、2021)を紹介します。Autoformerモデルは現在🤗 Transformersで利用できます。最後に、Autoformerの分解層を使用するシンプルなフィードフォワードネットワークであるDLinearモデルについて説明します。DLinearモデルは、「Transformerは時系列予測に効果的か?」という論文で初めて紹介され、Transformerベースのモデルを時系列予測で上回ると主張されています。 さあ、始めましょう! ベンチマーキング – Transformers vs. DLinear 最近AAAI 2023で発表された「Transformerは時系列予測に効果的か?」という論文では、著者らはTransformerが時系列予測に効果的ではないと主張しています。彼らは、DLinearと呼ばれるシンプルな線形モデルとTransformerベースのモデルを比較しています。DLinearモデルはAutoformerモデルの分解層を使用しており、後ほどこの記事で紹介します。著者らは、DLinearモデルがTransformerベースのモデルを時系列予測で上回ると主張しています。本当にそうなのでしょうか?さあ、確かめましょう。 上記の表は、論文で使用された3つのデータセットにおけるAutoformerモデルとDLinearモデルの比較結果を示しています。結果からわかるように、Autoformerモデルは3つのデータセットすべてでDLinearモデルを上回っています。 次に、上記の表のTrafficデータセットを使用してAutoformerモデルとDLinearモデルを比較し、得られた結果の説明を提供します。 要約: 簡単な線形モデルは一部の場合において有利ですが、ユニバリエートの設定では変数を組み込む能力がTransformerのようなより複雑なモデルに比べてありません。 Autoformer…

「私のお気に入りの3Dアプリ」:Blenderファンが今週「NVIDIA Studio」で彼の日本インスパイアされたシーンを共有

編集者の注:この投稿は、週刊NVIDIA Studioシリーズの一部であり、注目されるアーティストを称え、クリエイティブなヒントやトリックを提供し、NVIDIA Studioテクノロジーがクリエイティブなワークフローを向上させる方法を示します。また、新しいGeForce RTX 40シリーズGPUの機能、技術、リソースについて詳しく解説し、コンテンツの作成を劇的に加速する方法についても掘り下げています。 多様なアーティスト、ファッショニスタ、ミュージシャン、映画芸術家によって、Pedro Soares(通称Blendeered)の創造的な旅がインスピレーションを受け、彼は3Dを使った芸術創造に夢中になりました。 今では、ポルトガルのポルトに拠点を置くアーティストは、自分自身の人生の経験や人々との交流を通じて、彼の芸術的なビジョンを実現するために、芸術的なバックグラウンドに関係なく、人々を活かしています。 日本の文化に魅了されたBlendeeredは、常に芸術的なインスピレーションを提供してくれる強大な存在である動物に捧げられた古い日本の寺院の表現を試みました。その結果、BlenderとBlackmagic DesignのDaVinci Resolveを使用して作成された短編アニメーション「Japanese Temple Set」が、今週のIn the NVIDIA Studioの対象となりました。 https://blogs.nvidia.com/wp-content/uploads/2023/07/nvidia-studio-itns-wk64-pedro-soares-1280w-clip1.mp4 さらに、NVIDIA RTX GPUを搭載したWondershare FilmoraとTrimble SketchUp Goという2つのクラウドベースのAIアプリをご紹介し、コンテンツの作成を向上させる方法や自動化の方法について学んでください。…

次のLangChainプロジェクトのための基本を学ぶ

大型言語モデルは昨年、楽しみのためにメインストリームに参入し、時にはまったくばかげた実験のツールとして登場しました私たちの中でChatGPTに新しいノック・ノック・ジョークを作り出すよう挑戦したことがない人は誰もいないでしょう

私が通常のRDBMSをベクトルデータベースに変換して埋め込みを保存する方法

この記事では、一般的なRDBMSを完全に機能したベクトルデータベースに変換して、GenerativeAIアプリケーションの開発に埋め込みを格納する方法について説明します

Hamiltonを使って、8分でAirflowのDAGの作成とメンテナンスを簡単にしましょう

この投稿では、2つのオープンソースプロジェクト、HamiltonとAirflowの利点と、それらの有向非循環グラフ(DAG)が連携して動作する方法について説明しますAirflowは、高レベルでは...

Langchainを使用してYouTube動画用のChatGPTを構築する

はじめに ビデオとチャットで話すことができたらどのくらい便利だろうかと考えたことがありますか?私自身、ブログを書く人間として、関連する情報を見つけるために1時間ものビデオを見ることはしばしば退屈に感じます。ビデオから有用な情報を得るために、ビデオを見ることが仕事のように感じることもあります。そこで、YouTubeビデオやその他のビデオとチャットできるチャットボットを作成しました。これは、GPT-3.5-turbo、Langchain、ChromaDB、Whisper、およびGradioによって実現されました。この記事では、Langchainを使用してYouTubeビデオのための機能的なチャットボットを構築するコードの解説を行います。 学習目標 Gradioを使用してWebインターフェースを構築する Whisperを使用してYouTubeビデオを処理し、テキストデータを抽出する テキストデータを適切に処理およびフォーマットする テキストデータの埋め込みを作成する Chroma DBを構成してデータを保存する OpenAI chatGPT、ChromaDB、および埋め込み機能を使用してLangchainの会話チェーンを初期化する 最後に、Gradioチャットボットに対するクエリとストリーミング回答を行う コーディングの部分に入る前に、使用するツールや技術に慣れておきましょう。 この記事は、Data Science Blogathonの一部として公開されました。 Langchain Langchainは、Pythonで書かれたオープンソースのツールで、Large Language Modelsデータに対応したエージェントを作成できます。では、それはどういうことでしょうか?GPT-3.5やGPT-4など、商用で利用可能な大規模言語モデルのほとんどは、トレーニングされたデータに制限があります。たとえば、ChatGPTは、すでに見た質問にしか答えることができません。2021年9月以降のものは不明です。これがLangchainが解決する核心的な問題です。Wordドキュメントや個人用PDFなど、どのデータでもLLMに送信して人間らしい回答を得ることができます。ベクトルDB、チャットモデル、および埋め込み関数などのツールにはラッパーがあり、Langchainだけを使用してAIアプリケーションを簡単に構築できます。 Langchainを使用すると、エージェント(LLMボット)を構築することもできます。これらの自律エージェントは、データ分析、SQLクエリ、基本的なコードの記述など、複数のタスクに設定できます。これらのエージェントを使用することで、低レベルな知識作業をLLMに外注することができるため、時間とエネルギーを節約できます。 このプロジェクトでは、Langchainツールを使用して、ビデオ用のチャットアプリを構築します。Langchainに関する詳細については、公式サイトを訪問してください。 Whisper Whisperは、OpenAIの別の製品です。これは、オーディオまたはビデオをテキストに変換できる汎用音声認識モデルです。多言語翻訳、音声認識、および分類を実行するために、多様なオーディオをトレーニングしています。…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.